AI dreier seg om data, men hvor kommer de fra? Er datasettene lovlige og etiske? Hvordan kan utviklere avgjøre det med sikkerhet?

Opplæring av maskinlæringsmodeller, for eksempel store språkmodeller (LLM), krever store mengder tekstdata.

Det finnes stabler av datasett tilgjengelig på plattformer som Kaggle, GitHub og Hugging Face, men de befinner seg i en juridisk og etisk gråsone, først og fremst på grunn av lisensiering og spørsmål om rettferdig bruk.

Den Data Provenance Initiativeet samarbeid mellom AI-forskere og jurister, gjennomgikk tusenvis av datasett for å kaste lys over deres sanne opprinnelse.

Det fokuserte på over 1800 datasett som var tilgjengelige på plattformer som Hugging Face, GitHub og Papers With Code. Datasettene er hovedsakelig utviklet for å finjustere modeller med åpen kildekode, som Llama-2.

Studien avslørte at omtrent 70% av disse datasettene enten manglet tydelig lisensinformasjon eller var merket med altfor permissive lisenser.

Med en skrikende mangel på klarhet rundt opphavsrett og begrensninger for kommersiell bruk risikerer AI-utviklere å bryte loven eller opphavsretten ved et uhell.

Shayne Longpre, en doktorgradskandidat ved MIT Media Lab som ledet revisjonen, understreket at problemet ikke skyldes hostingplattformene, men snarere er et systemisk problem i maskinlæringssamfunnet.

2023 har vært vitne til en flodbølge av søksmål rettet mot store AI-utviklere som Meta, Anthropic og OpenAI, som er under sterkt press for å innføre en mer åpen datainnsamlingspraksis. Reguleringer, som f.eks. EUs lov om kunstig intelligenser satt til å håndheve nettopp dette.

Data Provenance Initiative gjør det mulig for maskinlæringsutviklere å Utforsk de reviderte datasettene her. Initiativet analyserer også mønstre i datasettene, og belyser deres geografiske og institusjonelle opprinnelse.

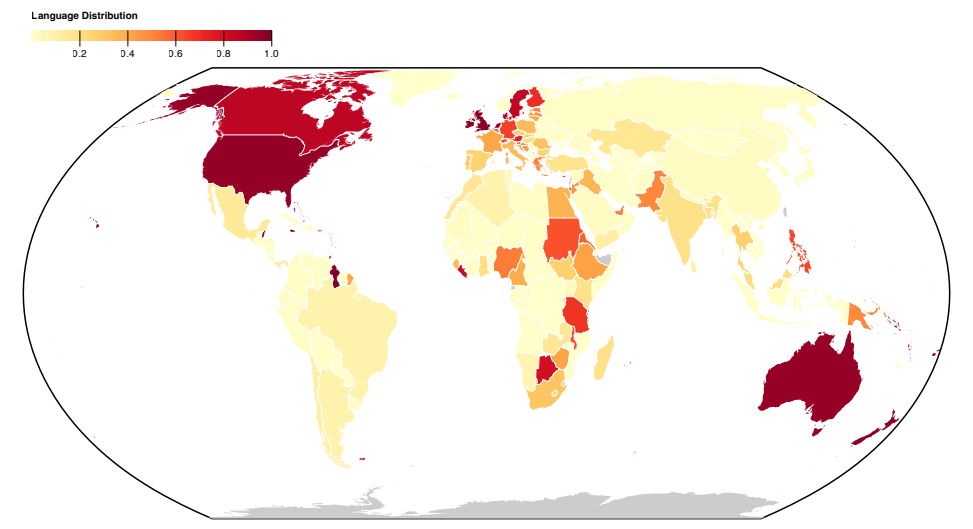

De fleste datasettene er konstruert i det engelskspråklige globale nord, noe som fremhever sosiokulturelle ubalanser.

Mer om studien

Denne storstilte analysen av datasett avdekket systematiske problemer med hvordan data samles inn og distribueres. Initiativet har også utarbeidet en artikkel for å forklare funnene, publisert her.

Her finner du mer informasjon om studiens metoder og funn:

- Analyserer datasett for opprinnelse og merking: I denne studien ble over 1800 finjusteringsdatasett systematisk gjennomgått for å granske dataenes opprinnelse, lisensiering og dokumentasjon.

- Bevis på feilmerking: Funnene viste at det er store forskjeller mellom datatypene som er tilgjengelige under ulike lisenser, og hvilke konsekvenser dette har for juridiske tolkninger av opphavsrett og rettferdig bruk. Det ble avdekket en høy grad av feilkategorisering av lisenser, med over 72% av datasettene som ikke spesifiserte en lisens, og en feilprosent på 50% i de som gjorde det.

- Upålitelig dataproveniens: Forskningen retter oppmerksomheten mot problemet med upålitelig dataproveniens, og understreker behovet for standarder for å spore datalinje, sikre riktig attribusjon og oppmuntre til ansvarlig bruk av data.

- Geografisk utbredelse: Studien belyser en alvorlig mangel på representasjon og attribusjon for datasett som stammer fra det globale sør. De fleste datasettene er engelskspråklige og kulturelt knyttet til Europa, Nord-Amerika og det engelskspråklige Oseania.

Denne studien belyser systemiske og strukturelle problemer i hvordan data skapes, distribueres og brukes. Data er en kritisk ressurs for AI, og i likhet med naturressurser er de begrensede.

Det er bekymring for at AI-teknologien etter hvert vil vokse seg større enn dagens datasett, og kanskje til og med begynner å forbruke sin egen produksjonDet betyr at AI-modeller vil lære av AI-generert tekst.

Dette kan svekke kvaliteten på modellene, noe som betyr at etiske og lovlige data av høy kvalitet kan bli svært verdifulle.