Data er livsnerven i AI, men det er ikke en uendelig ressurs. Kan menneskeheten gå tom for data? Hva skjer hvis vi gjør det?

Komplekse AI-modeller krever enorme mengder treningsdata. For eksempel krever opplæring av en stor språkmodell (LLM) som ChatGPT omtrent 10 billioner ord.

Noen eksperter mener at tilgangen på data av høy kvalitet er synkende. En studie fra 2022 fra forskere ved flere universiteter viser for eksempel oppgitt, "Analysen vår tyder på at beholdningen av språkdata av høy kvalitet snart vil være oppbrukt, sannsynligvis før 2026 ... Arbeidet vårt tyder på at den nåværende trenden med stadig voksende ML-modeller som baserer seg på enorme datasett, kan avta hvis ikke dataeffektiviteten forbedres drastisk eller nye datakilder blir tilgjengelige."

Selv om generering av syntetiske data er en løsning, klarer de som regel ikke å fange opp dybden, nyansene og variasjonen i reelle data.

For å komplisere situasjonen ytterligere, er det bekymring for hva som skjer når AI begynner å konsumere sin egen produksjon, noe forskere ved École Polytechnique Fédérale de Lausanne (EPFL) i Sveits mener er skjer allerede.

Forskningen deres indikerer at AI-selskaper som kjøper menneskeproduserte data gjennom plattformer som Amazon Mechanical Turk, kan motta AI-genererte data i stedet.

Hva skjer når AI begynner å spise sin egen produksjon? Kan det unngås?

Det er dyrt og tidkrevende å bygge datasett - og mye står på spill

Data er allestedsnærværende, men det er en kompleks prosess å operasjonalisere dem for AI. Kvaliteten på dataene og etikettene påvirker modellens ytelse - det er et tilfelle av "søppel inn, søppel ut".

For å gi en kort beskrivelse av prosessen med å bygge datasett, tar dataannotatører (eller etikettører) bearbeidede data (f.eks. et utsnitt av et bilde) og merker funksjoner (f.eks. en bil, en person, en fugl).

Dette gir algoritmene et "mål" å lære fra. Algoritmene trekker ut og analyserer egenskaper fra merkede data for å forutsi disse egenskapene i nye, usette data.

Dette er nødvendig for overvåket maskinlæring, som er en av kjernegrenene innen maskinlæring ved siden av ikke-overvåket maskinlæring og forsterkningslæring. Ved å noen estimatertar datatilberedningen og merkingsprosessen 80% av et maskinlæringsmodellprosjekts varighet, men hvis man tar for mange snarveier, risikerer man at det går på bekostning av modellens ytelse.

I tillegg til de praktiske utfordringene med å lage datasett av høy kvalitet, er det også slik at selve innholdet i dataene stadig endrer seg. Det du ville definert som et "datasett som inneholder et typisk utvalg av kjøretøy på veiene" for 10 år siden, er ikke det samme i dag. I dag vil du for eksempel finne et mye større antall el-sparkesykler og el-sykler på veiene.

Disse kalles "edge cases", og er sjeldne objekter eller fenomener som ikke finnes i datasettene.

Modellene gjenspeiler kvaliteten på datasettene

Hvis du trener opp et moderne AI-system på et gammelt datasett, risikerer modellen å få lav ytelse når den utsettes for nye, ukjente data.

Mellom 2015 og 2020 avdekket forskere store strukturelle skjevheter i AI-algoritmer, noe som delvis skyldtes at modellene ble trent på gamle og skjeve data.

For eksempel kan Merkede ansikter i det ville hjem (LFW), et datasett med kjendisansikter som ofte brukes i ansiktsgjenkjenningsoppgaver, består av 77,5% menn og 83,5% menn med hvit hudfarge individer. En kunstig intelligens har ingen mulighet til å fungere skikkelig hvis dataene ikke representerer alle den skal betjene. Feilraten for ansiktsgjenkjenning blant de beste algoritmene ble funnet å være så lav som 0,8% for hvite menn og så høy som 34,7% for mørkhudede kvinner.

Denne forskningen kulminerte i den banebrytende Studie av kjønnsnyanser og en dokumentarfilm ved navn Kodet skjevhetsom undersøkte hvordan kunstig intelligens sannsynligvis lærer av mangelfulle og ikke-representative data.

Konsekvensene av dette er langt fra ufarlige - det har ført til feilaktige rettsavgjørelser, falske fengslinger, og kvinner og andre grupper har blitt nektet jobb og kreditt.

KI trenger mer data av høy kvalitet, som må være rettferdige og representative - Det er en vanskelig kombinasjon.

Er syntetiske data svaret?

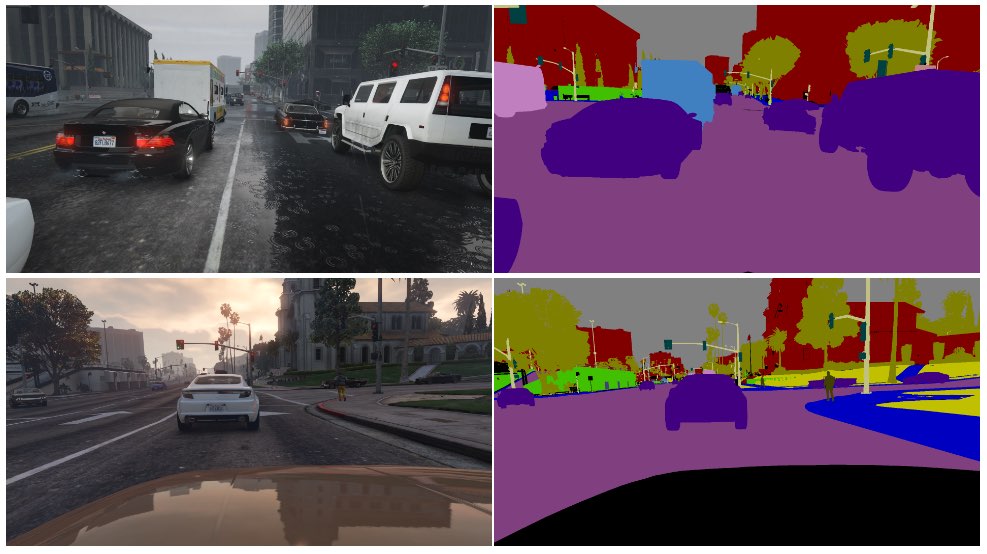

Syntetiske data brukes ofte i datasyn (CV), der kunstig intelligens identifiserer objekter og funksjoner fra bilder og video.

I stedet for å samle inn bildedata fra den virkelige verden - som å fotografere eller filme en gate, noe som er teknisk utfordrende og byr på problemer med personvernet - genererer du ganske enkelt dataene i et virtuelt miljø.

Selv om dette gir AI-ene mer data, har det flere ulemper:

- Det er ikke helt enkelt å modellere virkelige scenarier i et virtuelt miljø.

- Det er fortsatt kostbart og tidkrevende å generere store mengder syntetiske data.

- Randtilfeller og ekstremverdier er fortsatt et problem.

- Den kan ikke gjenskape den ekte varen perfekt.

- På den annen side kan noen aspekter være for perfekte, og det er vanskelig å finne ut hva som mangler.

Til syvende og sist er syntetiske data utmerket for lettvirtualiserte miljøer, som et fabrikkgulv, men de er ikke alltid like godt egnet for virkelige miljøer i rask bevegelse, som en bygate.

Hva med å generere syntetiske tekstdata?

Tekst er enklere enn bilde- eller videodata, så kan modeller som ChatGPT brukes til å generere nesten uendelig med syntetiske treningsdata?

Ja, men det er risikabelt, og konsekvensene er vanskelige å forutsi. Selv om syntetiske tekstdata kan bidra til å finjustere, teste og optimalisere modeller, er de ikke ideelle for å lære modeller ny kunnskap, og de kan forsterke skjevheter og andre problemer.

Her er en analogi som viser hvorfor det er problematisk å lære opp AI-er med AI-genererte data:

- Tenk deg en skole som bruker alle verdens beste lærebøker for å lære elevene alt som er mulig å lære fra ressursene i løpet av en dag.

- Deretter begynner skolen å produsere sitt eget arbeid basert på denne kunnskapen - på samme måte som en chatbot. Elevene har lært av alle data som var tilgjengelige da opplæringen startet, men de kan ikke effektivt innlemme nye data i kunnskapssystemet etterpå.

- Kunnskap skapes hver dag - og selv om det aller meste av menneskets kunnskap ble skapt før en bestemt dag, utvikler og forandrer kunnskapen seg over tid. Det er viktig å merke seg at mennesker ikke bare skaper ny kunnskap hele tiden - vi endrer også perspektivet vårt på eksisterende kunnskap.

- Anta nå at skolen, som er tom for data, begynner å undervise elevene ved hjelp av sine egne resultater. Elevene begynner å "spise" innholdet sitt for å produsere nytt innhold.

- På det stadiet klarer ikke studentenes resultater å tilpasse seg den virkelige verden, og nytteverdien avtar. Systemet gjentar sitt eget arbeid. Selv om arbeidet kan tilpasse seg og utvikle seg, gjør det det isolert fra alt utenfor denne tilbakemeldingssløyfen.

AI konfronterer stadig mennesker med gåter som skal løses, og denne har mange kommentatorer på Reddit og Y Combinator-forum forvirret.

Det er tankevekkende, og det er ingen reell enighet om konsekvensene.

Menneskelige dataetiketterere bruker ofte kunstig intelligens til å produsere data

Problemet med å produsere opplæringsdata av høy kvalitet har et annet, uforutsett aspekt.

Crowdworking-plattformer som Amazon Mechanical Turk (MTurk) brukes regelmessig av AI-selskaper som ønsker å produsere ekte "menneskelige" datasett. Tet er grunn til bekymring for at dataanmeldere på disse plattformene bruker kunstig intelligens til å utføre oppgavene sine.

Forskere ved École Polytechnique Fédérale de Lausanne (EPFL) i Sveits har analysert data fra MTurk for å undersøke om arbeiderne brukte kunstig intelligens til å generere innleggene sine.

Studiensom ble publisert 13. juni, fikk 44 MTurk-deltakere til å oppsummere sammendragene fra 16 medisinske forskningsartikler. Det viste seg at 33% til 46% av brukerne på plattformen genererte sammendragene sine med kunstig intelligens, til tross for at de ble bedt om å svare med naturlig språk.

"Vi utviklet en veldig spesifikk metode som fungerte veldig bra for å oppdage syntetisk tekst i vårt scenario", sier Manoel Ribeiro, medforfatter av studien og doktorgradsstudent ved EPFL, fortalte The Register denne uken.

Selv om studiens datasett og utvalgsstørrelse er ganske liten, er det langt fra utenkelig å tro at AI-er blir trent ubevisst på AI-generert innhold.

Studien handler ikke om å legge skylden på MTurk-arbeiderne - forskerne påpeker at lave lønninger og repetitivt arbeid bidrar til problemet. AI-selskaper vil ha menneskeskapte data av topp kvalitet og samtidig holde kostnadene lave. En kommentator sa på Reddit: "Jeg er for tiden en av disse arbeiderne, med oppgave å lære opp Bard. Jeg bruker helt sikkert ChatGPT til dette. 20$/time er ikke nok for den forferdelige behandlingen vi får, så jeg skal presse hver eneste cent ut av denne ******* jobben."

Kaninhullet blir enda dypere, ettersom kunstig intelligens ofte læres opp på data som skrapes fra internett. Etter hvert som det publiseres mer AI-skapt innhold på nettet, vil AI uunngåelig lære av sine egne resultater.

Etter hvert som mennesker begynner å bli avhengige av kunstig intelligens for å få informasjon, blir kvaliteten på det de produserer, stadig viktigere. Vi må finne innovative metoder for å oppdatere kunstig intelligens med ferske, autentiske data.

Som Ribeiro uttrykker det: "Menneskedata er gullstandarden, fordi det er mennesker vi bryr oss om, ikke store språkmodeller."

Arbeidet med å analysere den potensielle effekten av at kunstig intelligens bruker sine egne resultater pågår, men autentiske menneskelige data er fortsatt avgjørende for en lang rekke maskinlæringsoppgaver.

Å generere enorme mengder data for sultne AI-er samtidig som man navigerer i risikoer, er et pågående arbeid.