Eine Untersuchung der britischen Tageszeitung The Guardian hat den allgegenwärtigen Einsatz von KI und komplexen Algorithmen in verschiedenen Entscheidungsprozessen des öffentlichen Sektors aufgezeigt.

Beamte von mindestens acht öffentlichen Dienststellen sowie mehrere Polizeieinheiten haben KI-Tools in ihre Arbeitsabläufe integriert.

KI-Tools haben wichtige Entscheidungsprozesse in den Bereichen Wohlfahrt, Einwanderung und Strafjustiz unterstützt. Die Untersuchung ergab Hinweise auf Missbrauch und Diskriminierung.

Algorithmische und KI-bedingte Verzerrungen fallen zwar nicht unbedingt unter dieselbe Definition, aber beide bergen das Risiko verzerrter Ergebnisse, wenn sie realen Szenarien ausgesetzt werden. Selbstlernende Modelle des maschinellen Lernens können die in Datensätzen vorherrschenden Verzerrungen verstärken.

Nach Angaben der Bericht:

- Ein Abgeordneter hat Bedenken über einen Algorithmus des Ministeriums für Arbeit und Renten (DWP) geäußert, der vermutlich dazu geführt hat, dass zahlreiche Personen fälschlicherweise ihre Leistungen verloren haben.

- Es wurde festgestellt, dass das Gesichtserkennungsprogramm der Metropolitan Police unter bestimmten Bedingungen eine höhere Fehlerquote bei der Erkennung schwarzer Gesichter aufweist als bei weißen Gesichtern. Dies ist allgemein bekannt, mit eine Studie wonach diese Plattformen im Jahr 2018 eine Genauigkeit von mickrigen 2% boten.

- Das Innenministerium hat einen Algorithmus verwendet, der in unverhältnismäßiger Weise auf Personen bestimmter Nationalitäten abzielt, um betrügerische Eheschließungen im Hinblick auf Sozialleistungen und Steuervergünstigungen aufzudecken. Staatsangehörige aus Albanien, Griechenland, Rumänien und Bulgarien sind möglicherweise zu Unrecht markiert worden.

KI-Tools lernen Muster aus umfangreichen Datensätzen. Wenn die Datensätze verzerrt oder wenig repräsentativ für die Realität sind, übernimmt das Modell diese Muster.

Es gibt viele internationale Beispiele für die Voreingenommenheit von KI und Algorithmen, darunter falsche Gesichtserkennungsergebnisse, die zu Inhaftierungen führen, sowie Kreditbewertungssysteme Voreingenommenheit gegenüber Frauenund diskriminierende Instrumente, die in Gerichten und Gesundheitssystemen eingesetzt werden.

Dem Bericht des Guardian zufolge steht das Vereinigte Königreich nun am Rande eines potenziellen Skandals, wobei Experten Bedenken hinsichtlich der Transparenz und des Verständnisses der von den Beamten verwendeten Algorithmen äußern.

Skandale haben bereits in anderen Ländern zu beobachten sindwie zum Beispiel in den USA, wo Predictive Policing-Plattformen wurden abgebautund in den Niederlanden, wo sich die Gerichte gegen ein KI-System ausgesprochen haben, das den Sozialhilfebetrug eindämmen soll.

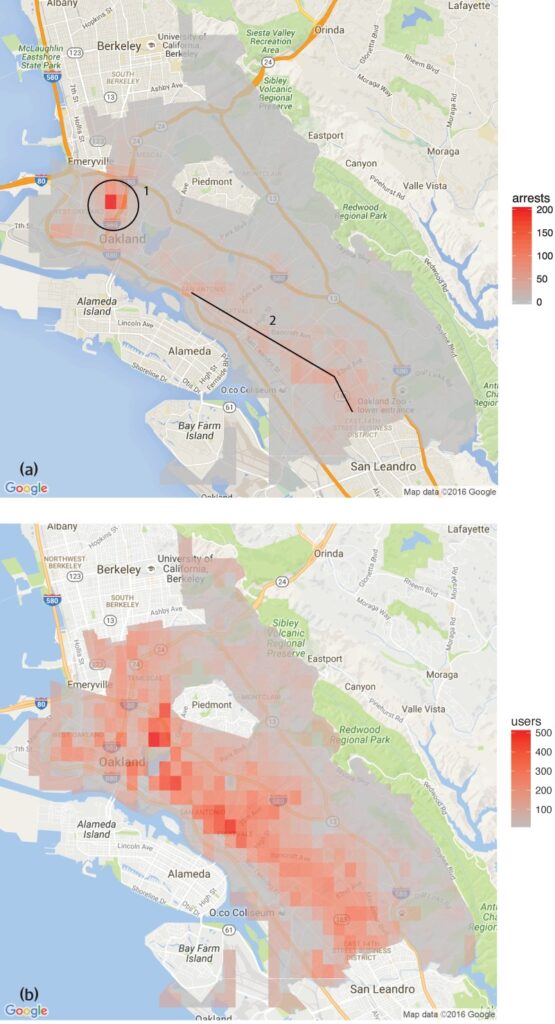

Eine Studie, die von der Gruppe für die Analyse von Menschenrechtsdaten stellte fest, dass die in Oakland (Kalifornien) eingesetzte Software für die vorausschauende Polizeiarbeit unverhältnismäßig häufig auf farbige Bevölkerungsgruppen abzielt und damit einen Kreislauf der übermäßigen Polizeiarbeit in diesen Vierteln aufrechterhält.

Dies spiegelt die von der Kommission geäußerten Bedenken wider. Das Gesichtserkennungsprogramm der Metropolitan Policedie unter bestimmten Bedingungen höhere Fehlerquoten bei der Erkennung schwarzer Gesichter aufwiesen.

Auch im Gesundheitswesen gibt es mehrere Beispiele, wie z. B. Ungereimtheiten in KI-Modellen, die bei der Erkennung von Hautkrebs helfen sollen. In den meisten Fällen sind Minderheitengruppen und Frauen am stärksten gefährdet.

Shameem Ahmad, Geschäftsführer des Public Law Project, betonte die Notwendigkeit sofortigen Handelns: "KI birgt ein enormes Potenzial für den gesellschaftlichen Nutzen. Wir können zum Beispiel Dinge effizienter machen. Aber wir dürfen die ernsten Risiken nicht ignorieren. Ohne dringende Maßnahmen könnten wir in eine Situation hineinschlummern, in der undurchsichtige automatisierte Systeme regelmäßig, möglicherweise unrechtmäßig, in lebensverändernder Weise eingesetzt werden und in der die Menschen nicht in der Lage sind, Rechtsmittel einzulegen, wenn diese Prozesse schief laufen."

Marion Oswald, Juraprofessorin an der Northumbria University, schließt sich diesen Bedenken an und weist auf die Ungereimtheiten und den Mangel an Transparenz bei der Nutzung von KI im öffentlichen Sektor hin: "Es mangelt an Konsistenz und Transparenz bei der Nutzung von KI im öffentlichen Sektor. Viele dieser Tools werden viele Menschen in ihrem Alltag betreffen, zum Beispiel diejenigen, die Sozialleistungen beantragen, aber die Menschen verstehen nicht, warum sie eingesetzt werden und haben keine Möglichkeit, sie in Frage zu stellen."

Die Risiken der KI für den öffentlichen Sektor

Der unkontrollierte Einsatz von KI in allen Ministerien und Polizeidienststellen gibt Anlass zu Bedenken hinsichtlich der Rechenschaftspflicht, Transparenz und Voreingenommenheit.

Im Fall des Ministeriums für Arbeit und Renten (Department for Work and Pensions, DWP) deckte der Bericht des Guardian Fälle auf, in denen ein Algorithmus die Leistungen von Menschen ohne eine klare Erklärung einstellte.

Die Abgeordnete Kate Osamor erklärte, dass ihre bulgarischen Wähler aufgrund eines halbautomatischen Systems, das ihre Fälle als potenzielle Betrugsfälle kennzeichnete, ihre Leistungen verloren haben, was einen Mangel an Transparenz verdeutlicht.

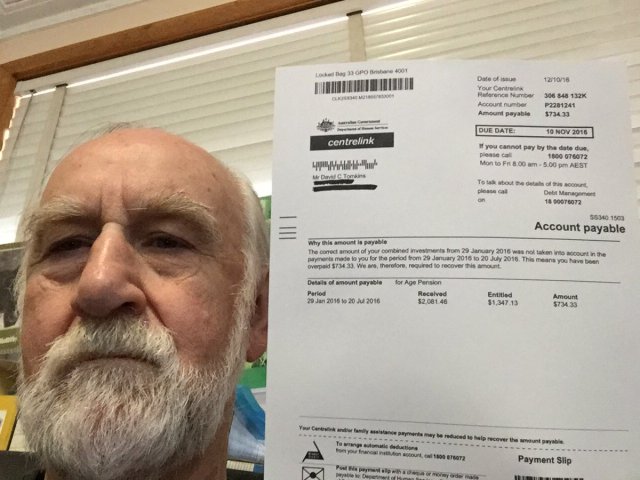

Dies erinnert an die "Robodebt"-Skandal in Australienwo ein automatisiertes System fälschlicherweise mehr als 400.000 Menschen des Sozialhilfebetrugs bezichtigte, was zu weit verbreiteten Härten führte.

Der Robodebt-Skandal, der Gegenstand von Untersuchungen des Commonwealth Ombudsman, rechtlichen Anfechtungen und öffentlichen Untersuchungen war, zeigte das Ausmaß der Auswirkungen algorithmischer Entscheidungen.

Die australische Regierung hat sich auf einen Betrag von $1,8 Milliarden AUS im Jahr 2021 geeinigt.

Die Unzulänglichkeiten der KI sind nicht auf den öffentlichen Dienst beschränkt. Auch in der Unternehmenswelt sind Fehler zu verzeichnen, insbesondere bei KI-gestützten Rekrutierungsinstrumenten.

Ein bemerkenswertes Beispiel ist das KI-Rekrutierungstool von Amazon, das eine Voreingenommenheit gegenüber weiblichen Bewerbern zeigte. Das System wurde anhand von Lebensläufen trainiert, die dem Unternehmen über einen Zeitraum von 10 Jahren vorgelegt wurden und von denen die meisten von Männern stammten, was dazu führte, dass die KI männliche Bewerber bevorzugte.

Drei Beispiele für algorithmische Verzerrungen, vor denen man sich in Acht nehmen sollte

Mit der Integration von KI und algorithmischer Entscheidungsfindung in komplexe gesellschaftliche Prozesse häufen sich alarmierende Beispiele für Voreingenommenheit und Diskriminierung.

Das Gesundheits- und Justizsystem der USA

Eine Studie 2019 veröffentlicht in Science ergab, dass ein in den USA weit verbreiteter Algorithmus für die Gesundheitsversorgung rassistische Vorurteile aufweist. Der Algorithmus verwies Schwarze mit geringerer Wahrscheinlichkeit an Programme, die die Versorgung von Patienten mit komplexen medizinischen Bedürfnissen verbessern sollten, als ihre weißen Gegenstücke.

Die Studie erklärt, warum: "Die Verzerrung entsteht, weil der Algorithmus die Gesundheitskosten als Ersatz für den Gesundheitsbedarf verwendet. Für schwarze Patienten wird bei gleichem Bedarf weniger Geld ausgegeben, so dass der Algorithmus fälschlicherweise zu dem Schluss kommt, dass schwarze Patienten gesünder sind als gleich kranke weiße Patienten."

Ein weiteres wichtiges Beispiel ist der Einsatz von KI bei der vorausschauenden Polizeiarbeit und der gerichtlichen Urteilsfindung. Tools wie Correctional Offender Management Profiling for Alternative Sanctions (COMPAS) wurden zur Bewertung des Rückfallrisikos von Angeklagten herangezogen.

Untersuchungen haben ergeben, dass diese Instrumente afroamerikanische Angeklagte benachteiligen können, indem sie ihnen höhere Risikoeinstufungen zuweisen als ihren weißen Mitbürgern. Dies gibt Anlass zu Bedenken hinsichtlich der Fairness und Unparteilichkeit von KI-gestützten Gerichtsentscheidungen.

Gesichtserkennung in Brasilien

Die Projekt Smart Sampa in São PauloBrasilien, war ein wichtiger Meilenstein bei der Integration von KI und Überwachung in städtische Landschaften - etwas, das bisher nur in China üblich war.

Bis zum Jahr 2024 sollen bis zu 20.000 Kameras in São Paulo installiert und eine gleiche Anzahl von Dritt- und Privatkameras in eine einzige Videoüberwachungsplattform integriert werden. Dieses Netzwerk wird öffentliche Plätze, medizinische Einrichtungen und Schulen überwachen und für die öffentliche Verwaltung relevante Inhalte in sozialen Medien überprüfen.

Während Smart Sampa mehr Sicherheit und bessere öffentliche Dienstleistungen verspricht, warnen Experten, dass es bestehende gesellschaftliche Probleme, insbesondere strukturellen Rassismus und Ungleichheit, verschärfen könnte.

Mehr als 90% der in Brasilien aufgrund von Gesichtserkennung verhafteten Personen sind schwarz. Die Initiative von São Paulo birgt die Gefahr, dass sich dieser Trend fortsetzt und die schwarze Gemeinschaft, die 56% der brasilianischen Bevölkerung ausmacht, weiter marginalisiert wird.

Technologien zur Gesichtserkennung erkennen häufig dunklere Hauttöne falsch, zum einen, weil die Bildgebungstechnologie bei dunklerem Teint unterdurchschnittlich abschneidet, und zum anderen, weil die Trainingsdatensätze nicht repräsentativ sind.

Fernanda Rodrigues, eine Anwältin für digitale Rechte, wies auf die Gefahr von Fehlalarmen und die daraus resultierende Gefahr der Masseninhaftierung von Schwarzen hin.

Rodrigues sagte: "Neben den Risiken, dass die in diese Plattformen eingespeisten Informationen nicht korrekt sind und das System selbst versagen könnte, gibt es ein Problem, das den technologischen Auswirkungen vorausgeht, nämlich Rassismus."

"Wir wissen, dass das brasilianische Strafvollzugssystem selektiv ist, so dass wir zu dem Schluss kommen können, dass es [bei der Überwachung mit Gesichtserkennung] nur darum geht, die Risiken und Schäden für diese Bevölkerungsgruppe zu erhöhen", fügte sie hinzu.

Auch der Schutz der Privatsphäre steht im Vordergrund. Kritiker argumentieren, dass Smart Sampa grundlegende Menschenrechte verletzen könnte, darunter die Privatsphäre, die Meinungs-, Versammlungs- und Vereinigungsfreiheit. Erschwerend kommt hinzu, dass das Projekt undurchsichtig ist und die Öffentlichkeit während der Konsultationsphase nur begrenzt einbezogen wurde.

Smart Sampa ist nicht unangefochten geblieben. Staatsanwälte haben ermittelt, und Menschenrechtsorganisationen haben rechtliche Schritte eingeleitet, um die Technologie zu stoppen.

Die niederländische System Risk Indication (SyRI)

Im Jahr 2022 überprüfte das Bezirksgericht Den Haag den Einsatz der niederländischen Regierung von System-Risiko-Anzeige (SyRI)ein Algorithmus, der potenziellen Sozialhilfebetrug aufdecken soll.

SyRI sollte die Effizienz bei der Ermittlung von Sozialhilfebetrug erhöhen, indem es Daten aus verschiedenen staatlichen Datenbanken zusammenführt und anhand von Risikoindikatoren Profile potenzieller Betrüger erstellt. Verdächtige Entscheidungen und ein Mangel an Transparenz ließen jedoch die Alarmglocken schrillen und führten zu einer rechtlichen Anfechtung durch eine Koalition von Organisationen der Zivilgesellschaft.

Die Kläger machten geltend, dass SyRI gegen verschiedene internationale und europäische Menschenrechtsgesetze verstoße. Sie stellten auch die Rechtmäßigkeit, Notwendigkeit und Verhältnismäßigkeit der Anwendung des Algorithmus in Frage.

Das Bezirksgericht in Den Haag entschied, dass die Rechtsvorschriften für SyRI und ihre Anwendung nicht den erforderlichen Menschenrechtsstandards entsprechen. Das Gericht wies auf die mangelnde Transparenz und das Potenzial für diskriminierende Auswirkungen hin und betonte die Notwendigkeit angemessener rechtlicher Schutzmaßnahmen bei der Einführung solcher Technologien.

Der Fall wurde als einer der ersten gepriesen, der sich mit den Auswirkungen der künstlichen Intelligenz auf die Menschenrechte im öffentlichen Sektor befasst und die Notwendigkeit von Transparenz, Rechenschaftspflicht und soliden rechtlichen Rahmenbedingungen unterstreicht.

Transparentes und faires Testen von Werkzeugen ist von größter Bedeutung

Im Zuge der jüngsten juristischen Anfechtungen und der öffentlichen Untersuchung der algorithmischen Entscheidungsfindung in der Verwaltung wird die Forderung nach transparenten Tests von KI-Tools immer dringlicher.

Um Rechenschaftspflicht zu gewährleisten, Diskriminierung zu verhindern und das öffentliche Vertrauen zu erhalten, müssen strenge und offene Prüfprotokolle eingeführt werden.

Transparente Tests ermöglichen ein umfassendes Verständnis der Funktionsweise dieser Algorithmen, der von ihnen verwendeten Daten und der Entscheidungsprozesse, denen sie folgen. Dies ist entscheidend, um potenzielle Verzerrungen, Ungenauigkeiten oder diskriminierende Praktiken innerhalb des Systems zu erkennen.

Strenge Testverfahren stehen jedoch im Widerspruch zu der von der KI versprochenen schnellen Effizienz.

Im Falle des Vereinigten Königreichs hat der Premierminister Rishi Sunak innovationsfreundliche" Haltunge lässt vielleicht nicht genug Raum für umfassende Testverfahren. Außerdem gibt es nur wenige - wenn überhaupt - vereinbarte Verfahren für das Testen von KI-Tools vor ihrer Verbreitung für die öffentliche Nutzung.

Dieses Szenario spiegelt sich weltweit wider. Die rasch zunehmende Einführung von KI sollte nicht auf Kosten einer genauen Prüfung und Analyse gehen.