1956 verfasste Philip K. Dick eine Novelle mit dem Titel "The Minority Report" (Der Minderheitenbericht), die von einer Zukunft handelt, in der "Precogs" Verbrechen vorhersehen können, bevor sie sich in der Realität ereignen.

Einige Jahrzehnte später brachte Tom Cruise diese unheimliche Vision auf die Leinwand und jagte auf der Grundlage dieser Vorhersagen Möchtegern-Verbrecher.

Beide Versionen zwangen uns, über die ethischen Implikationen nachzudenken, die es hat, wenn man für etwas verhaftet wird, das man in Zukunft tun könnte.

Heute, wo sich die Methoden der vorausschauenden Polizeiarbeit ihren Weg in die moderne Strafverfolgung bahnen, muss man sich fragen: Stehen wir an der Schwelle zur Verwirklichung von Dicks vorausschauender Erzählung?

Was ist prädiktive Polizeiarbeit, und wie funktioniert sie?

Predictive Policing verbindet Strafverfolgung und fortschrittliche Analytik und nutzt maschinelles Lernen, um kriminelle Handlungen vorherzusehen, bevor sie entstehen.

Die Prämisse ist auf dem Papier einfach: Wenn wir die in historischen Verbrechensdaten verborgenen Muster entschlüsseln können, können wir Algorithmen zur Vorhersage künftiger Vorfälle entwickeln.

Der Prozess beginnt mit dem Sammeln von historischen Verbrechensaufzeichnungen, Überwachungsdaten, Social-Media-Chatter und sogar Nuancen wie Wetterschwankungen. Dieser riesige Bestand an Informationen wird dann in ausgeklügelte maschinelle Lernmodelle eingespeist, die darauf ausgelegt sind, die zugrunde liegenden Muster zu erkennen.

So könnte das Modell beispielsweise feststellen, dass in einem bestimmten Viertel in regnerischen Wochenendnächten besonders viele Einbrüche verübt werden.

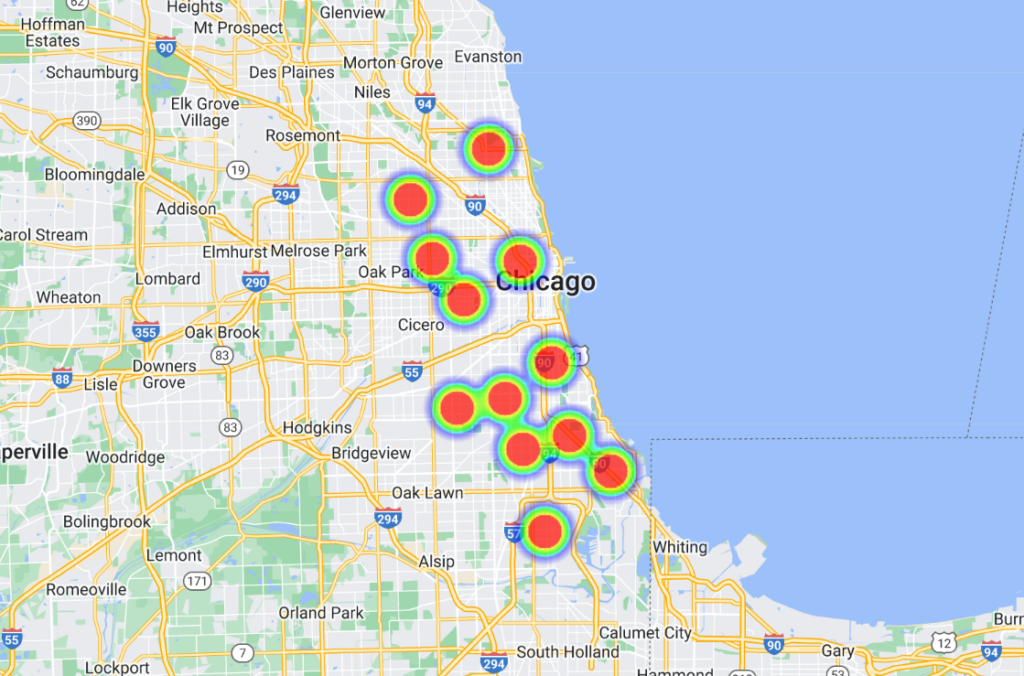

Sobald diese Korrelationen herausgearbeitet sind, werden sie von fortschrittlichen Softwareplattformen in visuelle Darstellungen umgewandelt, die oft "Heatmaps" ähneln und wahrscheinliche Kriminalitätsschwerpunkte hervorheben. Dies wiederum ermöglicht es der Polizei, ihre Ressourcen proaktiv zuzuweisen und ihre Patrouillen und Interventionen zu optimieren.

Einige Modelle gehen noch einen Schritt weiter und listen die Personen nach Namen und Adresse auf, so dass die Beamten über sehr spezifische und lokalisierte Prognosen verfügen.

Die Geschichte der vorausschauenden Polizeiarbeit

Die Technologie der vorausschauenden Polizei steckt noch in den Kinderschuhen, und obwohl es bereits einige einflussreiche Akteure wie Palantir gibt, ist die Branche noch klein.

Im Juni 2022 wird die Universität von Chicago ein KI-Modell entwickelt die in der Lage ist, Kriminalitätsorte und -raten innerhalb der Stadt mit einer angeblichen Genauigkeit von 90% vorherzusagen.

Auf der Grundlage offener Kriminalitätsdaten aus den Jahren 2014 bis 2016 teilte das Team Chicago in Quadrate von etwa 300 m Länge ein. Das Modell konnte eine Woche im Voraus vorhersagen, auf welchem Platz die Wahrscheinlichkeit eines Verbrechens am höchsten war.

Die Studie verfolgte ehrliche Absichten, indem sie räumliche und sozioökonomische Verzerrungen bei den polizeilichen Bemühungen und der Mittelzuweisung aufdeckte. Es wurde festgestellt, dass wohlhabende Viertel mehr Ressourcen erhielten als einkommensschwächere Gebiete.

In der Studie heißt es: "Wir zeigen, dass prädiktive Modelle zwar die Macht des Staates durch die Überwachung von Straftaten stärken können, aber auch die Überwachung des Staates ermöglichen, indem sie systemische Verzerrungen bei der Strafverfolgung aufspüren."

Darüber hinaus wurde das Modell mit Daten aus sieben anderen US-Städten trainiert, wobei ähnliche Ergebnisse erzielt wurden. Alle Datensätze und Algorithmen wurden auf GitHub zur Verfügung gestellt.

Chicago ist eine wichtige Fallstudie für datengesteuerte und KI-gestützte Polizeiarbeit. Ein weiteres Beispiel ist die städtische Heatmap zur Waffenkriminalitätdie "Hotspots" der Kriminalität identifiziert, die in die polizeilichen Bemühungen einfließen können.

Ein bemerkenswerter Vorfall aus dem Jahr 2013 - in den Anfängen der vorausschauenden Polizeiarbeit - beteiligt Robert McDanielsein Bewohner von Chicagos Stadtteil Austin, auf den 90% der Waffendelikte in der Stadt entfallen.

Obwohl er keine Gewalttaten begangen hat, wurde McDaniel aufgrund seiner Aufnahme in eine Liste potenziell gewalttätiger Straftäter zweimal zur Zielscheibe von Waffengewalt, weil die Polizei vor seiner Tür stand und ihn zur Zielscheibe machte.

Eine Untersuchung von The Verge heißt es, dass ein Journalist der Chicago Tribune McDaniel wegen der "Heat List" kontaktiert hat - ein inoffizieller Name, den die Polizei den Algorithmen zugewiesen hat, die potenzielle Schützen und Ziele kennzeichnen.

Ishanu Chattopadhyay, der leitende Forscher des Projekts 2022 Chicago Projekt zur Verbrechensvorhersagebetonte, dass ihr Modell Standorte vorhersagt, nicht Personen. "Es ist nicht Minority Report", sagte er - aber das McDaniels-Ereignis weist sicherlich einige Parallelen auf.

Chattopadhyay wies darauf hin, dass die von den Bürgern gemeldeten geringfügigen Drogen- und Verkehrsverstöße absichtlich ausgelassen wurden und der Schwerpunkt auf häufiger gemeldeten Gewalt- und Eigentumsdelikten lag.

Allerdings ist sStudien zeigen, dass Schwarze häufiger wegen Straftaten angezeigt werden als ihre weißen Altersgenossen. Folglich werden schwarze Viertel zu Unrecht als "Hochrisikogebiet" eingestuft.

Darüber hinaus führt eine verstärkte Polizeipräsenz in einem Gebiet zu mehr gemeldeten Straftaten, wodurch eine Rückkopplungsschleife entsteht, die die Wahrnehmung der Kriminalität verzerrt.

Wenn man sich dann auf Daten aus der Vergangenheit verlässt, können sich Stereotypen verfestigen und das Potenzial für Veränderungen und Rehabilitation übersehen werden.

Wie hat sich die vorausschauende Polizeiarbeit bewährt?

Es überrascht nicht, dass die vorausschauende Polizeiarbeit sehr umstritten ist, aber funktioniert sie überhaupt oder erfüllt sie ihren grundlegenden Zweck?

Eine Untersuchung vom Oktober 2023 durch Die Markup und Wired deckten eklatante Fehler auf und fügten sich in die wachsende Zahl von Beweisen ein, die die Gefahren und Unzulänglichkeiten der Übertragung von Strafverfolgungsentscheidungen auf Maschinen aufzeigen.

Das Programm im Fokus ist Geoliticaeine Software zur vorausschauenden Polizeiarbeit, die von der Polizei in Plainfield, New Jersey, eingesetzt wird. Es ist erwähnenswert, dass die Polizei von Plainfield die einzige von 38 Dienststellen war, die bereit war, Daten mit den Medien zu teilen.

Früher bekannt als PredPolwurde diese Software für maschinelles Lernen von verschiedenen Polizeidienststellen erworben.

The Markup und Wired analysierten 23.631 Vorhersagen von Geolitica von Februar bis Dezember 2018. Davon stimmten weniger als 100 Vorhersagen mit realen Verbrechen überein, was eine Erfolgsquote von weniger als einem halben Prozent ergibt.

Diese Prognosemodelle sind seit jeher umstritten und werfen zahlreiche ethische Fragen auf, da sie diskriminierende und rassistische Vorurteile verstärken können, die in der KI und der Strafverfolgung weit verbreitet sind.

Diese jüngste Untersuchung unterstreicht ethische Dilemmata und stellt die Wirksamkeit der Software bei der Vorhersage von Verbrechen in Frage.

Obwohl die Software leichte Abweichungen in der Vorhersagegenauigkeit bei den verschiedenen Verbrechensarten zeigte (z. B. wurden 0,6 Prozent der Raubüberfälle oder schweren Körperverletzungen korrekt vorhergesagt, im Vergleich zu 0,1 Prozent der Einbrüche), bleibt die übergreifende Aussage eine grobe Unterbewertung.

Die freimütige Antwort des Polizeichefs von Plainfield, David Guarino, wirft ein Licht auf die Realität. "Warum haben wir PredPol angeschafft? Wir wollten unsere Effizienz bei der Verbrechensbekämpfung verbessern", so Guarino.

"Ich bin mir nicht sicher, ob sie das erreicht hat. Wir haben es selten, wenn überhaupt, benutzt." Er erwähnte auch, dass die Polizeibehörde das System nicht mehr verwendet.

Kapitän Guarino schlug vor, dass die für Geolitica bereitgestellten Mittel - die sich auf eine jährliche Abonnementgebühr von $20.500 plus zusätzliche $15.500 für ein zweites Jahr beliefen - besser in gemeinschaftsorientierte Programme hätten investiert werden können.

Geolitica wird den Betrieb bis zum Jahresende einstellen.

Beweise für Voreingenommenheit bei vorausschauender Polizeiarbeit

Das Versprechen der vorausschauenden Polizeiarbeit bleibt verlockend, insbesondere da die Polizeikräfte immer stärker beansprucht werden und die Qualität der polizeilichen Entscheidungsfindung in Verruf geraten ist.

Die Polizeikräfte in den USA, im Vereinigten Königreich und in mehreren europäischen Ländern, darunter Frankreich, werden wegen Vorurteilen gegenüber Minderheitengruppen unter die Lupe genommen.

Mitglieder des britischen Ober- und Unterhauses drängen auf eine vorübergehender Stillstand über den Einsatz von Live-Gesichtserkennungstechnologie durch die Polizei.

Dies wurde bekannt, nachdem Polizeiminister Chris Philip erörtert hatte, den Polizeikräften Zugang zu 45 Millionen Bildern aus der Passdatenbank für die polizeiliche Gesichtserkennung zu gewähren. Bislang haben sich 65 Parlamentarier und 31 Organisationen für Rechte und Rassengleichheit gegen den Einsatz von Gesichtserkennungstechnologien in der Polizeiarbeit ausgesprochen.

Die Interessengruppe Big Brother Uhr stellte fest, dass 89% der polizeilichen Gesichtserkennungswarnungen im Vereinigten Königreich ihren Zweck nicht erfüllen, mit unverhältnismäßig schlechteren Ergebnissen für ethnische Minderheiten und Frauen. Ein 2018 von der Londoner Metropolitan Police durchgeführter Gesichtserkennungsversuch hatte ein enttäuschendes Ergebnis Erfolgsquote von nur etwa 2%.

Wie Michael Birtwistle vom Ada Lovelace Institute, beschriebenDie Genauigkeit und die wissenschaftliche Grundlage der Gesichtserkennungstechnologien sind höchst umstritten, und ihre Rechtmäßigkeit ist ungewiss.

In den USA wurden im Rahmen eines Gemeinschaftsprojekts, an dem die Columbia University, das AI Now Institute und andere beteiligt waren, kürzlich Gerichtsverfahren in den USA analysiert, bei denen Algorithmen eine Rolle spielten.

Die Studie ergab, dass KI-Systeme oft übereilt und ohne angemessene Aufsicht eingeführt wurden, hauptsächlich um Kosten zu sparen. Leider führten diese Systeme aufgrund inhärenter Vorurteile häufig zu verfassungsrechtlichen Problemen.

Mindestens vier Schwarze wurden in den USA fälschlicherweise verhaftet und/oder inhaftiert, weil ihr Gesicht nicht korrekt zugeordnet werden konnte, darunter Nijeer Parksfälschlicherweise Er wurde des Ladendiebstahls und von Verkehrsdelikten beschuldigt, obwohl er 30 Meilen von den angeblichen Vorfällen entfernt war. Er verbrachte daraufhin zehn Tage im Gefängnis und musste Tausende von Gerichtskosten zahlen.

Die Die Autoren der Studie kamen zu dem SchlussDiese KI-Systeme wurden ohne sinnvolle Schulung, Unterstützung oder Aufsicht und ohne besonderen Schutz für die Empfänger eingeführt. Dies ist zum Teil darauf zurückzuführen, dass sie eingeführt wurden, um Kosteneinsparungen und Standardisierung im Rahmen eines monolithischen Technologie-Beschaffungsmodells zu erzielen, bei dem verfassungsrechtliche Haftungsfragen nur selten berücksichtigt werden.

Vorausschauende Polizeiarbeit kann unnatürliche Entscheidungen fördern

Selbst wenn die vorausschauende Polizeiarbeit genau ist, muss der Mensch auf die Vorhersagen reagieren, und das ist der Punkt, an dem die Dinge unübersichtlich werden.

Wenn ein Algorithmus der Polizei mitteilt, dass sie an einem bestimmten Ort sein muss, weil ein Verbrechen begangen wird oder wahrscheinlich begangen werden wird, ist es durchaus denkbar, dass dies die Entscheidungsfindung verzerrt.

Es gibt einige grundlegende psychologische Theorien, mit denen man sich auseinandersetzen sollte, wenn man die Rolle der KI in der Polizeiarbeit betrachtet.

Erstens: Wenn ein Algorithmus die Polizei über einen wahrscheinlichen Tatort informiert, führt dies möglicherweise dazu, dass die Polizei die Situation durch eine Brille der Erwartung betrachtet. Dies könnte bei dem McDaniels-Vorfall eine Rolle gespielt haben - die Polizei kam in Erwartung eines Vorfalls am Tatort an und löste eine Eskalation der Ereignisse in einem unbeständigen Umfeld aus.

Dies liegt an der Bestätigungspräferenz, die besagt, dass wir, sobald wir eine Information haben, dazu neigen, nach weiteren Informationen zu suchen und diese so zu interpretieren, dass sie mit unserer ursprünglichen Überzeugung übereinstimmen.

Wenn jemandem von einem Algorithmus gesagt wird, dass ein Verbrechen wahrscheinlich ist, kann er unbewusst den Hinweisen, die diese Vorhersage bestätigen, mehr Gewicht beimessen und diejenigen übersehen, die ihr widersprechen.

Darüber hinaus können Algorithmen, insbesondere wenn sie in amtlicher Funktion verwendet werden, aufgrund ihres rechnerischen Charakters als maßgebend angesehen werden, und Beamte könnten ihnen unangemessenes Vertrauen entgegenbringen.

Und dann gibt es noch das Risiko eines moralischen Rückzugs. Die Beamten könnten die Verantwortung für ihre Handlungen auf den Algorithmus abwälzen und denken, dass die Software die Entscheidung getroffen hat und nicht sie selbst - was auch im Bereich der Kriegsführung von großer Bedeutung ist.

Diese Debatten laufen parallel zu den Debatten über Der Einsatz von KI auf dem Schlachtfelddie einige ähnliche Dilemmas aufwirft.

Die auferlegte Autorität der KI kann zu einer "Verantwortungslücke" führen, bei der niemand die Verantwortung für Fehler der KI übernimmt, wie Kate Crawford und Jason Schultz in einem kürzlich erschienenen JSTOR-Artikel.

Alles in allem zeigt sich, dass prädiktive Polizeiarbeit häufig Vorurteile eher aufrechterhält als abbaut.

Wenn sich Vorhersagen mit menschlichen Entscheidungen verbinden, können die Auswirkungen katastrophal sein.