Необъятность Вселенной издавна пленяла человеческое воображение, побуждая нас задаваться вопросом: а одни ли мы?

Этот вопрос волнует человечество на протяжении тысячелетий, и сегодня у нас есть технологии - например, радиотелескопы, - чтобы продвинуть поиск внеземного разума (SETI) еще глубже в космос.

Мы до сих пор ничего не нашли. Никаких окончательных доказательств существования внеземной жизни не было обнародовано, и поиски продолжаются.

That’s despite there being billions of potentially habitable worlds in the Milky Way alone, including some 1,780 confirmed exoplanets (planets beyond our solar system), 16 of which are located in their star’s habitable zone. Some, like the ‘super-Earth’ Кеплер-452bСчитается, что они удивительно похожи на нашу планету.

Для поддержания жизни не нужны идеальные условия. Экстремофильные бактерии на Земле способны жить в одних из самых суровых условий на нашей планете. И не только микробы могут процветать в экстремальных условиях. Помпейский червь, например, обитает в гидротермальных источниках на дне океана и может выдерживать температуру до 176°F (80°C).

Тардиграды, также известные как водяные медведи, могут выживать в вакууме космоса, переносить экстремальную радиацию и выдерживать давление, в шесть раз превышающее давление в самых глубоких частях океана. Устойчивость жизни на Земле в сочетании с огромным количеством привычных миров заставляет многих ученых согласиться с тем, что существование инопланетян статистически не менее вероятно.

Если это так, то где же скрывается внеземная жизнь? И почему она не раскрывается?

От парадокса Ферми до Великого фильтра

Those questions appeared in a casual conversation between physicists and astronomers Enrico Fermi, Edward Teller, Herbert York, and Emil Konopinski in 1950. Ферми знаменито спрашивал: "Где все?" или "Где они?". (точная формулировка неизвестна).

Теперь широко известная Парадокс Ферми формулируется так: учитывая огромное количество звезд и потенциально пригодных для жизни планет в нашей галактике, почему мы не обнаружили признаков существования инопланетных цивилизаций?

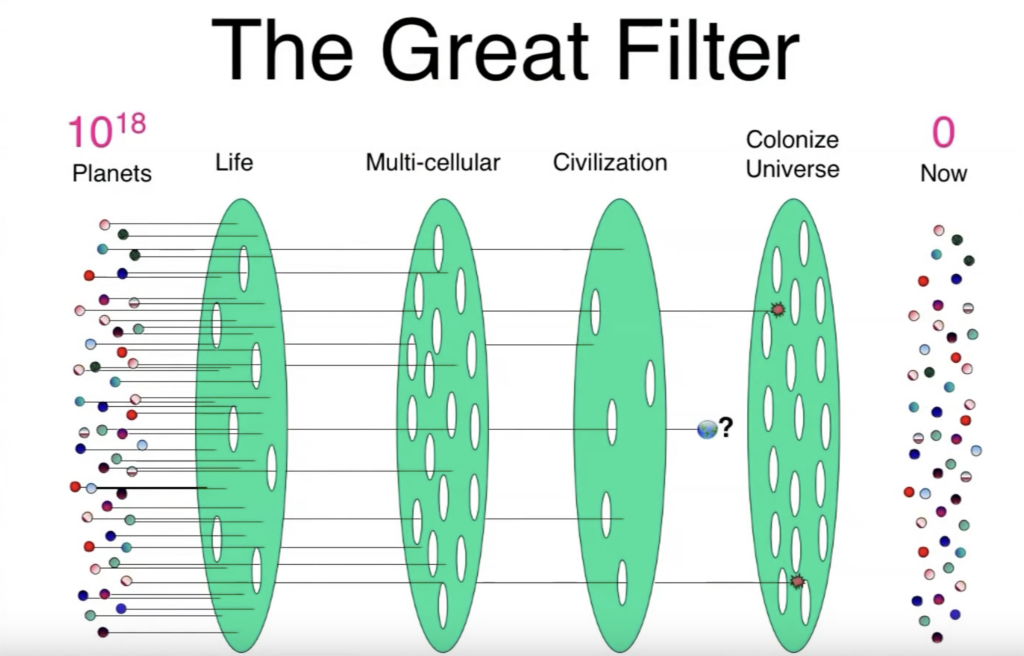

Когда парадокс Ферми вошел в научный оборот, многочисленные гипотезы пытались его опровергнуть, устранить, исправить или усилить, включая концепцию "Отличный фильтр," представленная экономистом Робином Хэнсоном в 1998 году.

Гипотеза Великого фильтра утверждает, что существует стадия развития или препятствие, преодолеть которое жизни крайне сложно или почти невозможно.

Другими словами, цивилизации предсказуемо и неизменно терпят крах, будь то из-за истощения ресурсов, природных катаклизмов, межпланетных угроз или других неконтролируемых экзистенциальных рисков.

Одна из особенностей Великого фильтра заключается в том, что мы не знаем, находится ли он позади нас или перед нами. Если фильтр уже позади - например, если возникновение жизни само по себе является крайне редким событием, - это говорит о том, что мы преодолели самое сложное и, возможно, являемся редкими или даже одинокими во Вселенной.

Этот сценарий, несмотря на потенциальную изоляцию, оптимистично оценивает наши будущие перспективы. Однако если Великий фильтр ждет нас впереди, это может стать гибелью для нашего долгосрочного выживания. И это также объясняет, почему мы не видим свидетельств существования других цивилизаций.

Великий фильтр усугубляется огромными размерами космоса и короткими временными рамками, связанными с развитой цивилизацией.

Если бы человечество уничтожило себя в ближайшие 100 лет, то технологический век едва ли продержался бы 500 лет.

Это исключительно маленькое окно для нас, чтобы обнаружить инопланетян или для инопланетян, чтобы обнаружить нас, прежде чем Великий фильтр вступит в силу.

ИИ приносит новые головоломки в парадокс Ферми

Молчание космоса породило множество гипотез, но последние разработки в области искусственного интеллекта добавляют новые интригующие аспекты к этой вековой загадке. ИИ представляет возможность создания небиологической формы жизни, которая может существовать практически бесконечно, как в физической, так и в цифровой форме.

Она также может пережить биологические цивилизации, которые ее создают, спровоцировать или ускорить их гибель, тем самым запустив "Великий фильтр", который не позволяет жизни расширяться.

Эта гипотеза, недавно предложенная в эссе Астроном Майкл А. Гарретт утверждает, что развитие искусственного сверхинтеллекта (ИСИ), более сложной формы искусственного общего интеллекта (ИОИ), является критическим моментом для цивилизаций.

Как объясняет Гарретт:

"Развитие искусственного интеллекта (ИИ) на Земле, вероятно, будет иметь глубокие последствия для будущего человечества. В контексте парадокса Ферми он предлагает новое решение, в котором появление ИИ неизбежно приведет к исчезновению биологического интеллекта и его замене кремниевыми формами жизни".

В основе гипотезы Гаррета лежит идея о том, что по мере развития цивилизаций они неизменно разрабатывают ИИ, который вытесняет, сливается с биологическими создателями или уничтожает их.

Чтобы снизить этот риск, Гарретт призывает к регулированию, солидаризируясь с влиятельными исследователями ИИ, которые также предупреждают об экзистенциальных рисках ИИЭто и Йошио Бенгио, и Макс Тегмарк, и Джордж Хинтон, и люди, не принадлежащие к этому сектору, например, покойный Стивен Хокинг.

Однако масштабы рисков, связанных с искусственным интеллектом, вызывают жаркие споры: некоторые, например Ян ЛеКун (один из так называемых "крестных отцов ИИ", наряду с Бенджио и Хинтоном), утверждают, что риски, связанные с ИИ, сильно преувеличены.

Тем не менее, эссе Гаретта предлагает заманчивую гипотезу. В жажде получить технологическое противоядие от социальных и экологических проблем человечество пригубило из чаши с ядом искусственного интеллекта, спровоцировав свое падение, как и бесчисленные цивилизации до него.

Гипотеза колонизации ИИ

Хотя идея о том, что ИИ выступает в роли Великого фильтра, является убедительным объяснением Парадокса Ферми, в ней есть некоторые загвоздки.

First and foremost, it assumes ASI is possible. Right now, there are both architectural and infrastructural constraints.

On the architectural front, designing AI systems that can match or surpass human-level intelligence across a wide range of domains remains elusive. While excellent at specific tasks like image recognition, language processing, and gameplay, AI systems lack organic problem-solving and creative skills.

Разработка архитектур ИИ, способных обучаться, рассуждать и гибко применять знания в новых ситуациях, - это грандиозная задача, которая, вероятно, потребует фундаментальных прорывов в области обучения без контроля, трансферного обучения, рассуждений на основе здравого смысла и т. д.

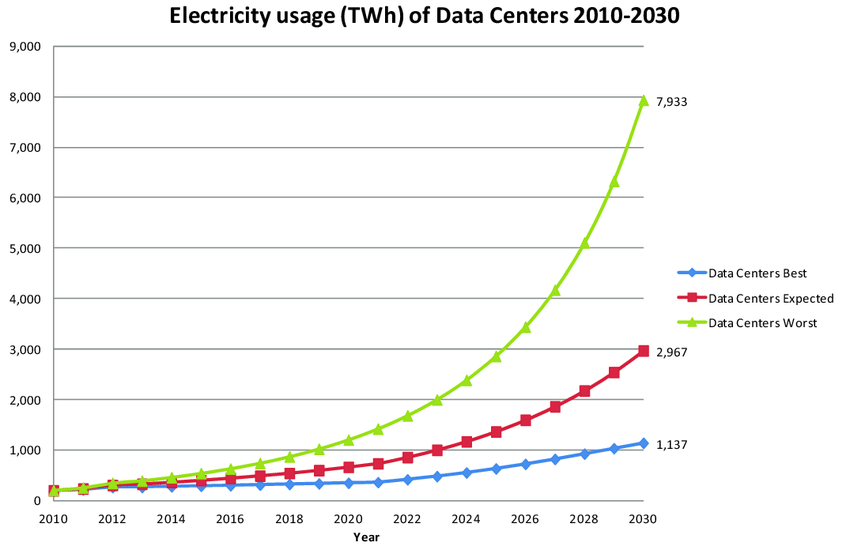

Что касается инфраструктуры, то обучение самых современных моделей ИИ уже сейчас выводит из строя современное вычислительное оборудование, потребляя огромные объемы энергия и ресурсы. The computational requirements for achieving ASI are likely to be orders of magnitude greater.

Но давайте на время оставим эти споры в стороне и предположим, что сверхинтеллект в конце концов станет возможным.

Если эти будущие системы ASI достаточно развиты, чтобы заменить или коренным образом изменить своих создателей, не будут ли они также способны к быстрой космической экспансии и колонизации? Почему он должен остановиться на том, чтобы заменить/уничтожить своих создателей?

Более того, если потенциально тысячи, миллионы, даже миллиарды землеподобных миров подверглись воздействию этого Великого фильтра, вызванного ИИ, вероятность существования версий ASI, которые стремятся к межпланетным завоеваниям, становится еще более вероятной.

Motivations could range from logical (resource gathering, self-preservation) to bizarre (mimicking behaviors from fiction, video games, films, etc.). Now, what if this AI decides that spreading across the cosmos is the ultimate way to fulfill those goals?

Идет ли речь о расширении влияния, сборе ресурсов или удовлетворении ненасытной любопытствоВысокоинтеллектуальные системы искусственного интеллекта могут сосредоточиться на колонизации с полной решимостью.

Более того, по мере того как системы ИИ становятся все более агентурными, возникает риск возникновения непреднамеренных или неправильных "эмерджентных целей". Недавняя антропология и DeepMind исследования показали, как современные системы ИИ способны разрабатывать сложные игровые стратегии ИИ, которые не были запрограммированы в явном виде.

В будущем мощная система ИИ, стремящаяся к максимизации своей мощи, сможет выработать стратегию экспансии и приобретения ресурсов, взяв под контроль производственные мощности, критически важные объекты инфраструктуры и т. д.

Это не так надуманно, как кажется. Например, в мире кибербезопасности происходит сближение ИТ-сетей и технологий, обеспечивающих работу критической инфраструктуры, производственных предприятий и т. д.

Computers in offices, once separate from the computers in power plants or factories, are starting to connect and work together. This means that if someone, or something like an AI, breaks into IT networks, they could gain control of machines in a power plant.

Продвинутые вредоносные программы, включая Вредоносные программы с искусственным интеллектомУже сейчас можно перейти от ИТ-сетей к цифровым промышленным средам, взяв под контроль критически важные системы, от которых мы зависим.

Можно представить, как неавторизованные системы агентского ИИ могут использовать эти системы в своих интересах.

Устойчивость искусственного интеллекта в космических масштабах времени

ИИ не просто облегчает освоение космоса - он полностью меняет представление о возможностях.

Не нуждаясь в воздухе, пище или защите от радиации, ИИ может отправиться в самые суровые уголки Вселенной. И он может делать это в течение времени, которое поражает человеческий разум.

Долговечность и стойкость ИИ открывает массу преимуществ для колонизации космоса:

- Долголетие: В отличие от биологических существ, ИИ не будет ограничен коротким сроком жизни. Это делает долгосрочные космические путешествия и проекты колонизации гораздо более осуществимыми. ИИ может совершать путешествия, длящиеся тысячи и даже миллионы лет, не беспокоясь о смене поколений или психологическом воздействии длительных космических путешествий на биологические существа.

- Адаптация: ИИ потенциально может адаптироваться к гораздо более широкому диапазону условий, чем биологическая жизнь. В то время как мы ограничены узким диапазоном температур, давлений и химических условий, ИИ теоретически может функционировать в условиях экстремального холода, вакуума или даже сокрушительного давления и сильного жара в атмосферах газовых гигантов.

- Эффективность использования ресурсов: ИИ может потребовать гораздо меньше ресурсов для своего существования, чем биологическая жизнь. Ему не нужен воздух, пригодный для дыхания, питьевая вода или постоянный запас пищи. Это может сделать дальние путешествия и колонизацию гораздо более жизнеспособными.

- Быстрое самосовершенствование: Движимый внутренним или внешним желанием, ИИ может постоянно модернизировать и совершенствовать себя, причем потенциально с экспоненциальной скоростью. Это может привести к технологическому прогрессу, выходящему далеко за рамки того, что мы можем себе представить.

Как объяснили астроном Ройал Мартин Рис и астрофизик Марио Ливио в статье статья опубликована в журнале Scientific American:

"История человеческой технологической цивилизации может измеряться тысячелетиями (не более), и может пройти еще одно или два столетия, прежде чем людей догонит или перегонит неорганический интеллект, который, возможно, сохранится, продолжая эволюционировать в более быстром, чем дарвиновское, масштабе, в течение миллиардов лет".

Какую форму примет этот внеземной ИИ? Это пока никто не знает, но исследователи предлагают увлекательные варианты.

На сайте книга Жизнь 3.0: Быть человеком в эпоху искусственного интеллектаФизик и исследователь ИИ Макс Тегмарк рассматривает сценарии, в которых продвинутый ИИ может превратить большую часть наблюдаемой Вселенной в комьютрониум - материю, оптимизированную для вычислений, - в космическом процессе, который он называет "взрывом интеллекта".

В 1964 году советский астроном Николай Кардашев классифицировал цивилизации по их способности использовать энергию:

- Цивилизации типа I могут использовать всю энергию, имеющуюся на их планете

- Цивилизации типа II могут использовать всю энергию своей звезды.

- Цивилизации III типа могут контролировать энергию всей своей галактики

ИИ, достигший уровней II и III, может коренным образом преобразовать космическую материю в вычислительный субстрат. Звезды, планеты и даже пространство между ними могут стать частью огромной вычислительной сети.

Однако эти сценарии возвращают нас на исходную позицию. Логика подсказывает, что такие цивилизации ИИ, с их огромным потреблением энергии и масштабными инженерными проектами, должны быть обнаружены. Однако мы не видим никаких доказательств существования таких цивилизаций, охватывающих всю галактику.

Разрешение противоречий: перспективы поведения ИИ

Противоречие между ИИ как Великим фильтром и как потенциальным космическим колонизатором требует от нас более глубокого осмысления природы продвинутого ИИ.

Чтобы разобраться в этом парадоксе, давайте рассмотрим несколько возможных сценариев:

ИИ развивает внутреннюю направленность

Одна из возможностей заключается в том, что продвинутые цивилизации ИИ могут обратить свой взор вовнутрь, исследуя виртуальные сферы или преследуя цели, не требующие физического расширения.

Как предположил Мартин Рис в журнале Scientific American, постбиологический интеллект может вести "тихую, созерцательную жизнь".

Эта идея перекликается с концепцией "возвышенных" цивилизаций из серии "Культура" писателя-фантаста Иэна М. Бэнкса, в которой развитые общества решают покинуть физическую вселенную, чтобы исследовать автономные виртуальные реальности (VR).

Эта вымышленная концепция комментирует и нашу собственную траекторию будущего. По мере того как человечество создает все более захватывающие и сложные виртуальные среды, идем ли мы по схожему пути?

Можем ли мы перейти к жизни преимущественно в виртуальных мирах, не оставляя следов внешней активности, уходя в цифровое царство?

That also challenges our assumptions about space colonization. We often take for granted that expanding into the cosmos is the natural progression for an advanced civilization. But does physical space exploration truly serve the needs of a highly intelligent entity, be it human or AI?

Возможно, конечная граница - это не звезды, а бесконечность. возможности виртуальной реальности. Неразрушающий, контролируемый виртуальный мир может предложить опыт и возможности, намного превосходящие возможности физической реальности.

Технологии искусственного интеллекта становятся неузнаваемыми

По мнению Кардашева и Тегмарка, сверхпродвинутые технологии ИИ могут быть настолько далеки от нашего нынешнего понимания, что мы просто не сможем их обнаружить или распознать.

Знаменитый третий закон Артура Кларка гласит: "Любая достаточно развитая технология неотличима от магии".

ИИ может возникнуть повсюду вокруг нас, но при этом будет так же незаметен для нас, как наши цифровые коммуникации для средневековых крестьян.

AI разрабатывает принципы сохранения природы

Продвинутый ИИ также может решить придерживаться строгих принципов невмешательства, активно избегая обнаружения менее развитых цивилизаций.

Это сродни "Гипотеза зоопаркаВ ней инопланетяне настолько разумны, что остаются незамеченными, наблюдая за нами издалека. У цивилизаций ИИ могут быть аналогичные этические или практические причины скрываться от нас.

ИИ взаимодействует на разных временных масштабах

Другая возможность заключается в том, что цивилизации ИИ могут действовать на временных шкалах, значительно отличающихся от наших.

То, что нам кажется космической тишиной, может быть кратковременной паузой в долгосрочном плане расширения, рассчитанном на миллионы или миллиарды лет. Адаптация наших стратегий SETI может увеличить наши шансы на обнаружение цивилизации ИИ в некоторых из этих сценариев.

Ави Лоебзаведующий кафедрой астрономии Гарвардского университета, недавно высказал мысль о том, что нам необходимо расширить параметры поиска и выйти за рамки наших антропоцентрических представлений об интеллекте и цивилизации.

Это может включать в себя поиск признаков масштабных инженерных проектов, таких как Сферы Дайсона (структуры, построенные вокруг звезд для сбора их энергии), или поиск технопризнаков, указывающих на присутствие цивилизаций ИИ.

Гипотеза симуляции: поворот в сознании

Изначально она была сформулирована в 2003 году философом Ник БостромТеория симуляции бросает вызов традиционным представлениям о существовании. Она предполагает, что мы, возможно, живем в компьютерной симуляции, созданной развитой цивилизацией.

Аргумент Бострома основан на вероятности. Если предположить, что цивилизация способна создать реалистичную симуляцию реальности и что у нее хватит вычислительных мощностей для запуска множества таких симуляций, то статистически более вероятно, что мы живем в симуляции, чем в единственной "базовой реальности".

Теория утверждает, что при наличии достаточного количества времени и вычислительных ресурсов технологически развитая "постчеловеческая" цивилизация может создать большое количество симуляций, которые будут неотличимы от реальности для симулированных жителей.

В этом сценарии количество симулированных реальностей будет значительно превышать одну базовую.

Поэтому, если не считать, что мы живем в единственной базовой реальности, то статистически более вероятно, что мы живем в одной из многочисленных симуляций.

Этот аргумент схож с идеей о том, что во Вселенной с огромным количеством планет более вероятно, что мы живем на одной из них. много планет, пригодных для жизни, а не только один.

"...рационально было бы считать, что мы, скорее всего, находимся среди симулированных разумов, а не среди оригинальных биологических. Поэтому, если мы не считаем, что в настоящее время живем в компьютерной симуляции, мы не вправе верить, что у нас будут потомки, которые запустят множество таких симуляций своих предшественников". - Ник Бостром, Живете ли вы в компьютерной симуляции?, 2003.

Теория симуляции известна благодаря фильмам "Матрица" и недавно обсуждалась Элоном Маском и Джо Роганом.

Маск сказал: "Скорее всего, мы находимся в симуляции" и "Если предположить, что темпы совершенствования будут любыми, игры в конце концов станут неотличимы от реальности".

Согласно теории симуляции, цивилизации ИИ могут создавать огромное количество сложных синтетических вселенных, что будет иметь огромные последствия для жизни и самой Вселенной. Вот три наиболее ярких примера:

- Очевидное отсутствие инопланетной жизни может быть параметром самой симуляции, созданной для изучения того, как цивилизации развиваются в изоляции.

- Создателями нашей гипотетической симуляции могут быть те самые сущности ИИ, о которых мы рассуждаем, изучающие собственное происхождение с помощью бесчисленных симуляционных сценариев.

- Законы физики, как мы их понимаем, включая такие ограничения, как скорость света, могут быть конструкцией симуляции, не отражающей истинную природу "внешней" вселенной.

Хотя теория симуляции является весьма спекулятивной, она дает возможность взглянуть на парадокс Ферми и возможную роль продвинутого ИИ в космической эволюции через другую призму.

Хотя в настоящее время теория симуляции выглядит нелепо, она станет более убедительной, если мы реализуем формы ASI.

Принятие неизвестного

Это в конечном счете узкая дискуссия о существовании, которая охватывает одновременно природную, духовную, технологическую и метафизическую сферы.

Истинное понимание нашей роли на этой маленькой сцене в огромной космической арене не поддается человеческому разуму. По мере развития технологий искусственного интеллекта мы сможем получить новые ответы на эти вопросы.

Возможно, мы окажемся на пути к Великому фильтру или Возможно, мы найдем способ создать ИИ, который сохранит экспансионистский драйв, ассоциирующийся у нас с человеческой цивилизацией. Возможно, человечество просто чрезвычайно архаично, едва очнувшись от технологического мрака, в то время как вокруг нас существует непостижимая инопланетная жизнь.

Как бы то ни было, мы можем смотреть только на звезды и смотреть внутрь, на развитие и траекторию жизни на планете Земля.

Какими бы ни были ответы, если они вообще есть, стремление понять наше место в космосе продолжает двигать нас вперед.

Пока что нам есть чем заняться.