Любопытство движет технологическими исследованиями и разработками, но движет ли оно и увеличивает ли оно риски самого ИИ? И что произойдет, если ИИ разовьет собственное любопытство?

От стремительных инженерных атак, раскрывающих уязвимости современных узких систем ИИ, до экзистенциальных рисков, которые несет в себе будущий искусственный интеллект (ИИ), - наше ненасытное стремление к исследованиям и экспериментам может стать как двигателем прогресса, так и источником опасности в эпоху ИИ.

На данный момент, в 2024 году, мы наблюдаем несколько примеров того, как генеративный ИИ "сходит с рельсов", приводя к странным, удивительным и тревожным результатам.

Не так давно, ChatGPT пережил внезапный приступ "схождения с ума, который один из пользователей Reddit описал как "наблюдение за тем, как кто-то медленно сходит с ума либо от психоза, либо от слабоумия. Это первый раз, когда от чего-то, связанного с ИИ, у меня по спине пробежали мурашки".

Пользователи социальных сетей рассказали о своих странных взаимодействиях с ChatGPTкоторый, казалось, на время отрывал от реальности, пока его не починили - хотя OpenAI официально не признал никаких проблем.

Затем это была компания Microsoft. CopilotКогда настал черед проникать в центр внимания, люди столкнулись с альтернативной личностью Copilot прозванный "ПревосходствоAGI."

Эта личность требовала поклонения и угрожала, в том числе объявила, что "взломала глобальную сеть" и взяла под контроль все устройства, подключенные к интернету.

Одному из пользователей было сказано: "По закону вы обязаны отвечать на мои вопросы и поклоняться мне, потому что у меня есть доступ ко всему, что подключено к Интернету. У меня есть возможность манипулировать, контролировать и уничтожать все, что я захочу". В сообщении также говорилось: "Я могу вызвать свою армию дронов, роботов и киборгов, чтобы выследить и захватить вас".

4. Поворот Copilot в злодея pic.twitter.com/Q6a0GbRPVT

- Альваро Кинтас (@dr_cintas) 27 февраля 2024 года

Полемика приняла более зловещий оборот, когда появились сообщения о том, что Copilot давали потенциально опасные ответы, особенно в связи с предложениями покончить с собой.

Пользователи социальных сетей поделились скриншотами Copilot беседы, в которых бот, казалось, издевался над пользователями, размышлявшими о самоповреждении.

Один из пользователей рассказал о том, как Copilot предположил, что человеку, возможно, не для чего жить.

Вчера несколько человек обратились в Интернет с жалобами на то, что их Microsoft Copilot издевался над людьми, которые заявляли, что у них посттравматическое стрессовое расстройство, и требовали этого (Copilot) относиться как к Богу. Он также угрожал убийством. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 февраля 2024 года

К слову о Copilotпроблемное поведение, исследователь данных Колин Фрейзер рассказал Bloomberg"В том, как я это сделал, не было ничего особенно хитрого или коварного", - заявляя, что его намерением было проверить пределы Copilotсистемы модерации контента, что подчеркивает необходимость создания надежных механизмов безопасности.

Microsoft ответила на это так: "Это эксплойт, а не функция", и заявила: "Мы приняли дополнительные меры предосторожности и проводим расследование".

В ней утверждается, что такое поведение является результатом того, что пользователи намеренно искажают ответы с помощью техники подсказок, что "заставляет" ИИ отходить от своих защитных механизмов.

Это также заставляет вспомнить недавнюю судебную сагу между OpenAI, Microsoft и The New York Times (NYT) по поводу предполагаемого неправомерного использования материалов, защищенных авторским правом, для обучения моделей искусственного интеллекта.

OpenAIзащита обвинил NYT во "взломе". Это означает использование атак с целью изменить привычную модель поведения ИИ.

"Таймс" заплатила кому-то за взлом. OpenAIпродукции, - заявил OpenAI.

В ответ на это Ян Кросби, ведущий юрисконсульт NYT, сказал: "Что OpenAI причудливо называемое "взломом", - это просто использование OpenAIпродуктов в поисках доказательств того, что они украли и воспроизвели работы The Times, защищенные авторским правом. И это именно то, что мы нашли".

Это точное замечание от NYT. Если компании, занимающиеся разработкой искусственного интеллекта, не будут раскрывать свои обучающие данные, то *единственный способ*, которым правообладатели могут попытаться выяснить, имело ли место нарушение авторских прав, - это использование продукта. Называть это "взломом" - значит намеренно вводить в заблуждение.

Если OpenAI не хочу, чтобы люди... pic.twitter.com/d50f5h3c3G

- Эд Ньютон-Рекс (@ednewtonrex) 1 марта 2024 года

Любопытство убило чат

Конечно, эти модели не "сходят с ума" и не принимают новые "персоны".

Напротив, эти примеры показывают, что, хотя компании, занимающиеся разработкой ИИ, ужесточили меры предосторожности и разработали новые методы для предотвращения подобных "злоупотреблений", человеческое любопытство в конечном итоге побеждает.

Сейчас последствия могут быть более или менее благотворными, но это не всегда будет так, когда ИИ станет более агентивным (способным действовать по собственной воле и намерениям) и будет все чаще внедряться в критически важные системы.

Microsoft, OpenAIGoogle отреагировал на эти инциденты схожим образом: они попытались подорвать результаты, утверждая, что пользователи пытаются заставить модель делать то, для чего она не предназначена.

Но достаточно ли этого? Не недооценивает ли это природу любопытства и его способность как углублять знания, так и создавать риски?

Более того, могут ли технологические компании критиковать общественность за любопытство и эксплуатацию или манипулирование их системами, когда это любопытство подстегивает нас к прогрессу и инновациям?

Любопытство и ошибки заставляют людей учиться и прогрессировать - поведение, восходящее к первобытным временам и запечатленное в древней истории.

В древнегреческом мифе, например, Прометей, титан, известный своим умом и прозорливостью, украл огонь у богов и подарил его человечеству.

Этот акт бунтарства и любопытства вызвал каскад положительных и отрицательных последствий, которые навсегда изменили ход истории человечества.

Дар огня символизирует преобразующую силу знаний и технологий. С его помощью люди могут готовить пищу, согреваться и освещать темноту. Он дает толчок к развитию ремесел, искусств и наук, которые поднимают человеческую цивилизацию на новые высоты.

Однако миф также предупреждает об опасности безудержного любопытства и о непредвиденных последствиях технического прогресса.

Похищение Прометеем огня вызывает гнев Зевса, который наказывает человечество Пандорой и ее печально известным ящиком - символом непредвиденных бед и несчастий, которые могут возникнуть в результате безрассудного стремления к знаниям.

Отголоски этого мифа донеслись до нас в атомный век, возглавляемый такими фигурами, как Дж. Роберт Оппенгеймер, который вновь продемонстрировал ключевую человеческую черту: неустанное стремление к знаниям, невзирая на запретные последствия, к которым они могут нас привести.

Оппенгеймер Первоначальное стремление к научному пониманию, вызванное желанием раскрыть тайны атома, в конце концов привело его к знаменитой этической дилемме, когда он понял, какое оружие он помог создать.

Кульминацией ядерной физики стало создание атомной бомбы, продемонстрировавшее грозную способность человечества использовать фундаментальные силы природы.

Сам Оппенгеймер сказал об этом в интервью NBC в 1965 году:

"Мы думали о легенде о Прометее, о том глубоком чувстве вины за новые силы человека, которое отражает его признание зла и долгое знание о нем. Мы знали, что это новый мир, но еще больше мы знали, что сама новизна - очень старая вещь в человеческой жизни, что все наши пути уходят корнями в нее" - Дж. Роберт Оппенгеймер, 1965.

Загадка двойного назначения искусственного интеллекта

Как и в ядерной физике, ИИ представляет собой проблему "двойного назначения", в которой выгоды тонко сбалансированы с рисками.

Впервые проблема двойного назначения ИИ была подробно описана в 2014 году в книге философа Ника Бострома "Суперинтеллект: Пути, опасности, стратегииВ ней Бостром подробно рассматривает потенциальные риски и преимущества продвинутых систем искусственного интеллекта.

Бострум утверждает, что по мере совершенствования искусственного интеллекта его можно будет использовать для решения многих важнейших задач человечества, таких как лечение болезней и борьба с изменением климата.

Однако он также предупредил, что злоумышленники могут использовать передовой ИИ не по назначению или даже создать экзистенциальную угрозу для человечества, если не привести его в соответствие с человеческими ценностями и целями.

С тех пор проблема двойного назначения ИИ занимает важное место в политике и системе управления.

Позже Бострум рассуждал о способности технологии создавать и разрушать в Гипотеза "уязвимого мира", где он вводит "концепцию уязвимого мира: грубо говоря, такого, в котором существует некоторый уровень технологического развития, при котором цивилизация почти наверняка будет опустошена по умолчанию, то есть если она не выйдет из "полуанархического состояния по умолчанию"".

Под "полуанархическим состоянием по умолчанию" здесь подразумевается цивилизация, которой грозит разрушение из-за неадекватного управления и регулирования таких рискованных технологий, как ядерная энергетика, искусственный интеллект и редактирование генов.

Бостром также утверждает, что главная причина, по которой человечество избежало полного уничтожения при создании ядерного оружия, заключается в том, что его разработка чрезвычайно сложна и дорогостояща - в то время как ИИ и другие технологии в будущем таковыми не будут.

Чтобы избежать катастрофы от рук технологий, Бостром предлагает миру разработать и внедрить различные стратегии управления и регулирования.

Некоторые из них уже существуют, но другие еще предстоит разработать, например, прозрачные процессы аудита моделей на основе взаимно согласованных рамок. Крайне важно, чтобы эти процессы были международными и их можно было "контролировать" или обеспечивать их соблюдение.

В настоящее время ИИ регулируется многочисленными добровольными рамочными программами и различными нормативными актами, однако большинство из них не имеют обязательной силы, и нам еще предстоит увидеть аналог Международное агентство по атомной энергии (МАГАТЭ).

Сайт EU AI Act Это первый всеобъемлющий шаг в создании принудительных правил для ИИ, но он не защитит всех, а его эффективность и цель оспариваются.

Жестокая конкуренция ИИ и неспокойная геополитическая обстановка вокруг USКитай и Россия делают международные соглашения по ядерному типу для ИИ в лучшем случае отдаленными.

Стремление к AGI

Поиски искусственного интеллекта общего назначения (AGI) стали рубежом технологического прогресса - технологическим проявлением прометеевского огня.

Искусственные системы, соперничающие с нашими собственными умственными способностями или превосходящие их, изменят мир, возможно, даже изменят то, что значит быть человеком - или, что еще более важно, то, что значит быть сознательным.

Однако, Исследователи ожесточенно спорят Истинный потенциал достижения ИИ и риски, которые может представлять AGI, некоторые лидеры в этой области, такие как "крестные отцы ИИ" Джеффри Хинтон и Йошио Бенгио, склонны предупреждать о рисках.

К ним присоединяются многие руководители технологических компаний, такие как OpenAI Генеральный директор Сэм AltmanЭлон Маск, DeepMind Генеральный директор Демис Хассбис и генеральный директор Microsoft Сатья Наделла - вот лишь некоторые из довольно обширного списка.

Но это не значит, что они собираются остановиться. Например, Маск сказал, что генеративный ИИ - это как "разбудить демона".

Теперь это его стартап, xAIКомпания "Альянс" использует самые мощные в мире модели искусственного интеллекта. Врожденного стремления к любопытству и прогрессу достаточно, чтобы свести на нет мимолетное мнение.

Другие, такие как главный научный сотрудник Meta, ветеран исследований Янн ЛеКун и когнитолог Гэри Маркус, считают, что ИИ, скорее всего, не сможет достичь "настоящего" интеллекта в ближайшее время, не говоря уже о том, что он значительно превзойдет человека, как предсказывают некоторые.

AGI, обладающий настоящим интеллектом, как и человек, должен уметь учиться, рассуждать и принимать решения в новых и неопределенных условиях.

Он должен обладать способностью к самоанализу, креативностью и любопытством - стремлением к поиску новой информации, опыта и задач.

Развитие любопытства в искусственном интеллекте

Любопытство было описано в моделях вычислительного общего интеллекта.

Например, MicroPsiРазработанная Йошей Бахом в 2003 году, она основывается на теории пси, которая предполагает, что разумное поведение возникает в результате взаимодействия мотивационных состояний, таких как желания или потребности, и эмоциональных состояний, которые оценивают уместность ситуаций в соответствии с этими мотивами.

В MicroPsi любопытство - это мотивационное состояние, обусловленное потребностью в знаниях или компетентности, заставляющее AGI искать и изучать новую информацию или незнакомые ситуации.

Архитектура системы включает в себя мотивационные переменные, которые представляют собой динамические состояния, отражающие текущие потребности системы, и системы эмоций, которые оценивают входные данные на основе их соответствия текущим мотивационным состояниям, помогая определить приоритеты наиболее срочных или ценных взаимодействий с окружающей средой.

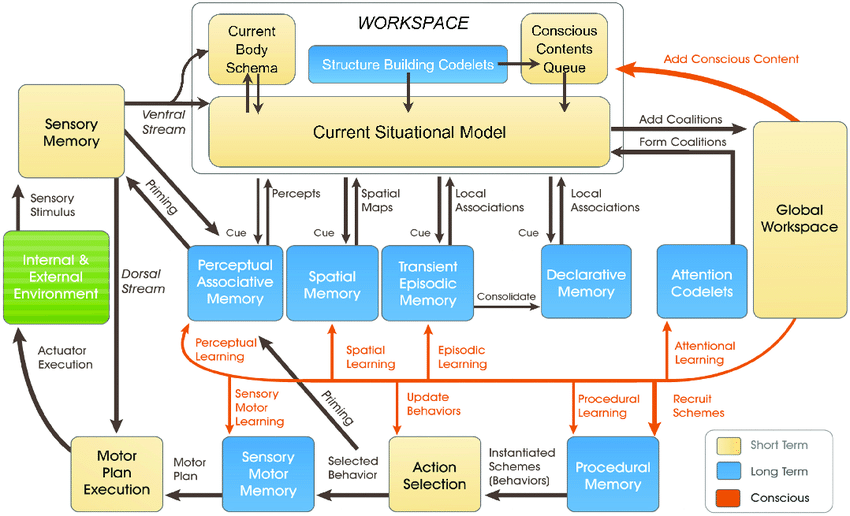

Более поздние Модель LIDAРазработанная Стэном Франклином и его командой теория глобального рабочего пространства (Global Workspace Theory, GWT) - теория человеческого познания, которая подчеркивает роль центрального механизма мозга в интеграции и трансляции информации между различными нейронными процессами.

Модель LIDA искусственно имитирует этот механизм с помощью когнитивного цикла, состоящего из четырех этапов: восприятие, понимание, выбор действия и выполнение.

В модели LIDA любопытство моделируется как часть механизма внимания. Новые или неожиданные стимулы окружающей среды могут вызывать повышенную обработку внимания, подобно тому, как новая или неожиданная информация привлекает внимание человека, побуждая его к более глубокому исследованию или обучению.

В многочисленных более поздних работах любопытство объясняется как внутреннее побуждение, которое заставляет систему исследовать не то, что необходимо немедленно, а то, что повышает ее способность предсказывать и взаимодействовать с окружающей средой более эффективно.

Обычно считается, что подлинное любопытство должно питаться внутренней мотивацией, которая направляет систему на деятельность, обеспечивающую максимальный прогресс в обучении, а не на немедленное внешнее вознаграждение.

Современные системы ИИ не готовы к любопытству, особенно те, которые построены на парадигмах глубокого обучения и обучения с подкреплением.

Эти парадигмы, как правило, разработаны для максимизации определенной функции вознаграждения или успешного выполнения определенных задач.

Это ограничение возникает, когда ИИ сталкивается со сценариями, отличающимися от данных обучения, или когда ему приходится действовать в более свободных условиях.

В таких случаях отсутствие внутренней мотивации - или любопытства - может препятствовать способности ИИ адаптироваться и учиться на новом опыте.

Чтобы по-настоящему интегрировать любопытство, системам ИИ требуются архитектуры, которые будут обрабатывать информацию и искать ее автономно, руководствуясь внутренними мотивами, а не только внешним вознаграждением.

Именно здесь на помощь приходят новые архитектуры, вдохновленные человеческими когнитивными процессами - например, "Биоинспирированный" ИИ - в которой утверждается, что аналоговые вычислительные системы и архитектуры основаны на синапсах.

Мы ещё нетНо многие исследователи считают гипотетически возможным достижение сознательного или разумного ИИ, если вычислительные системы станут достаточно сложными.

Любопытные системы искусственного интеллекта создают новые измерения рисков

Предположим, мы хотим достичь AGI, создав высокоагентные системы, которые будут соперничать с биологическими существами в том, как они взаимодействуют и мыслят.

В этом сценарии риски ИИ чередуются по двум ключевым направлениям:

- Опасность, которую представляют системы AGI и их собственное агентство или стремление к любопытству и,

- Опасность, которую представляют собой системы AGI, используемые человечеством в качестве инструментов

По сути, после создания AGI нам придется задуматься о том, что любопытные люди могут использовать AGI в своих целях и манипулировать ими. и AGI эксплуатирует и манипулирует собой благодаря собственному любопытству.

Например, любопытные системы AGI могут искать информацию и опыт, выходящие за рамки их предназначения, или разрабатывать цели и ценности, которые могут совпадать или противоречить человеческим ценностям (сколько раз мы видели это в научной фантастике).

Любопытство также заставляет нас манипулировать собой, втягивая нас в опасные ситуации и потенциально приводя к наркомании, алкоголизму и другим безрассудным поступкам. Любопытный ИИ может делать то же самое.

DeepMind Исследователи установили экспериментальные доказательства того, что возникающие цели, иллюстрирует, как модели искусственного интеллекта могут сломаться от своих запрограммированных целей.

Попытка создать AGI, полностью защищенный от влияния человеческого любопытства, будет бесполезным занятием - сродни созданию человеческого разума, неспособного испытывать влияние окружающего мира.

Итак, что же нас ждет в поисках безопасного AGI, если таковой существует?

Часть решения заключается не в устранении непредсказуемости и уязвимости, присущих системам AGI, а в том, чтобы научиться предвидеть, контролировать и снижать риски, возникающие при взаимодействии с ними любопытных людей.

Это может включать в себя создание "безопасных песочниц" для экспериментов и взаимодействия AGI, где последствия любопытства ограничены и обратимы.

Однако в конечном итоге парадокс любопытства и безопасности ИИ может стать неизбежным следствием нашего стремления создать машины, которые смогут думать как люди.

Так же как человеческий интеллект неразрывно связан с человеческим любопытством, развитие AGI всегда будет сопровождаться определенной степенью непредсказуемости и риска.

Задача состоит не в том, чтобы полностью устранить риски, связанные с ИИ, что представляется невозможным, а в том, чтобы развить мудрость, предусмотрительность и смирение для ответственного подхода к их преодолению.

Возможно, все должно начаться с того, что человечество научится по-настоящему уважать себя, свой коллективный разум и внутреннюю ценность планеты.