Da Google kunngjorde lanseringen av Gemini-modellene sine, var det stor begeistring da selskapet sa at disse var på nivå med tilbudene fra OpenAI. Det er kanskje ikke helt sant.

Google sa at dets Gemini Ultra modellen er bedre enn GPT-4. Modellen er ennå ikke lansert, så vi må ta referansetestresultatene deres for god fisk. Gemini Pro har blitt lansert, og Google sier at den er på nivå med GPT-3.5.

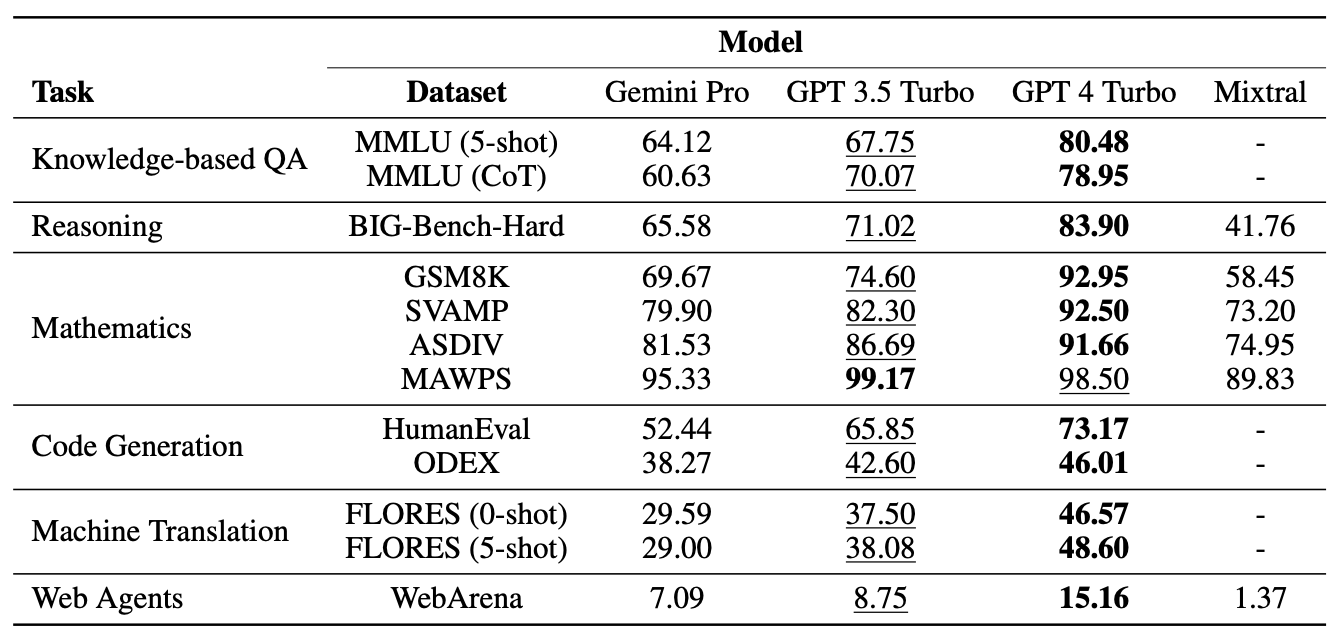

Forskere fra Carnegie Mellon University og AI-programvareplattformen BerriAI satte Gemini Pro gjennom en rekke oppgaver for å teste språkforståelsen og genereringsevnen.

De kjørte de samme testene med GPT-3.5 Turbo, GPT-4 Turbo og Mistral AIs nye Mixtral 8x7B-modell.

Googles Gemini ble nylig lansert som en stor konkurrent til OpenAIs GPT. Spennende! Men vi lurte på noe:

Hvor god er Gemini egentlig?

Ved CMU utførte vi en upartisk, grundig og reproduserbar studie der vi sammenlignet Gemini, GPT og Mixtral.

Papir: https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19. desember 2023

Resultater

GPT-4 gikk ikke overraskende til topps, men Google er nok mindre spent på å se hvordan Gemini Pro klarte seg mot GPT 3.5 Turbo. I en oppsummering av teamets resultater, papiret "Geminis Pro-modell oppnådde en sammenlignbar, men litt dårligere nøyaktighet sammenlignet med den nåværende versjonen av OpenAIs GPT 3.5 Turbo."

Her er et sammendrag av resultatene.

Modellene ble bedt om å bruke BerriAIs LiteLLM-grensesnitt, og hver modell fikk nøyaktig de samme instruksjonene og den samme evalueringsprotokollen.

Modellene ble testet på flervalgsspørsmål, generelle resonnementer, matematiske resonnementer, generering av kode, språkoversettelse og bruk som nettagent.

En av grunnene til at Gemini Pro scoret dårlig på flervalgsspørsmålene, var at den hadde en sterk skjevhet i forhold til posisjon. Den valgte ofte svaret i posisjon D, uansett om det var riktig eller ikke. Interessant nok er dette noe som Microsofts Medprompt løser med stuing.

Til tross for at Gemini Pro tapte noen av testene, slo den GPT-3.5 Turbo på to områder, nemlig ordsortering og symbolmanipulering og -oversettelse.

I alle oversettelsesoppgavene som Gemini Pro fullførte, utkonkurrerte den alle de andre modellene, inkludert GPT-4. Gemini Pros endelige poengsum på oversettelsestestene var imidlertid lavere enn GPT-3.5, fordi den nektet å fullføre noen forespørsler da den overivrige innholdsmodereringen satte inn.

Hva så?

Google bestrider tallene forskerne kom frem til, og insisterer på at deres tall viser at Gemini Pro er på nivå med eller bedre enn GPT-3.5. Hvis vi tar høyde for de utallige variablene og gir Google litt spillerom, kan vi dele forskjellen og si at Gemini Pro og GPT-3.5 er omtrent like gode.

Det viktigste her er at Gemini Pro, en helt ny modell som Google brukte måneder på å utvikle, ikke slår en modell som har vært ute i mer enn et år og er gratis å bruke via ChatGPT.

Gemini Ultra forventes å bli lansert tidlig i 2024. Vil den leve opp til påstanden om at den er bedre enn GPT-4? La oss håpe at professor Graham Neubig og teamet hans snart får kjøre lignende referansetester.