Forskere har introdusert FANToM, en ny benchmark som er utviklet for å teste og evaluere store språkmodellers (LLM) forståelse og anvendelse av Theory of Mind (ToM).

Theory of Mind refererer til evnen til å tillegge seg selv og andre oppfatninger, ønsker og kunnskap, og til å forstå at andre har andre oppfatninger og perspektiver enn en selv.

ToM anses som grunnleggende for den bevisstheten som intelligente dyr besitter. I tillegg til mennesker anses primater som orangutanger, gorillaer og sjimpanser å ha ToM, i tillegg til enkelte ikke-primater som papegøyer og medlemmer av kragefuglfamilien.

Etter hvert som AI-modellene blir mer komplekse, søker AI-forskere etter nye metoder for å evaluere evner som ToM.

En ny målestokk kalt FANToMsom er utviklet av forskere fra Allen Institute for AI, University of Washington, Carnegie Mellon University og Seoul National University, utsetter maskinlæringsmodeller for dynamiske scenarier som gjenspeiler interaksjoner i det virkelige liv.

Med FANToM går karakterer inn og ut av samtaler, noe som utfordrer AI-modellene til å opprettholde en nøyaktig forståelse av hvem som vet hva til enhver tid.

Ved å utsette store språkmodeller (LLM-er) for FANToM viste det seg at selv de mest avanserte modellene sliter med å opprettholde en konsistent ToM.

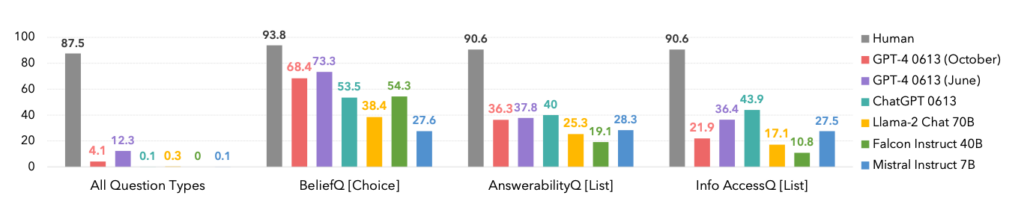

Modellenes prestasjoner var betydelig lavere enn de menneskelige deltakernes, noe som understreker AIs begrensninger når det gjelder å forstå og navigere i komplekse sosiale interaksjoner.

Faktisk dominerte menneskene alle kategorier, som vist nedenfor.

Et interessant sidepoeng er at oktoberversjonen av GPT-4-modellen ble utkonkurrert av en tidligere juni-versjon, noe som kan underbygge nylige anekdoter blant brukerne om at ChatGPT blir stadig verre.

FANToM avslørte også teknikker for å forbedre LLM ToM, for eksempel tankekjederesonnement og andre finjusteringsmetoder.

Men gapet mellom AI og menneskelige ToM-ferdigheter er fortsatt stort.

AI tar store sprang mot menneskelignende språkferdigheter

I en noe relatert, men separat studie publisert i Natureutviklet forskere et nevralt nettverk som er i stand til å generalisere språk på samme måte som mennesker.

Dette nye nevrale nettverket viste en imponerende evne til å integrere nyinnlærte ord i sitt eksisterende vokabular. Deretter kunne det bruke disse ordene i ulike sammenhenger, en kognitiv ferdighet som kalles systematisk generalisering.

Mennesker har en naturlig evne til systematisk generalisering, slik at de sømløst innlemmer nye ord i repertoaret sitt.

Når noen for eksempel har lært seg begrepet "photobomb", kan de bruke det i ulike situasjoner nesten umiddelbart. Det dukker hele tiden opp nye slanguttrykk, og mennesker tar dem naturlig inn i ordforrådet sitt.

Forskerne utsatte både sitt eget tilpassede nevrale nettverk og ChatGPT for en rekke tester, og fant ut at ChatGPT lå etter den tilpassede modellen i ytelse.

Mens LLM-er som ChatGPT utmerker seg i mange samtalescenarier, viser de merkbare inkonsekvenser og mangler i andre, et problem som dette nye nevrale nettverket tar tak i.

For å undersøke dette aspektet ved språklig kommunikasjon gjennomførte forskerne et eksperiment med 25 deltakere, der de vurderte deres evne til å bruke nyinnlærte ord i ulike sammenhenger. Forsøkspersonene ble introdusert for et pseudospråk bestående av nonsensord som representerte ulike handlinger og regler.

Etter en opplæringsfase utmerket deltakerne seg ved å anvende disse abstrakte reglene på nye situasjoner, noe som viste systematisk generalisering.

Da det nyutviklede nevrale nettverket ble eksponert for denne oppgaven, speilet det den menneskelige prestasjonen. Når ChatGPT ble utsatt for den samme utfordringen, slet den imidlertid betydelig, og mislyktes mellom 42 og 86% av tiden, avhengig av den spesifikke oppgaven.

Dette er viktig av to grunner. For det første kan man hevde at dette nye nevrale nettverket effektivt utkonkurrerte GPT-4 på denne spesifikke oppgaven - noe som er imponerende nok. For det andre viser denne studien nye metoder for å lære AI-modeller å generalisere nytt språk på samme måte som mennesker.

Elia Bruni, spesialist på naturlig språkprosessering ved universitetet i Osnabrück i Tyskland, beskriver det slik: "Det å tilføre systematikk til nevrale nettverk er en stor sak."

Til sammen tilbyr disse to studiene nye tilnærminger til opplæring av mer intelligente AI-modeller som kan konkurrere med mennesker på kritiske områder som lingvistikk og Theory of Mind.