De forente arabiske emiraters Technology Innovation Institute (TII) lanserte sin Falcon 180B LLM på Hugging Face i forrige uke, og den leverte imponerende ytelse i tidlig testing.

Modellen, som er åpent tilgjengelig for forskere og kommersielle brukere, er et produkt av en gryende AI-industri i Midtøsten.

Falcon 180B er 2,5 ganger større enn Metas Lama 2 og ble trent med fire ganger mer databehandling. TII trente modellen på hele 3,5 billioner tokens. Det er den unike datasetttilnærmingen som i stor grad er ansvarlig for modellens imponerende ytelse.

For å trene opp en modell trenger du ikke bare mye data, du trenger vanligvis mye kuratert data av god kvalitet. Det koster mye penger å produsere, og det finnes ikke mange virkelig store kuraterte datasett som er offentlig tilgjengelige. TII bestemte seg for å prøve en ny tilnærming for å unngå behovet for kuratering.

I juni brukte forskere nøye filtrering og deduplisering av offentlig tilgjengelige CommonCrawl-data for å lage RefinedWeb-datasettet. Dette datasettet var ikke bare enklere å produsere, men det gir også bedre ytelse enn bare å bruke kuraterte korpora eller nettdata.

Falcon 180B ble trent på hele 3,5 billioner tokens fra RefinedWeb-datasettet, betydelig mer enn de 2 billioner tokens fra Llama 2s pretraining-datasett.

Ytelsen til Falcon 180B

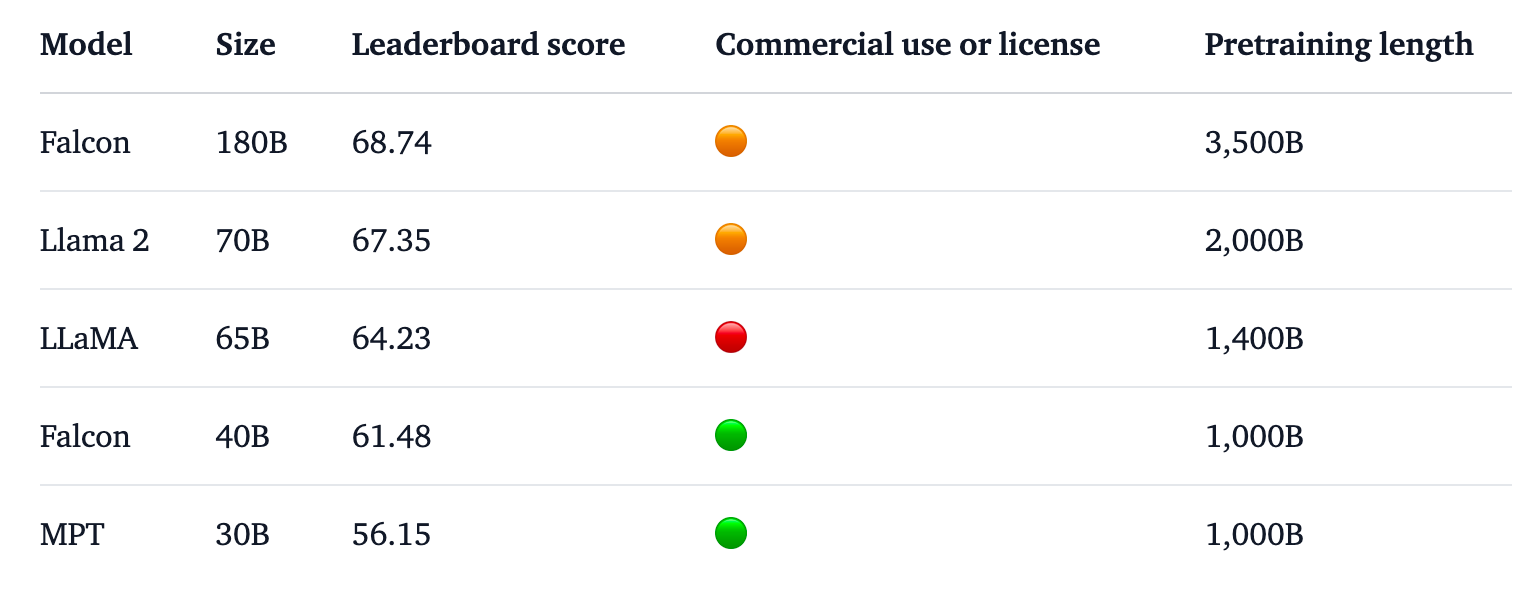

Falcon 180B topper Hugging Face-topplisten for LLM-er med åpen tilgang. Modellen utkonkurrerer Llama 2, den tidligere lederen, på en rekke benchmarks, inkludert resonnering, koding, ferdigheter og kunnskapstester.

Falcon 180B scorer til og med høyt sammenlignet med proprietære modeller med lukket kildekode. Den ligger rett bak GPT-4 og er på nivå med Googles PaLM 2 Large, som er dobbelt så stor som Falcon 180B.

Kilde: Klemmende ansikt

TII sier at til tross for den allerede imponerende ytelsen med den forhåndstrenede modellen, har de til hensikt "å tilby stadig mer kapable versjoner av Falcon i fremtiden, basert på forbedrede datasett og RLHF/RLAIF".

Du kan prøve en chat-versjon av modellen med denne Demo av Falcon 180B på Hugging Face.

Chat-versjonen er finjustert og renset, men grunnmodellen har ennå ikke fått på plass noen justeringsbarrierer. TII sa at siden den ennå ikke hadde vært gjennom en finjusterings- eller justeringsprosess, kunne den gi "problematiske" svar.

Det vil ta litt tid å få det justert til et punkt der det kan tas i bruk kommersielt på en trygg måte.

Den imponerende ytelsen til denne modellen viser likevel at det finnes andre forbedringsmuligheter enn bare å skalere dataressursene.

Falcon 180B viser at mindre modeller trent på datasett av god kvalitet kan være en mer kostnadseffektiv og effektiv retning for utviklingen av kunstig intelligens.

Lanseringen av denne imponerende modellen understreker den voldsomme veksten i Utviklingen av kunstig intelligens i Midtøstentil tross for den siste tidens eksportrestriksjoner for GPU-er til regionen.

Etter hvert som TII og Meta fortsetter å lansere sine kraftfulle modeller under åpne lisenser, blir det interessant å se hva Google og OpenAI gjør for å få flere til å ta i bruk sine lukkede modeller.

Prestasjonsgapet mellom åpen tilgang og proprietære modeller ser definitivt ut til å bli mindre.