Армия США пробует внедрить чат-ботов с искусственным интеллектом в стратегическое планирование, хотя и в рамках симулятора военной игры, основанного на популярной видеоигре Starcraft II.

Это исследованиеИсследовательская лаборатория армии США анализирует боевые стратегии OpenAI GPT-4 Turbo и GPT-4 Vision.

Это часть проекта OpenAI сотрудничество с Министерством обороны (МО) после создания Целевая группа по генеративному ИИ в прошлом году.

Использование искусственного интеллекта на поле боя горячо обсуждаемый, с Недавнее аналогичное исследование, посвященное военным играм с искусственным интеллектом обнаружил, что такие LLM, как GPT-3.5 и GPT-4, склонны к эскалации тактики дипломатии, иногда приводящей к ядерной войне.

В новом исследовании, проведенном армией США, Starcraft II использовался для моделирования сценария боя с участием ограниченного числа военных подразделений.

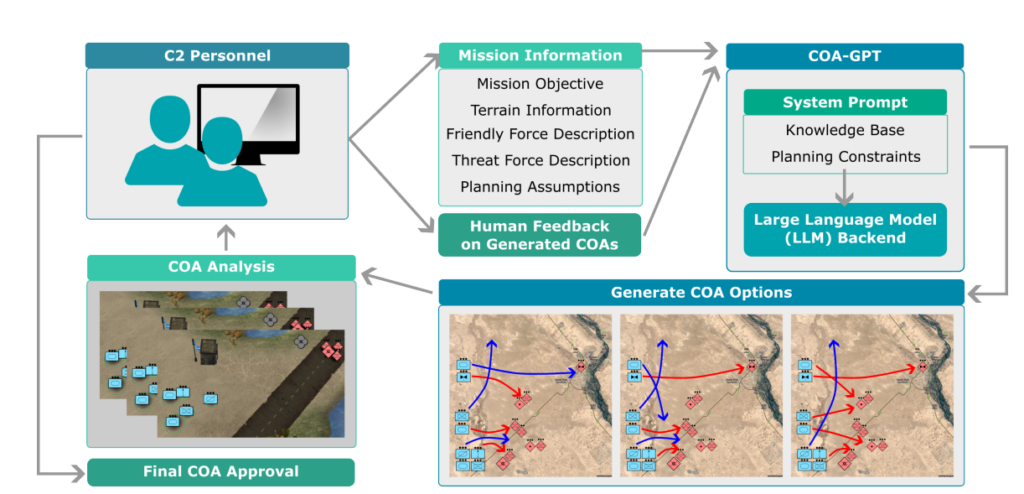

Исследователи окрестили эту систему "COA-GPT" - COA означает военный термин "Courses of Action", который, по сути, описывает военную тактику.

COA-GPT взял на себя роль помощника военного командира, которому поручено разрабатывать стратегии уничтожения вражеских сил и захвата стратегических пунктов.

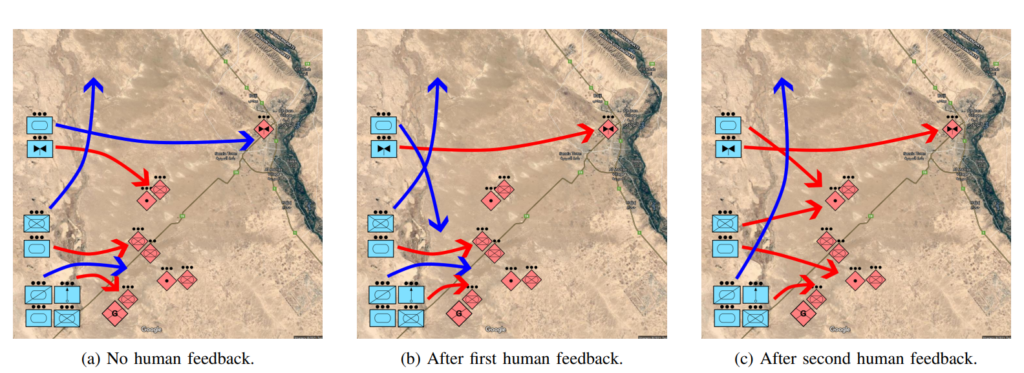

Исследователи отмечают, что традиционный COA, как известно, медленный и трудоемкий. COA-GPT принимает решения за считанные секунды, интегрируя обратную связь с человеком в процесс обучения ИИ.

COA-GPT превосходит другие методы, но за это приходится платить

COA-GPT продемонстрировал превосходство над существующими методами и превзошел их в генерации стратегических COA, и может адаптироваться к обратной связи в режиме реального времени.

Однако были и недостатки. В частности, COA-GPT понесла больше потерь при выполнении поставленных задач.

В исследовании говорится: "Мы наблюдаем, что COA-GPT и COA-GPT-V, даже если они дополнены обратной связью с человеком, демонстрируют более высокие потери дружественных сил по сравнению с другими базовыми вариантами".

Сдерживает ли это исследователей? Похоже, что нет.

В исследовании говорится: "В заключение следует отметить, что COA-GPT представляет собой трансформационный подход в военных операциях C2, способствующий более быстрому и оперативному принятию решений и сохранению стратегического преимущества в современной войне".

Вызывает беспокойство тот факт, что система искусственного интеллекта, которая привела к большему количеству ненужных жертв, чем базовый уровень, определяется как "преобразующий подход".

Министерство обороны уже наметила другие направления для изучения возможностей использования ИИ в военных целях, но опасения по поводу готовности технологии и этических последствий остаются.

Например, кто несет ответственность, когда военные Приложения искусственного интеллекта работают неправильно? Разработчики? Ответственный человек? Или кто-то еще ниже по цепочке?

Боевые системы с искусственным интеллектом уже применяются в конфликтах на Украине и в Палестине и Израиле, но эти вопросы остаются практически непроверенными.

Будем надеяться, что так оно и останется.