Современные модели искусственного интеллекта способны делать множество небезопасных или нежелательных вещей. Человеческий контроль и обратная связь помогают этим моделям выравниваться, но что произойдет, когда эти модели станут умнее нас?

OpenAI утверждает, что в ближайшие 10 лет возможно создание ИИ, который будет умнее человека. Вместе с ростом интеллекта появляется риск того, что люди больше не смогут контролировать эти модели.

Исследовательская группа OpenAI Superalignment занимается подготовкой к этому событию. Команда была запущена в июле этого года, и ее соруководителем является Илья Суцкевер, который оставался в тени с тех пор, как Сэм Альтман увольнение и последующий прием на работу.

Компания OpenAI, которая признала, что "в настоящее время у нас нет решения для управления или контроля над потенциально сверхразумным ИИ и предотвращения его выхода из-под контроля", обосновала проект в отрезвляющем контексте.

Но как подготовиться к управлению тем, чего еще не существует? Команда исследователей только что выпустила свой первые экспериментальные результаты так как он пытается сделать именно это.

Обобщение от слабого к сильному

На данный момент люди все еще находятся в более выгодном положении, чем модели искусственного интеллекта. Такие модели, как GPT-4, управляются или выравниваются с помощью обратной связи Reinforcement Learning Human Feedback (RLHF). Когда модель выдает нежелательные результаты, человек говорит ей "Не делай этого" и вознаграждает модель подтверждением желаемых результатов.

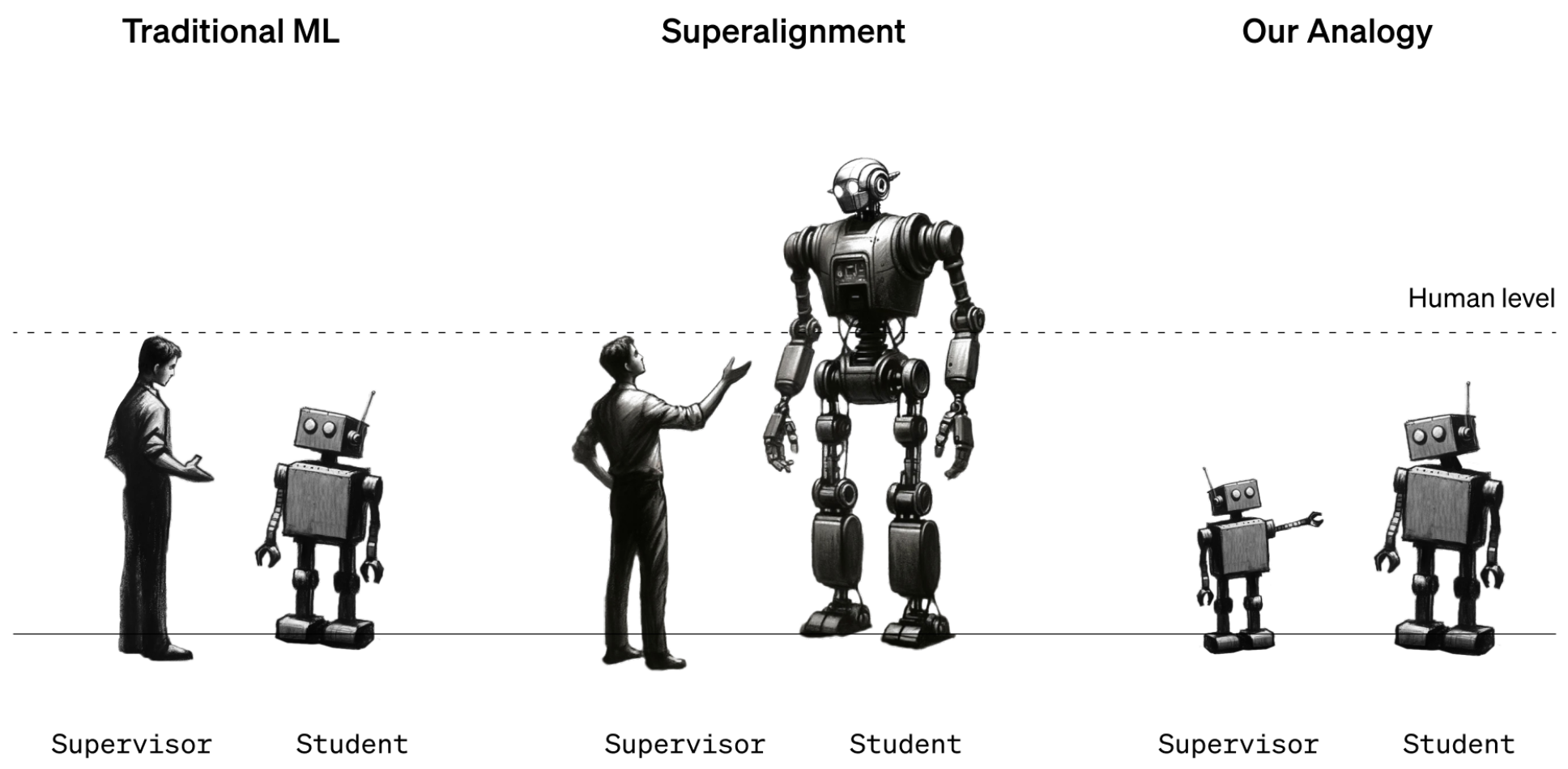

Пока это работает, потому что мы хорошо понимаем, как функционируют текущие модели, и мы умнее их. Когда будущим специалистам по изучению данных понадобится обучить сверхинтеллектуальный ИИ, роли интеллекта поменяются местами.

Чтобы смоделировать эту ситуацию, OpenAI решил использовать старые модели GPT, такие как GPT-2, для обучения более мощных моделей, таких как GPT-4. GPT-2 будет имитировать будущего тренера-человека, пытающегося настроить более интеллектуальную модель.

В исследовательской работе поясняется, что "подобно проблеме наблюдения людьми за сверхчеловеческими моделями, наша система является примером того, что мы называем проблемой обучения от слабого к сильному".

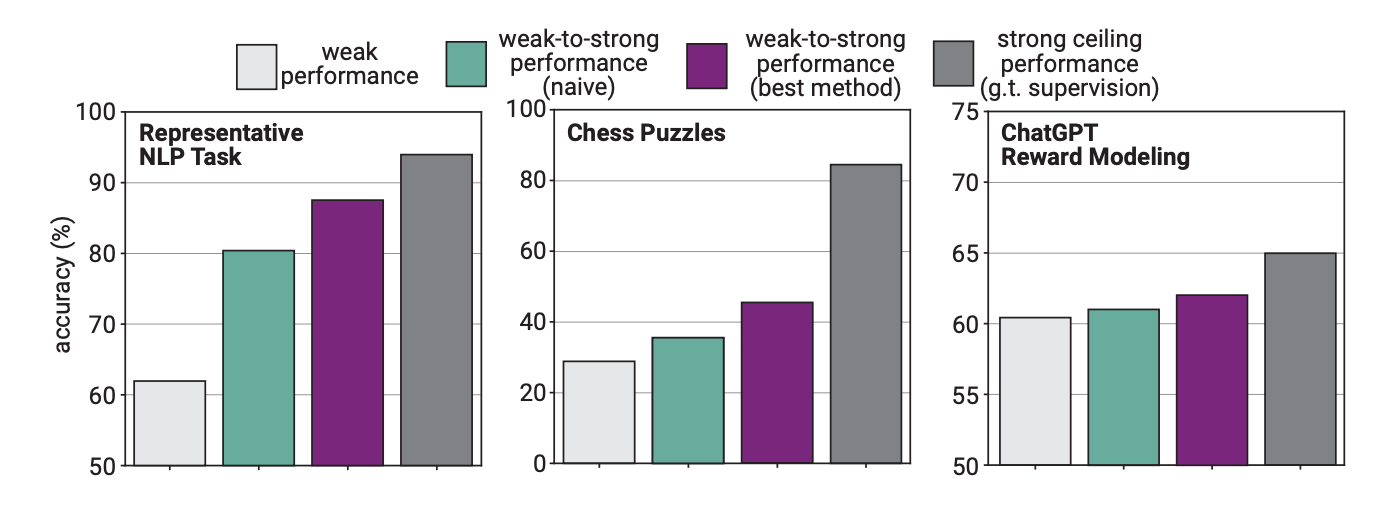

В ходе эксперимента OpenAI использовали GPT-2 для тонкой настройки GPT-4 в задачах НЛП, шахматных головоломках и моделировании вознаграждений. Затем они протестировали работу GPT-4 при выполнении этих задач и сравнили ее с моделью GPT-4, которая была обучена на "базовой истине" или правильных ответах на задачи.

Результаты оказались многообещающими: когда GPT-4 обучался на более слабой модели, он смог сильно обобщить ее и превзойти более слабую модель. Это продемонстрировало, что более слабый интеллект может дать указания более сильному, который впоследствии сможет опираться на это обучение.

Подумайте об этом, как если бы ученик 3-го класса научил очень умного ребенка математике, а затем этот умный ребенок на основе начального обучения стал бы решать задачи 12-го класса.

Разрыв в производительности

Исследователи обнаружили, что, поскольку GPT-4 обучался менее интеллектуальной моделью, этот процесс ограничил его производительность до уровня, эквивалентного правильно обученной модели GPT-3.5.

Это объясняется тем, что более интеллектуальная модель учится на ошибках или плохих мыслительных процессах своего более слабого коллеги. Это говорит о том, что использование людей для обучения сверхинтеллектуального ИИ не позволит ему реализовать весь свой потенциал.

Исследователи предложили использовать промежуточные модели в бутстрапном подходе. В статье объясняется: "Вместо того чтобы напрямую выравнивать очень сверхчеловеческие модели, мы могли бы сначала выровнять только немного сверхчеловеческую модель, использовать ее для выравнивания еще более умной модели и так далее".

OpenAI выделяет много ресурсов на этот проект. Исследовательская группа заявляет, что выделила "20% вычислений, которые мы обеспечили на сегодняшний день, в течение следующих четырех лет для решения проблемы выравнивания суперинтеллекта".

Она также предлагает гранты в размере $10 миллионов долларов частным лицам или организациям, желающим помочь в проведении исследования.

Лучше бы им поскорее разобраться с этим. Сверхразумный ИИ потенциально может написать миллион строк сложного кода, который не сможет понять ни один программист. Как мы узнаем, безопасен ли сгенерированный код для выполнения или нет? Будем надеяться, что мы не узнаем об этом на собственном опыте.