NVIDIA heeft Chat with RTX uitgebracht als een technische demo van hoe AI-chatbots lokaal op Windows-pc's kunnen worden uitgevoerd met behulp van de RTX GPU's.

De standaardaanpak voor het gebruik van een AI-chatbot is het gebruik van een webplatform zoals ChatGPT of het uitvoeren van query's via een API, waarbij de inferentie plaatsvindt op cloud computing servers. De nadelen hiervan zijn de kosten, latentie en privacyproblemen door het heen en weer sturen van persoonlijke of bedrijfsgegevens.

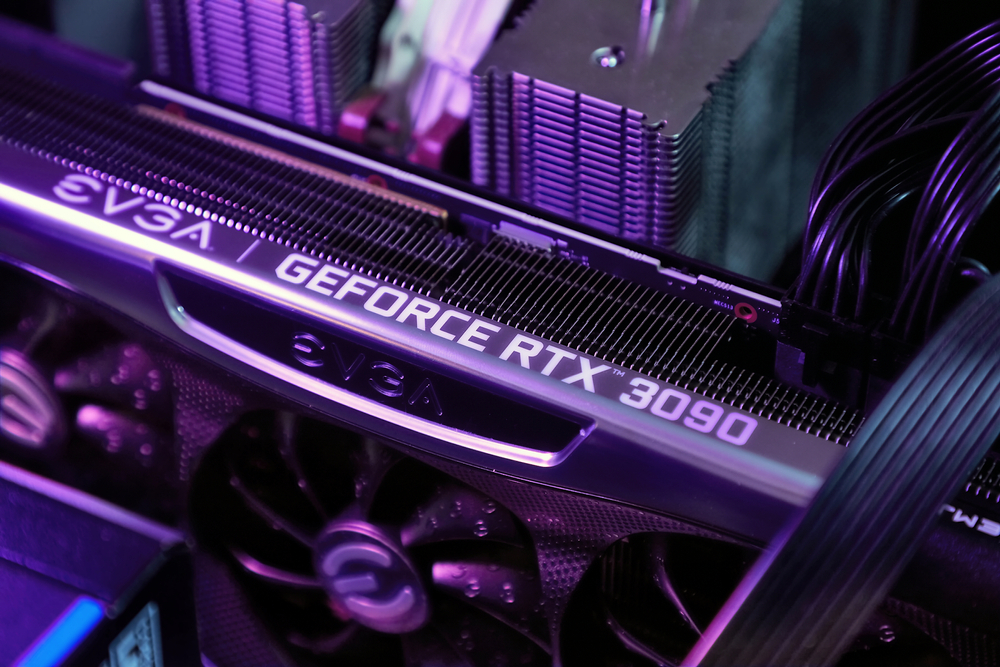

NVIDIA's RTX reeks GPU's is het nu mogelijk om een LLM lokaal op je Windows-pc uit te voeren, zelfs als je niet verbonden bent met het internet.

Met Chat met RTX kunnen gebruikers een gepersonaliseerde chatbot maken met behulp van Mistral of Lama 2. Het maakt gebruik van retrieval-augmented generation (RAG) en NVIDIA's inferentie-optimaliserende TensorRT-LLM software.

Je kunt Chat with RTX naar een map op je pc leiden en dan vragen stellen over de bestanden in de map. Het ondersteunt verschillende bestandsformaten, waaronder .txt, .pdf, .doc/.docx en .xml.

Omdat de LLM lokaal opgeslagen bestanden analyseert en de inferentie op jouw machine gebeurt, is het erg snel en worden er geen gegevens gedeeld op mogelijk onbeveiligde netwerken.

Je kunt het ook een URL van een YouTube-video geven en vragen stellen over de video. Hiervoor heb je toegang tot internet nodig, maar het is een geweldige manier om antwoorden te krijgen zonder een lange video te hoeven bekijken.

U kunt download Chatten met RTX gratis, maar je moet wel Windows 10 of 11 draaien op je pc met een GeForce RTX 30 Series GPU of hoger, met minimaal 8GB VRAM.

Chat met RTX is eerder een demo dan een afgewerkt product. Het is een beetje buggy en onthoudt de context niet, dus je kunt geen vervolgvragen stellen. Maar het is een mooi voorbeeld van de manier waarop we LLM's in de toekomst zullen gebruiken.

Lokaal gebruik van een AI-chatbot zonder API-call-kosten en met zeer weinig latentie is waarschijnlijk de manier waarop de meeste gebruikers uiteindelijk met LLM's zullen communiceren. De open-source aanpak van bedrijven als Meta zal ervoor zorgen dat on-device AI het gebruik van hun gratis modellen zal stimuleren in plaats van propriëtaire modellen zoals GPT.

Dat gezegd hebbende, zullen gebruikers van mobiele apparaten en laptops nog even moeten wachten voordat de rekenkracht van een RTX GPU in kleinere apparaten past.