Google heeft twee modellen uitgebracht uit zijn familie van lichtgewicht, open modellen met de naam Gemma.

Terwijl de Gemini-modellen van Google gesloten modellen zijn, zijn de Gemma-modellen vrijgegeven als "open modellen" en vrij beschikbaar voor ontwikkelaars.

Google heeft Gemma-modellen uitgebracht in twee groottes, 2B- en 7B-parameters, met voorgetrainde en instructie-afgestemde varianten voor elk model. Google geeft de modelgewichten vrij, evenals een reeks tools voor ontwikkelaars om de modellen aan hun behoeften aan te passen.

Google zegt dat de Gemma-modellen zijn gebouwd met dezelfde technologie die het vlaggenschip Gemini aandrijft. Verschillende bedrijven hebben 7B-modellen uitgebracht in een poging om een LLM te leveren die bruikbare functionaliteit behoudt, maar mogelijk lokaal draait in plaats van in de cloud.

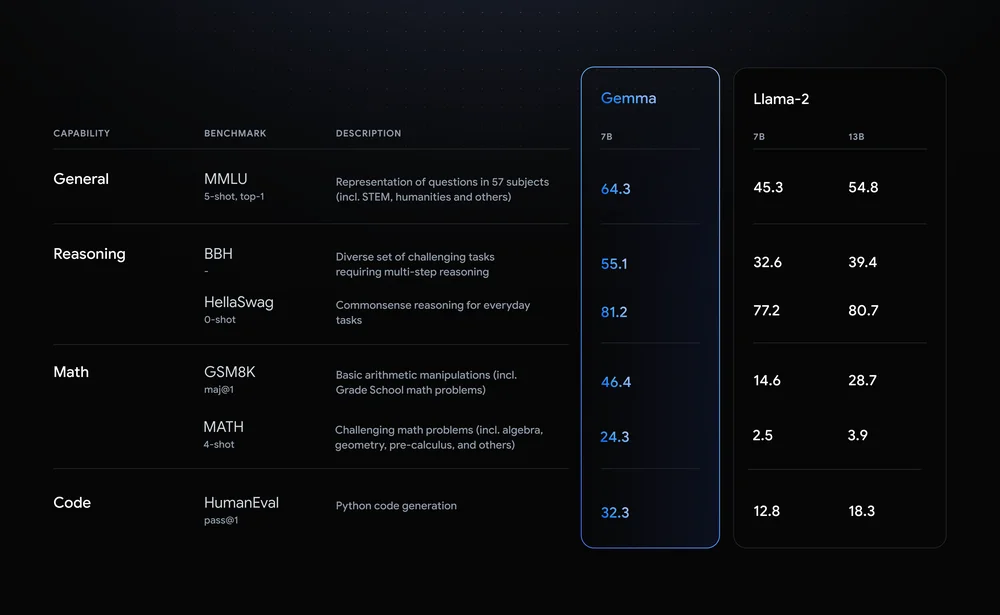

Llama-2-7B en Mistral-7B zijn opmerkelijke mededingers in deze ruimte, maar Google zegt dat "Gemma aanzienlijk grotere modellen op belangrijke benchmarks overtreft" en biedt deze benchmarkvergelijking als bewijs.

De benchmarkresultaten laten zien dat Gemma zelfs de grotere 12B versie van Llama 2 verslaat in alle vier de capaciteiten.

Het meest opwindende aan Gemma is het vooruitzicht om het lokaal uit te voeren. Google is een samenwerking aangegaan met NVIDIA om Gemma te optimaliseren voor NVIDIA GPU's. Als je een pc hebt met een van NVIDIA's RTX GPU's, kun je Gemma op je apparaat draaien.

NVIDIA zegt een installed base van meer dan 100 miljoen NVIDIA RTX GPU's te hebben. Dit maakt Gemma een aantrekkelijke optie voor ontwikkelaars die proberen te beslissen welk lichtgewicht model ze willen gebruiken als basis voor hun producten.

NVIDIA zal ook ondersteuning voor Gemma toevoegen aan haar Chatten met RTX platform waardoor het eenvoudig is om LLM's uit te voeren op RTX PC's.

Hoewel het technisch gezien geen open-source is, zijn het alleen de gebruiksbeperkingen in de licentieovereenkomst die Gemma modellen ervan weerhouden dat label te dragen. Critici van open modellen wijzen op de risico's die inherent zijn aan het op één lijn houden, maar Google zegt dat het uitgebreide red-teaming heeft uitgevoerd om ervoor te zorgen dat Gemma veilig was.

Google zegt dat het "uitgebreide fijnafstemming en versterkingsleren van menselijke feedback (RLHF) heeft gebruikt om onze instructie-afgestemde modellen af te stemmen op verantwoordelijk gedrag". Er is ook een Responsible Generative AI Toolkit uitgebracht om ontwikkelaars te helpen Gemma op één lijn te houden na finetuning.

Aanpasbare lichtgewicht modellen zoals Gemma kunnen ontwikkelaars meer nut bieden dan grotere modellen zoals GPT-4 of Gemini Pro. De mogelijkheid om LLM's lokaal uit te voeren zonder de kosten van cloud computing of API calls wordt met de dag toegankelijker.

Nu Gemma openlijk beschikbaar is voor ontwikkelaars, wordt het interessant om te zien welke AI-toepassingen er binnenkort op onze pc's kunnen draaien.