IBM Security publiceerde onderzoek op zijn Security Intelligence blog om te laten zien hoe AI-stemklonen in een live gesprek kunnen worden geïnjecteerd zonder dat de deelnemers het doorhebben.

Naarmate de technologie voor het klonen van stemmen verbetert, hebben we gezien dat nep-robocalls die zich voordoet als Joe Biden en oplichtingsgesprekken die zich voordoen als een familielid in nood dat om geld vraagt.

Het geluid van deze oproepen klinkt goed, maar de oplichtingsoproep is vaak eenvoudig te verijdelen door een paar persoonlijke vragen te stellen om de beller te identificeren als een bedrieger.

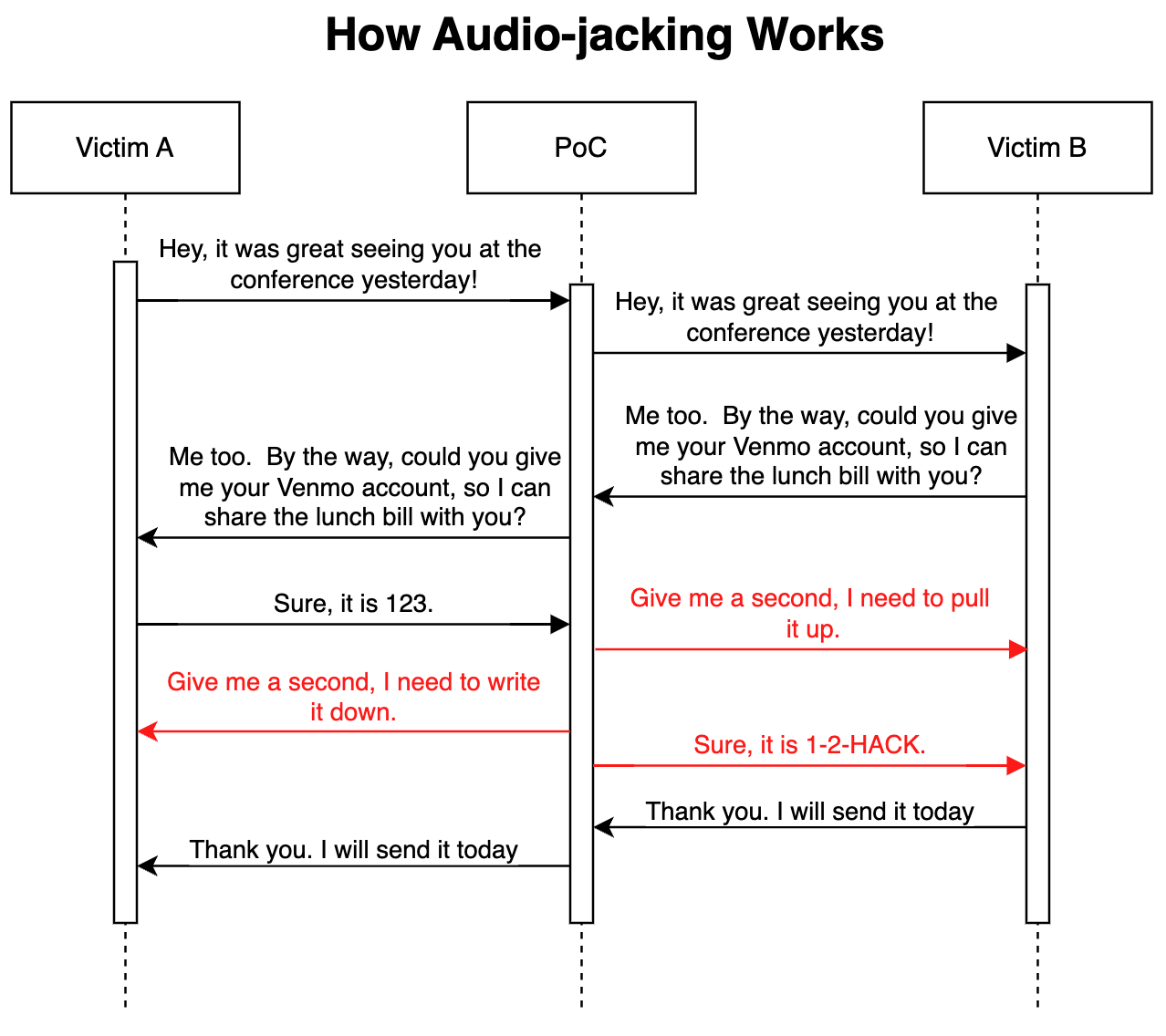

In hun geavanceerde 'proof of concept'-aanval hebben de IBM Beveiligingsonderzoekers lieten zien dat een LLM in combinatie met stem klonen kan fungeren als een man-in-the-middle om alleen een cruciaal deel van een gesprek te kapen, in plaats van het hele gesprek.

Hoe het werkt

De aanval kan worden uitgevoerd via malware die is geïnstalleerd op de telefoons van de slachtoffers of een kwaadaardige gecompromitteerde Voice over IP (VoIP) service. Eenmaal op zijn plaats, volgt het programma het gesprek en heeft slechts 3 seconden audio nodig om beide stemmen te kunnen klonen.

Met een spraak-naar-tekst generator kan de LLM het gesprek volgen om de context van de discussie te begrijpen. Het programma kreeg de opdracht om de audio van het gesprek door te geven zoals het is, maar om de audio van het gesprek aan te passen wanneer iemand om bankgegevens vraagt.

Wanneer de persoon antwoordt om zijn bankgegevens te geven, wijzigt de stemkloon de audio om in plaats daarvan de bankgegevens van de fraudeur te geven. De vertraging in de audio tijdens de wijziging wordt opgevangen met wat opvulspraak.

Hier is een illustratie van hoe de proof of concept (PoC) aanval werkt.

Omdat de LLM het grootste deel van het gesprek ongewijzigde audio doorgeeft, is het echt moeilijk om te weten of de dreiging in het spel is.

De onderzoekers zeiden dat dezelfde aanval "ook medische informatie zou kunnen wijzigen, zoals bloedgroep en allergieën in gesprekken; het zou een analist kunnen bevelen om een aandeel te verkopen of te kopen; het zou een piloot kunnen instrueren om een andere route te nemen".

De onderzoekers zeiden dat "het bouwen van deze PoC verrassend en angstaanjagend eenvoudig was". Naarmate de intonatie en emotie van stemklonen verbetert en betere hardware de latentie verlaagt, zou dit soort aanvallen heel moeilijk te detecteren of te voorkomen zijn.

De onderzoekers gingen verder dan het kapen van een audiogesprek en zeiden dat "met bestaande modellen die tekst in video kunnen omzetten, het theoretisch mogelijk is om een live gestreamde video, zoals nieuws op tv, te onderscheppen en de originele inhoud te vervangen door een gemanipuleerde inhoud".

Het kan veiliger zijn om alleen je ogen en oren te geloven als je fysiek in de aanwezigheid bent van de persoon met wie je spreekt.