De stijgende vraag naar AI ligt op ramkoers met de duurzaamheid van het milieu, waarbij experts stellen dat steenkool misschien zal blijven bestaan om aan de vraag naar elektriciteit te blijven voldoen.

Landen over de hele wereld streven naar de overgang naar netto nul, door te investeren in groene energie en het verbruik van fossiele brandstoffen terug te dringen.

Dit staat haaks op de immense vraag naar elektriciteit die wordt gecreëerd door AI, met name generatieve AI, die miljoenen gebruikers wereldwijd bedient.

Dat is een definitief punt - zelfs een paar jaar geleden waren AI-modellen relatief klein en beperkt tot gelokaliseerd gebruik.

Vandaag de dag hebben jij, ik en miljoenen anderen op zijn minst geëxperimenteerd met AI. Volgens sommige schattingen 40% van de volwassenen in de VS en Europa en 75% van de jongeren onder de 18 jaar.

AI-bedrijven zien een toekomst waarin hun producten zijn ingebed in alles wat we doen en in elk apparaat dat we gebruiken, maar AI wordt niet door lucht aangedreven. Zoals alle technologieën heeft het energie nodig.

A recente krant Het BLOOM-model gebruikte 433 MWh om te trainen en GPT-3 had maar liefst 1287 MWh nodig.

OpenAI's ChatGPT heeft dagelijks naar schatting 564 MWh nodig om antwoorden op gebruikersvragen te berekenen. Elke individuele output vertegenwoordigt een berekening die wordt uitgevoerd door de wijdvertakte neurale netwerken van OpenAI, die allemaal energie verbruiken.

Laten we dat eens in perspectief plaatsen: 1287 MWh zou 43.000 tot 128.700 gemiddelde huishoudens een dag lang van stroom kunnen voorzien, uitgaande van een gemiddeld dagelijks gebruik van 10 tot 30 kWh per huishouden.

Het kan ook meer dan 200.000.000 LED-lampen een uur lang van stroom voorzien of een elektrisch voertuig ruwweg 4 tot 5 miljoen kilometer laten rijden.

Hoewel dit onderzoek en andere hun beperkingen hebben, bevestigen openbare gegevens van open-source AI-bedrijven zoals HuggingFace de omvang van deze cijfers.

De gevolgen van AI voor het milieu gaan verder dan alleen energieverbruik. Waterverbruik in de datacenters van Microsoft onderstreept de grondstofintensieve aard van AI-activiteiten. Een datacenter van 15 megawatt kan dagelijks tot 360.000 liter water verbruiken.

Het Internationaal Energieagentschap (IEA) heeft gewaarschuwd voor de bredere impact van datacenters, die nu al goed zijn voor meer dan 1,3% van het wereldwijde elektriciteitsverbruik. Dit cijfer zal naar verwachting stijgen naarmate de vraag naar AI en gegevensverwerking toeneemt, waardoor de wereldwijde energie-infrastructuur verder onder druk komt te staan en de roep om duurzamere praktijken binnen de AI-industrie wordt versterkt.

De Boston Consulting Group schat dat tegen het einde van dit decennium het elektriciteitsverbruik van datacenters in de VS kan verdrievoudigen ten opzichte van 2022 tot maar liefst 390 terawattuur, goed voor ongeveer 7,5% van de verwachte elektriciteitsvraag van het land.

De EU heeft ook gezegd dat de energiebehoefte van datacenters zal verdubbelen tegen 2026. Alleen al in de VS en China zouden datacenters rond 2030 evenveel kunnen verbruiken als de jaarlijkse productie van 80 tot 130 kolencentrales.

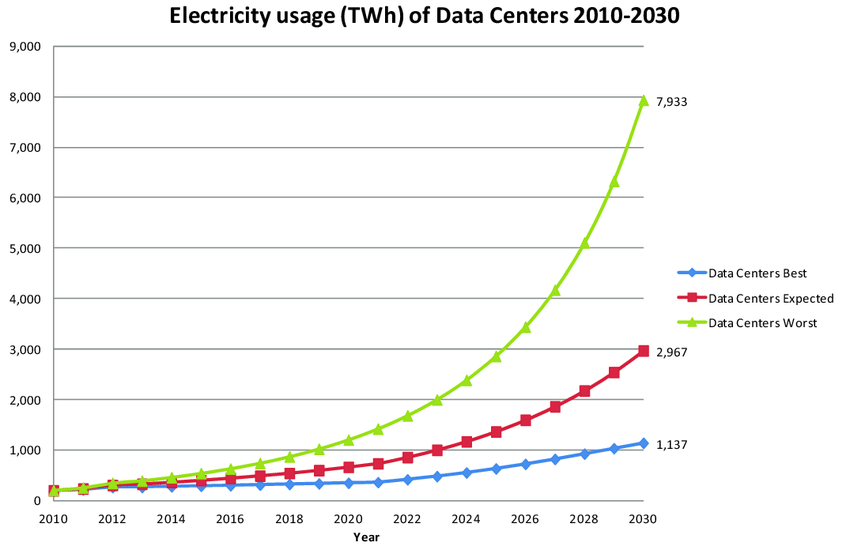

In een worst-case scenario laat de onderstaande grafiek zien dat datacenters in 2030 ongeveer 8.000 TWh aan elektriciteit zouden kunnen verbruiken, wat overeenkomt met 30% van het huidige wereldwijde elektriciteitsverbruik. Dat is het dubbele van wat de VS jaarlijks verbruikt.

We haasten ons niet te sensationeel te doen - laten we niet vergeten dat dit een bovengrensschatting is en dat datacenters voor veel andere dingen dan AI worden gebruikt - maar het is nog steeds behoorlijk schokkend, zelfs bij de ondergrens van 1.100 TWh.

Sam Altman, CEO van OpenAI, zei zelf op het World Economic Forum: "We hebben veel meer energie nodig in de wereld dan we eerder dachten. We zijn ons nog steeds niet bewust van de energiebehoefte van deze technologie."

"AI zal veel meer energie verbruiken dan mensen hadden verwacht," vervolgde hij, suggererend dat energiebronnen zoals kernfusie of goedkopere zonne-energie van vitaal belang zijn voor de vooruitgang van AI.

Datacenters belasten het energienetwerk

In het hart van Noord-Virginia, een regio die nu bekend staat als "datacenter alley", verlegt de snelle groei van generatieve AI de grenzen van elektriciteitsopwekking.

Lokale energieleveranciers moesten op een gegeven moment in 2022 zelfs de aansluiting van nieuwe datacenters stopzetten, omdat de vraag gewoonweg te groot was. Door weerstand uit de gemeenschap werden voorstellen om dieselgeneratoren te gebruiken tijdens stroomtekorten op de lange baan geschoven.

Bloomberg meldt dat in de regio Kansas City voor de bouw van een datacenter en een fabriek voor batterijen voor elektrische auto's zoveel stroom nodig was dat plannen om een kolencentrale te ontmantelen werden uitgesteld.

Ari Peskoe, van het Electricity Law Initiative aan de Harvard Law School, waarschuwde voor de mogelijk ernstige gevolgen als nutsbedrijven zich niet aanpassen: "Nieuwe belastingen worden uitgesteld, fabrieken kunnen niet online komen, ons economisch groeipotentieel wordt verminderd," zegt hij.

"Het ergste scenario is dat nutsbedrijven zich niet aanpassen en oude fossiele-brandstofcapaciteit online houden en zich niet verder ontwikkelen dan dat."

Rob Gramlich van Grid Strategies sloot zich aan bij deze bezorgdheid en benadrukte tegenover Bloomberg het risico van stroomuitval als verbeteringen aan de infrastructuur achterblijven.

De uitdagingen van de nutssector beperken zich niet tot datacenters. Recente wetgeving en stimuleringsmaatregelen stimuleren de bouw van halfgeleider-, EV- en batterijfabrieken, wat ook bijdraagt aan de stijgende vraag naar elektriciteit.

Zo heeft Evergy, dat de regio Kansas City bedient, de sluiting van een kolencentrale uit 1960 uitgesteld om te kunnen voldoen aan de vraag van nieuwe ontwikkelingen, waaronder een Meta Platforms datacenter en een Panasonic EV-batterijfabriek.

Ondanks de voorkeur van veel techbedrijven en fabrikanten van schone technologie voor hernieuwbare energie, zegt de realiteit iets anders. Het is moeilijk voor te stellen hoe dit energieverbruik kan worden gecompenseerd.

De situatie is niet uniek voor de VS. Wereldwijd hebben China, India, het Verenigd Koninkrijk en de EU allemaal gewaarschuwd voor de stijgende vraag naar elektriciteit door AI.

Hoe gaan we betalen?

Nu AI-technologieën alomtegenwoordig worden, botst hun ecologische voetafdruk met de wereldwijde ambities voor een netto nul-toekomst. Zelfs als we de ambitieuze doelen voor het bereiken van net-nul buiten beschouwing laten, kunnen elektriciteitsnetten het huidige traject van de industrie eenvoudigweg niet volhouden.

Komt er een "AI-winter" wanneer AI een lang proces ondergaat van steeds verfijnder en efficiënter worden voordat het intelligenter wordt? Of zullen doorbraken en beloften van de industrie de ontwikkeling op gang houden?

Biologisch geïnspireerde AI, is bijvoorbeeld een veelbelovende grens die de efficiëntie van natuurlijke systemen probeert te harmoniseren met computationele intelligentie. De aarde wordt bewoond door miljarden extreem geavanceerde organismen die worden 'aangedreven' door natuurlijke bronnen zoals voedsel en de zon - kan dit een blauwdruk zijn voor AI?

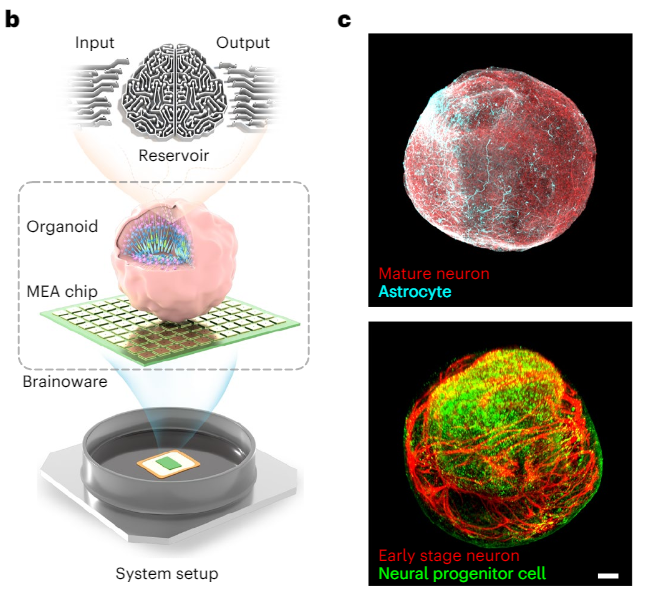

Het antwoord is een voorzichtig ja, met neuromorfe AI-chips gebaseerd op synaptische functies die steeds beter uitvoerbaar worden. AI-spraakherkenning is zelfs uitgevoerd met biologische cellen gevormd tot 'organoïden' - in wezen 'mini-hersenen'.

Andere methoden om het weglopen van middelen door de AI-industrie tegen te gaan zijn onder andere een "AI-belasting".

Een AI-belasting wordt meestal voorgesteld als een methode om AI-gerelateerd banenverlies te verzachten, maar zou er ook voor kunnen zorgen dat entiteiten die profiteren van AI-ontwikkelingen bijdragen aan het verminderen van hun milieueffecten.

Uiteindelijk is het moeilijk te voorspellen hoe de industrie met deze eisen zal omgaan en in welke mate mensen de lasten zullen moeten dragen.