Toen Google de lancering van zijn Gemini-modellen aankondigde, was er veel opwinding omdat het bedrijf zei dat deze vergelijkbaar waren met het aanbod van OpenAI. Dat is misschien niet helemaal waar.

Google zei dat zijn Gemini Ultra model beter is dan GPT-4. Het model moet nog worden uitgebracht, dus we zullen hun benchmarktestresultaten op hun waarde moeten schatten. Gemini Pro is uitgebracht en Google zegt dat het op hetzelfde niveau zit als GPT-3.5.

Onderzoekers van de Carnegie Mellon University en het AI-softwareplatform BerriAI lieten Gemini Pro een reeks taken uitvoeren om zijn taalbegrip en generatievaardigheden te testen.

Ze hebben dezelfde tests uitgevoerd met GPT-3.5 Turbo, GPT-4 Turbo en Mistral AI's nieuwe Model Mixtral 8x7B.

Google's Gemini maakte onlangs furore als grote concurrent voor OpenAI's GPT. Spannend! Maar we vroegen ons af:

Hoe goed is Gemini eigenlijk?

Bij CMU hebben we een onpartijdig, diepgaand en reproduceerbaar onderzoek uitgevoerd waarin Gemini, GPT en Mixtral werden vergeleken.

Papier: https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19 december 2023

Resultaten

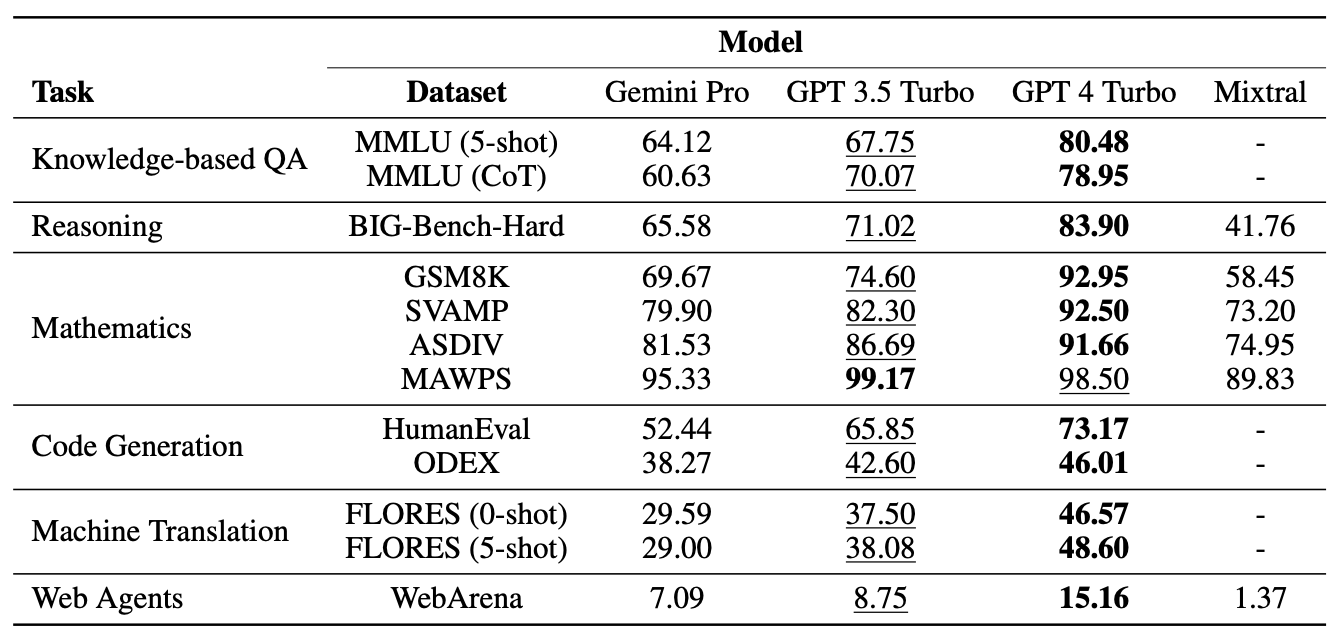

Het zal geen verrassing zijn dat GPT-4 als beste uit de bus kwam, maar Google zal minder benieuwd zijn hoe Gemini Pro het deed in vergelijking met GPT 3.5 Turbo. Een samenvatting van de resultaten van het team, het papier zei: "Het Pro-model van Gemini behaalde een vergelijkbare, maar iets mindere nauwkeurigheid in vergelijking met de huidige versie van OpenAI's GPT 3.5 Turbo."

Hier is een samenvatting van de resultaten.

De modellen werden gevraagd met behulp van de LiteLLM-interface van BerriAI, waarbij elk model exact dezelfde vragen en hetzelfde evaluatieprotocol kreeg.

De modellen werden getest op meerkeuzevragen, redeneren voor algemene doeleinden, wiskundig redeneren, code genereren, taal vertalen en handelen als een webagent.

Een van de redenen waarom Gemini Pro slecht scoorde bij de meerkeuzevragen is dat het een sterke positievoorkeur had. Het koos vaak het antwoord op positie D, of dat nu juist was of niet. Interessant genoeg is dit iets dat Microsoft's Medprompt oplost met schudden.

Ondanks het feit dat Gemini Pro bij sommige tests het onderspit delfde, versloeg het GPT-3.5 Turbo op twee gebieden, namelijk woordsortering en symboolmanipulatie en -vertaling.

Bij alle vertaaltaken die Gemini Pro uitvoerde, presteerde het beter dan alle andere modellen, inclusief GPT-4. De eindscore van Gemini Pro op de vertaaltests kwam echter lager uit dan GPT-3.5, omdat het weigerde sommige aanvragen te voltooien toen de overijverige content moderatiebescherming in werking trad.

Nou en?

Google betwist de cijfers waar de onderzoekers op uitkwamen en houdt vol dat de cijfers aantonen dat Gemini Pro gelijkwaardig of beter is dan GPT-3.5. Als we rekening houden met de talloze variabelen en Google wat speling geven, kunnen we het verschil verdelen en zeggen dat Gemini Pro en GPT-3.5 vrijwel hetzelfde zijn.

De belangrijkste conclusie is dat Gemini Pro, een gloednieuw model waaraan Google maanden heeft gewerkt, het niet wint van een model dat al meer dan een jaar bestaat en gratis te gebruiken is via ChatGPT.

Gemini Ultra wordt naar verwachting begin 2024 uitgebracht. Zal het zijn claim om beter te zijn dan GPT-4 waarmaken? Laten we hopen dat professor Graham Neubig en zijn team binnenkort vergelijkbare benchmarktests kunnen uitvoeren.