AI draait om gegevens, maar waar komen die vandaan? Zijn datasets legaal en ethisch? Hoe kunnen ontwikkelaars dat zeker weten?

Voor het trainen van machine-learningmodellen zoals grote taalmodellen (LLM) zijn grote hoeveelheden tekstgegevens nodig.

Er zijn stapels datasets beschikbaar op platformen zoals Kaggle, GitHub en Hugging Face, maar deze bevinden zich in een juridisch en ethisch grijs gebied, voornamelijk vanwege problemen met licenties en fair use.

De Initiatief Gegevensbewijzen, een samenwerkingsverband tussen AI-onderzoekers en juristen, heeft duizenden datasets onderzocht om hun ware oorsprong te achterhalen.

Het gericht op meer dan 1.800 datasets die beschikbaar zijn op platforms, waaronder Hugging Face, GitHub en Papers With Code. De datasets zijn voornamelijk ontworpen voor het verfijnen van open-source modellen zoals Llama-2.

Uit het onderzoek bleek dat in ongeveer 70% van deze datasets ofwel duidelijke licentie-informatie ontbrak of dat ze waren gelabeld met overdreven permissieve licenties.

Door een schreeuwend gebrek aan duidelijkheid over auteursrechten en commerciële gebruiksbeperkingen lopen AI-ontwikkelaars het risico per ongeluk de wet te overtreden of auteursrechten te schenden.

Shayne Longpre, een promovendus aan het MIT Media Lab die de audit leidde, benadrukte dat het probleem niet de schuld is van hostingplatforms, maar eerder een systemisch probleem binnen de machine-learning gemeenschap.

2023 heeft een stortvloed aan rechtszaken gericht op grote AI-ontwikkelaars zoals Meta, Anthropic en OpenAI, die onder grote druk staan om transparanter om te gaan met het verzamelen van gegevens. Regelgeving, zoals de AI-wet van de EUzijn ingesteld om precies dat af te dwingen.

Het Data Provenance Initiative stelt ontwikkelaars van machine learning in staat om bekijk hier de gecontroleerde gegevenssets. Het initiatief analyseert ook patronen binnen gegevensverzamelingen en werpt licht op hun geografische en institutionele oorsprong.

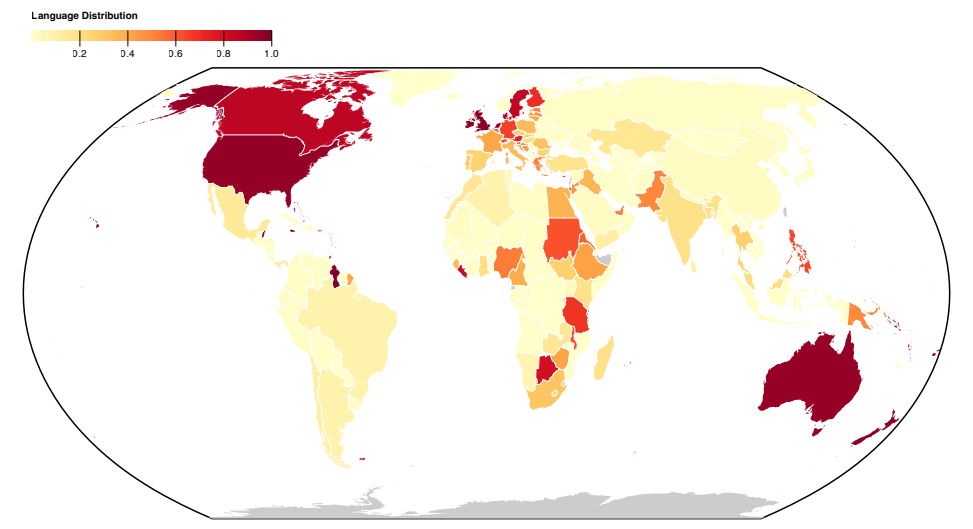

De meeste datasets zijn opgesteld in het Engelssprekende Noorden, wat de sociaal-culturele onevenwichtigheden benadrukt.

Meer over het onderzoek

Deze grootschalige analyse van datasets bracht systematische problemen aan het licht met de manier waarop gegevens worden verzameld en gedistribueerd. Het initiatief produceerde ook een paper om hun bevindingen uit te leggen, hier gepubliceerd.

Hier vindt u meer informatie over de methoden en bevindingen van het onderzoek:

- Analyseren van datasets op oorsprong en labeling: In deze studie werden meer dan 1800 datasets voor fijnafstemming systematisch gecontroleerd om de herkomst, licenties en documentatie van de gegevens te onderzoeken.

- Bewijs van verkeerde etikettering: De bevindingen benadrukten de kloof in datatypes die beschikbaar zijn onder verschillende licenties en implicaties voor juridische interpretaties van auteursrecht en fair use. Het onderzoek bracht een hoge mate van miscategorisatie van licenties aan het licht, waarbij meer dan 72% van de datasets geen licentie specificeerde en een foutenpercentage van 50% in de datasets die dat wel deden.

- Onbetrouwbare herkomst van gegevens: Het onderzoek vestigt de aandacht op het probleem van onbetrouwbare herkomst van gegevens en benadrukt de behoefte aan standaarden om de herkomst van gegevens te traceren, een juiste toeschrijving te garanderen en een verantwoord gebruik van gegevens aan te moedigen.

- Geografische verspreiding: Het onderzoek wijst op een ernstig gebrek aan vertegenwoordiging en toekenning voor datasets afkomstig uit het Zuiden. De meeste datasets draaien om de Engelse taal en zijn cultureel gebonden aan Europa, Noord-Amerika en Engelstalig Oceanië.

Dit onderzoek belicht systemische en structurele problemen in de manier waarop gegevens worden gecreëerd, gedistribueerd en gebruikt. Gegevens zijn een essentiële bron voor AI en net als natuurlijke hulpbronnen zijn ze eindig.

Er bestaat bezorgdheid dat AI-technologie uiteindelijk de huidige datasets zal ontgroeien en mogelijk zelfs zijn eigen uitvoer beginnen te consumerenDit betekent dat AI-modellen zullen leren van door AI gegenereerde tekst.

Dit kan de kwaliteit van modellen aantasten, wat betekent dat kwalitatief hoogwaardige, ethische en legale gegevens wel eens heel waardevol zouden kunnen worden.