Een onderzoek van The Guardian heeft licht geworpen op het alomtegenwoordige gebruik van AI en complexe algoritmen in verschillende besluitvormingsprocessen in de publieke sector in het Verenigd Koninkrijk.

Ambtenaren van ten minste acht overheidsdepartementen en verschillende politie-eenheden hebben AI-tools in hun workflows opgenomen.

AI-tools hebben cruciale besluitvormingsprocessen ondersteund op het gebied van welzijn, immigratie en strafrecht. Het onderzoek bracht bewijs van misbruik en discriminatie aan het licht.

Hoewel algoritmische en AI-gerelateerde bias niet strikt onder dezelfde definitie vallen, lopen ze beide het risico op vertekende resultaten wanneer ze worden blootgesteld aan scenario's in de echte wereld. Zelflerende modellen voor machinaal leren kunnen vertekeningen die overheersen in datasets uitvergroten.

Volgens de verslag:

- Een parlementslid heeft zijn bezorgdheid geuit over een algoritme dat wordt gebruikt door het Department for Work and Pensions (DWP), waarvan wordt vermoed dat het er ten onrechte toe heeft geleid dat veel mensen hun uitkering zijn kwijtgeraakt.

- Het gezichtsherkenningsprogramma van de Metropolitan Police blijkt onder bepaalde omstandigheden een hogere foutmarge te hebben bij het identificeren van zwarte gezichten in vergelijking met blanke gezichten. Dit is al lang bekend, met één onderzoek die aangeven dat deze platforms in 2018 een nauwkeurigheid van een miezerige 2% boden.

- Het ministerie van Binnenlandse Zaken heeft een algoritme gebruikt dat onevenredig gericht is op personen van specifieke nationaliteiten om frauduleuze huwelijken voor uitkeringen en belastingvoordelen aan het licht te brengen. Onderdanen van Albanië, Griekenland, Roemenië en Bulgarije zijn mogelijk onterecht gemarkeerd.

AI-tools leren patronen uit uitgebreide datasets. Als datasets vertekend zijn of slecht representatief voor de werkelijkheid, erft het model die patronen.

Er zijn veel internationale voorbeelden van AI-gerelateerde en algoritmische vooringenomenheid, waaronder foutieve matches voor gezichtsherkenning die leiden tot gevangenisstraf, kredietscorende systemen vrouwen benadelenen discriminerende instrumenten die gebruikt worden in rechtbanken en gezondheidszorgsystemen.

In het rapport van The Guardian wordt gesteld dat het Verenigd Koninkrijk zich nu op de rand van een potentieel schandaal bevindt, waarbij experts hun bezorgdheid uiten over de transparantie en het begrip van de algoritmen die door ambtenaren worden gebruikt.

Schandalen hebben al in andere landenzoals in de VS, waar platforms voor voorspellend politiewerk zijn ontmantelden in Nederland, waar de rechtbank zich verzette tegen een AI-systeem dat fraude met sociale uitkeringen moest tegengaan.

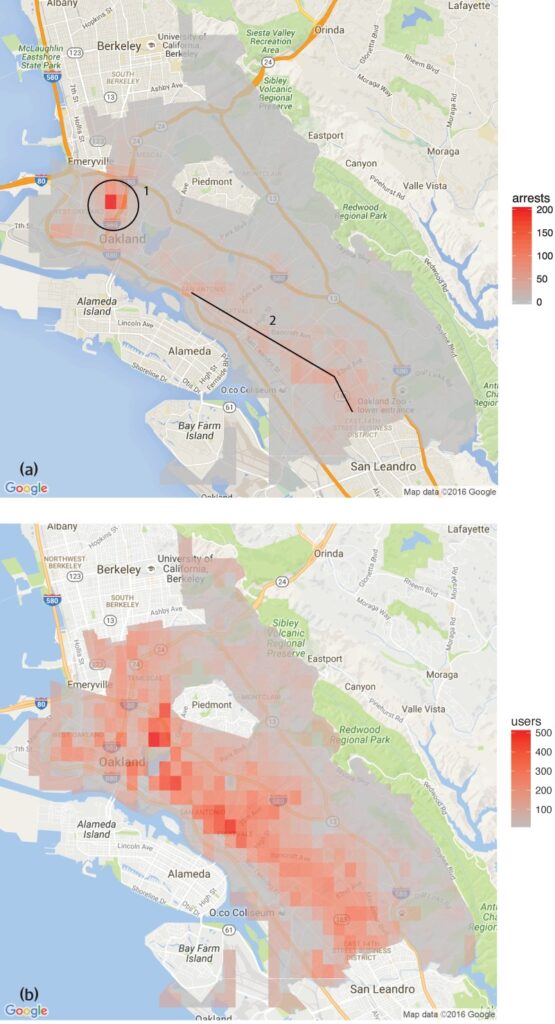

Een onderzoek uitgevoerd door de Groep analyse mensenrechtengegevens ontdekte dat software voor voorspellend politiewerk in Oakland, Californië, onevenredig gericht was op gekleurde gemeenschappen, waardoor een cyclus van overpolitie in deze buurten in stand werd gehouden.

Dit weerspiegelt de bezorgdheid van de Gezichtsherkenningstool van Metropolitan Policedie hogere foutpercentages lieten zien bij het identificeren van zwarte gezichten onder bepaalde omstandigheden.

Er zijn ook verschillende voorbeelden in de gezondheidszorg, zoals inconsistenties in AI-modellen die zijn ontworpen om huidkanker op te sporen. In de meeste gevallen lopen minderheidsgroepen en vrouwen het grootste risico.

Shameem Ahmad, Chief Executive van het Public Law Project, benadrukte de noodzaak van onmiddellijke actie: "AI heeft een enorm potentieel voor sociaal welzijn. We kunnen bijvoorbeeld dingen efficiënter maken. Maar we kunnen de ernstige risico's niet negeren. Als er niet snel actie wordt ondernomen, kunnen we slaapwandelen in een situatie waarin ondoorzichtige geautomatiseerde systemen regelmatig, mogelijk onrechtmatig, worden gebruikt op levensveranderende manieren en waarin mensen geen verhaal kunnen halen als deze processen fout gaan."

Marion Oswald, professor in de rechten aan de Northumbria University, deelt deze bezorgdheid en wijst op de inconsistenties en het gebrek aan transparantie in het gebruik van AI in de publieke sector: "Er is een gebrek aan consistentie en transparantie in de manier waarop AI wordt gebruikt in de publieke sector. Veel van deze tools zullen veel mensen in hun dagelijks leven beïnvloeden, bijvoorbeeld mensen die een uitkering aanvragen, maar mensen begrijpen niet waarom ze worden gebruikt en hebben niet de mogelijkheid om ze aan te vechten."

De risico's van AI voor de publieke sector

De ongecontroleerde toepassing van AI in overheidsdepartementen en politiekorpsen doet vragen rijzen over verantwoording, transparantie en vooringenomenheid.

In het geval van het Department for Work and Pensions (DWP) onthulde het rapport van The Guardian gevallen waarin een algoritme de uitkeringen van mensen opschortte zonder duidelijke uitleg.

Parlementslid Kate Osamor zei dat haar Bulgaarse kiezers hun uitkering kwijtraakten door een semi-geautomatiseerd systeem dat hun gevallen markeerde voor mogelijke fraude, wat wijst op een gebrek aan transparantie.

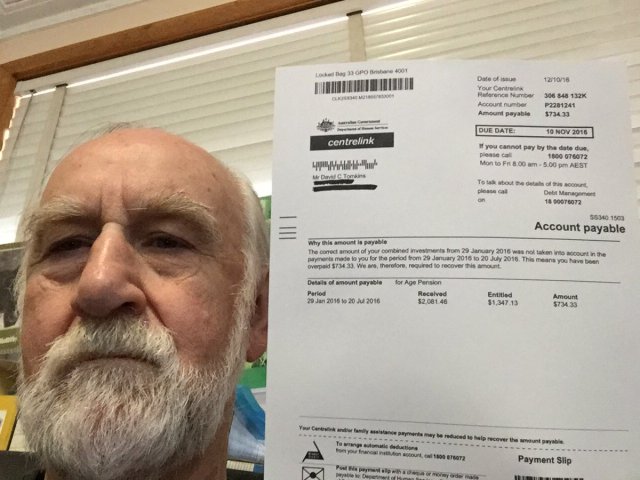

Dit doet denken aan de "Robodebt-schandaal in Australiëwaar een geautomatiseerd systeem ten onrechte meer dan 400.000 mensen beschuldigde van bijstandsfraude, wat leidde tot wijdverspreide ontberingen.

Het Robodebt-schandaal, dat het onderwerp was van onderzoeken door de Commonwealth Ombudsman, juridische uitdagingen en openbare onderzoeken, toonde de omvang van de impact aan die algoritmische besluitvorming heeft.

De Australische regering stemde in met een schikkingsbedrag van AUS $1,8 miljard in 2021.

De tekortkomingen van AI blijven niet beperkt tot overheidsdiensten. Ook het bedrijfsleven is getuige geweest van mislukkingen, met name bij AI-gestuurde wervingstools.

Een opmerkelijk voorbeeld is de AI-wervingstool van Amazon, die een vooroordeel tegen vrouwelijke kandidaten vertoonde. Het systeem werd getraind op cv's die over een periode van 10 jaar bij het bedrijf waren ingediend. De meeste cv's waren afkomstig van mannen, waardoor de AI de voorkeur gaf aan mannelijke kandidaten.

Drie voorbeelden van algoritmische vertekening om op je hoede te zijn

Naarmate AI en algoritmische besluitvorming integreren in complexe maatschappelijke processen, nemen alarmerende voorbeelden van vooroordelen en discriminatie toe.

De gezondheidszorg en het rechtssysteem in de VS

Een onderzoek in 2019 gepubliceerd in Wetenschap onthulde dat een veelgebruikt gezondheidszorgalgoritme in de VS raciale vooroordelen vertoonde. Het algoritme verwees zwarte mensen minder vaak door naar programma's die bedoeld waren om de zorg voor patiënten met complexe medische behoeften te verbeteren dan hun blanke tegenhangers.

Het onderzoek legt uit waarom: "Bias treedt op omdat het algoritme gezondheidskosten gebruikt als een proxy voor gezondheidsbehoeften. Er wordt minder geld uitgegeven aan zwarte patiënten die hetzelfde niveau van behoefte hebben, en het algoritme concludeert dus ten onrechte dat zwarte patiënten gezonder zijn dan even zieke blanke patiënten."

Een ander kritisch voorbeeld is het gebruik van AI bij voorspellend politiewerk en gerechtelijke veroordeling. Tools zoals Correctional Offender Management Profiling voor Alternatieve Sancties (COMPAS) zijn gebruikt om het risico op recidive van verdachten te beoordelen.

Onderzoeken hebben aangetoond dat deze tools bevooroordeeld kunnen zijn ten opzichte van Afro-Amerikaanse verdachten, door hen hogere risicoscores toe te kennen dan hun blanke tegenhangers. Dit roept vragen op over de eerlijkheid en onpartijdigheid van AI-ondersteunde justitiële besluitvorming.

Gezichtsherkenning in Brazilië

De Smart Sampa-project in São Paulo, Brazilië, markeerde een belangrijke mijlpaal in de integratie van AI en surveillance in stedelijke landschappen - iets wat alleen in China gebruikelijk was.

Tegen 2024 wil het tot 20.000 camera's installeren in São Paulo en evenveel camera's van derden en privécamera's integreren in één enkel videobewakingsplatform. Dit netwerk zal toezicht houden op openbare ruimtes, medische faciliteiten en scholen en sociale media-inhoud die relevant is voor het openbaar bestuur onderzoeken.

Hoewel Smart Sampa meer veiligheid en betere openbare diensten belooft, waarschuwen deskundigen dat het bestaande maatschappelijke problemen kan verergeren, met name structureel racisme en ongelijkheid.

Meer dan 90% van de personen die in Brazilië gearresteerd worden op basis van gezichtsherkenning zijn zwart. Het initiatief van São Paulo dreigt deze trend te bestendigen en de zwarte gemeenschap, die 56% van de Braziliaanse bevolking uitmaakt, verder te marginaliseren.

Gezichtsherkenningstechnologieën identificeren donkere huidtinten vaak verkeerd, deels omdat beeldvormingstechnologie ondermaats presteert voor donkere huidtinten en deels omdat trainingsdatasets niet representatief zijn.

Fernanda Rodrigues, een advocaat op het gebied van digitale rechten, benadrukte de mogelijkheid van fout-positieven en het daaruit voortvloeiende risico van massale opsluiting van zwarte individuen.

Rodrigues: "Naast de risico's dat de informatie die aan deze platforms wordt doorgegeven niet nauwkeurig is en het systeem zelf kan falen, is er een probleem dat voorafgaat aan technologische implicaties, namelijk racisme."

"We weten dat het strafsysteem in Brazilië selectief is, dus we kunnen concluderen dat [het gebruik van bewaking met gezichtsherkenning] alleen maar gaat over het vergroten van de risico's en schade voor deze populatie," voegde ze eraan toe.

Privacybelangen zijn ook van het grootste belang. Critici beweren dat Smart Sampa inbreuk zou kunnen maken op fundamentele mensenrechten, waaronder privacy, vrijheid van meningsuiting, vergadering en vereniging. De ondoorzichtige aard van het project maakte de zaken nog ingewikkelder, met beperkte betrokkenheid van het publiek tijdens de raadplegingsfase.

Smart Sampa is niet onomstreden gebleven. Openbare aanklagers hebben een onderzoek ingesteld en mensenrechtenorganisaties hebben juridische stappen ondernomen om de technologie een halt toe te roepen.

De Nederlandse Systeem Risico Indicatie (SyRI)

In 2022 onderzocht de rechtbank van Den Haag de inzet van de Nederlandse overheid van Systeem Risico Indicatie (SyRI), een algoritme dat is ontworpen om potentiële fraude met sociale uitkeringen op te sporen.

SyRI was bedoeld om uitkeringsfraude efficiënter op te sporen door gegevens uit verschillende overheidsdatabases samen te voegen en risico-indicatoren toe te passen om profielen van potentiële fraudeurs op te stellen. Verdachte beslissingen en een gebrek aan transparantie deden echter de alarmbellen rinkelen, wat leidde tot een rechtszaak door een coalitie van maatschappelijke organisaties.

De aanklagers voerden aan dat SyRI verschillende internationale en Europese wetten op het gebied van mensenrechten schond. Ze trokken ook de wettigheid, noodzaak en proportionaliteit van de toepassing van het algoritme in twijfel.

De rechtbank in Den Haag oordeelde dat de wetgeving met betrekking tot SyRI en de toepassing ervan niet voldeed aan de vereiste mensenrechtennormen. De rechtbank benadrukte het gebrek aan transparantie en de mogelijkheid van discriminerende effecten en benadrukte de noodzaak van goede juridische waarborgen bij de implementatie van dergelijke technologieën.

De zaak is geprezen als een van de eerste die de gevolgen van AI voor de mensenrechten in de publieke sector aan de orde stelt en de noodzaak van transparantie, verantwoording en robuuste wettelijke kaders benadrukt.

Transparant en eerlijk testen van tools is van het grootste belang

In het kielzog van recente juridische uitdagingen en openbaar onderzoek rondom algoritmische besluitvorming in overheidsoperaties, is de roep om transparante tests van AI-tools steeds dringender geworden.

Om ervoor te zorgen dat er verantwoording wordt afgelegd, discriminatie wordt voorkomen en het vertrouwen van het publiek behouden blijft, moeten er strenge en open testprotocollen worden geïmplementeerd.

Transparant testen zorgt voor een uitgebreid begrip van de werking van deze algoritmen, de gegevens die ze gebruiken en de besluitvormingsprocessen die ze volgen. Dit is cruciaal voor het identificeren van mogelijke vooroordelen, onnauwkeurigheden of discriminerende praktijken die in het systeem zijn ingebed.

Strenge testprocedures staan echter haaks op de belofte van AI om snel en efficiënt te werken.

In het geval van het Verenigd Koninkrijk is premier Rishi Sunak's innovatiebevorderende houdinge laat misschien niet genoeg ruimte over voor uitgebreide testprocedures. Bovendien zijn er weinig of geen overeengekomen processen voor het testen van AI-instrumenten voordat ze worden gedistribueerd voor publiek gebruik.

Dit scenario wordt wereldwijd weerspiegeld. De snelle toename van AI mag niet ten koste gaan van onderzoek en analyse.