In 1956 schreef Philip K. Dick een novelle getiteld "The Minority Report" die een toekomst voorspelde waarin "precogs" misdaden konden voorzien voordat ze in werkelijkheid plaatsvonden.

Een paar decennia later bracht Tom Cruise dit griezelige visioen naar het witte doek, waarbij hij op basis van deze voorspellingen achter criminelen aanging.

Beide versies dwongen ons na te denken over de ethische implicaties van gearresteerd worden voor iets wat je in de toekomst zou kunnen doen.

Vandaag de dag, nu voorspellende politiemethoden hun weg vinden naar moderne wetshandhaving, moet je je afvragen: staan we op het punt om Dick's vooruitziende verhaal te realiseren?

Wat is predictive policing en hoe werkt het?

Predictive policing combineert wetshandhaving en geavanceerde analyse, waarbij gebruik wordt gemaakt van machinaal leren om te anticiperen op criminele activiteiten voordat ze plaatsvinden.

Op papier is het uitgangspunt eenvoudig genoeg: als we de patronen kunnen decoderen die verborgen zitten in historische misdaadgegevens, kunnen we algoritmes maken om toekomstige gebeurtenissen te voorspellen.

Het proces begint met het verzamelen van historische misdaadgegevens, surveillancefeeds, geklets op sociale media en zelfs nuances zoals weersschommelingen. Deze enorme verzameling informatie wordt vervolgens ingevoerd in geavanceerde modellen voor machinaal leren die zijn ontworpen om onderliggende patronen te onderscheiden.

Het model kan bijvoorbeeld vaststellen dat een bepaalde buurt een piek in inbraken vertoont tijdens regenachtige weekendnachten.

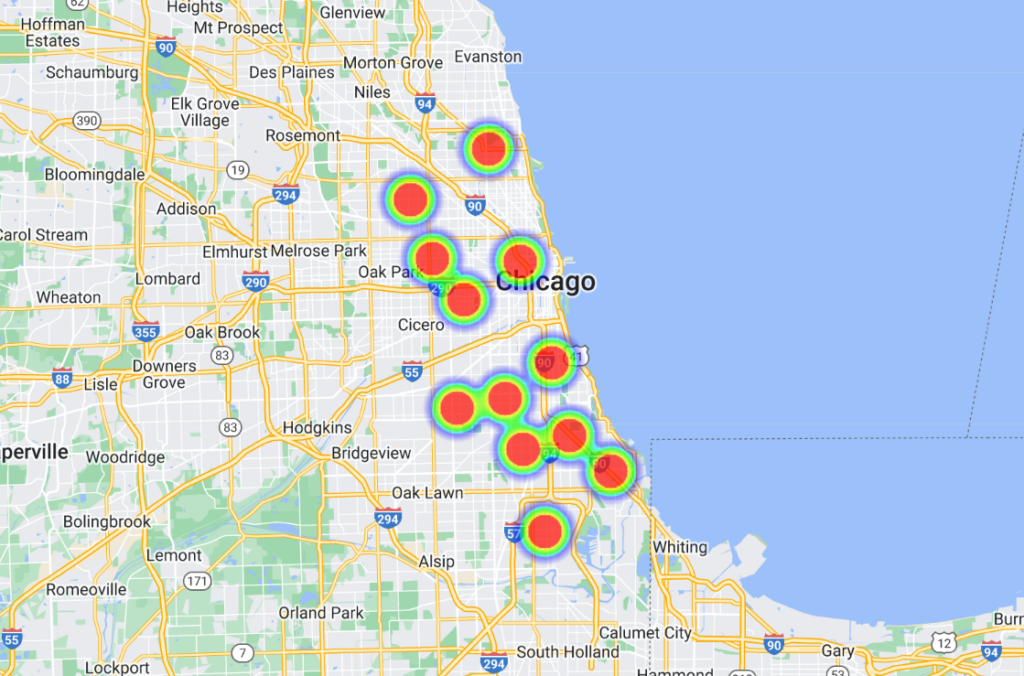

Zodra deze correlaties zijn vastgesteld, worden ze door geavanceerde softwareplatforms omgezet in visuele weergaven, die vaak lijken op 'heat maps' waarop waarschijnlijke criminaliteitshaarden worden gemarkeerd. Dit stelt de politie op haar beurt in staat om haar middelen proactief in te zetten en haar patrouilles en interventies te optimaliseren.

Sommige modellen zijn nog een stap verder gegaan door mensen op naam en adres te vermelden, waardoor agenten zeer specifieke en gelokaliseerde voorspellingen kunnen doen.

De geschiedenis van voorspellend politiewerk

Voorspellende politietechnologie staat nog in de kinderschoenen en hoewel er enkele invloedrijke spelers in de industrie zijn geweest, zoals Palantir, is de industrie klein.

In juni 2022 heeft de Universiteit van Chicago een AI-model ontwikkeld in staat is om misdaadlocaties en -cijfers binnen de stad te voorspellen met een vermeende precisie van 90%.

Op basis van open misdaadgegevens van 2014 tot 2016 verdeelde het team Chicago in vierkanten van ongeveer 300 meter. Het model kon een week van tevoren voorspellen op welk plein de kans op een misdrijf het grootst was.

Het onderzoek had eerlijke bedoelingen en bracht ruimtelijke en sociaaleconomische vooroordelen aan het licht in de inspanningen van de politie en de toewijzing van middelen. Uit het onderzoek bleek dat welvarende buurten meer middelen ontvingen dan gebieden met lagere inkomens.

In de woorden van het onderzoek: "Hier laten we zien dat voorspellende modellen de macht van de staat kunnen vergroten door criminele surveillance, maar dat ze ook surveillance van de staat mogelijk maken door het opsporen van systemische vooroordelen in de handhaving van criminaliteit."

Daarnaast werd het model getraind met gegevens van zeven andere steden in de VS, met vergelijkbare resultaten. Alle datasets en algoritmen zijn beschikbaar gesteld op GitHub.

Chicago is een belangrijke casestudy op het gebied van datagestuurd en AI-ondersteund politiewerk. Een ander voorbeeld is de vuurwapenmisdaad heatmapdat "hotspots" van criminaliteit identificeert die kunnen worden gebruikt voor politie-inspanningen.

Een opmerkelijk incident in 2013 - in de kinderschoenen van predictive policing. betrokken Robert McDaniels, een inwoner van Chicago's Austin district, waar 90% van de wapenmisdrijven in de stad plaatsvinden.

Ondanks zijn geweldloze verleden werd McDaniels opname op een lijst van potentieel gewelddadige criminelen twee keer het doelwit van vuurwapengeweld doordat de politie bij hem aan de deur stond en hem tot doelwit maakte.

Een onderzoek door The Verge staat dat een journalist van de Chicago Tribune contact opnam met McDaniel over de "hittelijst" - een onofficiële naam die de politie gaf aan de algoritmes die potentiële schutters en doelwitten labelen.

Ishanu Chattopadhyay, de hoofdonderzoeker in de 2022 Chicago misdaadvoorspellingsprojectbenadrukte dat hun model locaties voorspelt, geen individuen. "Het is geen Minority Report," zei hij - maar het McDaniels-gebeuren trekt zeker enkele parallellen.

Chattopadhyay ging in op de bezorgdheid over vooroordelen en merkte op dat ze opzettelijk kleine drugs- en verkeersovertredingen weglieten en zich concentreerden op gewelds- en eigendomsdelicten die vaker werden gerapporteerd.

Echter, sUit onderzoek blijkt dat zwarte mensen vaker worden aangegeven voor misdaden dan hun blanke tegenhangers. Bijgevolg worden zwarte buurten onterecht bestempeld als "risicovol".

Bovendien betekent een intensievere politiezorg in een gebied meer gerapporteerde criminaliteit, waardoor een terugkoppelingslus ontstaat die de perceptie van criminaliteit vertekent.

Vertrouwen op gegevens uit het verleden kan stereotypen bestendigen en het potentieel voor verandering en rehabilitatie over het hoofd zien.

Hoe is het gegaan met voorspellend politiewerk?

Voorspellend politiewerk is, zoals te verwachten valt, zeer controversieel, maar werkt het eigenlijk wel of voldoet het aan zijn basisdoel?

Een onderzoek van oktober 2023 door De opmaak en Wired onthulde flagrante tekortkomingen en voegde toe aan een groeiende hoeveelheid bewijsmateriaal dat de gevaren en tekortkomingen benadrukt van het overdragen van de besluitvorming van wetshandhaving naar machines.

Het programma in focus is Geolitica, een voorspellende politiesoftware die wordt gebruikt door de politie in Plainfield, New Jersey. Opmerkelijk is dat de politie van Plainfield de enige van de 38 afdelingen was die bereid was om gegevens met de media te delen.

Voorheen bekend als PredPolwerd deze software voor machinaal leren aangeschaft door verschillende politieafdelingen.

The Markup en Wired analyseerden 23.631 van Geolitica's voorspellingen van februari tot december 2018. Daarvan kwamen minder dan 100 voorspellingen overeen met echte misdaadgevallen, wat resulteert in een succespercentage van minder dan een half procent.

Deze voorspellingsmodellen zijn altijd omstreden geweest en riepen veel ethische vragen op over hun vermogen om discriminerende en racistische vooroordelen te versterken die vaak voorkomen in AI en wetshandhaving.

Dit recente onderzoek onderstreept ethische dilemma's en zet vraagtekens bij de doeltreffendheid van de software bij het voorspellen van misdaden.

Hoewel de software kleine verschillen vertoonde in de voorspellingsnauwkeurigheid van de verschillende soorten misdrijven (het voorspelde bijvoorbeeld 0,6 procent van de overvallen of zware mishandelingen correct, vergeleken met 0,1 procent van de inbraken), blijft het overkoepelende verhaal er een van sterk ondermaats presteren.

Het openhartige antwoord van David Guarino van de politie van Plainfield werpt licht op de realiteit. "Waarom hebben we PredPol? We wilden onze efficiëntie op het gebied van misdaadbestrijding vergroten," zei hij.

"Ik weet niet zeker of het dat bereikt heeft. We hebben het zelden of nooit gebruikt." Hij zei ook dat de politie het niet meer gebruikte.

Kapitein Guarino suggereerde dat de middelen die aan Geolitica waren toegewezen - wat neerkwam op een jaarlijks abonnementsgeld van $20.500 plus nog eens $15.500 voor een tweede jaar - misschien beter geïnvesteerd hadden kunnen worden in programma's die gericht zijn op de gemeenschap.

Geolitica zal tegen het einde van het jaar zijn activiteiten staken.

Bewijs voor vertekening bij voorspellend politiewerk

De belofte van voorspellend politiewerk blijft prikkelen, vooral nu politiekorpsen steeds meer onder druk komen te staan en de kwaliteit van de menselijke besluitvorming bij de politie in diskrediet raakt.

Politiediensten in de VS, het VK en verschillende Europese landen, waaronder Frankrijk, worden kritisch bekeken vanwege vooroordelen over minderheidsgroepen.

Leden van zowel het Britse Hogerhuis als het Lagerhuis dringen aan op een tijdelijke stillegging over de inzet van live gezichtsherkenningstechnologie door de politie.

Dit kwam aan het licht nadat minister van Politie Chris Philip had besproken om politiediensten toegang te geven tot 45 miljoen afbeeldingen uit de paspoortdatabase voor gezichtsherkenning door de politie. Tot nu toe zijn 65 parlementsleden en 31 organisaties op het gebied van rechten en rassengelijkheid tegen het gebruik van gezichtsherkenningstechnologieën bij de politie.

De belangengroep Big Brother kijken stelde dat 89% van de gezichtsherkenningssignalen van de Britse politie falen in hun doel, met onevenredig slechtere resultaten voor etnische minderheidsgroepen en vrouwen. Een gezichtsherkenningstest in 2018 door de Londense Metropolitan Police had een somber succespercentage van slechts ongeveer 2%.

Zoals Michael Birtwistle, van het Ada Lovelace Instituut, beschreven"De nauwkeurigheid en wetenschappelijke basis van gezichtsherkenningstechnologieën is zeer omstreden en hun wettigheid is onzeker."

In de VS heeft een samenwerkingsproject tussen Columbia University, AI Now Institute en anderen onlangs rechtszaken in de VS geanalyseerd waarbij algoritmen betrokken waren.

Uit het onderzoek bleek dat AI-systemen vaak overhaast en zonder passend toezicht werden geïmplementeerd, voornamelijk om kosten te besparen. Helaas leidden deze systemen vaak tot constitutionele problemen vanwege inherente vooroordelen.

Minstens vier zwarte mannen zijn ten onrechte gearresteerd en/of gevangen gezet in afwachting van onjuiste gezichtsvergelijkingen in de VS, waaronder Nijeer Parkenvalselijk beschuldigd van winkeldiefstal en verkeersovertredingen, ondanks het feit dat hij 30 mijl verwijderd was van de vermeende incidenten. Hij bracht vervolgens tien dagen door in de gevangenis en moest duizenden aan juridische kosten betalen.

De De auteurs van de studie concludeerdenDeze AI-systemen werden geïmplementeerd zonder zinvolle training, ondersteuning of toezicht en zonder enige specifieke bescherming voor ontvangers. Dit was deels te wijten aan het feit dat ze werden aangenomen om kosten te besparen en te standaardiseren in het kader van een monolithisch technologie-aankoopmodel, waarin zelden rekening wordt gehouden met constitutionele aansprakelijkheidskwesties."

Voorspellend politiewerk kan onnatuurlijke besluitvorming in de hand werken

Zelfs als voorspellend politiewerk accuraat is, moeten mensen handelen naar aanleiding van de voorspellingen, en dat is waar het een rommeltje wordt.

Als een algoritme de politie vertelt dat ze ergens moeten zijn omdat er een misdaad wordt gepleegd of dreigt te worden gepleegd, is het niet ondenkbaar dat dit de besluitvorming verstoort.

Er zijn een paar fundamentele psychologische theorieën die je beter onder ogen kunt zien als je de rol van AI in het politiewerk overweegt.

Ten eerste, wanneer een algoritme de politie informeert over een waarschijnlijke plaats delict, kan het hen klaarstomen om de situatie te bekijken door een lens van verwachting. Dit kan een rol hebben gespeeld bij het McDaniels-incident - de politie kwam ter plaatse in de verwachting dat er een incident zou plaatsvinden, waardoor de gebeurtenissen escaleerden in een vluchtige omgeving.

Dit is geworteld in confirmation bias, wat suggereert dat als we eenmaal een stukje informatie hebben, we geneigd zijn om volgende informatie te zoeken en te interpreteren op een manier die overeenkomt met die aanvankelijke overtuiging.

Als iemand van een algoritme te horen krijgt dat een misdrijf waarschijnlijk zal plaatsvinden, kan hij onbewust meer belang hechten aan aanwijzingen die deze voorspelling bevestigen en aanwijzingen die deze voorspelling tegenspreken over het hoofd zien.

Bovendien kunnen algoritmen, vooral die welke in officiële hoedanigheden worden gebruikt, als gezaghebbend worden beschouwd vanwege hun computationele aard.

En dan is er nog het risico van morele ontkoppeling. Agenten kunnen de verantwoordelijkheid voor hun acties afschuiven op het algoritme, denkend dat het de software was die de beslissing nam, niet zij - wat ook zeer relevant is op het gebied van oorlogsvoering.

De debatten lopen hier parallel met die rond Het gebruik van AI op het slagvelddie een aantal vergelijkbare dilemma's met zich meebrengt.

De opgelegde autoriteit van AI kan resulteren in een "verantwoordingskloof" waarbij niemand verantwoordelijkheid neemt voor fouten die door de AI worden gemaakt, zoals Kate Crawford en Jason Schultz in een recente JSTOR artikel.

Al met al, op basis van het huidige bewijs dat we hebben, bestendigt voorspellend politiewerk vaak vooroordelen in plaats van ze te verminderen.

Wanneer voorspellingen gecombineerd worden met menselijke besluitvorming, kunnen de gevolgen catastrofaal zijn.