I en ikke så fjern fortid var samtaler om kunstig intelligens først og fremst forbeholdt science fiction og akademiske artikler.

I dag er kunstig intelligens dypt integrert i hverdagen, fra smarthus til diagnostisering av sykdommer.

Men samtidig som AI-teknologien løper fremover, henger regelverket ofte etter innovasjonskurven.

Dette stiller menneskeheten overfor et mangefasettert puslespill - hvordan utformer vi lover og regler som er smidige nok til å tilpasse seg raske teknologiske endringer, men samtidig robuste nok til å beskytte samfunnets interesser?

Over hele verden er reguleringsarbeidet langt fra ensartet. EU har lagt grunnlaget med sin omfattende AI-lov, som tar sikte på å kategorisere og kontrollere AI-applikasjoner basert på risikonivå.

I mellomtiden har USA foretrukket frivillige forpliktelser fremfor umiddelbar lovgivning.

Kina, derimot, har et stramt grep om kunstig intelligens og tilpasser reguleringen til bredere politiske og sosiale styringsmål.

Og la oss ikke glemme andre jurisdiksjoner - AI er et globalt fenomen som vil kreve en tilnærmet universell lovgivning dekning.

Så hvor står reguleringen nå, og hvordan forventes den å utvikle seg?

EUs tilnærming

EU har vedtatt et strengt rammeverk med sin banebrytende AI-lov, som forventes å bli fullstendig godkjent innen utgangen av året.

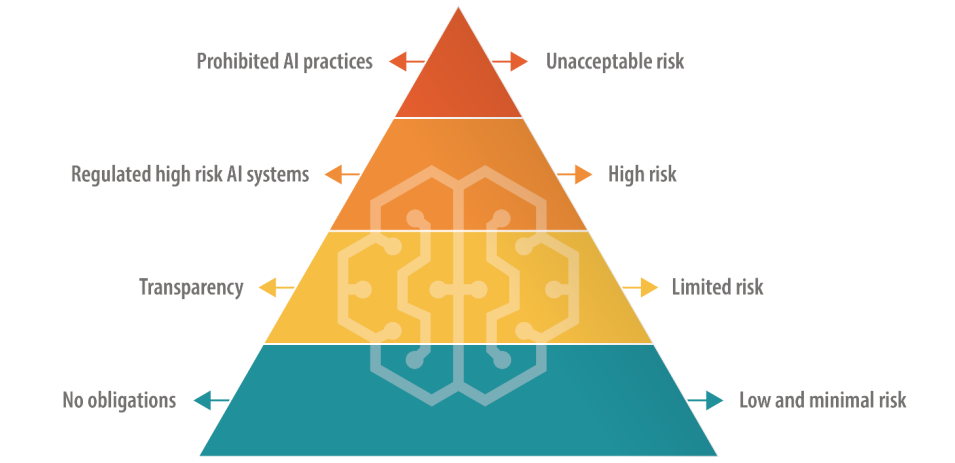

AI-loven spesifiserer fire nivåer, inkludert "uakseptabel risiko-AI", "høyrisiko-AI", "begrenset risiko-AI" og "lavrisiko-AI", som hver har et spesifikt sett med retningslinjer og forbud.

Uakseptable risiko-KI-er utgjør en umiddelbar eller betydelig fare, for eksempel ved å forårsake fysisk eller psykisk skade eller krenke menneskerettighetene - og disse vil bli direkte forbudt.

Kunstig intelligens med høy risiko er tillatt, men underlagt strenge regler for alt fra risikohåndtering til teknisk dokumentasjon og cybersikkerhet.

AI-er med begrenset og lav risiko er derimot stort sett uregulerte, men de er pålagt å opprettholde åpenhet overfor brukerne.

På kort sikt er det en mulighet, ettersom lovverket omfatter en overgangsperiode på omtrent to år for selskaper som ønsker å tilpasse seg det nye regelverket.

EU foreslår at de opprinnelige skaperne av AI-modeller skal være ansvarlige for hvordan teknologien deres brukes, selv når den bygges inn i et annet system av et annet selskap eller en annen utvikler. Det er også lagt til nye regler for "grunnmodeller", som omfatter generative AI-modeller.

Mottakelsen av AI-loven varierer - noen kritiserer de klønete definisjonene og dens potensial til å hemme innovasjon. Det er for eksempel stor usikkerhet knyttet til hvordan ulike AI-modeller sorteres i risikokategorier.

I tillegg er mindre AI-selskaper bekymret for at de ikke har nok ressurser til å etterleve kravene.

OpenAIs administrerende direktør Sam Altman kortvarig truet å trekke selskapets produkter fra EU-markedet hvis AI-loven stiller krav som det ikke er realistisk å overholde.

I juni ble 150 store selskaper fremhevet lovens hardhendte tilnærming, og uttalte at de nåværende reglene risikerer å ødelegge europeisk konkurranseevne.

Avvik fra USA

A Stanford-analyse av AI-loven diskuterte grunnleggende forskjeller mellom EUs og USAs tilnærming til AI-regulering.

Alex Engler, stipendiat i Governance Studies ved Brookings Institution, sa: "Det er en økende forskjell mellom USAs og EUs tilnærming [til regulering av AI]."

Han fremhever at EU har presset på for å få på plass lover om personvern og åpenhet, noe som for det meste mangler i USA. Ulikhetene gjør det vanskelig for AI-selskaper å etterleve lovene, og kostnadene forbundet med å etterleve dem på tvers av jurisdiksjonene kan bli uoverkommelige.

"Bedriftsinteresser vil kjempe med nebb og klør hvis du har to dramatisk forskjellige standarder for nettbaserte plattformer", sier Engler.

Når det kommer til stykket, er det vanskelig å se for seg at teknologibedrifter ikke vil finne en måte å navigere i AI-loven på, slik de har gjort med GDPR og vil måtte gjøre med den nylig vedtatte loven om digitale tjenester.

I en tale til tidsskriftet NatureDaniel Leufer, senioranalytiker ved Access Now, avviser AI-industriens innvendinger mot loven som "det vanlige skrytet".

Den britiske tilnærmingen

Etter brexit har Storbritannia som mål å utnytte sin uavhengighet fra EU til å utforme et mer fleksibelt og sektorspesifikt regelverk.

I motsetning til AI-loven har den britiske regjeringen til hensikt å regulere anvendelsen av kunstig intelligens snarere enn selve den underliggende programvaren.

En "pro-innovasjon"-holdning

Den britiske regjeringen offentliggjorde en hvitbok i mars som skisserer et "innovasjonsfremmende" rammeverk, og inviterer interessenter til å komme med sine synspunkter. Regjeringen har imidlertid ennå ikke utstedt retningslinjer for hvordan dette rammeverket skal implementeres.

I en uttalelse heter det at "regjeringen vil hjelpe Storbritannia med å utnytte mulighetene og fordelene som AI-teknologien gir" - en tilnærming som har blitt kritisert for ikke å ta tilstrekkelig hensyn til AI-relaterte skader.

Regjeringen hadde til og med planlagt å tilby AI-firmaer et ekstremt kontroversielt "opphavsrettsfritak", men Snudde om på den planen i august.

Storbritannia har hatt vanskelig for å tiltrekke seg teknologisk innovasjon i det siste, og har blant annet mistet Cambridge-chipprodusenten Arm, som valgte å børsnotere aksjene i USA i stedet for i hjemlandet. Dette er kanskje med på å forsterke Storbritannias angst for å få fart på den sviktende teknologisektoren igjen.

For å bidra til å posisjonere Storbritannia som et fremtidsrettet land innen kunstig intelligens, kunngjorde statsminister Rishi Sunak en todagers Toppmøte om AI-sikkerhet som finner sted i november.

Kina er invitert til arrangementet - selv om det spekuleres i om de vil bli ekskludert på grunn av frykt for spionasje.

Den amerikanske tilnærmingen

I USA er fokuset på å la bransjen regulere seg selv, i hvert fall inntil videre.

Den amerikanske kongressen signaliserer en "vent og se"-tilnærming, og starter en gjennomgang av AI-møter bak lukkede dører og Chuck Schumers AI Insight-forum for å finne ut nøyaktig hvor AI krever ny regulering.

Tverrpolitiske avtaler kan dreie seg om snevert skreddersydd lovgivning som tar for seg personvern, plattformgjennomsiktighet eller beskytte barn på nettet.

I tillegg har noen fremhevet at eksisterende lover og forskrifter fortsatt er relevante for AI.

I juni, Khan sa"Det finnes ikke noe AI-fritak fra lover som forbyr diskriminering ... Etter hvert som disse tingene blir mer integrert i hvordan daglige beslutninger tas, tror jeg de inviterer til og fortjener mye gransking ... Jeg tror håndhevere, det være seg på delstatsnivå eller nasjonalt nivå, kommer til å handle."

Frivillige rammeverk og "stop-gaps

Fremtredende teknologiselskaper som Microsoft, OpenAI, Google, Amazon og Meta har nylig undertegnet frivillige forpliktelser for sikker AI-utvikling, inkludert intern og ekstern testing av AI-modeller før offentlig lansering.

Mange ledere i teknologibransjen har kommet med sine egne løfter, men i I mangel av et solid lovgivende tilsyn gjenstår det å teste om disse løftene er oppriktige.

Alt i alt hevder kritikerne at USAs tilnærming i hovedsak er symbolsk, og at den ikke er like dyptgående og forpliktende som EUs AI Act. Den første AI Insight Forum var et arrangement som i stor grad foregikk bak lukkede dører, og som enkelte kritiserte for å begrense den åpne debatten.

Senator Josh Hawley sa at arrangementet var et "gigantisk cocktailparty".

Som Ryan Calo, professor ved University of Washington School of Law, så treffende oppsummerte det: "Det ser ut som om det er aktivitet, men det er ikke noe substansielt og bindende."

Den kinesiske tilnærmingen

Kina har innført noen av de strengeste reguleringene for kunstig intelligens, noe som står i forhold til landets ønske om statlig kontroll.

Hovedvekten ligger på å kontrollere AIs spredning av informasjon, noe som gjenspeiler Kinas bredere politiske og sosiale styringsrammeverk.

For eksempel må leverandører av generativ AI hvis produkter kan "påvirke den offentlige opinionen", gjennomgå en sikkerhetsvurdering.

Den første bølgen av godkjente chatboter, inkludert Baidus ERNIE Bot, ble nylig frigitt til offentligheten og funnet å sensurere spørsmål med politisk tema.

Økningen av "deep fakes" og AI-generert innhold skaper utfordringer over hele verden, og Kina er ikke noe unntak. Kinas Cyberspace Administration of China (CAC) erkjente de potensielle fallgruvene ved AI relativt tidlig på året, og krever at AI-drevne innholdsgeneratorer må gjennomgå identitetsverifiseringsprosesser for brukerne.

I tillegg er det innført bestemmelser om vannmerking for å skille AI-generert innhold fra menneskeskapt innhold, regler som også vestlige makter ønsker å innføre.

Ulikheter mellom USA og Kina

AI har ført til økt friksjon mellom USA og Kina, og har utløst det mange har kalt en "digital kald krig" - eller kanskje mer passende, en "AI-kald krig".

USAs restriksjoner på samarbeid og handel med Kina er ikke noe nytt, men frikoblingen mellom de to landene skjøt fart da Xi Jinping kunngjorde sin nye, reformerte Made in China 2025-planen.

Målet er å gjøre Kina 70% selvforsynt innen viktige teknologisektorer innen 2025, inkludert avansert AI-teknologi.

For øyeblikket er USA kutte finansiering og forskning bånd til Kina, samtidig som de underlegger seg innkjøp av AI-brikker fra selskaper som Nvidia.

Mens USA har et klart forsprang i kappløpet om AI-dominans, har Kina noen triks i ermet, blant annet en sentralisert tilnærming til regulering og nesten ubegrensede mengder persondata.

I mai ble Edith Yeung, partner i investeringsselskapet Race Capital, fortalte BBC"Kina har mye færre regler rundt personvern, og mye mer data [sammenlignet med USA]. Det finnes for eksempel ansiktsgjenkjenning overalt."

Kinas tette bånd mellom myndighetene og teknologibransjen gir også fordeler, ettersom datautvekslingen mellom myndighetene og innenlandske teknologibedrifter er praktisk talt sømløs.

USA og andre vestlige jurisdiksjoner har ikke samme tilgang til forretnings- og persondata, som er selve livsnerven i maskinlæringsmodeller. Faktisk er det allerede bekymring for at data av høy kvalitet datakildene er i ferd med å "ta slutt".'

Vestlige AI-selskapers liberale bruk av potensielt opphavsrettslig beskyttede treningsdata har dessuten ført til omfattende opprør og søksmål.

Kinas AI-selskaper vil sannsynligvis ikke lide av det problemet.

Balanse mellom tilgjengelighet og risiko

AI var en gang forbeholdt akademia og store bedrifter. I løpet av et år har mellom en fjerdedel og halvparten av alle voksne i Storbritannia, USA og EU brukt generativ AI.

Tilgjengelighet har mange fordeler, blant annet at det stimulerer til innovasjon og reduserer etableringsbarrierene for nystartede selskaper og individuelle utviklere. Men det gir også grunn til bekymring for det potensielle misbruket som følger med uregulert tilgang.

Den nylige hendelsen der Metas språkmodell Llama-1 ble lekket på internett er et godt eksempel på utfordringene med å begrense AI-teknologi. AI-modeller med åpen kildekode har allerede blitt brukt til svindelformål og til å generere bilder av overgrep mot barn.

AI-selskaper vet detteog åpen kildekode-modeller truer deres konkurransefortrinn. Meta har vokst frem som noe av en antagonist i bransjen, og har lansert en rekke modeller gratis mens andre, som Microsoft, OpenAI og Google, sliter med å tjene penger på sine AI-produkter.

Andre modeller med åpen kildekode, som Falcon 180B LLMer eksepsjonelt kraftige, samtidig som de mangler rekkverk.

Noen spekulerer i at de store AI-selskapene presser på for regulering fordi dette tvinger mindre aktører og open source-miljøet ut av ringen, slik at de kan opprettholde sin dominans over bransjen.

AIs dobbeltbruksproblematikk

En annen kompleks faktor er AIs doble eller multiple bruksområder.

De samme algoritmene som kan forbedre livskvaliteten vår, kan også brukes som våpen eller i militære sammenhenger. Dette kan være akilleshælen i EU AI Act's heuristiske rammeverk - hvordan tolker man nyttig AI som kan modifiseres for å gjøre skade?

Regulering av teknologi med dobbelt bruk er som kjent svært komplisert. Streng kontroll kan kvele innovasjon og økonomisk vekst når bare et lite mindretall misbruker en AI-teknologi.

AI-selskaper kan omgå skyld ved å lage retningslinjer mot misbruk, men det hindrer ikke folk i å bruke "jailbreaks' for å lure modeller til å sende ut ulovlig materiale.

Balanse mellom økonomiske fordeler og etiske hensyn ved kunstig intelligens

Fordelene med kunstig intelligens er økonomisk overbevisende, særlig innen sektorer som helse, energi og produksjon.

Rapporter av McKinsey og PwC spår at kunstig intelligens vil bidra med billioner av kroner til verdensøkonomien hvert år, uavhengig av virkningen av nyansettelser og oppsigelser.

Kunstig intelligens kan ses på som en vei til jobbskaping og vekst for land som sliter med økonomiske problemer.

På et bredere filosofisk plan blir kunstig intelligens noen ganger fremstilt som menneskehetens redningsmann i møte med makroproblemer som fattigdom, klimaendringer og aldrende befolkninger.

Vestlige myndigheter - særlig i USA og Storbritannia - ser ut til å være tilbøyelige til å fremme vekst gjennom skatteinsentiver, finansiering av AI-forskning og en laissez-faire-tilnærming til regelverket.

Dette er et sjansespill USA har tatt tidligere ved å la teknologibransjen regulere seg selv, men kan det fortsette å lønne seg?

WKan dommedagsprofetier som sammenligner kunstig intelligens med "atomkrig" og "globale pandemier" sette en stopper for romantiserte forestillinger om teknologiens potensial til å løfte menneskeheten ut av stadig større globale problemer?

AI representerer en viss dobbelthet som fremkaller både eutopiske og dystopiske fremtidsvisjoner, avhengig av hvem man lytter til.

Reguleringen av en slik enhet er en utfordring uten sidestykke.

Uansett vil vi innen utgangen av 2024 sannsynligvis leve i en verden der AI er nesten universelt regulert, men det ingen kan svare på, er hvor mye bransjen - og selve teknologien - vil ha utviklet seg innen den tid.