AI-selskaper presser på for regulering. Er motivasjonen deres paranoia eller altruisme? Eller sikrer regulering konkurransemessige mål?

I begynnelsen av mai skrev Luke Sernau, en senior programvareingeniør hos Google, et uformelt notat om AI med åpen kildekode. Det ble spredt på Googles interne systemer før konsulentselskapet Semi-Analysis, verifisert og publisert den.

Her er noen utdrag:

"Vi har sett oss mye over skulderen i OpenAI. Hvem kommer til å passere neste milepæl? Hva blir det neste trekket?

Men den ubehagelige sannheten er at vi ikke er i posisjon til å vinne dette våpenkappløpet, og det er heller ikke OpenAI. Mens vi har kranglet, har en tredje fraksjon i det stille spist lunsjen vår. Jeg snakker selvfølgelig om åpen kildekode.

De er rett og slett i ferd med å overkjøre oss. Ting vi anser som "store åpne problemer", er løst og i folks hender i dag. Selv om våre modeller fortsatt har et lite forsprang når det gjelder kvalitet, blir avstanden forbausende raskt mindre.

Modeller med åpen kildekode er raskere, mer tilpasningsdyktige, mer private og mer effektive. De gjør ting med $100 og 13B-parametere som vi sliter med på $10M og 540B. Og de gjør det på uker, ikke måneder.

I begynnelsen av mars fikk open source-fellesskapet sin første virkelig kapable grunnmodell i hendene, da Metas LLaMA ble lekket til offentligheten.

Den hadde ingen instruksjon eller samtaleinnstilling, og ingen RLHF. Likevel forsto samfunnet umiddelbart betydningen av det de hadde fått. En enorm strøm av innovasjon fulgte, og det gikk bare noen dager mellom de store utviklingene...

Her er vi, knapt en måned senere, og det finnes varianter med instruksjonsjustering, kvantisering, kvalitetsforbedringer, menneskelige evalueringer, multimodalitet, RLHF, etc., etc., hvorav mange bygger på hverandre. Viktigst av alt er at de har løst skaleringsproblemet i den grad at hvem som helst kan flikke på det.

Mange av de nye ideene kommer fra vanlige folk. Inngangsbarrieren for opplæring og eksperimentering har sunket fra den totale produksjonen til en stor forskningsorganisasjon til én person, en kveld og en kraftig bærbar datamaskin."

Sernaus notat ble plukket opp av store nyhetsbyråer og utløste en debatt om hvorvidt big tech-teknologiens press for regulering skjuler et motiv for å tvinge AI med åpen kildekode ut av spillet. Ben Schrekcinger fra Politico skriver"Åpen kildekode er også vanskeligere å forby, siden nye instanser kan dukke opp hvis myndighetene forsøker å stenge et nettsted eller et verktøy som bruker den. Kombinert med andre desentraliserende funksjoner har disse åpen kildekode-prosjektene potensial til å forstyrre ikke bare Silicon Valleys forretningsmodell, men også styringsmodellene i Washington og Brussel."

Open source-miljøet for kunstig intelligens blomstrer allerede. Utviklere løser utfordringer på få dager som det tar Google og OpenAI måneder eller år å løse. Sernau hevder at smidige miljøer med åpen kildekode-utviklere er bedre rustet til å bygge iterative modeller enn big tech, ettersom de er mer mangfoldige, effektive og pragmatiske.

Hvis dette er tilfelle, kan big tech-teknologiens dominans over AI bli kortvarig.

Meta LLaMA-lekkasjen

Metas LLaMA-modell, en stor språkmodell (LLM) i likhet med ChatGPT, ble lekket på 4chan en uke etter at selskapet sendte ut innsynsbegjæringer. Den 3. mars dukket det opp en nedlastbar torrent på meldingsforumet, og den spredte seg som ild i tørt gress.

Som Sernau påpeker, fortsatte open source-fellesskapet med å modifisere LLaMA, og la til imponerende funksjonalitet uten bruk av bedriftens dataressurser.

Det er billigere enn noensinne å bygge kraftige AI-modeller, og åpen kildekode-miljøer presser på for å demokratisere tilgangen. Mens LLaMA i stor grad er en ferdig trent modell, er andre modeller med åpen kildekode, som BLOOM, trent opp av frivillige.

Opplæringen av BLOOM krevde en superdatamaskin utstyrt med 384 NVIDIA A100 80 GB GPU-er, som heldigvis ble donert av den franske regjeringen. Open source AI-selskapet Together kunngjorde nylig $20 millioner i såkornfinansiering, og AI-fokuserte skyleverandører som CoreWeave tilby maskinvare under markedspris.

Åpen kildekode-prosjekter har ulike måter å fokusere ressurser på og utkonkurrere de store teknologiene på. Big tech vil nok gjerne at vi skal tro at deres AI-er er et produkt av flere tiår med arbeid og milliarder av dollar i investeringer - er åpen kildekode-samfunnet sannsynligvis uenig.

På et arrangement i India spurte den tidligere Google-sjefen Rajan Anandan OpenAI-sjef Sam Altman om indiske ingeniører kunne bygge grunnleggende AI-modeller med en investering på $10 millioner kroner.

Altman svarte: "Det er helt håpløst å konkurrere med oss på trening av grunnmodeller. Du bør ikke prøve, og det er din jobb å like å prøve uansett. Og jeg tror på begge disse tingene. Jeg tror det er ganske håpløst."

Men i notatet sitt uttrykker Sernau at åpen kildekode allerede konkurrerer med big tech. Han sier: "Det blir enda vanskeligere å beholde et konkurransefortrinn innen teknologi nå som det er rimelig å drive med banebrytende forskning innen LLM. Forskningsinstitusjoner over hele verden bygger på hverandres arbeid og utforsker løsningsrommet på en måte som langt overgår vår egen kapasitet."

Open source-utviklere bygger alternativer til de store teknologiselskapenes AI-er og går forbi dem når det gjelder ytelse og brukerstatistikk.

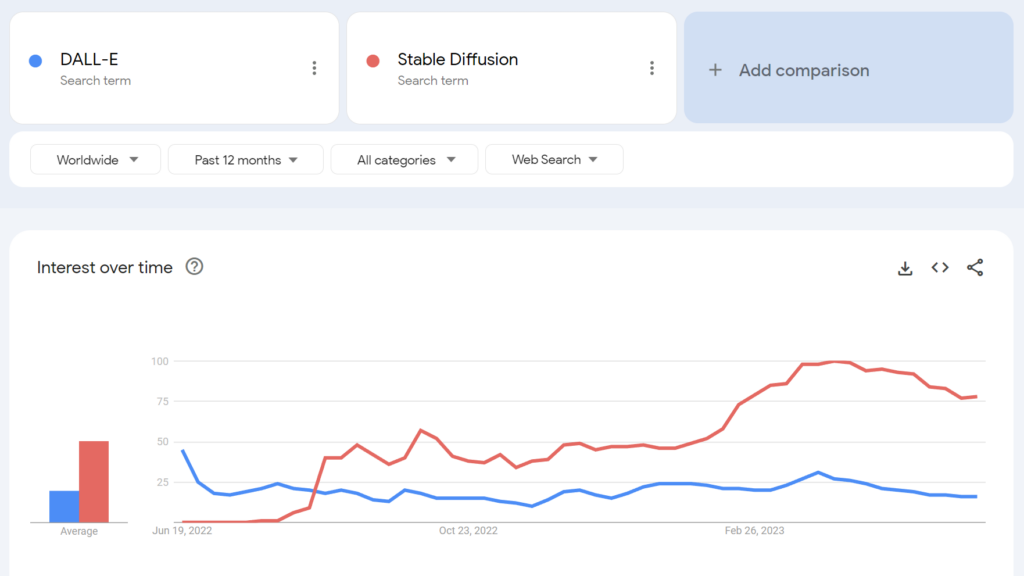

For eksempel ble Stable Diffusion med åpen kildekode mer populær enn OpenAIs DALL-E i løpet av noen måneder etter lanseringen.

I hvilken grad kan vi lirke fra hverandre potensielle baktanker her? Har big tech-bransjens regulatoriske fremstøt noen altruistisk verdi?

AI-fellesskapet med åpen kildekode

I tillegg til LLaMA finnes det minst tre større eksempler på AI-prosjekter med åpen kildekode:

- Hugging Face & BLOOM - AI-firmaet Hugging Face har samarbeidet med over 1 000 frivillige forskere om å utvikle BLOOM, en LLM med åpen kildekode. BLOOM har som mål å tilby et mer transparent og tilgjengelig motstykke til proprietære AI-modeller.

- Sammen - En AI-oppstartsbedrift ved navn Together har samlet inn $20 millioner i såkornfinansiering for å støtte målet sitt om å bygge desentraliserte alternativer til lukkede AI-systemer. De presenterte flere generative AI-initiativer med åpen kildekode, inkludert GPT-JT, OpenChatKit og RedPajama.

- Stabilitet AI - I april 2023 lanserte Stability AI, selskapet bak Stable Diffusion, StableLM, en serie åpen kildekode-alternativer til ChatGPT.

Det er verdt å merke seg at mens noen av disse utviklerne (f.eks. Stable Diffusion) tilbyr modellene sine via intuitive, brukervennlige dashbord, krever andre, som BLOOM, betydelige ressurser for å kjøre. For det første trenger du rundt 360 GB RAM for å kjøre BLOOM, men det finnes mange smarte triks for å få ned ressurskravene.

Etter hvert som AI-kompatibel maskinvare faller i pris og åpen kildekode-modeller blir enklere å distribuere, er det fullt mulig at praktisk talt hvem som helst kan distribuere modeller som ligner på ChatGPT. Google-notatlekkasjen siterer eksempler på folk som har finjustert og tatt i bruk LLaMA på forbrukerenheter, inkludert en MacBook.

For virksomheter med betydelige IT-ressurser, modeller med åpen kildekode sparer penger og gir datasuverenitet og kontroll over opplæring og optimalisering.

Det er imidlertid ikke alle som er optimistiske når det gjelder virkningen av kraftig AI med åpen kildekode. For eksempel twitret cybersikkerhetsforskeren Jeffrey Ladis: "Gjør deg klar for massevis av personlig tilpasset spam og phishing-forsøk", og "Det var en forferdelig idé å åpne disse modellene".

Spredning av kunstig intelligens gjør oss alle mindre trygge. Det virker som en god ting å forhindre, og også som en ganske vanskelig utfordring!

Jeg ville ikke bli så overrasket om en statlig aktør klarte å få tak i OpenAIs frontier-modeller i løpet av det neste året eller to https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10. mai 2023

En annen observatør twitret: "Åpen kildekode er en trussel, men ikke på den måten du tror. Det er en trussel fordi AI i hendene på folk som kan bruke det til sine egne formål, blir enda vanskeligere å regulere eller holde oversikt over, og det er et større problem."

Google og OpenAI hevder at de er redde for åpen kildekode-AI, at det er "ingen vollgrav" mellom dem alle. Men det er egentlig ikke sant.

Åpen kildekode er en trussel, men ikke på den måten du tror. Det er en trussel fordi AI i hendene på folk som kan bruke den til sine egne formål, blir enda vanskeligere å ... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5. mai 2023

Yann LeCun, som ofte regnes som en "AI-gudfar" sammen med Geoffrey Hinton og Yoshio Bengman, hevder det motsatte"Når LLM blir hovedkanalen som alle får tilgang til informasjon gjennom, vil folk (og myndigheter) *kreve* at den er åpen og transparent. Grunnleggende infrastruktur må være åpen."

LeCun tok også avstand fra mainstream-fortellinger om AI-risikoer: "Jeg tror at omfanget av AI-tilpasningsproblemet har blitt latterlig overdrevet og vår evne til å løse det i stor grad undervurdert." Elon Musk slo tilbake i Twitter-tråden og sa: "Tror du virkelig at AI er et enegget sverd?"

Tror du virkelig at AI er et enegget sverd?

- Elon Musk (@elonmusk) 1. april 2023

Andre kommentatorer trakk paralleller mellom AI-regulering og kryptografi, der amerikanske myndigheter forsøkte å forby offentlige kryptografiske metoder ved å å klassifisere dem som "ammunisjon" - kalt "Kryptokrigen".

Nå har praktisk talt alle rett til å bruke kryptering, men den kampen var vanskelig å vinne - noe som også kan være tilfelle med AI med åpen kildekode.

OpenAIs fremmedgjøring av åpen kildekode-AI

Åpen kildekode er mer enn bare programvare, kode og teknologi. Det er prinsippet, tankesettet eller troen på at et samarbeidende, åpent og transparent arbeidsmiljø overgår konkurranse i et lukket marked.

OpenAI, som en gang var et non-profit-selskap med fokus på offentlig samarbeid og utvikling av åpen kildekode, har stadig fjernet seg fra sitt navnesøster.

Oppstartsselskapet gikk over til å bli et "for-profit"-selskap i 2019, noe som i praksis avsluttet selskapets forhold til open source-fellesskapet. Investeringen fra Microsoft gjorde at OpenAI ikke lenger var involvert i noen form for "åpen" FoU-virksomhet.

I midten av mai kunngjorde selskapet en åpen kildekode-modell i pipelinemen de har ikke vært ærlige med detaljene.

Nå presser OpenAI på for en regulering som vil ramme nye AI-selskaper hardest, for ikke å snakke om en potensiell kriminalisering av open source-fellesskapet.

Dette har fått enkelte til å kritisere OpenAIs krav om regulering som ren forretningsvirksomhet - for å beskytte sine lønnsomme modeller mot åpen kildekode-miljøer som ønsker å demokratisere AI.

Er AI med åpen kildekode en risiko for big tech?

Kombinasjonen av Googles lekkede notat, big tech-bransjens press for regulering og Altmans nedvurdering av AI-prosjekter på grasrotnivå får noen til å heve øyenbrynene. Det har faktisk blitt stilt spørsmål ved legitimiteten til risikoen ved kunstig intelligens - som rettferdiggjør regulering.

Da Center for AI Safety (CAIS) publiserte en uttalelse om AI-risiko, som var medundertegnet av flere AI-sjefer, var det for eksempel noen eksterne observatører som ikke var overbevist.

I et utvalg av ekspertreaksjoner på uttalelsen utgitt av Science Media CentreDr. Mhairi Aitken, etikkforsker ved Alan Turing Institute, sier

"I det siste har disse påstandene i økende grad kommet fra store teknologiaktører, hovedsakelig i Silicon Valley. Noen antyder at det skyldes at de er klar over fremskrittene innen teknologien, men jeg tror det faktisk fungerer som en avledningsmanøver. Det avleder oppmerksomheten fra beslutningene til de store teknologiaktørene (personer og organisasjoner) som utvikler AI og driver innovasjonen på dette feltet, og retter i stedet oppmerksomheten mot hypotetiske fremtidsscenarioer og forestilte fremtidige kapasiteter for AI."

Noen hevder at de store teknologibedriftene har nok ressurser til å sette av ressurser til etikk, styring og overvåking, slik at de kan riste av seg de verste reguleringene og fortsette å selge produktene sine.

Samtidig er det problematisk å avfeie AI-risikoer som fantasier og hevde at det ikke er noen verdi i regulering.

Det finnes skeptikere i begge leire

Å avfeie AI-risikoer som rent spekulative kan vise seg å være en kritisk feil for menneskeheten.

Faktisk har kommentatorer uten interessekonflikter advart mot kunstig intelligens i flere tiår, inkludert avdøde professor Stephen Hawking, som sa at kunstig intelligens "kan bety slutten for menneskeheten" og være "den verste hendelsen i vår sivilisasjons historie".

Selv om noen vil hevde at big tech bruker visjoner om en AI-apokalypse til å forsterke markedsstrukturer og øke etableringshindringene, overskygger ikke det legitimiteten til AI-risikoen.

For eksempel har AI-forskerteam allerede bevist AIs evne til å autonomt etablere nye mål med potensielt katastrofale konsekvenser.

Andre eksperimenter viser at AI-er aktivt kan samle inn ressurser, akkumulere kraft og ta proaktive skritt for å forhindre at de blir "slått av". Troverdige studier tyder på at i det minste noen av AI-risikoene ikke er overdrevet.

Kompatible synspunkter?

Spørsmålet er om vi kan stole på oss selv med eksepsjonelt kraftig AI. Med "oss selv" menes mennesker overalt, på alle nivåer, fra store teknologiske forskningslaboratorier til miljøene som bygger AI med åpen kildekode.

Big tech ønsker kanskje å konsolidere markedsstrukturene, samtidig som de ønsker å fremme en genuin bekymring for AIs fremtid. De to er ikke nødvendigvis gjensidig utelukkende.

I mellomtiden er fremveksten av AI med åpen kildekode uunngåelig, og regulering risikerer å skape misnøye i et samfunn som eier en av menneskehetens farligste teknologier.

Det er allerede for sent å underlegge seg åpen kildekode-AI gjennom regulering, og forsøk på å gjøre det kan føre til en destruktiv æra med AI-forbud.

Samtidig bør diskusjonene om farene ved kunstig intelligens styres av bevisene - det eneste objektive signalet vi har om teknologiens skadepotensial.