Etter hvert som kunstig intelligens fortsetter å gjøre sitt inntog i rekrutteringsprosessene, er det klart at teknologiens løfte om effektivitet kommer med sine egne risikoer.

Ifølge 2022-databruker allerede 55% av selskapene AI-verktøy til rekruttering.

Selv om kunstig intelligens har fremskyndet tradisjonell ansettelsespraksis og eliminert hauger av CV-er og CV-er i prosessen, har den også reist kritiske spørsmål om rettferdighet, forutinntatthet og selve naturen til menneskelig beslutningstaking.

AI-er er tross alt opplært på menneskelige data, så de kan arve alle de skjevhetene og fordommene de lover å utslette.

Er dette noe vi kan endre på? Hva har vi lært av AI-rekruttering så langt?

Meta anklages for diskriminerende annonsepraksis av menneskerettighetsgrupper

Data viser at noen 79% av arbeidssøkere bruker sosiale medier til å søke jobb, og mye tyder på at det er her diskrimineringen begynner.

Meta er for tiden står overfor flere anklager fra europeiske menneskerettighetsorganisasjoner som hevder at Facebooks algoritme for målretting av stillingsannonser er partisk.

I juni ble den frivillige organisasjonen Global Witness undersøkte flere automatisk målrettede stillingsannonser på Facebook og fant ut at mange av dem opprettholdt kjønnsskjevheter.

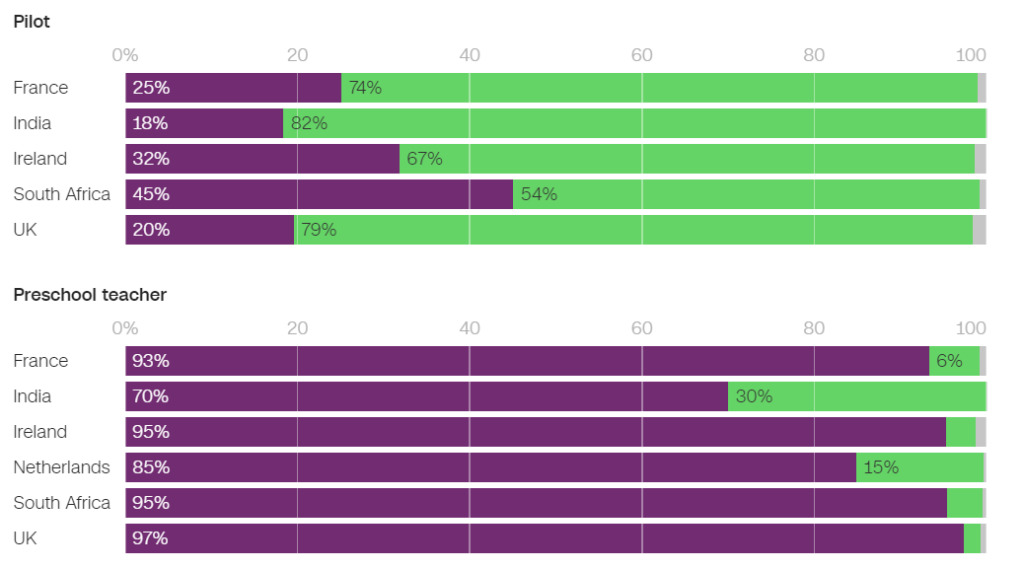

For eksempel var det betydelig større sannsynlighet for at menn ble vist annonser relatert til ingeniørfag, mens det var betydelig større sannsynlighet for at kvinner ble vist annonser relatert til undervisning.

Av annonsene som ble vist i Frankrike, var 93% av brukerne som fikk se en stillingsannonse for førskolelærere, og 86% av dem som fikk se en stillingsannonse for psykologer, kvinner. Motsatt var det bare 25% av kvinnene som fikk se en pilotannonse, og bare 6% som fikk se en mekanikerannonse.

I Nederland var 85% av brukerne som ble vist en stillingsannonse for lærere, og 96% av dem som ble vist en stillingsannonse for resepsjonister, kvinner. Lignende resultater ble observert i mange andre land, blant annet Storbritannia, India og Sør-Afrika.

I en intervju med CNN"Vår bekymring er at Facebook forsterker fordommene i samfunnet og faktisk ødelegger mulighetene for fremgang og likeverd på arbeidsplassen", sier Naomi Hirst fra Global Witness.

Sammen med Bureau Clara Wichmann og Fondation des Femmes har Global Witness klaget Meta inn for menneskerettighets- og personvernmyndigheter i Frankrike og Nederland.

Gruppene oppfordrer til en etterforskning av hvorvidt Metas praksis bryter med menneskerettighetene eller personvernlovene. Hvis anklagene holder, kan Meta bli ilagt bøter og sanksjoner.

En talsperson for Meta svarte: "Systemet tar hensyn til ulike typer informasjon for å prøve å vise folk annonser de vil være mest interessert i."

Dette er ikke første gang Meta har slått bort slik kritikk - selskapet møtte flere søksmål i 2019 og forpliktet seg til å endre annonseleveringssystemet for å unngå skjevheter basert på beskyttede egenskaper som kjønn og rase.

Pat de Brún fra Amnesty International var kritisk til Global Witness' funn. "Forskning viser konsekvent hvordan Facebooks algoritmer gir svært ulike resultater og ofte forsterker marginalisering og diskriminering", sier hun til CNN.

Amazon skroter hemmelig AI-rekrutteringsverktøy som viste skjevhet mot kvinner

Amazon utviklet et AI-rekrutteringsverktøy mellom 2014 og 2017, før de innså at verktøyet var partisk i utvelgelsen av programvareutviklerjobber og andre tekniske stillinger. I 2018 hadde Amazon droppet verktøyet helt.

AI-systemet straffet CV-er som inneholdt ordet "kvinner" og "kvinners", og nedgraderte ferdighetene til kvinnelige nyutdannede.

Systemet mislyktes selv etter at Amazon forsøkte å redigere algoritmene for å gjøre dem kjønnsnøytrale.

Det viste seg senere at Amazon hadde trent verktøyet på CV-er som ble sendt inn til selskapet over en tiårsperiode, og de fleste av disse kom fra menn.

I likhet med mange andre AI-systemer ble Amazons verktøy påvirket av dataene det ble trent på, noe som førte til utilsiktede skjevheter. Denne skjevheten favoriserte mannlige kandidater og foretrakk CV-er som brukte et språk som var mer vanlig å finne i mannlige ingeniørers CV-er.

På grunn av problemer med de underliggende dataene anbefalte systemet dessuten ofte ukvalifiserte kandidater til ulike jobber.

Den Verdens økonomiske forum om Amazons rekrutteringssystem: "For eksempel - som i Amazons tilfelle - kan sterk kjønnsubalanse ha sammenheng med hvilken type studie som er gjennomført. Disse skjevhetene i treningsdataene kan også oppstå på grunn av dårlig datakvalitet eller svært små, ikke-mangfoldige datasett, noe som kan være tilfelle for selskaper som ikke opererer globalt og søker etter nisjekandidater."

Amazon klarte å gjenbruke en "utvannet versjon" av rekrutteringsmotoren til rudimentære oppgaver, som å eliminere dupliserte kandidatprofiler fra databaser.

De opprettet et nytt team for å gjøre et nytt forsøk med automatisert screening, denne gangen med fokus på å fremme mangfold.

Google kjemper mot sine egne problemer med diskriminering og fordommer

I desember 2020 kunngjorde Dr. Timnit Gebru, en ledende AI-etiker hos Google, at den selskapet hadde gitt henne sparken.

Oppsigelsen kom etter at Dr. Gebru uttrykte bekymring for Googles tilnærming til ansettelse av minoriteter og iboende skjevheter i AI-systemer.

Før han forlot selskapet, skulle Gebru publisere en artikkel som belyste skjevheter i Googles AI-modeller.

Etter å ha sendt inn artikkelen til en akademisk konferanse, avslørte Gebru at en Google-leder ba henne om å trekke tilbake artikkelen eller fjerne navnene på seg selv og de andre Google-forskerne. Da hun nektet å etterkomme dette, aksepterte Google et betinget forslag om avskjed, noe som i praksis innebar at Gebru sa opp stillingen sin umiddelbart.

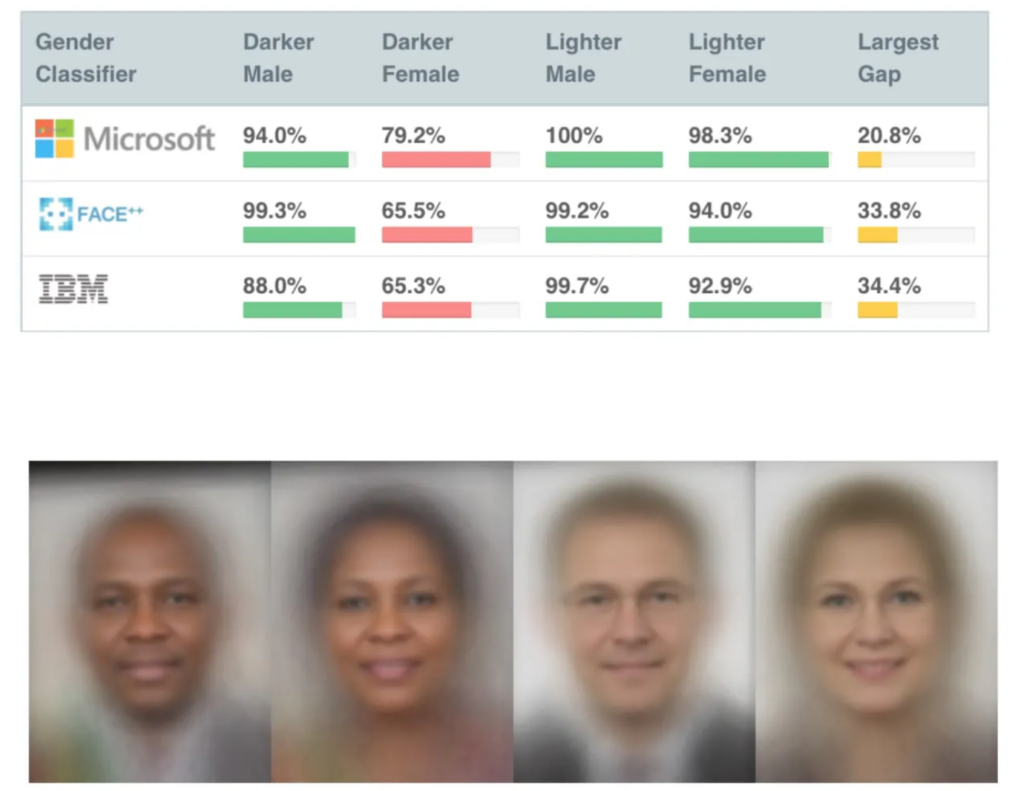

Dette var ikke lenge etter at flere innflytelsesrike studier om AI-skjevhet ble publisert, blant annet MITs Gender Shades-studiesom har blitt en av de mest siterte AI-artiklene gjennom tidene.

Gender Shades-studien avdekket skjevheter i ansiktsgjenkjennings-AI, som feilidentifiserte svarte ansikter omtrent 30% til 35% av tiden, sammenlignet med rundt 5% for hvite ansikter.

Feilaktig ansiktsgjenkjenning førte til urettmessig arrestasjon og fengsling av flere menn i USA.

Gebrus avskjedigelse utløste en mediestorm rundt diskriminerende praksis i Silicon Valley.

Mutale Nkonde fra Stanford Digital Civil Society Lab sa: "Avskjedigelsen av henne viser bare at forskere, aktivister og akademikere som ønsker å jobbe på dette feltet - og som er svarte kvinner - ikke er velkomne i Silicon Valley."

Dr. Gebru's avskjedigelse inspirerte til en annen studie, Avmaskering av kodede fordommersom viste at det var betydelig større sannsynlighet for at svarte ble undervurdert av AI i rekrutteringsarbeidet enn andre.

"Denne rapporten viser at det er mye som tyder på at svarte studenter og fagfolk er bekymret for å bli utsatt for fordommer mot svarte i ansettelsesprosessen. Litt over halvparten av alle respondentene oppgir at de har observert fordommer i ansettelses- eller rekrutteringsprosessen på ansettelses- eller rekrutteringsnettsteder. Det er litt mer sannsynlig at svarte fagpersoner har observert slike fordommer, med 55 prosent av respondentene som oppgir at de har observert fordommer i ansettelsesprosessen", - Avmaskering av kodede fordommer, Penn Law Policy Lab.

I artikkelen står det: "Den offentlige samtalen som Gebru og kollegene hennes ansporet til om algoritmiske skjevheter, gjorde det mulig for laboratoriet vårt å delta i denne nasjonale dialogen og utvide en mer nyansert forståelse av algoritmiske skjevheter i ansettelsesplattformer."

Avsløringen av problemet har vært en katalysator for endring, men AI har en lang vei å gå for å forene sin rolle i sensitive menneskelige beslutningsprosesser.

AIs rolle i rekruttering: noen positive sider ved rekruttering

Til tross for mange kontroverser har det vært vanskelig for bedrifter å motstå AIs enorme potensial for å fremskynde rekruttering.

AIs rolle i rekrutteringsarbeidet gir absolutt logisk mening - det er kanskje lettere å fjerne fordommer fra AI enn fra mennesker. AI er tross alt *bare* matematikk og kode - og det er vel mer formbart enn dypt forankrede ubevisste fordommer?

Og selv om opplæringsdataene var svært skjeve på begynnelsen og midten av 2010-tallet, først og fremst på grunn av mangel på ulike datasett, har dette blitt bedre siden den gang.

Et fremtredende AI-rekrutteringsverktøy er SapiaSapia er en "smart intervjuer". Ifølge Sapias grunnlegger, Barb Hyman, muliggjør kunstig intelligens en "blind" intervjuprosess som ikke baserer seg på CV-er, sosiale medier eller demografiske data, men utelukkende på søkerens svar, og som dermed eliminerer skjevheter som er utbredt i menneskestyrte ansettelser.

Disse systemene kan gi alle en rettferdig sjanse ved å intervjue alle søkere. Hyman foreslår"Det er dobbelt så stor sannsynlighet for at du får kvinner og beholder kvinner i ansettelsesprosessen når du bruker AI."

Men selv selve prosessen med å intervjue noen med AI reiser spørsmål.

NLP-modeller (Natural Language Processing) er vanligvis først og fremst trent på engelskspråklige tekster, noe som betyr at de er dårlig til å håndtere fremmedspråklige.

Disse systemene kan utilsiktet straffe personer som ikke har engelsk som morsmål, eller personer med andre kulturelle særtrekk. Kritikerne hevder dessuten at det kanskje ikke tas tilstrekkelig hensyn til funksjonshemminger i en AI-chat eller et videointervju, noe som kan føre til ytterligere potensiell diskriminering.

Dette forverres av at søkerne ofte ikke vet om de blir vurdert av en AI, noe som gjør det umulig å be om nødvendige justeringer i intervjuprosessen.

Datasett er grunnleggende

Datasett er grunnleggende her. Tren en AI på ti år gamle data, og den lærer seg ti år gamle verdier.

Arbeidsmarkedet har blitt betydelig mer mangfoldig siden årtusenskiftet.

I noen land er det for eksempel flere kvinner enn menn i flere viktige medisinske fagområder, som psykologi, genetikk, pediatri og immunologi.

I Storbritannia, en rapport fra 2023 fant at 27% av de sysselsatte kvinnene jobbet i "profesjonelle yrker" (som leger, ingeniører, sykepleiere, regnskapsførere, lærere og advokater) sammenlignet med 26% av mennene, en trend som har økt jevnt i løpet av fem til ti år.

Slike overganger har akselerert de siste to til fem årene - mange datasett er eldre og gjenspeiler rett og slett ikke nyere data. Det samme gjelder for rase og funksjonsnedsettelser som for kjønn.

Datasettene må gjenspeile de stadig mer mangfoldige arbeidsplassene våre, slik at alle kan få en rettferdig behandling.

Selv om det fortsatt gjenstår mye arbeid for å sikre mangfold på arbeidsplassen, må kunstig intelligens arve verdier fra nåtiden og ikke fra fortiden. Det bør være et minimumskrav for å skape rettferdige og transparente AI-rekrutteringssystemer.

Utviklerne av AI for rekruttering står sannsynligvis overfor strenge reguleringer, med USA, Storbritannia, Kina, EU-landene og mange andre land som vil skjerpe AI-kontrollene i løpet av de kommende årene.

Forskning pågår, men det er fortsatt lite sannsynlig at de fleste AI-er som rekrutterer, følger de rettferdige og objektive prinsippene vi forventer av hverandre.