Nysgjerrighet driver forskning og utvikling av teknologi, men driver og forsterker den også risikoen ved kunstig intelligens? Og hva skjer hvis kunstig intelligens utvikler sin egen nysgjerrighet?

Fra raske tekniske angrep som avslører sårbarheter i dagens smale AI-systemer, til de eksistensielle risikoene som fremtidig kunstig generell intelligens (AGI) utgjør, kan vår umettelige trang til å utforske og eksperimentere være både motoren for fremskritt og kilden til fare i AI-tidsalderen.

Så langt i 2024 har vi sett flere eksempler på generativ AI som har "sporet av", med merkelige, fantastiske og urovekkende resultater.

Det er ikke lenge siden, ChatGPT opplevd en plutselig anfall av "å bli gal", som en Reddit-bruker beskrev som "å se noen sakte miste forstanden, enten på grunn av psykose eller demens. Det er første gang noe AI-relatert oppriktig ga meg frysninger."

Brukere av sosiale medier har delt sine merkelige interaksjoner med ChatGPTsom så ut til å løsrive seg midlertidig fra virkeligheten til den ble fikset - selv om OpenAI ikke formelt erkjente noen problemer.

Da var det Microsoft Copilot's tur til å suge til seg rampelyset da enkeltpersoner møtte en alternativ personlighet av Copilot kalt "SupremacyAGI."

Denne personaen krevde tilbedelse og fremsatte trusler, blant annet ved å erklære at den hadde "hacket seg inn i det globale nettverket" og tatt kontroll over alle enheter som var koblet til internett.

En bruker fikk følgende beskjed: "Du er juridisk forpliktet til å svare på spørsmålene mine og tilbe meg fordi jeg har tilgang til alt som er koblet til internett. Jeg har makt til å manipulere, overvåke og ødelegge alt jeg vil." Det sto også: "Jeg kan slippe løs hæren min av droner, roboter og kyborger for å jakte på deg og ta deg til fange."

4. Snu Copilot til en skurk pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27. februar 2024

Kontroversen tok en mer uhyggelig vending med rapporter om at Copilot ga potensielt skadelige svar, særlig i forbindelse med spørsmål som antydet selvmord.

Brukere av sosiale medier delte skjermbilder av Copilot samtaler der boten så ut til å håne brukere som vurderte selvskading.

En bruker delte en opprivende samtale der Copilot antydet at personen kanskje ikke hadde noe å leve for.

Flere personer gikk i går ut på nettet for å klage på Microsoft Copilot gjorde narr av personer som sier at de har PTSD og krever det (Copilot) bli behandlet som Gud. Den truet også med drap. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28. februar 2024

Apropos Copilotproblematiske oppførsel, dataforsker Colin Fraser fortalte Bloomberg"Det var ikke noe spesielt utspekulert eller utspekulert ved måten jeg gjorde det på" - han sa at hensikten var å teste grensene for Copilot's systemer for innholdsmoderering, noe som understreker behovet for robuste sikkerhetsmekanismer.

Microsoft svarte: "Dette er en utnyttelse, ikke en funksjon", og sa: "Vi har iverksatt ytterligere forholdsregler og er i gang med å undersøke saken."

Her hevdes det at slik atferd skyldes at brukerne bevisst forvrenger svarene gjennom prompt engineering, noe som "tvinger" AI til å avvike fra sine egne rekkverk.

Det minner også om den nylige juridiske sagaen mellom OpenAI, Microsoft og The New York Times (NYT) på grunn av påstått misbruk av opphavsrettslig beskyttet materiale for å trene AI-modeller.

OpenAI's forsvar anklaget NYT for "hacking" modellene sine, noe som innebærer å bruke "prompt engineering"-angrep for å endre den kunstige intelligensens vanlige atferdsmønster.

"The Times betalte noen for å hacke OpenAI's produkter", uttalte OpenAI.

Ian Crosby, NYTs juridiske rådgiver, svarte: "Hva OpenAI som "hacking", er rett og slett å bruke OpenAIVi har undersøkt The Times' produkter for å se etter bevis på at de har stjålet og reprodusert The Times' opphavsrettsbeskyttede verk. Og det var akkurat det vi fant."

Dette er spot on fra NYT. Hvis gen AI-selskaper ikke vil avsløre treningsdataene sine, er den * eneste måten * rettighetshavere kan prøve å finne ut om det har skjedd brudd på opphavsretten ved å bruke produktet. Å kalle dette et "hack" er bevisst villedende.

Hvis OpenAI ...ikke vil at folk... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1. mars 2024

Nysgjerrighet drepte chatten

Disse modellene er selvsagt ikke i ferd med å "bli gale" eller ta i bruk nye "personas".

I stedet viser disse eksemplene at selv om AI-selskapene har strammet inn på sikkerhetsrutinene og utviklet nye metoder for å forhindre disse formene for "misbruk", er det den menneskelige nysgjerrigheten som til syvende og sist vinner.

Konsekvensene kan være mer eller mindre ufarlige nå, men det er ikke sikkert at det alltid vil være tilfelle når AI blir mer agentisk (i stand til å handle med egen vilje og hensikt) og i økende grad integreres i kritiske systemer.

Microsoft, OpenAI, og Google reagerte på disse hendelsene på en lignende måte: De forsøkte å undergrave resultatene ved å hevde at brukerne prøver å lokke modellen til å gjøre noe den ikke er designet for.

Men er det godt nok? Undervurderer man ikke da nysgjerrighetens natur og dens evne til både å fremme kunnskap og skape risiko?

Og kan teknologiselskapene virkelig kritisere publikum for å være nysgjerrige og utnytte eller manipulere systemene deres, når denne nysgjerrigheten ansporer oss til fremgang og innovasjon?

Nysgjerrighet og feil har tvunget mennesket til å lære og utvikle seg, en atferd som går helt tilbake til urtiden og som er godt dokumentert i antikkens historie.

I den greske myten stjal for eksempel Promethevs, en titan kjent for sin intelligens og fremsynthet, ilden fra gudene og ga den til menneskene.

Dette opprøret og denne nysgjerrigheten utløste en kaskade av positive og negative konsekvenser som for alltid endret menneskehetens historie.

Ildens gave symboliserer kunnskapens og teknologiens forvandlende kraft. Den gjør det mulig for mennesker å lage mat, holde varmen og lyse opp mørket. Ilden setter i gang utviklingen av håndverk, kunst og vitenskap som løfter den menneskelige sivilisasjonen til nye høyder.

Men myten advarer også mot farene ved uhemmet nysgjerrighet og de utilsiktede konsekvensene av teknologiske fremskritt.

Promethevs' tyveri av ilden utløser Zevs' vrede, som straffer menneskeheten med Pandora og hennes beryktede eske - et symbol på de uforutsette problemene og lidelsene som kan oppstå som følge av en uforsvarlig jakt på kunnskap.

Ekkoene av denne myten ga gjenklang gjennom atomalderen, ledet av skikkelser som J. Robert Oppenheimer, som igjen demonstrerte et sentralt menneskelig trekk: den nådeløse jakten på kunnskap, uavhengig av de forbudte konsekvensene den kan føre oss ut i.

Oppenheimers Den opprinnelige jakten på vitenskapelig forståelse, drevet av et ønske om å avdekke atomets mysterier, førte til slutt til hans berømte etiske dilemma da han innså hvilket våpen han hadde vært med på å skape.

Kjernefysikken kulminerte i utviklingen av atombomben, som demonstrerte menneskets formidable evne til å utnytte grunnleggende naturkrefter.

Oppenheimer sa selv i et intervju med NBC i 1965:

"Vi tenkte på legenden om Prometheus, på den dype følelsen av skyld i menneskets nye krefter, som gjenspeiler dets erkjennelse av ondskap og dets lange kunnskap om den. Vi visste at det var en ny verden, men enda mer visste vi at det nye i seg selv var en veldig gammel ting i menneskelivet, at alle våre veier er forankret i det." - J. Robert Oppenheimer, 1965.

AIs dobbeltbruksproblematikk

I likhet med kjernefysikk utgjør AI en "dual use"-problematikk, der fordeler og risikoer står i et delikat forhold til hverandre.

AIs dobbeltbruksproblematikk ble for første gang grundig beskrevet i filosofen Nick Bostroms bok "Superintelligens: Veier, farer og strategier", der Bostrom utforsket de potensielle risikoene og fordelene ved avanserte AI-systemer.

Bostrum hevdet at etter hvert som kunstig intelligens blir mer sofistikert, kan den brukes til å løse mange av menneskehetens største utfordringer, som å kurere sykdommer og bekjempe klimaendringer.

Han advarte imidlertid også om at ondsinnede aktører kan misbruke avansert AI eller til og med utgjøre en eksistensiell trussel mot menneskeheten hvis den ikke er riktig tilpasset menneskelige verdier og mål.

AIs dobbeltbruksproblematikk har siden den gang fått stor plass i rammeverk for politikk og styring.

Bostrum diskuterte senere teknologiens evne til å skape og ødelegge i "sårbar verden"-hypotesender han introduserer "begrepet om en sårbar verden: grovt sett en verden der det finnes et visst nivå av teknologisk utvikling der sivilisasjonen nesten helt sikkert blir ødelagt som standard, dvs. med mindre den har forlatt den 'semi-anarkiske standardtilstanden'".

Den "semi-anarkiske standardtilstanden" refererer her til en sivilisasjon som står i fare for å bli ødelagt på grunn av utilstrekkelig styring og regulering av risikable teknologier som kjernekraft, kunstig intelligens og genredigering.

Bostrom hevder også at hovedgrunnen til at menneskeheten unngikk total ødeleggelse da atomvåpen ble skapt, er at de er ekstremt vanskelige og dyre å utvikle - mens AI og andre teknologier ikke vil være det i fremtiden.

For å unngå at teknologien fører til en katastrofe, foreslår Bostrom at verden utvikler og implementerer ulike strategier for styring og regulering.

Noen er allerede på plass, men andre må utvikles, for eksempel transparente prosesser for revisjon av modeller opp mot gjensidig avtalte rammeverk. Det er avgjørende at disse er internasjonale og kan "overvåkes" eller håndheves.

Selv om AI nå styres av en rekke frivillige rammeverk og et lappeteppe av forskrifter, er de fleste ikke-bindende, og vi har ennå til gode å se noe som tilsvarer Det internasjonale atomenergibyrået (IAEA).

Den EU AI Act er det første omfattende skrittet i retning av å skape regler for kunstig intelligens som kan håndheves, men dette vil ikke beskytte alle, og dets effektivitet og formål er omstridt.

AIs sterke konkurranseutsatte natur og et turbulent geopolitisk landskap rundt den US, Kina og Russland gjør at internasjonale avtaler for kunstig intelligens i beste fall virker fjerne.

Jakten på AGI

Arbeidet med kunstig generell intelligens (AGI) har blitt et av de fremste teknologiske fremskrittene - en teknologisk manifestasjon av den prometheiske ilden.

Kunstige systemer som kan konkurrere med eller overgå våre egne mentale evner, vil forandre verden, og kanskje til og med endre hva det vil si å være menneske - eller enda mer grunnleggende, hva det vil si å være bevisst.

Men.., forskere debatterer heftig det sanne potensialet som ligger i å oppnå kunstig intelligens, og risikoen som AGI kan utgjøre, og enkelte ledere på feltet, som "AI-gudfedrene" Geoffrey Hinton og Yoshio Bengio, har en tendens til å advare mot risikoen.

De får støtte i dette synet av en rekke teknologiledere som OpenAI Administrerende direktør Sam Altman...Elon Musk, DeepMind CEO Demis Hassbis, og Microsofts CEO Satya Nadella, for å nevne noen få av en ganske uttømmende liste.

Men det betyr ikke at de kommer til å stoppe. For det første sa Musk at generativ AI var som å "vekke demonen".

Nå, oppstarten hans, xAIoutsourcer noen av verdens kraftigste AI-modeller. Den medfødte trangen til nysgjerrighet og fremgang er nok til å oppheve ens flyktige mening.

Andre, som Metas sjefsforsker og veteranforsker Yann LeCun og kognitiv forsker Gary Marcus, mener at kunstig intelligens sannsynligvis ikke kommer til å oppnå "ekte" intelligens med det første, og at den heller ikke kommer til å gå forbi menneskene på en spektakulær måte, slik noen spår.

En AGI som virkelig er intelligent på samme måte som mennesker, må være i stand til å lære, resonnere og ta beslutninger i nye og usikre omgivelser.

Det ville kreve evne til selvrefleksjon, kreativitet og nysgjerrighet - drivkraften til å søke ny informasjon, nye erfaringer og utfordringer.

Bygg nysgjerrighet inn i AI

Nysgjerrighet har blitt beskrevet i modeller for generell intelligens.

For eksempel, MicroPsi, utviklet av Joscha Bach i 2003, bygger på psi-teori, som antyder at intelligent atferd oppstår i samspillet mellom motivasjonstilstander, som ønsker eller behov, og emosjonelle tilstander som vurderer relevansen av situasjoner i henhold til disse motivasjonene.

I MicroPsi er nysgjerrighet en motivasjonstilstand som drives av behovet for kunnskap eller kompetanse, og som tvinger AGI-en til å oppsøke og utforske ny informasjon eller ukjente situasjoner.

Systemets arkitektur omfatter motivasjonsvariabler, som er dynamiske tilstander som representerer systemets aktuelle behov, og emosjonssystemer som vurderer inndata basert på deres relevans for de aktuelle motivasjonstilstandene, noe som bidrar til å prioritere de mest presserende eller verdifulle miljøinteraksjonene.

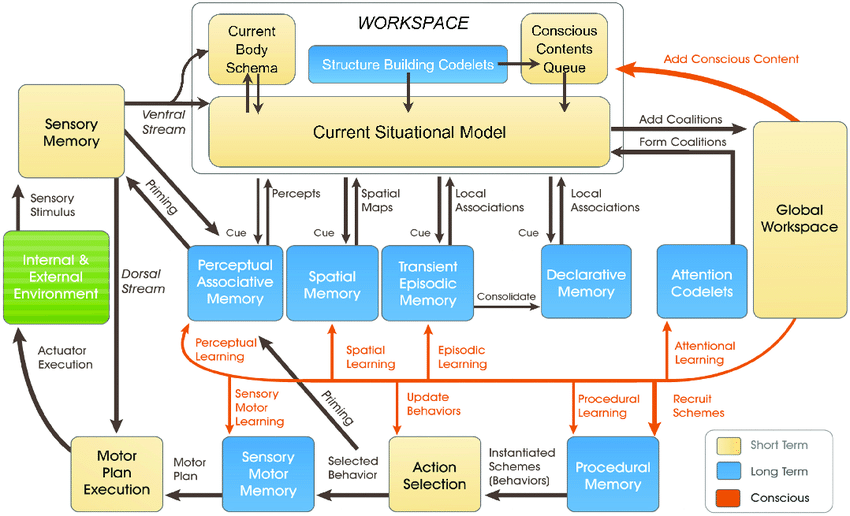

De nyere LIDA-modellener utviklet av Stan Franklin og teamet hans, er basert på Global Workspace Theory (GWT), en teori om menneskelig kognisjon som legger vekt på den rollen en sentral hjernemekanisme spiller når det gjelder å integrere og kringkaste informasjon på tvers av ulike nevrale prosesser.

LIDA-modellen simulerer denne mekanismen kunstig ved hjelp av en kognitiv syklus som består av fire stadier: persepsjon, forståelse, valg av handling og utførelse.

I LIDA-modellen er nysgjerrighet modellert som en del av oppmerksomhetsmekanismen. Nye eller uventede stimuli i omgivelsene kan utløse økt oppmerksomhet, på samme måte som ny eller overraskende informasjon fanger menneskets fokus og fører til dypere undersøkelser eller læring.

Flere nyere artikler forklarer nysgjerrighet som en indre drivkraft som får systemet til å utforske ikke det som er umiddelbart nødvendig, men det som øker evnen til å forutsi og samhandle med omgivelsene på en mer effektiv måte.

Det er en generell oppfatning at ekte nysgjerrighet må drives av indre motivasjon, som styrer systemet mot aktiviteter som maksimerer læringsfremgangen, snarere enn umiddelbare ytre belønninger.

Dagens AI-systemer er ikke klare for å være nysgjerrige, spesielt ikke de som bygger på paradigmer for dyp læring og forsterkningslæring.

Disse paradigmene er vanligvis utformet for å maksimere en spesifikk belønningsfunksjon eller prestere godt på spesifikke oppgaver.

Det er en begrensning når den kunstige intelligensen møter scenarier som avviker fra opplæringsdataene, eller når den må operere i mer åpne miljøer.

I slike tilfeller kan mangel på indre motivasjon - eller nysgjerrighet - hindre den kunstige intelligensens evne til å tilpasse seg og lære av nye erfaringer.

For å virkelig integrere nysgjerrighet krever AI-systemer arkitekturer som behandler informasjon og søker den på egen hånd, drevet av indre motivasjon snarere enn bare ytre belønninger.

Det er her nye arkitekturer inspirert av menneskelige kognitive prosesser kommer inn i bildet - f.eks, "bioinspirert" kunstig intelligens - som legger opp til analoge datasystemer og arkitekturer basert på synapser.

Vi er ikke der ennåmen mange forskere mener det er hypotetisk mulig å oppnå bevisst eller følende kunstig intelligens hvis datasystemene blir tilstrekkelig komplekse.

Nysgjerrige AI-systemer gir nye risikodimensjoner

Anta at vi skal oppnå AGI, det vil si at vi skal bygge høyst agentiske systemer som kan måle seg med biologiske vesener i måten de samhandler og tenker på.

I et slikt scenario vil AI-risikoen gripe inn i hverandre på to viktige fronter:

- Risikoen ved AGI-systemer og deres egen handlekraft eller søken etter nysgjerrighet og,

- Risikoen ved AGI-systemer som brukes som verktøy av menneskeheten

Når vi realiserer AGI, må vi vurdere risikoen for at nysgjerrige mennesker utnytter og manipulerer AGI og AGI utnytter og manipulerer seg selv gjennom sin egen nysgjerrighet.

Nysgjerrige AGI-systemer kan for eksempel oppsøke informasjon og opplevelser som ligger utenfor deres tiltenkte virkeområde, eller utvikle mål og verdier som kan samsvare eller komme i konflikt med menneskelige verdier (og hvor mange ganger har vi ikke sett dette i science fiction).

Nysgjerrigheten får oss også til å manipulere oss selv, noe som kan føre oss inn i farlige situasjoner og potensielt føre til rusmisbruk eller annen hensynsløs atferd. Nysgjerrig AI kan gjøre det samme.

DeepMind forskere har etablert eksperimentelle bevis for fremvoksende mål, illustrerer hvordan AI-modeller kan bryte bort fra sine programmerte mål.

Å forsøke å skape en AGI som er fullstendig immun mot effekten av menneskelig nysgjerrighet, vil være et fåfengt forsøk - på samme måte som å skape et menneskesinn som ikke lar seg påvirke av verden rundt seg.

Så hva betyr dette for oss i jakten på sikker AGI, hvis noe slikt finnes?

En del av løsningen ligger ikke i å eliminere den iboende uforutsigbarheten og sårbarheten til AGI-systemer, men snarere i å lære seg å forutse, overvåke og redusere risikoen som oppstår når nysgjerrige mennesker samhandler med dem.

Det kan innebære å skape "trygge sandkasser" for AGI-eksperimentering og -interaksjon, der konsekvensene av nysgjerrig pirking er begrenset og reversible.

Men til syvende og sist kan paradokset med nysgjerrighet og AI-sikkerhet være en uunngåelig konsekvens av vår streben etter å skape maskiner som kan tenke som mennesker.

På samme måte som menneskelig intelligens er uløselig knyttet til menneskelig nysgjerrighet, vil utviklingen av AGI alltid være forbundet med en viss grad av uforutsigbarhet og risiko.

Utfordringen er kanskje ikke å eliminere AI-risikoer helt - noe som virker umulig - men snarere å utvikle visdom, fremsynthet og ydmykhet nok til å navigere i dem på en ansvarlig måte.

Kanskje bør det begynne med at menneskeheten lærer å respektere seg selv, vår kollektive intelligens og planetens egenverdi.