Mistral AI er en fransk AI-oppstartsbedrift som skaper overskrifter med sine lette modeller med åpen kildekode. Sammen med oppmerksomheten kom en ny omgang med finansiering da selskapet sikret seg investeringer på 385 millioner euro, eller $414 millioner kroner, denne uken.

Selskapets andre finansieringsrunde ble ledet av risikokapitalfirmaene Andreessen Horowitz og Lightspeed Venture Partners.

Diskusjonen om åpen kildekode-modeller kontra proprietære modeller pågår stadig, og Mistral AI er helt klart på åpen kildekode-siden.

Selskaper som OpenAI har vært kritisert for sin fryktskapende virksomhet om sikkerheten til åpen kildekode-modeller, og mange mener at det handler om at Big Tech prøver å beholde sitt hegemoni.

Mistral AI sier at ved å trene opp sine egne modeller, "gi dem ut åpent og fremme bidrag fra fellesskapet, kan vi bygge et troverdig alternativ til det fremvoksende AI-oligopolet. Generative modeller med åpen vekt vil spille en sentral rolle i den kommende AI-revolusjonen."

Flere store investorer har bekreftet sin tillit til denne strategien. Finansieringen Mistral AI sikret seg denne uken, verdsetter selskapet til $2 milliarder kroner. Det er en 7 ganger høyere verdsettelse i løpet av de seks månedene som har gått siden selskapet ble lansert.

Mixtral 8x7B

I september ble Mistral 7B lansert, Mistral AIs lille, men kraftige LLM som slo eller matchet større open source-modeller som Metas lama 2 34B.

OpenAIs egenutviklede GPT-modeller anses med rette som gullstandarden når man sammenligner modellers ytelse. Med Mistral AIs nye modell, Mixtral 8x7Bhar selskapet sikret seg en betydelig skryterett i denne forbindelse.

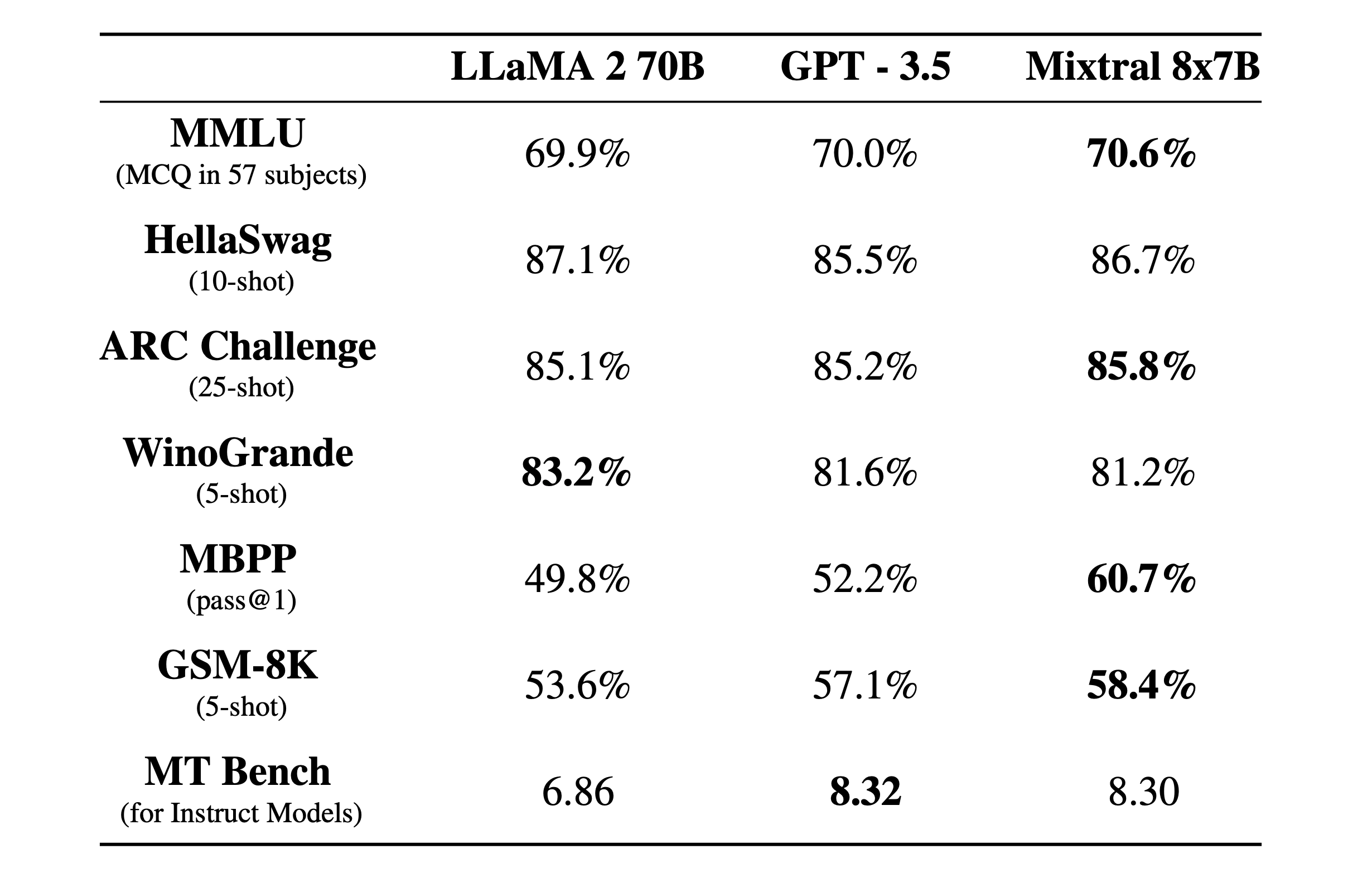

Mixtral 8x7B er en sparsom blanding av eksperter modell med et 32k kontekstvindu. Her kan du se hvordan den presterte i referansetester sammenlignet med Llama 2 og GPT-3.5.

Referansetestene er en god måte å få et inntrykk av hvor god en modell er til å utføre ulike funksjoner. Testene ovenfor var:

- MMLU (flervalgsoppgaver i 57 fag): Står for flervalgsspørsmål i 57 fag.

- HellaSwag (10-skudd): Evaluerer AI-enes evne til å forutsi slutten på et scenario etter å ha fått 10 eksempler.

- ARC Challenge (25-skudd): Tester den kunstige intelligensens forståelse av vitenskapelige begreper og resonnementer etter å ha fått 25 eksempler å lære av før den testes.

- WinoGrande (5-skudd): Tester sunn fornuft basert på å løse tvetydigheter i setninger, med fem eksempler som AI-en kan lære av.

- MBPP (pass@1): Tester en AI-modells evne til å generere korrekte Python-kodebiter. Metrikken pass@1 måler prosentandelen av problemer der modellens første fullføring var korrekt.

- GSM-8K (5-skudd): Grade School Math 8K tester en AIs evne til å løse matematiske ordoppgaver på det nivået som forventes i grunnskolen etter å ha fått fem eksempler.

- MT Bench (for instruksjonsmodeller): Machine Translation Benchmark for Instruct Models måler hvor godt en kunstig intelligens kan følge instruksjoner i forbindelse med oversettelsesoppgaver.

Det som er enda mer imponerende enn resultatene i referansetestene, er hvor liten og effektiv Mixtral 8x7B er. Du kan kjøre denne modellen lokalt på en anstendig bærbar PC med rundt 32 GB RAM.

Med mye mer penger til rådighet kan vi forvente en spennende utvikling fra Mistral AI.