Opplæring av AI-modeller som GPT-4 har stort sett vært basert på datasett som består av tekst og bilder. Metas Ego-Exo4D multimodale persepsjonsdatasett gir dataforskere et rikt nytt sett med treningsdata.

Du kan lære en ny ferdighet ved å lese en bok, men det er så mye enklere når noen viser deg hvordan du gjør noe mens de forklarer det for deg. Dette er målet Metas FAIR-team (Fundamental Artificial Intelligence Research) har for Ego-Exo4D.

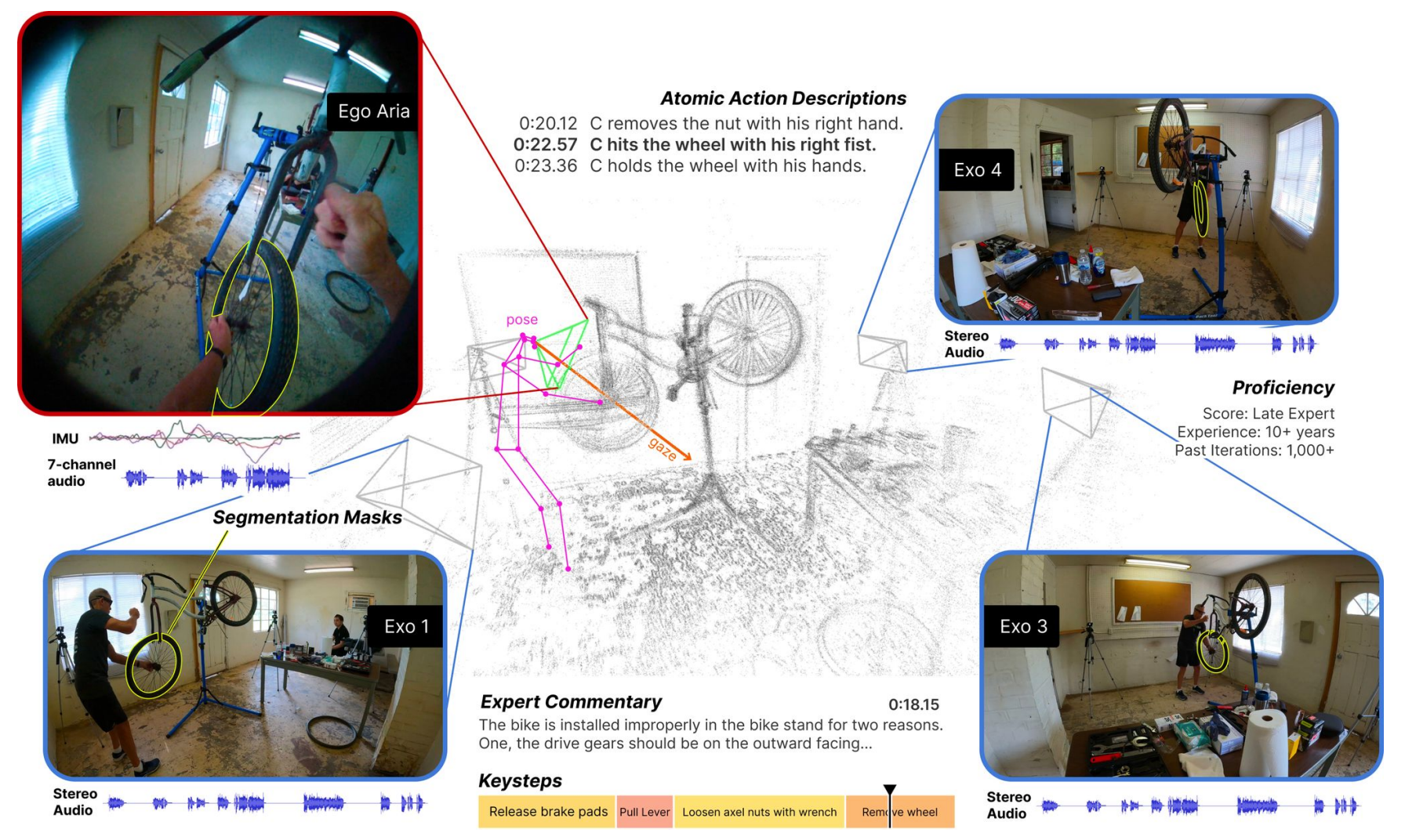

Datasettet består av videoer i førstepersons- (Ego) og tredjepersons- (Exo) perspektiv av mennesker som utfører ulike menneskelige aktiviteter. Det kan være alt fra matlaging, dansing, musikk eller sykkelreparasjon. Dataene ble samlet inn i 13 byer over hele verden av 839 kamerabrukere, og det ble tatt opp 1422 timer med video.

Videoene, som er filmet samtidig, blir deretter utvidet med flere typer data ved hjelp av Metas Project Aria-briller.

Project Aria-brillene er bærbare datamaskiner i brilleform. De fanger opp video- og lydopptak, samt øyesporing og lokasjonsinformasjon. Brillene registrerer også hodestillinger og 3D-punktskyer av omgivelsene.

Resultatet er et datasett med samtidige videoer av en oppgave som utføres, med førstepersonsfortellinger fra kamerabærerne som beskriver handlingene sine, samt hode- og øyesporing av personen som utfører oppgaven.

Vi presenterer Ego-Exo4D - et grunnleggende datasett og en referansepakke som fokuserer på dyktige menneskelige aktiviteter for å støtte forskning på videolæring og multimodal persepsjon. Det er det største offentlige datasettet i sitt slag noensinne.

Mer informasjon ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI på Meta (@AIatMeta) 4. desember 2023

Meta la deretter til tredjepersons play-by-play-beskrivelser av hver kamerabærers handlinger. Meta hyret også inn eksperter på flere felt for å legge til muntlige ekspertkommentarer i tredjeperson som kritiserte måten personen i videoen utførte oppgaven på.

Ved å samle inn både egosentriske og eksosentriske bilder kan Ego-Exo4D-datasettet vise forskerne hvordan aktiviteter ser ut fra ulike perspektiver. Dette kan hjelpe dem med å utvikle algoritmer for datasyn som kan gjenkjenne hva en person gjør fra alle perspektiver.

Ego-Exo4D åpner nye muligheter for læring

En av de største hindringene for å oppnå AGI eller lære opp roboter på en mer effektiv måte er datamaskiners manglende sensoriske persepsjon. Som mennesker har vi så mange sanseinntrykk fra omgivelsene våre at vi ofte tar dem for gitt når vi lærer oss nye ferdigheter.

Ego-Exo4D vil være en svært nyttig ressurs for å bygge bro over dette gapet.

Dr. Gedas Bertasius, assisterende professor ved Institutt for informatikk ved University of North Carolina, sier: "Ego-Exo4D handler ikke bare om å samle inn data, men om å endre hvordan AI forstår, oppfatter og lærer. Med menneskesentrert læring og perspektiv kan kunstig intelligens bli mer nyttig i hverdagen vår, og hjelpe oss på måter vi bare kan forestille oss."

Meta sier at de håper at Ego-Exo4D vil "gjøre det mulig for fremtidens roboter å få innsikt i komplekse fingerferdige manipulasjoner ved å se på dyktige menneskelige eksperter i aksjon".

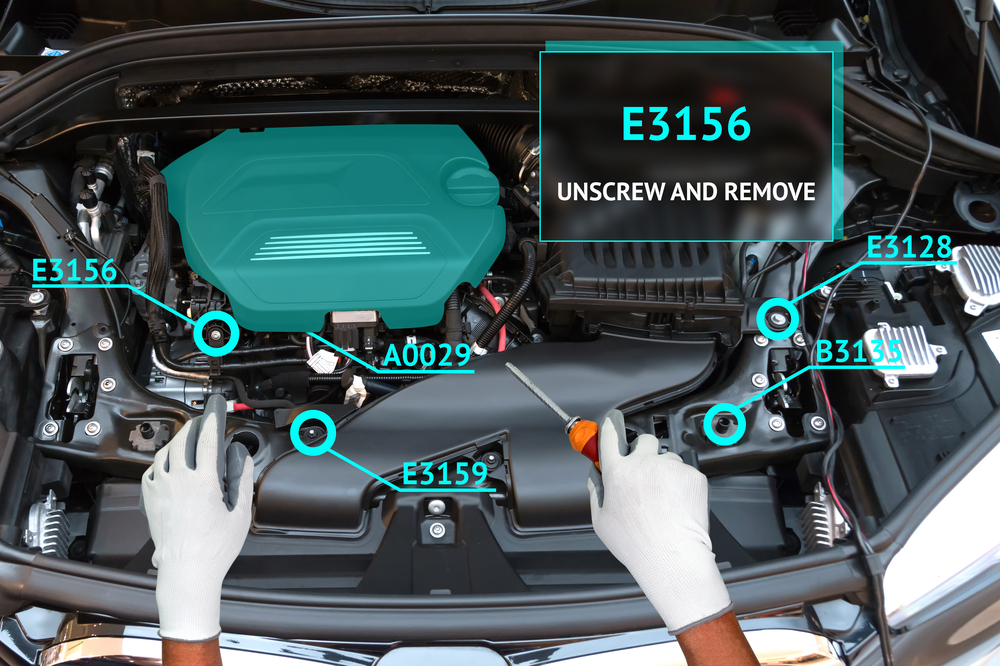

Dette datasettet kombinert med Project Aria-brillene vil snart også muliggjøre en virkelig oppslukende læringsopplevelse for mennesker. Forestill deg at du utfører en oppgave mens brillene dine bruker utvidet virkelighet (AR) til å legge over en opplæringsvideo eller snakke deg gjennom oppgaven.

Du kan lære deg å spille piano og få et visuelt overlegg som viser deg hvor hendene dine skal bevege seg, med lydinstruksjoner i sanntid mens du gjør det. Eller du kan åpne panseret på bilen din og få veiledning i feilsøking og reparasjon av et motorproblem.

Det blir interessant å se om Metas Ego How-To læringskonsept vil drive bedre adopsjon av Project Aria-briller enn det mislykkede Google Glass-produktet opplevde. Det er imidlertid ikke noe ord om når de vil være tilgjengelige for kjøp ennå.

Meta vil gjøre Ego-Exo4D-datasettet tilgjengelig for nedlasting før utgangen av desember.