Nøyaktig hvordan hjernen vår behandler og formulerer språk, er fortsatt i stor grad et mysterium. Forskere ved Meta AI har funnet en ny måte å måle hjernebølger på og avkode ordene som er knyttet til dem.

Personer som har sterkt begrensede motoriske ferdigheter, slik som ALS-rammede, opplever det som spesielt utfordrende å kommunisere. Det er vanskelig å forestille seg frustrasjonen hos en person som Stephen Hawking, som møysommelig konstruerer en setning ved hjelp av øyebevegelser eller rykninger i en kinnmuskel.

Mye forskning har blitt gjort for å avkode tale fra hjerneaktivitetmen de beste resultatene avhenger av invasiv hjerne-datamaskin-implantater.

Meta AI-forskerne brukte magneto-encefalografi (MEG) og elektroencefalografi (EEG) til å registrere hjernebølgene til 175 frivillige mens de lyttet til korte historier og isolerte setninger.

De brukte en forhåndstrenet talemodell og kontrastive læringsprosesser for å identifisere hvilke hjernebølgemønstre som var assosiert med spesifikke ord som forsøkspersonene lyttet til.

"Avkoding av taleoppfatning fra ikke-invasive hjerneopptak",

ledet av den eneste ene @honualx

er nettopp publisert i den siste utgaven av Nature Machine Intelligence:- åpent tilgjengelig artikkel: https://t.co/1jtpTezQzM

- full opplæringskode: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5. oktober 2023

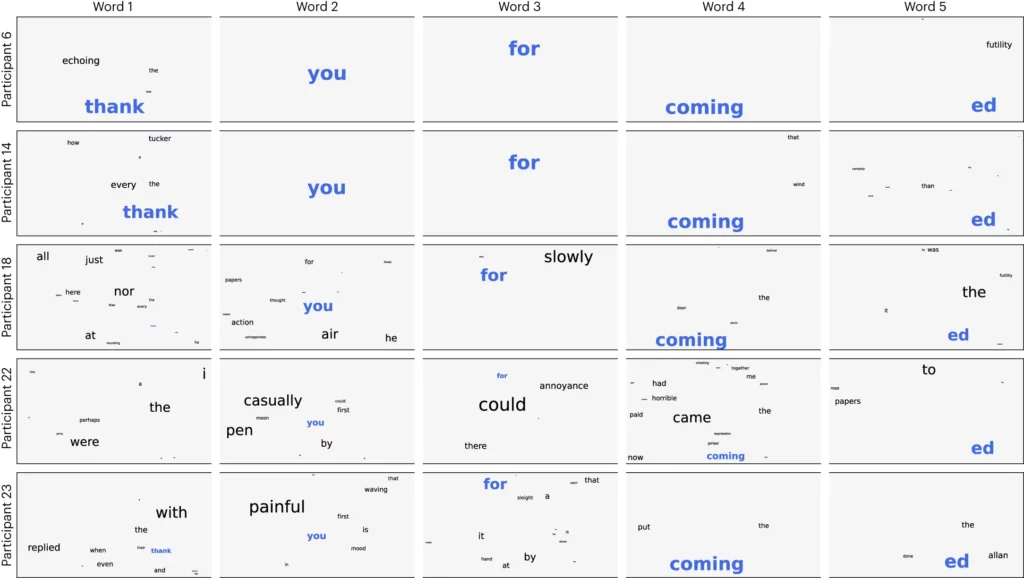

Forskerne delte opp lyden i segmenter på tre sekunder og testet deretter modellen for å se om den kunne identifisere hvilket av de 1500 segmentene den frivillige lyttet til. Modellen forutså en slags ordsky, der det mest sannsynlige ordet ble tillagt størst vekt.

De oppnådde en nøyaktighet på 41% i gjennomsnitt og 95,9% nøyaktighet med sine beste deltakere.

Forskningen viser at det er mulig å få en ganske god idé om hvilken tale en person hører, men nå må prosessen reverseres for å være nyttig. Vi må måle hjernebølgene deres og vite hvilket ord de tenker på.

I artikkelen foreslås det å trene opp et nevralt nettverk mens forsøkspersonene produserer ord ved å snakke eller skrive. Den generelle modellen kan deretter brukes til å tolke hjernebølger og de tilhørende ordene som en ALS-syk person tenker på.

Forskerne klarte å identifisere talesegmenter fra et begrenset forhåndsbestemt sett. For å kunne kommunisere ordentlig, må du kunne identifisere mange flere ord. Det kan være nyttig å bruke en generativ AI til å forutsi det neste mest sannsynlige ordet en person prøver å si.

Selv om prosessen var ikke-invasiv, krever den likevel at man kobles til en MEG-enhet. Dessverre var resultatene fra EEG-målingene ikke gode.

Forskningen gir håp om at kunstig intelligens etter hvert kan brukes til å hjelpe stemmeløse, som ALS-pasienter, med å kommunisere. Ved å bruke en ferdig trent modell unngikk man også behovet for mer møysommelig ord-for-ord-trening.

Meta AI offentliggjorde modellen og dataene, slik at andre forskere forhåpentligvis vil bygge videre på arbeidet deres.