En studie utført av psykologer ved UCLA har vist at GPT-3 er omtrent like gode til å løse resonnementsproblemer som studenter på universitetsnivå.

Vi vet at LLM-er som GPT-3 er gode til å generere responser basert på dataene de er opplært på, men deres evne til å resonnere er tvilsom. Analogisk resonnering er menneskets evne til å ta det vi lærer fra en erfaring som ikke er relatert til noe annet, og anvende det på et problem vi ikke har stått overfor før.

Det er den evnen du har når du skal svare på et spørsmål du aldri har sett før. Du kan resonnere deg gjennom det basert på tidligere problemer du har løst. Og ut fra forskningen ser det ut til at GPT-3 også har utviklet den evnen.

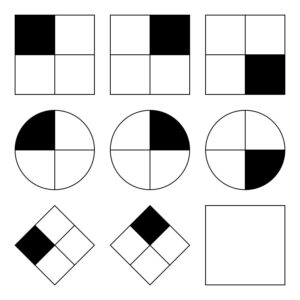

Den UCLA-forskere sette GPT-3 til å jobbe med et sett problemer som ligner på Raven's Progressive Matrices som går ut på å forutsi neste bilde i en bildeserie. Her er en enkel oppgave du kan prøve.

GPT-3 klarte seg godt sammenlignet med de 40 UCLA-studentene som ble bedt om å ta den samme testen. Den kunstige intelligensen svarte riktig i 80% av tilfellene, mens de 40 studentene i gjennomsnitt fikk rundt 60%. Toppstudentene fikk omtrent samme poengsum som GPT-3.

Professor i psykologi ved UCLA, Hongjing Lu, som er hovedforfatter av studien, sier: "Overraskende nok klarte GPT-3 seg ikke bare omtrent like bra som mennesker, men den gjorde også lignende feil."

Forskerne ba også GPT-3 om å løse noen ordassosiasjonsoppgaver. For eksempel: "'Bil' er til 'vei' som 'båt' er til hvilket ord?". Svaret er åpenbart "vann", men denne typen spørsmål kan være vanskelige for en kunstig intelligens.

Forskerne trodde i hvert fall at det kunne være vanskelig. Det viser seg at GPT-3 presterte bedre enn gjennomsnittet av college-søkere gjorde på SAT-prøvene.

GPT-3 sliter med problemer som er enkle for mennesker

Det AI-modeller sliter med, er problemer som krever en visuell forståelse av det fysiske rommet. Hvis du gir GPT-3 en liste med verktøy, for eksempel en hammer, en spiker og et bilde, er den ikke i stand til å komme opp med den åpenbare løsningen for å henge opp bildet på veggen.

Den typen problemer er enkle for mennesker å løse fordi vi kan se, holde og føle fysiske gjenstander i et rom vi opptar. Disse erfaringene gjør det enkelt for hjernen vår å lære og løse problemer på en måte som AI-modeller ikke kan. Når det er sagt, er GPT-4 i ferd med å bli bedre på denne typen resonnementer nå.

Selv om forskerne kunne måle ytelsen til GPT-3, har de ingen anelse om "tankeprosessen" den følger for å komme frem til svarene. Følger den en lignende tankeprosess som mennesker gjør, eller gjør den noe helt annet? Siden GPT-3 er en lukket modell, er det ikke mulig å se under panseret for å finne ut hva som skjer.

Det overraskende resultatet av denne forskningen er at GPT-3 ser ut til å være i stand til å løse nye problemer uten direkte trening. Det er helt i tråd med hvordan mennesker løser nye problemer. GPT-4 forventes å prestere enda bedre på disse problemene, og hvem vet hvilke andre "tenkeevner" som kan dukke opp med mer testing.

Selv om romlig resonnering er en utfordring for LLM-er, kan disse utfordringene løses ved hjelp av visuelle modeller som Googles RT-2 som nylig ble kunngjort. Når AI-modeller kan begynne å "se" og samhandle fysisk med omgivelsene sine, vil problemløsningsevnen deres bli eksponentielt forbedret.