La manière dont notre cerveau traite et formule le langage reste un mystère. Les chercheurs de Meta AI ont trouvé un nouveau moyen de mesurer les ondes cérébrales et de décoder les mots qui y sont associés.

Les personnes dont les capacités motrices sont gravement limitées, comme les personnes atteintes de la SLA, éprouvent des difficultés particulières à communiquer. Il est difficile d'imaginer la frustration d'une personne comme Stephen Hawking qui construit laborieusement une phrase avec des mouvements oculaires ou en contractant un muscle de la joue.

De nombreuses recherches ont été menées pour décoder la parole à partir de l'activité cérébralemais les meilleurs résultats dépendent de l'invasivité les implants cerveau-ordinateur.

Les chercheurs de Meta AI ont utilisé la magnéto-encéphalographie (MEG) et l'électroencéphalographie (EEG) pour enregistrer les ondes cérébrales de 175 volontaires pendant qu'ils écoutaient des histoires courtes et des phrases isolées.

Ils ont utilisé un modèle vocal pré-entraîné et l'apprentissage contrastif pour identifier les modèles d'ondes cérébrales associés à des mots spécifiques que les sujets écoutaient.

`Décodage de la perception de la parole à partir d'enregistrements cérébraux non invasifs`,

dirigée par le seul et unique @honualx

vient de paraître dans le dernier numéro de Nature Machine Intelligence :- article en libre accès : https://t.co/1jtpTezQzM

- code de formation complet : https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5 octobre 2023

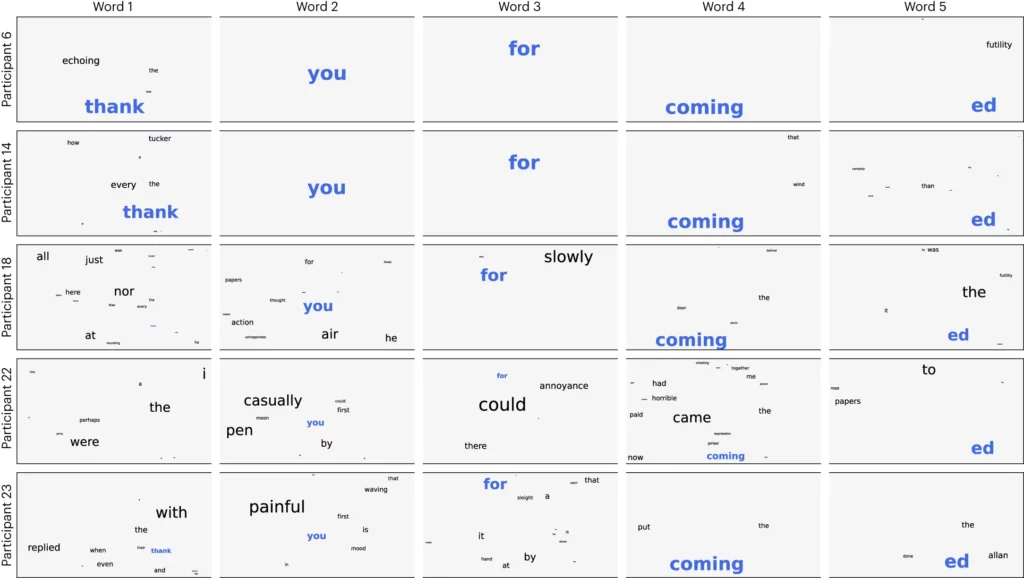

Les chercheurs ont divisé l'audio en segments de 3 secondes et ont ensuite testé leur modèle pour voir s'il pouvait identifier correctement lequel des 1 500 segments le volontaire écoutait. Le modèle a prédit une sorte de nuage de mots, le mot le plus probable ayant le plus de poids.

Ils ont obtenu une précision de 41% en moyenne et une précision de 95,9% avec leurs meilleurs participants.

La recherche montre qu'il est possible de se faire une idée assez précise du discours qu'une personne entend, mais le processus doit maintenant être inversé pour être utile. Nous devons mesurer les ondes cérébrales de la personne et savoir à quel mot elle pense.

L'article propose d'entraîner un réseau neuronal pendant que les sujets produisent des mots en parlant ou en écrivant. Ce modèle général pourrait alors être utilisé pour comprendre les ondes cérébrales et les mots associés auxquels pense une personne atteinte de SLA.

Les chercheurs ont pu identifier des segments de discours à partir d'un ensemble limité de mots prédéterminés. Pour une bonne communication, il faudrait pouvoir identifier beaucoup plus de mots. L'utilisation d'une IA générative pour prédire le prochain mot le plus probable qu'une personne essaie de dire pourrait y contribuer.

Même si le processus n'est pas invasif, il nécessite tout de même d'être relié à un appareil de radiologie. Dispositif MEG. Malheureusement, les résultats des mesures de l'EEG n'étaient pas excellents.

La recherche laisse entrevoir la possibilité d'utiliser l'IA pour aider les personnes sans voix, comme les malades atteints de la SLA, à communiquer. L'utilisation d'un modèle pré-entraîné a également permis d'éviter une formation mot à mot plus laborieuse.

Meta AI a rendu publics le modèle et les données, et espère que d'autres chercheurs s'appuieront sur ses travaux.