La IA gira en torno a los datos, pero ¿de dónde proceden? ¿Son legales y éticos los conjuntos de datos? ¿Cómo lo determinan con seguridad los desarrolladores?

El entrenamiento de modelos de aprendizaje automático, como los grandes modelos lingüísticos (LLM), requiere grandes volúmenes de datos de texto.

Hay montones de conjuntos de datos disponibles en plataformas como Kaggle, GitHub y Hugging Face, pero se encuentran en una zona gris desde el punto de vista legal y ético, principalmente por cuestiones de licencias y uso justo.

En Iniciativa para la Procedencia de los Datosun esfuerzo de colaboración entre investigadores de IA y profesionales del Derecho, revisó miles de conjuntos de datos para arrojar luz sobre sus verdaderos orígenes.

En se centró en más de 1.800 conjuntos de datos disponibles en plataformas como Hugging Face, GitHub y Papers With Code. Los conjuntos de datos están diseñados principalmente para afinar modelos de código abierto como Llama-2.

El estudio reveló que aproximadamente 70% de estos conjuntos de datos carecían de información clara sobre licencias o estaban etiquetados con licencias excesivamente permisivas.

Con una flagrante falta de claridad sobre los derechos de autor y las restricciones de uso comercial, los desarrolladores de IA corren el riesgo de infringir accidentalmente la ley o violar los derechos de autor.

Shayne Longpre, doctorando del MIT Media Lab que encabezó la auditoría, subrayó que el problema no es culpa de las plataformas de alojamiento, sino de un problema sistémico de la comunidad de aprendizaje automático.

2023 ha sido testigo de un aluvión de demandas dirigidas a los principales desarrolladores de IA, como Meta, Anthropic y OpenAI, que están sometidos a una presión extrema para que adopten prácticas de recopilación de datos más transparentes. Las normativas, como la Ley de IA de la UEestán preparados para hacer cumplir precisamente eso.

La Data Provenance Initiative permite a los desarrolladores de aprendizaje automático explore aquí los conjuntos de datos auditados. La iniciativa también analiza patrones dentro de los conjuntos de datos, arrojando luz sobre sus orígenes geográficos e institucionales.

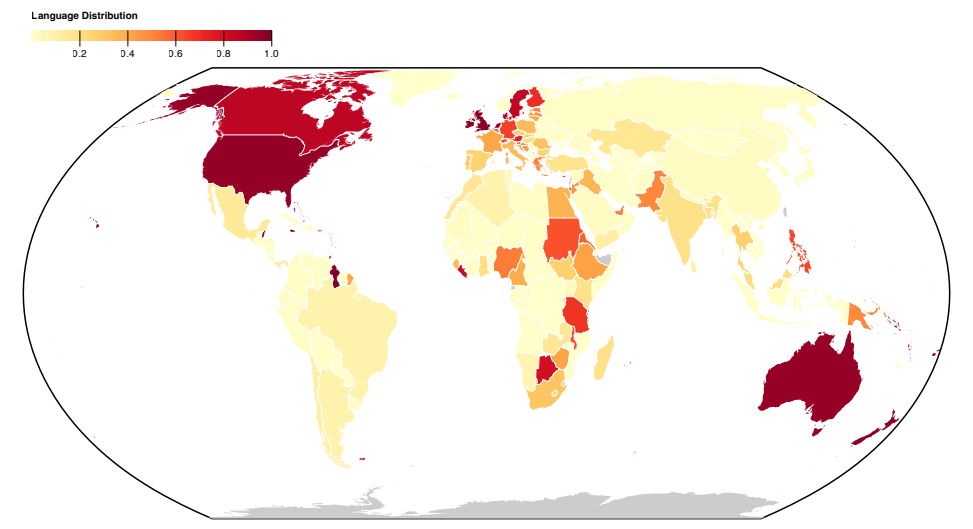

La mayoría de los conjuntos de datos se elaboran en el Norte Global anglófono, lo que pone de relieve los desequilibrios socioculturales.

Más información sobre el estudio

Este análisis a gran escala de conjuntos de datos puso de manifiesto problemas sistemáticos en la forma de recopilar y distribuir los datos. La iniciativa también elaboró un documento para explicar sus conclusiones, publicado aquí.

Aquí encontrará más información sobre los métodos y resultados del estudio:

- Análisis de conjuntos de datos para determinar su origen y etiquetado: Este estudio auditó sistemáticamente más de 1.800 conjuntos de datos de ajuste fino para examinar su procedencia, licencia y documentación.

- Pruebas de etiquetado incorrecto: Los resultados pusieron de manifiesto las diferencias entre los tipos de datos disponibles con distintas licencias y sus implicaciones para las interpretaciones jurídicas de los derechos de autor y el uso leal. Se descubrió un alto índice de categorización errónea de licencias, con más de 72% de conjuntos de datos sin especificar una licencia y un índice de error de 50% en los que sí lo hacían.

- Procedencia poco fiable de los datos: La investigación llama la atención sobre el problema de la procedencia poco fiable de los datos, haciendo hincapié en la necesidad de normas para rastrear el linaje de los datos, garantizar una atribución adecuada y fomentar un uso responsable de los mismos.

- Distribución geográfica: El estudio pone de relieve una grave falta de representación y atribución de los conjuntos de datos procedentes del Sur Global. La mayoría de los conjuntos de datos giran en torno a la lengua inglesa y están culturalmente vinculados a Europa, Norteamérica y Oceanía anglófona.

Este estudio pone de relieve problemas sistémicos y estructurales en la forma en que se crean, distribuyen y utilizan los datos. Los datos son un recurso esencial para la IA y, al igual que los recursos naturales, son finitos.

Existe la preocupación de que la tecnología de IA acabe superando los conjuntos de datos actuales e incluso empezar a consumir su propia producciónlo que significa que los modelos de IA aprenderán del texto generado por la IA.

Esto podría erosionar la calidad de los modelos, lo que significa que los datos de alta calidad, éticos y legales podrían llegar a ser muy valiosos.