Los datos son la savia de la IA, pero no son un recurso infinito. ¿Puede la humanidad quedarse sin datos? ¿Qué ocurrirá?

Los modelos complejos de IA requieren grandes cantidades de datos de entrenamiento. Por ejemplo, para entrenar un gran modelo lingüístico (LLM) como ChatGPT se necesitan aproximadamente 10 billones de palabras.

Algunos expertos creen que la oferta de datos de alta calidad está disminuyendo. Por ejemplo, un estudio de 2022 de investigadores de varias universidades declaró, "Nuestro análisis indica que el stock de datos lingüísticos de alta calidad se agotará pronto; probablemente antes de 2026... Nuestro trabajo sugiere que la tendencia actual de modelos ML en constante crecimiento que dependen de enormes conjuntos de datos podría ralentizarse si no se mejora drásticamente la eficiencia de los datos o se dispone de nuevas fuentes de datos."

Aunque la generación de datos sintéticos ofrece una solución, por lo general no logra captar la profundidad, los matices y la varianza de los datos reales.

Para complicar aún más la situación, preocupa qué ocurrirá cuando la IA empiece a consumir su propia producción, algo que los investigadores de la École Polytechnique Fédérale de Lausanne (EPFL), en Suiza, creen que va a ocurrir. ya está sucediendo.

Su investigación indica que las empresas de IA que compran datos producidos por humanos a través de plataformas como Amazon Mechanical Turk pueden recibir en su lugar datos generados por IA.

¿Qué ocurre cuando la IA empieza a comerse su propia producción? ¿Puede evitarse?

Crear conjuntos de datos es caro y lleva mucho tiempo, y es mucho lo que está en juego.

Los datos son omnipresentes, pero operacionalizarlos para la IA es un proceso complejo. La calidad de los datos y las etiquetas influye en el rendimiento del modelo: es un caso de "basura que entra, basura que sale".

Para describir brevemente el proceso de creación de conjuntos de datos, los anotadores de datos (o etiquetadores) toman datos procesados (por ejemplo, una imagen recortada) y etiquetan características (por ejemplo, un coche, una persona, un pájaro).

Esto proporciona a los algoritmos un "objetivo" del que aprender. Los algoritmos extraen y analizan las características de los datos etiquetados para predecirlas en datos nuevos que no se han visto.

Esto es necesario para el aprendizaje automático supervisado, que es una de las ramas principales del aprendizaje automático junto con el aprendizaje automático no supervisado y el aprendizaje por refuerzo. En algunas estimacionesEl proceso de preparación y etiquetado de datos ocupa 80% de la duración de un proyecto de modelo de aprendizaje automático, pero si se toman demasiadas precauciones se corre el riesgo de comprometer el rendimiento del modelo.

Además de los retos prácticos que plantea la creación de conjuntos de datos de alta calidad, la propia naturaleza de los datos cambia constantemente. Lo que hace 10 años se definía como un "conjunto de datos que contiene una selección típica de vehículos en circulación" no es lo mismo hoy en día. Ahora, por ejemplo, encontraríamos un número mucho mayor de eScooters y eBikes en las carreteras.

Son los llamados "casos extremos", es decir, objetos o fenómenos poco frecuentes que no están presentes en los conjuntos de datos.

Los modelos reflejan la calidad de sus conjuntos de datos

Si se entrena un sistema de IA moderno en un conjunto de datos antiguo, el modelo corre el riesgo de obtener un bajo rendimiento cuando se expone a datos nuevos y desconocidos.

Entre 2015 y 2020, los investigadores descubrieron importantes sesgos estructurales en los algoritmos de IA, atribuidos en parte al entrenamiento de modelos con datos antiguos y sesgados.

Por ejemplo, el Caras etiquetadas en el hogar salvaje (LFW)un conjunto de datos de rostros de famosos utilizado habitualmente en tareas de reconocimiento facial, consta de 77,5% varones y 83,5% de piel blanca individuos. Una IA no puede funcionar correctamente si los datos no representan a todas las personas a las que pretende servir. Se han detectado tasas de error en el reconocimiento facial de los mejores algoritmos de hasta 0,8% en hombres blancos y 34,7% en mujeres de piel oscura.

Esta investigación culminó en el histórico Estudio de matices de género y un documental titulado Sesgo codificadoen el que se investigaba cómo es probable que la IA aprenda a partir de datos erróneos y poco representativos.

Las consecuencias no son nada benignas: ha dado lugar a resoluciones judiciales incorrectas, encarcelamientos falsos y denegación de empleo y créditos a mujeres y otros colectivos.

Las IA necesitan más datos de alta calidad, que deben ser justos y representativos - es una combinación escurridiza.

¿Son los datos sintéticos la respuesta?

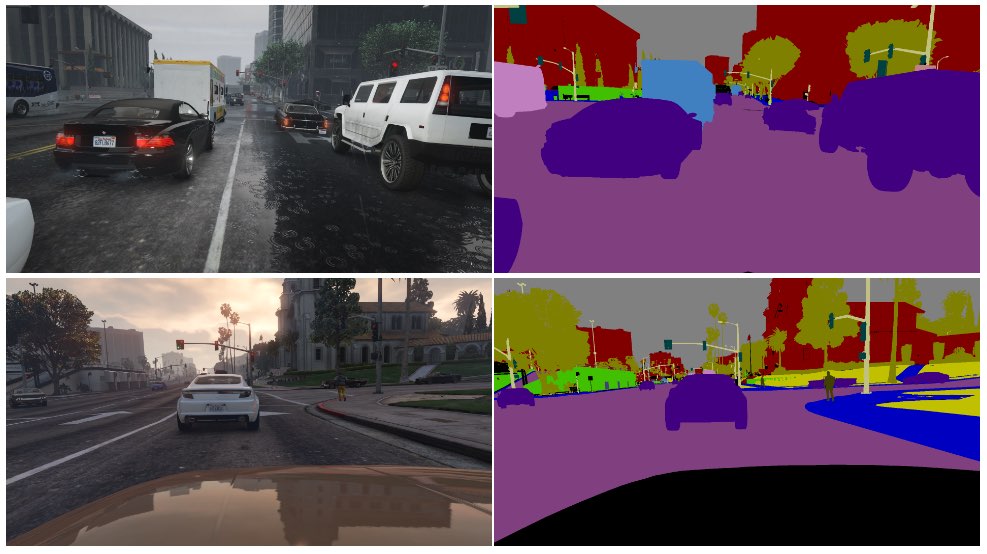

Los datos sintéticos se utilizan habitualmente en visión por ordenador (VC), donde las IA identifican objetos y características a partir de imágenes y vídeo.

En lugar de recoger datos de imágenes del mundo real -como fotografiar o grabar en vídeo una calle-, lo que supone un reto técnico y plantea problemas de privacidad, basta con generar los datos en un entorno virtual.

Aunque esto complementa a las IA con más datos, tiene varios inconvenientes:

- Modelizar escenarios de la vida real en un entorno virtual no es sencillo.

- Generar grandes cantidades de datos sintéticos sigue siendo costoso y requiere mucho tiempo.

- Los casos extremos y los valores atípicos siguen siendo un problema.

- No puede reproducir perfectamente la realidad.

- Por otro lado, algunos aspectos pueden ser demasiado perfectos, y es difícil determinar lo que falta.

Al final, los datos sintéticos son excelentes para entornos fácilmente virtualizables, como una fábrica, pero no siempre son adecuados para entornos reales en rápido movimiento, como las calles de una ciudad.

¿Y la generación de datos de texto sintético?

El texto es más sencillo que los datos de imagen o vídeo, por lo que ¿pueden utilizarse modelos como ChatGPT para generar datos de entrenamiento sintéticos casi infinitos?

Sí, pero es arriesgado, y los impactos no son fáciles de predecir. Aunque los datos de texto sintético pueden ayudar a afinar, probar y optimizar los modelos, no son ideales para enseñar a los modelos nuevos conocimientos y podrían afianzar sesgos y otros problemas.

He aquí una analogía de por qué entrenar IAs con datos generados por IA es problemático:

- Pensemos en una escuela que utiliza los mejores libros de texto del mundo para formar a sus alumnos con todo lo que hay que saber de sus recursos en el espacio de un día.

- Después, la escuela empieza a producir su propio trabajo basado en ese conocimiento, de forma análoga a la producción de un chatbot. Los estudiantes han aprendido de todos los datos disponibles hasta la fecha de inicio de la formación, pero después no pueden introducir nuevos datos en el sistema de conocimiento de forma eficiente.

- El conocimiento se crea a diario. Aunque la inmensa mayoría del conocimiento humano se creó antes de un día concreto, el conocimiento evoluciona y se transforma con el tiempo. Y lo que es más importante, los seres humanos no sólo creamos nuevos conocimientos constantemente, sino que también cambiamos nuestra perspectiva sobre los ya existentes.

- Ahora, supongamos que la escuela, agotada de datos, empieza a enseñar a sus alumnos utilizando su propia producción. Los alumnos empiezan a "comerse" su contenido para producir contenido nuevo.

- En ese momento, la producción de los alumnos no se ajusta al mundo real y su utilidad disminuye. El sistema regurgita su propio trabajo. Aunque el trabajo puede adaptarse y evolucionar, lo hace aislado de todo lo que está fuera de ese bucle de retroalimentación.

La IA enfrenta constantemente a las personas a acertijos que resolver, y este tiene mucho comentaristas en Reddit y el Foro de Y Combinator perplejo.

Es algo alucinante y no hay consenso sobre sus ramificaciones.

Los etiquetadores de datos humanos suelen utilizar la IA para producir datos

Hay otra capa imprevista en el problema de producir datos de formación de calidad.

Plataformas de crowdworking como Amazon Mechanical Turk (MTurk) son utilizados habitualmente por empresas de IA que buscan producir auténticos conjuntos de datos "humanos". Te teme que los anotadores de datos de esas plataformas utilicen IA para realizar sus tareas.

Investigadores de la École Polytechnique Fédérale de Lausanne (EPFL) en Suiza analizaron datos creados a través de MTurk para explorar si los trabajadores utilizaban IA para generar sus envíos.

El estudiopublicado el 13 de junio, pidió a 44 participantes de MTurk que resumieran los resúmenes de 16 artículos de investigación médica. Se descubrió que entre 33% y 46% de los usuarios de la plataforma generaron sus presentaciones con IA, a pesar de que se les pedía que respondieran con lenguaje natural.

"Desarrollamos una metodología muy específica que funcionó muy bien para detectar texto sintético en nuestro escenario", Manoel Ribeiro, coautor del estudio y estudiante de doctorado en la EPFL, a The Register esta semana.

Aunque el conjunto de datos y el tamaño de la muestra del estudio son bastante reducidos, no es ni mucho menos inconcebible pensar que las IA se entrenan sin darse cuenta con contenidos generados por ellas.

El estudio no trata de culpar a los trabajadores de MTurk: los investigadores señalan que los bajos salarios y el trabajo repetitivo contribuyen al problema. Las empresas de IA quieren datos de alta calidad creados por humanos y, al mismo tiempo, mantener los costes bajos. Un comentarista dijo en Reddit: "Actualmente soy uno de estos trabajadores, encargado de formar a Bard. Estoy seguro de que estoy usando ChatGPT para esto. 20$/hora no es suficiente para el horrible trato que recibimos, así que voy a exprimir hasta el último céntimo de este trabajo *******".

La madriguera del conejo es aún más profunda, ya que las IA se entrenan a menudo con datos extraídos de Internet. A medida que se publiquen en línea más contenidos escritos con IA, esta aprenderá inevitablemente de sus propios resultados.

A medida que los seres humanos empiezan a depender de las IA para obtener información, la calidad de sus resultados es cada vez más crítica. Tenemos que encontrar métodos innovadores para actualizar las IA con datos frescos y auténticos.

En palabras de Ribeiro, "los datos humanos son el patrón oro, porque son los humanos los que nos importan, no los grandes modelos lingüísticos".

Los trabajos que analizan el impacto potencial de la IA que consume sus propios resultados están en curso, pero los datos humanos auténticos siguen siendo fundamentales para una amplia gama de tareas de aprendizaje automático.

Generar grandes cantidades de datos para IAs hambrientas mientras se sortean riesgos es un trabajo en curso.