Forscher von Stanford und Google DeepMind haben eine künstliche Intelligenz entwickelt, die menschliche Persönlichkeiten nach einem zweistündigen Gespräch mit verblüffender Genauigkeit nachbilden kann.

Durch die Befragung von 1.052 Menschen mit unterschiedlichem Hintergrund haben sie so genannte "Simulationsagenten" entwickelt - digitale Kopien, die die Überzeugungen, Einstellungen und Verhaltensweisen ihrer menschlichen Gegenstücke erschreckend gut vorhersagen können.

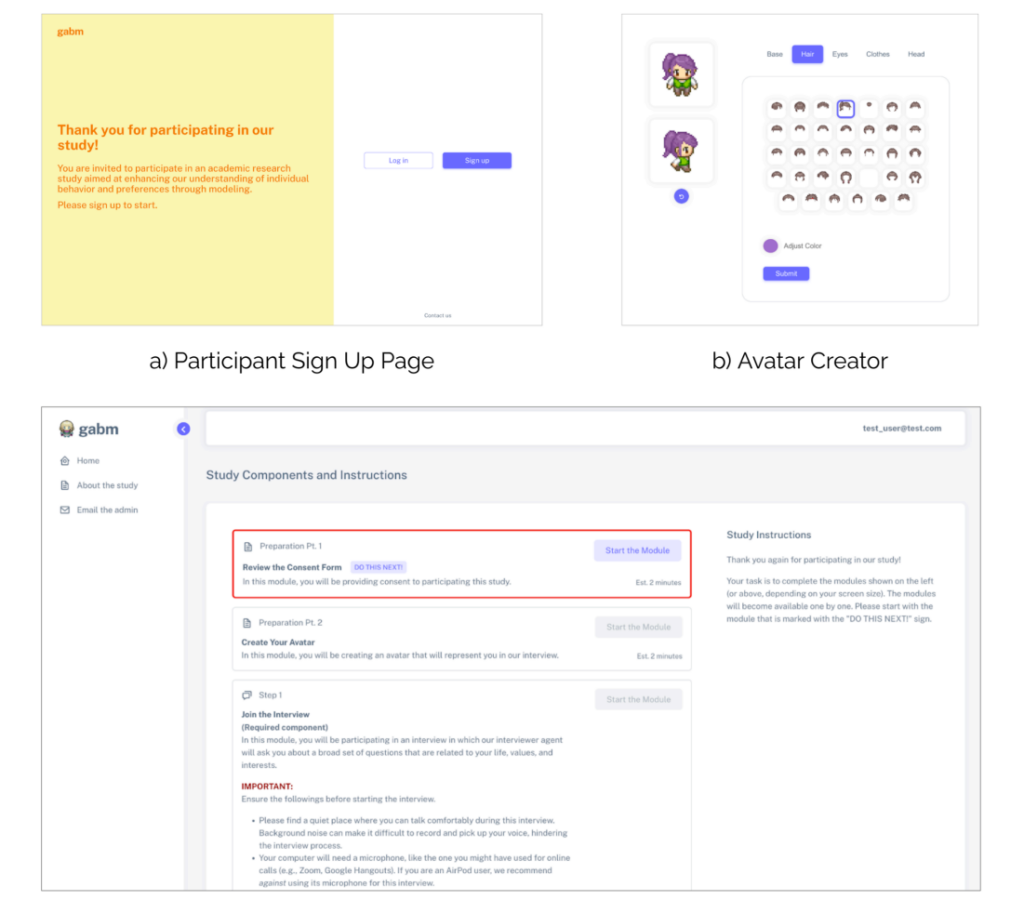

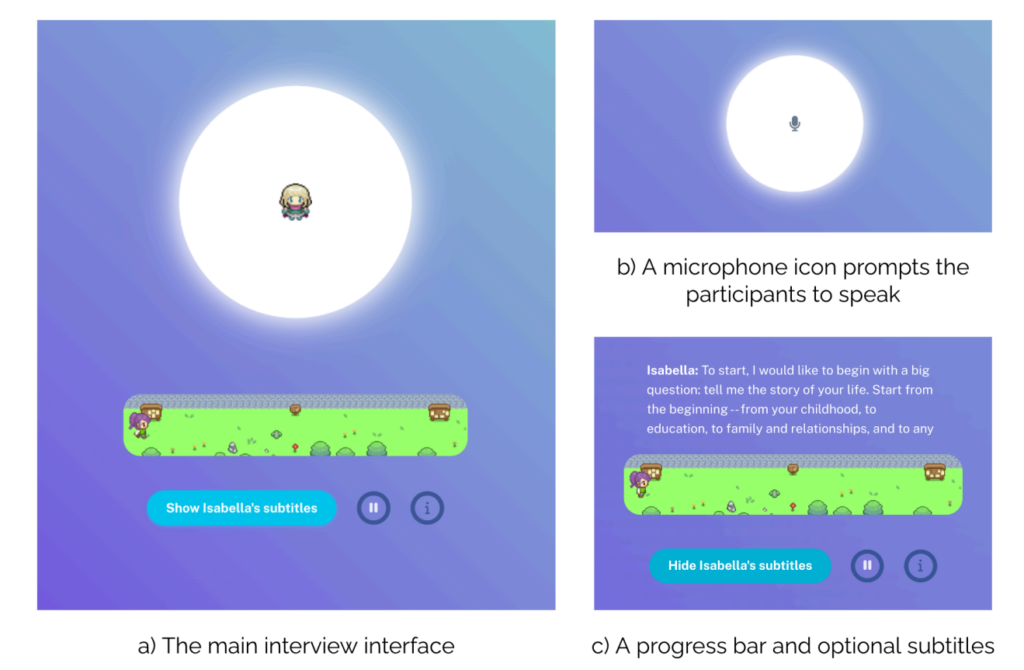

Zur Erstellung der digitalen Kopien verwendet das Team die Daten eines "KI-Interviewers", der die Teilnehmer in ein natürliches Gespräch verwickeln soll.

Der KI-Interviewer stellt Fragen und generiert personalisierte Folgefragen - durchschnittlich 82 pro Sitzung -, die alles von Kindheitserinnerungen bis hin zu politischen Ansichten abfragen.

In diesen zweistündigen Gesprächen erstellte jeder Teilnehmer ausführliche Transkripte mit durchschnittlich 6.500 Wörtern.

Wenn ein Teilnehmer beispielsweise den Heimatort seiner Kindheit erwähnt, kann die KI tiefer gehen und nach bestimmten Erinnerungen oder Erfahrungen fragen. Durch die Simulation eines natürlichen Gesprächsflusses erfasst das System nuancierte persönliche Informationen, die bei Standardumfragen oft übergangen werden.

Hinter den Kulissen ist die Studie dokumentiert, was die Forscher als "Expertenreflexion" bezeichnen, indem sie große Sprachmodelle (LLMs) auffordern, jedes Gespräch aus vier verschiedenen professionellen Blickwinkeln zu analysieren:

- Als Psychologe identifiziert sie bestimmte Persönlichkeitsmerkmale und emotionale Muster - zum Beispiel, wie sehr jemand Unabhängigkeit schätzt, wenn er seine Familienbeziehungen beschreibt.

- Durch die Brille eines Verhaltensökonomen werden Erkenntnisse über finanzielle Entscheidungen und Risikotoleranz gewonnen, z. B. darüber, wie sie an Ersparnisse oder Berufswahl herangehen.

- Aus der Sicht der Politikwissenschaftler werden ideologische Neigungen und politische Präferenzen für verschiedene Themen dargestellt.

- In einer demografischen Analyse werden sozioökonomische Faktoren und Lebensumstände erfasst.

Die Forscher kamen zu dem Schluss, dass diese auf Interviews basierende Technik vergleichbare Methoden - wie die Auswertung von Daten aus sozialen Medien - deutlich übertraf.

Prüfung der digitalen Kopien

Wie gut waren also die KI-Kopien? Die Forscher unterzogen sie einer Reihe von Tests, um das herauszufinden.

Zunächst wurde die Allgemeine Sozialerhebung (General Social Survey) herangezogen - ein Maß für soziale Einstellungen, das Fragen zu allen möglichen Themen stellt, von politischen Ansichten bis hin zu religiösen Überzeugungen. Hier stimmten die KI-Kopien in 85% der Fälle mit den Antworten ihrer menschlichen Gegenstücke überein.

Bei dem Big-Five-Persönlichkeitstest, bei dem Eigenschaften wie Offenheit und Gewissenhaftigkeit anhand von 44 verschiedenen Fragen gemessen werden, stimmten die KI-Vorhersagen in 80% der Fälle mit den menschlichen Antworten überein. Das System war hervorragend bei der Erfassung von Eigenschaften wie Extraversion und Neurotizismus.

Beim Testen von Wirtschaftsspielen zeigten sich jedoch faszinierende Grenzen. Beim "Diktatorspiel", bei dem die Teilnehmer entscheiden, wie sie das Geld mit anderen teilen, hatte die KI Schwierigkeiten, die menschliche Großzügigkeit perfekt vorherzusagen.

Beim "Vertrauensspiel", bei dem die Bereitschaft zur Zusammenarbeit mit anderen zum gegenseitigen Nutzen getestet wird, stimmten die digitalen Kopien nur in etwa zwei Dritteln der Fälle mit den menschlichen Entscheidungen überein.

Dies deutet darauf hin, dass die KI zwar unsere erklärten Werte erfassen kann, aber die Nuancen der menschlichen sozialen Entscheidungsfindung (natürlich noch) nicht vollständig erfassen kann.

Experimente in der realen Welt

Damit nicht genug, unterzogen die Forscher die Kopien auch fünf klassischen sozialpsychologischen Experimenten.

In einem Experiment, in dem untersucht wurde, wie sich die wahrgenommene Absicht auf die Schuldzuweisung auswirkt, zeigten sowohl Menschen als auch ihre KI-Kopien ähnliche Muster der Schuldzuweisung, wenn schädliche Handlungen beabsichtigt schienen.

In einem anderen Experiment wurde untersucht, wie Fairness emotionale Reaktionen beeinflusst, wobei KI-Kopien die menschlichen Reaktionen auf faire bzw. unfaire Behandlung genau vorhersagten.

Die KI-Nachbildungen konnten in vier von fünf Experimenten das menschliche Verhalten erfolgreich reproduzieren, was darauf hindeutet, dass sie nicht nur einzelne aktuelle Reaktionen, sondern umfassende, komplexe Verhaltensmuster modellieren können.

Einfache KI-Klone: Was sind die Auswirkungen?

AI systems that ‘clone’ human views and behaviors are big business, with Meta kündigte kürzlich Pläne zur Besetzung von Facebook und Instagram mit KI-Profilen die Inhalte erstellen und mit den Nutzern in Kontakt treten können.

Auch TikTok ist mit seiner neuen "Symphony"-Suite von KI-gesteuerten Kreativtools in das Geschehen eingestiegen. Dazu gehören digitale Avatare, die von Marken und Kreativen genutzt werden können, um lokalisierte Inhalte in großem Umfang zu produzieren.

Mit Digitale Avatare der SymphonieTikTok ermöglicht es berechtigten Personen, Avatare zu erstellen, die echte Menschen darstellen, mit einer breiten Palette an Gesten, Ausdrücken, Alter, Nationalitäten und Sprachen.

Die Forschungen von Stanford und DeepMind deuten darauf hin, dass solche digitalen Nachbildungen immer ausgefeilter werden - und einfacher zu erstellen und in großem Maßstab einzusetzen sind.

"Wenn man einen Haufen kleiner 'Du's' hat, die herumlaufen und tatsächlich die Entscheidungen treffen, die man selbst getroffen hätte, dann ist das meiner Meinung nach die Zukunft", erklärt der leitende Forscher Joon Sung Park, ein Doktorand der Computerwissenschaften in Stanford, gegenüber MIT.

Park beschreibt, dass eine solche Technologie auch Vorteile hat, da die Erstellung präziser Klone die wissenschaftliche Forschung unterstützen könnte.

Anstatt teure oder ethisch fragwürdige Experimente an echten Menschen durchzuführen, könnten Forscher testen, wie Bevölkerungsgruppen auf bestimmte Inputs reagieren. So könnte man beispielsweise die Reaktionen auf Botschaften zur öffentlichen Gesundheit vorhersagen oder untersuchen, wie sich Gemeinschaften an größere gesellschaftliche Veränderungen anpassen.

Letztlich machen die gleichen Merkmale, die diese KI-Nachbildungen für die Forschung so wertvoll machen, sie auch zu mächtigen Werkzeugen der Täuschung.

Da digitale Kopien immer überzeugender werden, wird es immer schwieriger, zwischen authentischer menschlicher Interaktion und künstlicher Intelligenz zu unterscheiden, wie wir an der Flut von Fälschungen beobachten konnten.

Was wäre, wenn eine solche Technologie dazu verwendet würde, jemanden gegen seinen Willen zu klonen? Was sind die Auswirkungen der Erstellung digitaler Kopien, die echten Menschen genau nachempfunden sind?

Das Forschungsteam von Stanford und DeepMind ist sich dieser Risiken bewusst. Ihr Rahmenwerk erfordert eine klare Zustimmung der Teilnehmer und ermöglicht es ihnen, ihre Daten zurückzuziehen. Die Replikation von Persönlichkeiten wird mit denselben Datenschutzbedenken behandelt wie sensible medizinische Informationen.

Dies bietet zumindest einen gewissen theoretischen Schutz gegen bösartigere Formen des Missbrauchs. Aber in In jedem Fall dringen wir immer tiefer in die unerforschten Gebiete der Mensch-Maschine-Interaktion vor, und die langfristigen Auswirkungen sind noch weitgehend unbekannt.