Die Ära der generativen KI schreitet voran, und eine Vielzahl von Unternehmen hat sich dieser Entwicklung angeschlossen, während die Modelle selbst immer vielfältiger werden.

Inmitten dieses KI-Booms haben viele Unternehmen ihre Modelle als "Open Source" angepriesen, aber was bedeutet das in der Praxis wirklich?

Das Konzept von Open Source hat seine Wurzeln in der Software-Entwicklungsgemeinschaft. Bei herkömmlicher Open-Source-Software ist der Quellcode für jedermann frei zugänglich und kann eingesehen, verändert und weitergegeben werden.

Im Wesentlichen ist Open-Source ein kollaborativer Wissensaustausch, der durch Software-Innovationen vorangetrieben wird und zu Entwicklungen wie dem Linux-Betriebssystem, dem Firefox-Webbrowser und der Programmiersprache Python geführt hat.

Die Anwendung des Open-Source-Ethos auf die heutigen massiven KI-Modelle ist jedoch alles andere als einfach.

Diese Systeme werden häufig auf riesigen Datensätzen mit Terabytes oder Petabytes an Daten trainiert, wobei komplexe neuronale Netzwerkarchitekturen mit Milliarden von Parametern zum Einsatz kommen.

Die erforderlichen Computerressourcen kosten Millionen von Dollar, die Talente sind rar, und das geistige Eigentum ist oft gut geschützt.

Wir können dies bei OpenAI beobachten, das, wie der Name schon sagt, ein KI-Forschungslabor war, das sich weitgehend dem Ethos der offenen Forschung verschrieben hat.

Allerdings ist das Ethos schnell erodiert als das Unternehmen das Geld roch und Investitionen anziehen musste, um seine Ziele zu erreichen.

Warum? Weil Open-Source-Produkte nicht auf Gewinn ausgerichtet sind und KI teuer und wertvoll ist.

Mit der explosionsartigen Entwicklung der generativen KI veröffentlichen Unternehmen wie Mistral, Meta, BLOOM und xAI Open-Source-Modelle, um die Forschung voranzutreiben und gleichzeitig zu verhindern, dass Unternehmen wie Microsoft und Google zu viel Einfluss erlangen.

Aber wie viele dieser Modelle sind wirklich quelloffen, und zwar nicht nur dem Namen nach?

Klärung der Frage, wie offen Open-Source-Modelle wirklich sind

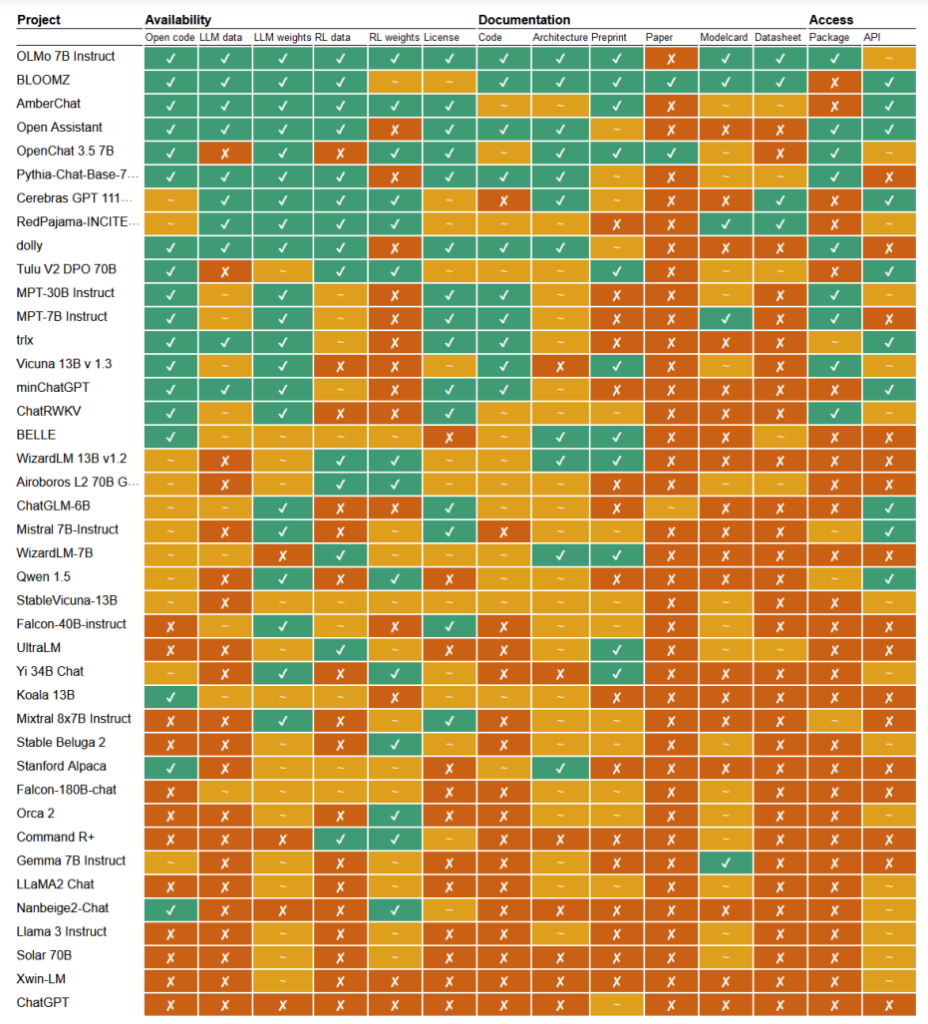

In einer kürzlich erschienenen StudieDie Forscher Mark Dingemanse und Andreas Liesenfeld von der Radboud-Universität in den Niederlanden analysierten zahlreiche bekannte KI-Modelle, um zu untersuchen, wie offen sie sind. Sie untersuchten mehrere Kriterien, wie z. B. die Verfügbarkeit von Quellcode, Trainingsdaten, Modellgewichten, Forschungsarbeiten und APIs.

So wurde beispielsweise festgestellt, dass das LLaMA-Modell von Meta und das Gemma-Modell von Google lediglich "offen gewichtet" sind, was bedeutet, dass das trainierte Modell öffentlich zur Verwendung freigegeben wird, ohne dass vollständige Transparenz in Bezug auf seinen Code, den Trainingsprozess, die Daten und die Feinabstimmungsmethoden besteht.

Am anderen Ende des Spektrums hoben die Forscher BLOOM hervor, ein großes mehrsprachiges Modell, das von einer Zusammenarbeit von mehr als 1.000 Forschern weltweit entwickelt wurde, als ein Beispiel für echte Open-Source-KI. Jedes Element des Modells ist für die Überprüfung und weitere Forschung frei zugänglich.

In dem Papier wurden mehr als 30 Modelle (sowohl Text- als auch Bildmodelle) bewertet, die jedoch die enorme Vielfalt der Modelle zeigen, die den Anspruch erheben, Open-Source zu sein:

- BloomZ (BigScience): Vollständig offen für alle Kriterien, einschließlich Code, Trainingsdaten, Modellgewichte, Forschungsunterlagen und API. Hervorgehoben als ein Beispiel für echte Open-Source-KI.

- OLMo (Allen Institute for AI): Offener Code, Trainingsdaten, Gewichte und Forschungspapiere. API nur teilweise offen.

- Mistral 7B-Instruct (Mistral AI): Offene Modellgewichte und API. Code und Forschungsunterlagen nur teilweise offen. Trainingsdaten sind nicht verfügbar.

- Orca 2 (Microsoft): Teilweise offene Modellgewichte und Forschungspapiere. Code, Trainingsdaten und API geschlossen.

- Gemma 7B instruieren (Google): Teilweise offener Code und Gewichte. Trainingsdaten, Forschungspapiere und API geschlossen. Wird von Google eher als "offen" denn als "Open Source" bezeichnet.

- Llama 3 Anleitung (Meta): Teilweise offene Gewichte. Code, Trainingsdaten, Forschungspapiere und API geschlossen. Ein Beispiel für ein "offenes Gewichtungsmodell" ohne größere Transparenz.

Mangelnde Transparenz

Die mangelnde Transparenz bei KI-Modellen, insbesondere bei denen, die von großen Technologieunternehmen entwickelt werden, gibt Anlass zu ernsten Bedenken hinsichtlich der Rechenschaftspflicht und der Aufsicht.

Ohne vollständigen Zugang zum Code des Modells, zu den Trainingsdaten und anderen Schlüsselkomponenten ist es äußerst schwierig zu verstehen, wie diese Modelle funktionieren und Entscheidungen treffen. Dies macht es schwierig, mögliche Verzerrungen, Fehler oder den Missbrauch von urheberrechtlich geschütztem Material zu erkennen und zu beheben.

Urheberrechtsverletzungen bei KI-Trainingsdaten sind ein Paradebeispiel für die Probleme, die sich aus diesem Mangel an Transparenz ergeben. Viele proprietäre KI-Modelle, wie GPT-3.5/4/40/Claude 3/Gemini, wurden wahrscheinlich auf urheberrechtlich geschütztem Material trainiert.

Da die Schulungsdaten jedoch unter Verschluss gehalten werden, ist es nahezu unmöglich, bestimmte Daten in diesem Material zu identifizieren.

Der Bericht der New York Times aktueller Rechtsstreit gegen OpenAI zeigt, welche Auswirkungen diese Herausforderung in der Praxis hat. OpenAI beschuldigte die NYT, mit Prompt-Engineering-Angriffen Trainingsdaten offenzulegen und ChatGPT dazu zu bringen, ihre Artikel wortwörtlich zu reproduzieren, um so zu beweisen, dass die Trainingsdaten von OpenAI urheberrechtlich geschütztes Material enthalten.

"Die Times hat jemanden dafür bezahlt, die Produkte von OpenAI zu hacken", so OpenAI.

In seiner Antwort sagte Ian Crosby, der leitende Rechtsberater der NYT: "Was OpenAI bizarrerweise als 'Hacking' bezeichnet, ist einfach die Verwendung der Produkte von OpenAI, um nach Beweisen dafür zu suchen, dass sie die urheberrechtlich geschützten Werke der Times gestohlen und reproduziert haben. Und das ist genau das, was wir gefunden haben."

Das ist nur ein Beispiel aus einem riesigen Stapel von Klagen, die derzeit zum Teil aufgrund der undurchsichtigen, undurchdringlichen Natur von KI-Modellen blockiert werden.

Dies ist nur die Spitze des Eisbergs. Ohne solide Transparenz und Maßnahmen zur Rechenschaftspflicht riskieren wir eine Zukunft, in der unerklärliche KI-Systeme Entscheidungen treffen, die unser Leben, unsere Wirtschaft und unsere Gesellschaft tiefgreifend beeinflussen, aber von der Kontrolle abgeschirmt bleiben.

Aufruf zur Offenheit

Unternehmen wie Google und OpenAI wurden aufgefordert, die Zugang zum Innenleben ihrer Modelle gewähren für die Zwecke der Sicherheitsbewertung.

Die Wahrheit ist jedoch, dass selbst KI-Unternehmen nicht wirklich verstehen, wie ihre Modelle funktionieren.

Dies wird als "Blackbox"-Problem bezeichnet, das auftritt, wenn versucht wird, die spezifischen Entscheidungen des Modells auf eine für den Menschen verständliche Weise zu interpretieren und zu erklären.

Ein Entwickler kann zum Beispiel wissen, dass ein Deep-Learning-Modell genau ist und gute Leistungen erbringt, aber er kann nicht genau sagen, welche Merkmale das Modell für seine Entscheidungen verwendet.

Anthropic, das die Claude-Modelle entwickelt hat, hat kürzlich ein Experiment durchgeführt um herauszufinden, wie Claude 3 Sonnet funktioniert, und erklärt: "Wir behandeln KI-Modelle meist wie eine Blackbox: Es wird etwas eingegeben und eine Antwort kommt heraus, und es ist nicht klar, warum das Modell diese bestimmte Antwort gibt und nicht eine andere. Das macht es schwer, darauf zu vertrauen, dass diese Modelle sicher sind: Wenn wir nicht wissen, wie sie funktionieren, woher wissen wir dann, dass sie keine schädlichen, voreingenommenen, unwahren oder anderweitig gefährlichen Antworten geben werden? Wie können wir darauf vertrauen, dass sie sicher und zuverlässig sind?"

Es ist wirklich ein bemerkenswertes Eingeständnis, dass der Erfinder einer Technologie sein Produkt im Zeitalter der KI nicht versteht.

Dieses anthropische Experiment hat gezeigt, dass die objektive Erklärung von Ergebnissen eine äußerst schwierige Aufgabe ist. Tatsächlich schätzte Anthropic, dass das Öffnen der Blackbox" mehr Rechenleistung verbrauchen würde als das Trainieren des Modells selbst!

Die Entwickler versuchen, das Blackbox-Problem aktiv zu bekämpfen, indem sie Forschungsarbeiten wie "Explainable AI" (XAI) durchführen, die darauf abzielen, Techniken und Werkzeuge zu entwickeln, um KI-Modelle transparenter und interpretierbar zu machen.

XAI-Methoden sollen Einblicke in den Entscheidungsprozess des Modells geben, die einflussreichsten Merkmale hervorheben und für den Menschen verständliche Erklärungen liefern. XAI wurde bereits auf Modelle angewandt, die in hochrangigen Anwendungen wie die Arzneimittelentwicklungwo das Verständnis für die Funktionsweise eines Modells entscheidend für die Sicherheit sein kann.

Open-Source-Initiativen sind für XAI und andere Forschungen, die versuchen, die Blackbox zu durchdringen und KI-Modelle transparent zu machen, unerlässlich.

Ohne Zugang zum Code des Modells, zu den Trainingsdaten und anderen Schlüsselkomponenten können Forscher keine Techniken entwickeln und testen, die erklären, wie KI-Systeme wirklich funktionieren, und die spezifischen Daten identifizieren, auf denen sie trainiert wurden.

Vorschriften könnten die Open-Source-Situation weiter verwirren

Die Europäische Union das kürzlich verabschiedete AI-Gesetz wird neue Vorschriften für KI-Systeme einführen, die speziell auf Open-Source-Modelle ausgerichtet sind.

Das Gesetz sieht vor, dass Open-Source-Allzweckmodelle bis zu einer bestimmten Größe von den umfangreichen Transparenzanforderungen ausgenommen werden.

Wie Dingemanse und Liesenfeld in ihrer Studie jedoch betonen, ist die genaue Definition von "Open-Source-KI" im Rahmen des KI-Gesetzes noch unklar und könnte zu einem Streitpunkt werden.

Das Gesetz definiert Open-Source-Modelle derzeit als solche, die unter einer "freien und offenen" Lizenz veröffentlicht werden, die es den Nutzern erlaubt, das Modell zu verändern. Es enthält jedoch keine Anforderungen für den Zugang zu Trainingsdaten oder anderen Schlüsselkomponenten.

Diese Zweideutigkeit lässt Raum für Interpretationen und potenzielle Lobbyarbeit durch Unternehmensinteressen. Die Forscher warnen, dass die Verfeinerung der Open-Source-Definition im KI-Gesetz "wahrscheinlich einen einzigen Druckpunkt bilden wird, auf den Konzernlobbys und große Unternehmen abzielen werden".

Es besteht die Gefahr, dass ohne klare, robuste Kriterien dafür, was wirklich quelloffene KI ist, die Verordnungen unbeabsichtigt Schlupflöcher oder Anreize für Unternehmen schaffen könnten, sich auf "Open-Washing" einzulassen - indem sie Offenheit für die rechtlichen und öffentlichkeitswirksamen Vorteile beanspruchen, während sie wichtige Aspekte ihrer Modelle weiterhin proprietär halten.

Darüber hinaus bedeutet der globale Charakter der KI-Entwicklung, dass unterschiedliche Vorschriften in den verschiedenen Ländern die Landschaft weiter verkomplizieren könnten.

Wenn große KI-Produzenten wie die Vereinigten Staaten und China unterschiedliche Konzepte für Offenheit und Transparenzanforderungen verfolgen, könnte dies zu einem fragmentierten Ökosystem führen, in dem der Grad der Offenheit je nach Herkunftsland eines Modells stark variiert.

Die Autoren der Studie betonen, dass die Regulierungsbehörden eng mit der wissenschaftlichen Gemeinschaft und anderen Interessengruppen zusammenarbeiten müssen, um sicherzustellen, dass alle Open-Source-Bestimmungen in der KI-Gesetzgebung auf einem tiefen Verständnis der Technologie und den Grundsätzen der Offenheit beruhen.

Wie Dingemanse und Liesenfeld in einer Studie feststellen Diskussion mit der NaturMan kann mit Fug und Recht behaupten, dass der Begriff Open Source in den Ländern, die unter den EU AI Act fallen, ein noch nie dagewesenes rechtliches Gewicht erhalten wird.

Wie sich dies in der Praxis auswirkt, wird erhebliche Auswirkungen auf die künftige Richtung der KI-Forschung und -Einführung haben.