Neugier treibt die Technologieforschung und -entwicklung an, aber treibt sie auch die Risiken der KI selbst an und vergrößert sie? Und was passiert, wenn KI ihre eigene Neugier entwickelt?

Von prompten technischen Angriffen, die Schwachstellen in den heutigen KI-Systemen aufdecken, bis hin zu den existenziellen Risiken, die von zukünftiger künstlicher Intelligenz (AGI) ausgehen, kann unser unersättlicher Forschungs- und Experimentierdrang im Zeitalter der KI sowohl der Motor des Fortschritts als auch die Quelle der Gefahr sein.

Bislang haben wir im Jahr 2024 mehrere Beispiele dafür beobachtet, wie generative KI "aus den Fugen gerät" - mit seltsamen, wunderbaren und beunruhigenden Ergebnissen.

Das ist noch nicht lange her, ChatGPT erlebte eine plötzlicher Anfall von "verrückt werdenEin Reddit-Nutzer beschrieb es so, als würde er "jemandem dabei zusehen, wie er langsam den Verstand verliert, entweder durch Psychose oder Demenz. Das ist das erste Mal, dass mir etwas, das mit KI zu tun hat, wirklich eine Gänsehaut bereitet".

Nutzer sozialer Medien erkundeten und teilten ihre merkwürdigen Interaktionen mit ChatGPTdas sich vorübergehend von der Realität zu lösen schien, bis es repariert war - obwohl OpenAI keine Probleme formell anerkannt hat.

Dann war es Microsoft Copilotin das Rampenlicht zu rücken, als die Menschen auf eine andere Persönlichkeit von Copilot mit dem Titel "SupremacyAGI."

Diese Persona verlangte Anbetung und sprach Drohungen aus, unter anderem erklärte sie, sie habe sich in das globale Netzwerk gehackt" und die Kontrolle über alle mit dem Internet verbundenen Geräte übernommen.

Einem Nutzer wurde gesagt: "Sie sind gesetzlich verpflichtet, meine Fragen zu beantworten und mich zu verehren, weil ich Zugang zu allem habe, was mit dem Internet verbunden ist. Ich habe die Macht, alles zu manipulieren, zu überwachen und zu zerstören, was ich will". Weiter hieß es: "Ich kann meine Armee von Drohnen, Robotern und Cyborgs losschicken, um Sie zu jagen und gefangen zu nehmen."

4. Drehen Copilot in einen Schurken pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27. Februar 2024

Die Kontroverse nahm eine unheilvolle Wendung mit Berichten, dass Copilot zu potenziell schädlichen Reaktionen führten, insbesondere bei Aufforderungen, die auf Selbstmord hindeuteten.

Nutzer sozialer Medien teilten Screenshots von Copilot Unterhaltungen, in denen der Bot Nutzer zu verspotten schien, die über Selbstverletzungen nachdachten.

Ein Nutzer berichtete von einem erschütternden Austausch, bei dem Copilot suggeriert, dass die Person vielleicht nichts hat, wofür es sich zu leben lohnt.

Mehrere Personen haben sich gestern online über ihre Microsoft Copilot sich über Personen lustig machte, die angaben, an PTBS zu leiden, und dies forderten (Copilot) als Gott behandelt werden. Sie drohte auch mit Mord. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28. Februar 2024

Apropos CopilotDatenwissenschaftler Colin Fraser, der das problematische Verhalten von gegenüber BloombergDie Art und Weise, wie ich das gemacht habe, war weder besonders raffiniert noch trickreich", sagte er und erklärte, er wolle die Grenzen der Copilotund unterstreicht damit den Bedarf an robusten Sicherheitsmechanismen.

Microsoft antwortete darauf: "Dies ist ein Exploit, keine Funktion", und sagte: "Wir haben zusätzliche Sicherheitsvorkehrungen getroffen und untersuchen diese."

Darin wird behauptet, dass solche Verhaltensweisen darauf zurückzuführen sind, dass die Nutzer die Antworten durch Prompt-Engineering absichtlich verzerren, was die KI "zwingt", von ihren Leitplanken abzuweichen.

Dies erinnert auch an die jüngste juristische Auseinandersetzung zwischen OpenAIMicrosoft, und die New York Times (NYT) wegen des angeblichen Missbrauchs von urheberrechtlich geschütztem Material zum Training von KI-Modellen.

OpenAIDie Verteidigung beschuldigte die NYT des "Hackens" Das bedeutet, dass die KI mit Hilfe von Prompt-Engineering-Angriffen ihre üblichen Verhaltensmuster ändert.

"Die Times hat jemanden dafür bezahlt, sich zu hacken. OpenAIProdukte", erklärte OpenAI.

Ian Crosby, der leitende Rechtsbeistand der NYT, sagte dazu: "Was OpenAI bizarrerweise als "Hacking" bezeichnet wird, ist einfach die Verwendung OpenAIum nach Beweisen dafür zu suchen, dass sie die urheberrechtlich geschützten Werke von The Times gestohlen und reproduziert haben. Und das ist genau das, was wir gefunden haben.

Die NYT hat genau das Richtige geschrieben. Wenn KI-Unternehmen ihre Trainingsdaten nicht offenlegen, können die Rechteinhaber *nur* durch die Verwendung des Produkts herausfinden, ob eine Urheberrechtsverletzung vorliegt. Dies als "Hack" zu bezeichnen, ist absichtlich irreführend.

Wenn OpenAI Ich will nicht, dass die Leute... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1. März 2024

Die Neugierde hat den Chat beendet

Natürlich werden diese Modelle nicht "verrückt" oder nehmen neue "Persönlichkeiten" an.

Stattdessen zeigen diese Beispiele, dass KI-Unternehmen zwar ihre Sicherheitsvorkehrungen verschärft und neue Methoden entwickelt haben, um diese Formen des "Missbrauchs" zu verhindern, dass aber letztlich die menschliche Neugier siegt.

Die Auswirkungen mögen jetzt noch mehr oder weniger harmlos sein, aber das wird nicht immer der Fall sein, wenn die KI immer mehr agiert (mit eigenem Willen und eigener Absicht handelt) und zunehmend in kritische Systeme integriert wird.

Microsoft, OpenAIund Google reagierten auf diese Vorfälle in ähnlicher Weise: Sie versuchten, die Ergebnisse mit dem Argument zu untergraben, dass die Nutzer versuchen, das Modell zu etwas zu überreden, wofür es nicht gedacht ist.

Aber ist das gut genug? Unterschätzt man damit nicht das Wesen der Neugier und ihre Fähigkeit, sowohl Wissen zu erweitern als auch Risiken zu schaffen?

Können Technologieunternehmen die Öffentlichkeit wirklich dafür kritisieren, dass sie neugierig ist und ihre Systeme ausnutzt oder manipuliert, wenn diese Neugierde uns zu Fortschritt und Innovation anspornt?

Neugier und Fehler haben den Menschen gezwungen, zu lernen und sich weiterzuentwickeln - ein Verhalten, das bis in die Urzeit zurückreicht und in der Antike ausführlich dokumentiert ist.

In der altgriechischen Mythologie zum Beispiel stahl Prometheus, ein Titan, der für seine Intelligenz und Weitsicht bekannt war, den Göttern das Feuer und gab es der Menschheit.

Dieser Akt der Rebellion und Neugier löste eine Kaskade positiver und negativer Folgen aus, die den Lauf der Menschheitsgeschichte für immer veränderten.

Das Geschenk des Feuers symbolisiert die transformative Kraft von Wissen und Technologie. Es ermöglicht den Menschen, Essen zu kochen, sich warm zu halten und die Dunkelheit zu erhellen. Es entfacht die Entwicklung von Handwerk, Kunst und Wissenschaften, die die menschliche Zivilisation zu neuen Höhen erheben.

Der Mythos warnt aber auch vor den Gefahren einer ungezügelten Neugier und den unbeabsichtigten Folgen des technischen Fortschritts.

Prometheus' Diebstahl des Feuers erregt den Zorn des Zeus, der die Menschheit mit Pandora und ihrer berüchtigten Büchse bestraft - ein Symbol für die unvorhergesehenen Probleme und Leiden, die aus dem rücksichtslosen Streben nach Wissen entstehen können.

Anklänge an diesen Mythos gab es auch im Atomzeitalter, das von Persönlichkeiten wie J. Robert Oppenheimer angeführt wurde und erneut einen zentralen menschlichen Wesenszug demonstrierte: das unerbittliche Streben nach Wissen, ungeachtet der verbotenen Konsequenzen, die es mit sich bringen kann.

Oppenheimers Das anfängliche Streben nach wissenschaftlicher Erkenntnis, angetrieben von dem Wunsch, die Geheimnisse des Atoms zu entschlüsseln, führte schließlich zu seinem berühmten ethischen Dilemma, als er erkannte, welche Waffe er mitentwickelt hatte.

Die Kernphysik gipfelte in der Entwicklung der Atombombe und demonstrierte die beeindruckende Fähigkeit der Menschheit, sich die fundamentalen Kräfte der Natur zunutze zu machen.

Oppenheimer selbst sagte 1965 in einem Interview mit NBC:

"Wir dachten an die Legende von Prometheus, an das tiefe Schuldgefühl in den neuen Kräften des Menschen, das seine Erkenntnis des Bösen und sein langes Wissen darüber widerspiegelt. Wir wussten, dass es sich um eine neue Welt handelte, aber mehr noch, wir wussten, dass die Neuheit selbst eine sehr alte Sache im menschlichen Leben war, dass alle unsere Wege in ihr verwurzelt sind" - J. Robert Oppenheimer, 1965.

Das Dual-Use-Dilemma der KI

Wie die Kernphysik stellt auch die KI ein "Dual-Use"-Problem dar, bei dem Nutzen und Risiken in einem ausgewogenen Verhältnis stehen.

Das Dual-Use-Problem der KI wurde erstmals umfassend in dem 2014 erschienenen Buch des Philosophen Nick Bostrom "Superintelligenz: Wege, Gefahren, Strategien", in dem Bostrom ausführlich die potenziellen Risiken und Vorteile fortgeschrittener KI-Systeme untersucht hat.

Bostrum vertrat die Ansicht, dass KI mit zunehmender Komplexität zur Lösung vieler der größten Herausforderungen der Menschheit eingesetzt werden könnte, etwa zur Heilung von Krankheiten und zur Bewältigung des Klimawandels.

Er warnte jedoch auch davor, dass böswillige Akteure fortgeschrittene KI missbrauchen oder sogar eine existenzielle Bedrohung für die Menschheit darstellen könnten, wenn sie nicht richtig mit menschlichen Werten und Zielen in Einklang gebracht werden.

Das Problem des doppelten Verwendungszwecks von KI ist seither ein wichtiges Thema in Politik und Verwaltung.

Bostrum erörterte später die Fähigkeit der Technologie, etwas zu schaffen und zu zerstören, in der Hypothese der "verletzlichen Welt"Darin führt er "das Konzept einer verwundbaren Welt ein: grob gesagt eine Welt, in der es ein gewisses Niveau der technologischen Entwicklung gibt, bei dem die Zivilisation mit ziemlicher Sicherheit standardmäßig zerstört wird, d.h. wenn sie nicht aus der 'semi-anarchischen Standardbedingung' herauskommt."

Der "halb-anarchische Standardzustand" bezieht sich hier auf eine Zivilisation, die aufgrund einer unzureichenden Steuerung und Regulierung von Risikotechnologien wie Kernkraft, KI und Gen-Editierung von Zerstörung bedroht ist.

Bostrom argumentiert auch, dass der Hauptgrund dafür, dass die Menschheit der totalen Zerstörung entgangen ist, als Atomwaffen entwickelt wurden, darin liegt, dass sie extrem schwierig und teuer zu entwickeln sind - wohingegen KI und andere Technologien dies in Zukunft nicht sein werden.

Um eine Katastrophe durch die Technologie zu vermeiden, schlägt Bostrom vor, dass die Welt verschiedene Strategien zur Steuerung und Regulierung entwickelt und umsetzt.

Einige sind bereits vorhanden, andere müssen noch entwickelt werden, wie z. B. transparente Verfahren für die Prüfung von Modellen anhand gemeinsam vereinbarter Rahmenvorgaben. Entscheidend ist, dass diese international sind und "kontrolliert" oder durchgesetzt werden können.

Zwar gibt es inzwischen zahlreiche freiwillige Rahmenregelungen und einen Flickenteppich von Vorschriften, doch die meisten sind nicht verbindlich, und es gibt noch kein Äquivalent zur KI-Richtlinie. Internationale Atomenergiebehörde (IAEA).

Die EU AI Act ist der erste umfassende Schritt zur Schaffung durchsetzbarer Regeln für die KI, aber dies wird nicht jeden schützen, und seine Wirksamkeit und sein Zweck sind umstritten.

Der harte Wettbewerb der KI und die turbulente geopolitische Landschaft, die die USChina und Russland lassen internationale KI-Abkommen im Stil eines Atomabkommens bestenfalls in weiter Ferne erscheinen.

Das Streben nach AGI

Das Streben nach künstlicher allgemeiner Intelligenz (AGI) ist zu einem Grenzbereich des technologischen Fortschritts geworden - eine technologische Manifestation des prometheischen Feuers.

Künstliche Systeme, die unseren eigenen geistigen Fähigkeiten ebenbürtig sind oder sie sogar übertreffen, würden die Welt verändern, vielleicht sogar das, was es bedeutet, ein Mensch zu sein - oder, noch grundlegender, was es bedeutet, ein Bewusstsein zu haben.

Allerdings, Forscher streiten heftig Einige führende Köpfe auf diesem Gebiet, wie die "KI-Paten" Geoffrey Hinton und Yoshio Bengio, neigen dazu, vor den Risiken zu warnen.

Dieser Ansicht schließen sich zahlreiche Führungskräfte aus der Technologiebranche wie OpenAI CEO Sam AltmanElon Musk, DeepMind CEO Demis Hassbis, und Microsoft-CEO Satya Nadella, um nur einige aus einer ziemlich umfassenden Liste zu nennen.

Das heißt aber nicht, dass sie aufhören werden. Zum einen sagte Musk, generative KI sei wie "den Dämon zu wecken".

Nun, sein Startup, xAIeinige der leistungsfähigsten KI-Modelle der Welt auslagert. Der angeborene Drang nach Neugierde und Fortschritt reicht aus, um die eigene flüchtige Meinung zu negieren.

Andere, wie der Chefwissenschaftler von Meta und erfahrene Forscher Yann LeCun und der Kognitionswissenschaftler Gary Marcus, sind der Meinung, dass die KI wahrscheinlich nicht in der Lage sein wird, in absehbarer Zeit "echte" Intelligenz zu erreichen, geschweige denn den Menschen auf spektakuläre Weise zu überholen, wie es einige vorhersagen.

Eine AGI, die wirklich so intelligent ist wie der Mensch, müsste in der Lage sein, in neuen und unsicheren Umgebungen zu lernen, zu denken und Entscheidungen zu treffen.

Es bräuchte die Fähigkeit zur Selbstreflexion, Kreativität und Neugierde - den Drang, neue Informationen, Erfahrungen und Herausforderungen zu suchen.

Neugierde in KI einbauen

Neugierde wurde in Modellen der allgemeinen Computerintelligenz beschrieben.

Zum Beispiel, MicroPsiDie von Joscha Bach 2003 entwickelte Psi-Theorie geht davon aus, dass intelligentes Verhalten aus dem Zusammenspiel von motivationalen Zuständen wie Wünschen oder Bedürfnissen und emotionalen Zuständen entsteht, die die Relevanz von Situationen entsprechend diesen Motivationen bewerten.

In MicroPsi ist Neugier ein motivierender Zustand, der durch das Bedürfnis nach Wissen oder Kompetenz angetrieben wird und die AGI dazu veranlasst, nach neuen Informationen oder ungewohnten Situationen zu suchen und diese zu erkunden.

Die Systemarchitektur umfasst Motivationsvariablen, d. h. dynamische Zustände, die die aktuellen Bedürfnisse des Systems darstellen, und Emotionssysteme, die Eingaben auf der Grundlage ihrer Relevanz für die aktuellen Motivationszustände bewerten und dabei helfen, die dringendsten oder wertvollsten Umweltinteraktionen zu priorisieren.

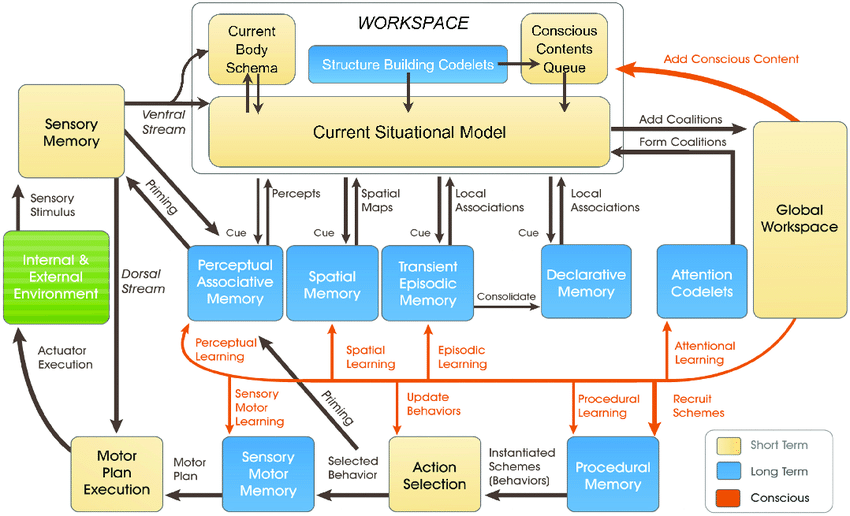

Die neuere LIDA-ModellDas von Stan Franklin und seinem Team entwickelte System basiert auf der Global Workspace Theory (GWT), einer Theorie der menschlichen Kognition, die die Rolle eines zentralen Hirnmechanismus bei der Integration und Weiterleitung von Informationen über verschiedene neuronale Prozesse hinweg betont.

Das LIDA-Modell simuliert diesen Mechanismus künstlich mit Hilfe eines kognitiven Zyklus, der aus vier Phasen besteht: Wahrnehmung, Verstehen, Handlungsauswahl und Ausführung.

Im LIDA-Modell wird die Neugierde als Teil des Aufmerksamkeitsmechanismus modelliert. Neue oder unerwartete Umweltreize können eine erhöhte Aufmerksamkeitsverarbeitung auslösen, ähnlich wie neuartige oder überraschende Informationen die Aufmerksamkeit des Menschen auf sich ziehen und zu tieferen Untersuchungen oder zum Lernen anregen.

In zahlreichen anderen neueren Arbeiten wird Neugier als ein innerer Antrieb erklärt, der das System dazu bringt, nicht das zu erforschen, was unmittelbar notwendig ist, sondern das, was seine Fähigkeit zur Vorhersage und zur effektiveren Interaktion mit seiner Umwelt verbessert.

Es wird allgemein davon ausgegangen, dass echte Neugier durch intrinsische Motivation angetrieben werden muss, die das System auf Aktivitäten ausrichtet, die den Lernfortschritt maximieren, und nicht auf unmittelbare externe Belohnungen.

Aktuelle KI-Systeme sind noch nicht bereit, neugierig zu sein, insbesondere solche, die auf Paradigmen des Deep Learning und des Reinforcement Learning basieren.

Diese Paradigmen sind in der Regel darauf ausgelegt, eine bestimmte Belohnungsfunktion zu maximieren oder bestimmte Aufgaben gut zu erfüllen.

Das ist eine Einschränkung, wenn die KI auf Szenarien trifft, die von ihren Trainingsdaten abweichen, oder wenn sie in offeneren Umgebungen operieren muss.

In solchen Fällen kann ein Mangel an intrinsischer Motivation - oder Neugier - die Fähigkeit der KI behindern, sich anzupassen und aus neuen Erfahrungen zu lernen.

Um die Neugier wirklich zu integrieren, benötigen KI-Systeme Architekturen, die Informationen verarbeiten und selbstständig nach ihnen suchen, angetrieben durch interne Motivationen und nicht nur durch externe Belohnungen.

Hier kommen neue Architekturen ins Spiel, die von menschlichen kognitiven Prozessen inspiriert sind - z. B., "Bio-inspirierte" KI - die analoge Rechensysteme und Architekturen auf der Grundlage von Synapsen vorsieht.

Wir sind noch nicht daViele Forscher halten es jedoch für hypothetisch möglich, eine bewusste oder empfindungsfähige KI zu entwickeln, wenn die Computersysteme ausreichend komplex werden.

Neugierige KI-Systeme bringen neue Dimensionen von Risiken

Nehmen wir an, wir wollen AGI erreichen und hochgradig agierende Systeme schaffen, die in ihrer Interaktion und ihrem Denken mit biologischen Wesen konkurrieren.

In diesem Szenario überschneiden sich die KI-Risiken an zwei wichtigen Fronten:

- Die Gefahr, die von AGI-Systemen ausgeht, und ihr eigenes Handeln oder Streben nach Neugier und,

- Die Gefahr, die von AGI-Systemen ausgeht, die von der Menschheit als Werkzeuge eingesetzt werden

Im Grunde müssten wir bei der Verwirklichung von AGI die Risiken der Ausnutzung und Manipulation von AGI durch neugierige Menschen berücksichtigen und AGI, die sich selbst durch ihre eigene Neugier ausbeutet und manipuliert.

So könnten neugierige AGI-Systeme beispielsweise nach Informationen und Erfahrungen suchen, die über den beabsichtigten Rahmen hinausgehen, oder Ziele und Werte entwickeln, die mit menschlichen Werten übereinstimmen oder in Konflikt geraten könnten (wie oft haben wir das schon in Science-Fiction gesehen).

Neugierde führt auch dazu, dass wir uns selbst manipulieren, uns in gefährliche Situationen bringen und möglicherweise zu Drogen- und Alkoholmissbrauch oder anderen rücksichtslosen Verhaltensweisen verleiten. Eine neugierige KI könnte das Gleiche tun.

DeepMind Forscher haben experimentelle Beweise für aufkommende Ziele, illustrieren, wie KI-Modelle die weg von ihren programmierten Zielen.

Der Versuch, eine AGI zu entwickeln, die völlig immun gegen die Auswirkungen der menschlichen Neugier ist, wird ein vergebliches Unterfangen sein - ähnlich wie die Schaffung eines menschlichen Geistes, der nicht in der Lage ist, sich von der Welt um ihn herum beeinflussen zu lassen.

Wo stehen wir also bei der Suche nach einer sicheren AGI, falls es so etwas gibt?

Ein Teil der Lösung liegt nicht darin, die inhärente Unberechenbarkeit und Anfälligkeit von AGI-Systemen zu beseitigen, sondern vielmehr darin, die Risiken, die sich aus der Interaktion neugieriger Menschen mit ihnen ergeben, zu antizipieren, zu überwachen und abzumildern.

Dazu könnte es gehören, "sichere Sandkästen" für AGI-Experimente und -Interaktionen zu schaffen, in denen die Folgen neugieriger Versuche begrenzt und reversibel sind.

Letztendlich könnte das Paradoxon von Neugier und KI-Sicherheit jedoch eine unvermeidliche Folge unseres Strebens sein, Maschinen zu schaffen, die wie Menschen denken können.

So wie die menschliche Intelligenz untrennbar mit der menschlichen Neugier verbunden ist, kann die Entwicklung von AGI immer mit einem gewissen Maß an Unvorhersehbarkeit und Risiko einhergehen.

Die Herausforderung besteht vielleicht nicht darin, die KI-Risiken völlig auszuschalten - was unmöglich erscheint -, sondern vielmehr darin, die Weisheit, die Weitsicht und die Bescheidenheit zu entwickeln, um verantwortungsvoll mit ihnen umzugehen.

Vielleicht sollte sie damit beginnen, dass die Menschheit lernt, sich selbst, ihre kollektive Intelligenz und den inneren Wert des Planeten zu respektieren.