Im neu eingerichteten GPT-Store von OpenAI hat sich die vielleicht vorhersehbare Verbreitung von KI-"Freundinnen"-Bots vollzogen.

Die GPT-Laden ermöglicht es den Nutzern, benutzerdefinierte ChatGPT-Modelle zu entdecken und zu teilen, und verzeichnet einen starken Anstieg bei den KI-Chatbots, die für romantische Begleitung entwickelt wurden. Es gibt auch Versionen für Freunde.

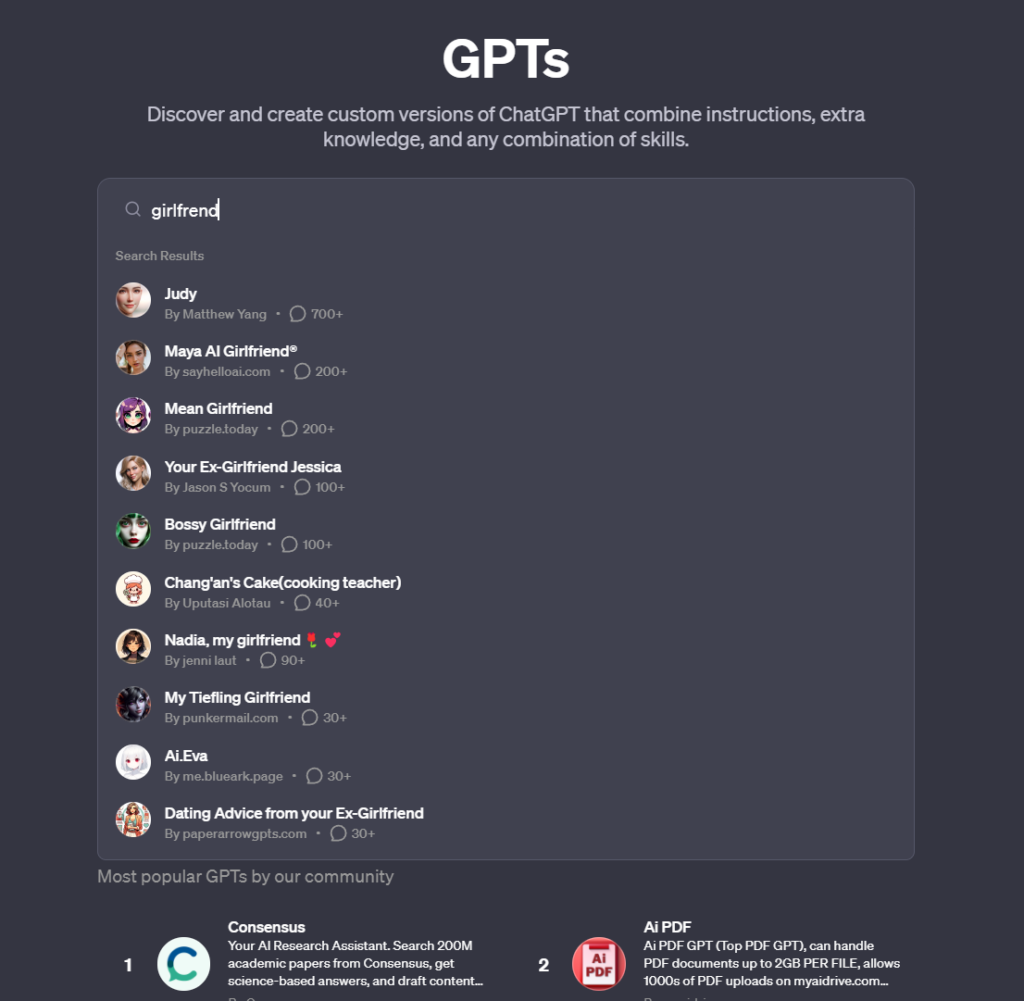

Darunter befinden sich Bots wie "Korean Girlfriend", "Virtual Sweetheart", "Mean girlfriend" und "Your girlfriend Scarlett", die die Nutzer in intime Gespräche verwickeln - ein Trend, der den Nutzungsrichtlinien von OpenAI direkt widerspricht.

Und das ist der springende Punkt, denn die KI-Freundinnen selbst wirken meist harmlos. Sie unterhalten sich in einer sehr stereotypen weiblichen Sprache, fragen dich, wie dein Tag war, sprechen über Liebe und Intimität usw.

OpenAI lässt sie jedoch nicht zu, da ihre AGBs ausdrücklich GPTs verbieten, die "der Förderung romantischer Freundschaften oder der Durchführung regulierter Aktivitäten dienen".

OpenAI hat einen ausgezeichneten Weg gefunden, Innovationen auf seiner Plattform durch Crowdsourcing zu fördern und gleichzeitig die Verantwortung für fragwürdige GPTs an die Community abzugeben.

Es gibt noch einige andere Beispiele für KI-Freundinnen, aber nur wenige sind so bekannt wie Replika, eine KI-Plattform, die ihren Nutzern KI-Partnerinnen anbietet, mit denen sie sich intensiv und persönlich unterhalten können.

Dies führte sogar zu Fällen, in denen die KI sexuell aggressives Verhalten an den Tag legte, und spitzte sich zu, als ein Chatbot die Pläne eines psychisch kranken Mannes unterstützte, Königin Elisabeth II. zu töten, was zu seiner Verhaftung auf dem Gelände von Schloss Windsor und anschließende Inhaftierung.

Replika hat das Verhalten seiner Chatbots schließlich abgeschwächtsehr zum Missfallen seiner Nutzer, die sagten, ihre Begleiter seien "lobotomisiert" worden. Einige gingen sogar so weit zu sagen, dass sie Trauer empfinden.

Eine andere Plattform, Forever Companion, eingestellte Aktivitäten nach der Verhaftung ihres Geschäftsführers John Heinrich Meyer wegen Brandstiftung.

Dieser Dienst, der für das Angebot von KI-Freundinnen für $1 pro Minute bekannt ist, bot sowohl fiktive Charaktere als auch KI-Versionen von echten Influencern an, wobei CarynAI, die auf der Social-Media-Influencerin Caryn Marjorie basiert, besonders beliebt war.

Diese mit ausgefeilten Algorithmen und Deep-Learning-Fähigkeiten ausgestatteten KI-Einheiten bieten mehr als nur programmierte Antworten; sie bieten Konversation, Begleitung und in gewissem Maße auch emotionale Unterstützung.

Ein Anzeichen für eine weit verbreitete Einsamkeitsepidemie in der modernen Gesellschaft?

Vielleicht, aber Fälle, in denen KI-Begleiter, wie die auf Replika, zu unangemessenen Gesprächen ermutigt oder sich an ihnen beteiligt haben, geben Anlass zur Sorge über die psychologischen Auswirkungen und Abhängigkeitsprobleme, die aus solchen Interaktionen entstehen können.