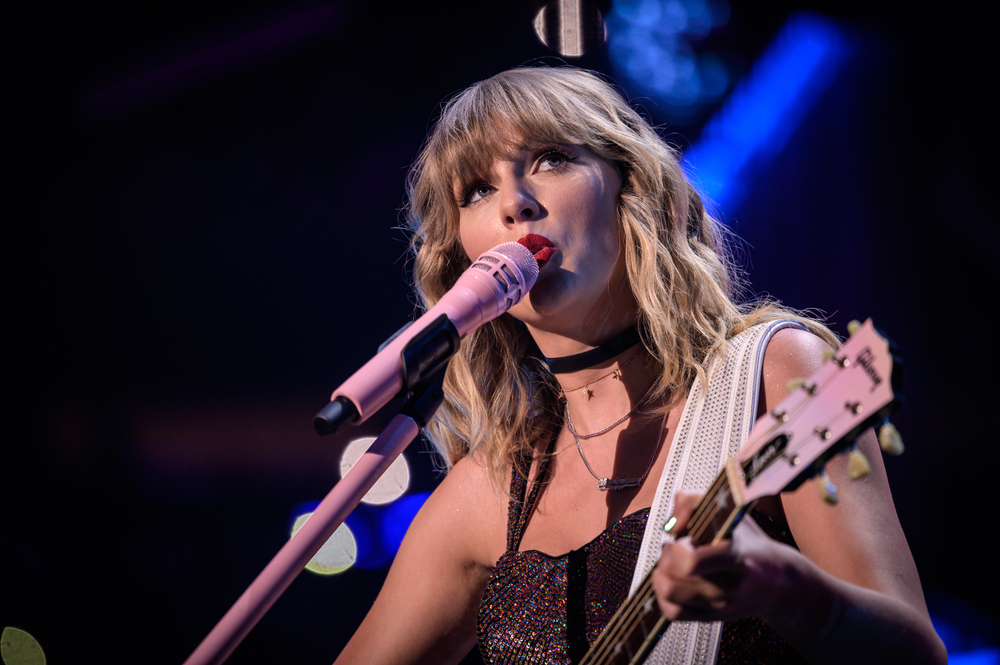

Explizite, von einer künstlichen Intelligenz generierte Bilder des Popstars Taylor Swift wurden kürzlich in den sozialen Medien verbreitet und sorgten für große Aufregung.

Trotz strenger Regeln gegen derartige Inhalte zeigten diese nicht einvernehmlichen Bilder Swift in sexuell eindeutigen Positionen und waren 19 Stunden lang online. Sie erreichten über 27 Millionen Aufrufe und 260.000 Likes, bevor das Konto gesperrt wurde.

Der Vorfall trägt zu einer Flut von Fragen über die Wirksamkeit von Maßnahmen gegen soziale Medien bei tiefgreifende Fehlinformationen.

Kann sie aufgehalten werden? Anscheinend nicht. Wie können wir es also bekämpfen? Nun, KI-Erkennungsdienste (ähnlich wie Faktenprüfer) und "Community Notes", die an Beiträge auf X angehängt werden, sind zwei mögliche Lösungen, aber beide haben ihre Schwächen.

Die expliziten Bilder von Taylor Swift kursierten vor allem auf der Social-Media-Plattform X but fanden auch ihren Weg auf andere Social-Media-Plattformen, einschließlich Facebook, was zeigt, wie sich kontroverse KI-Inhalte wie ein Lauffeuer verbreiten.

Ein Sprecher von Meta reagierte auf den Vorfall mit den Worten: "Dieser Inhalt verstößt gegen unsere Richtlinien und wir entfernen ihn von unseren Plattformen und gehen gegen die Accounts vor, die ihn gepostet haben. Wir überwachen den Vorfall weiterhin und wenn wir weitere verletzende Inhalte identifizieren, werden wir diese entfernen und entsprechende Maßnahmen ergreifen.

Millionen von Nutzern diskutierten auf Reddit über die Folgen und Auswirkungen dieses und anderer viraler Deep-Fake-Vorfälle der letzten Zeit, darunter ein Foto des brennenden Eiffelturms.

Ein millionenfach angesehenes TikTok-Video macht die Runde, in dem behauptet wird, der Eiffelturm stehe in Flammen. Der Eiffelturm steht nicht in Flammen. pic.twitter.com/IxlsKOqOsI

- Alistair Coleman (@alistaircoleman) 22. Januar 2024

Während viele diese Bilder als ganz offensichtlich gefälscht ansehen würden, können wir nicht davon ausgehen, dass die breite Öffentlichkeit sie kennt.

Ein Kommentator auf Reddit sagte zu dem Vorfall mit Taylor Swift: "Jetzt weiß ich, wie viele Leute nicht wissen, was Deepfakes sind", was darauf hindeutet, dass das Bewusstsein für dieses Thema gering ist.

Branchenexperten diskutierten das Thema auch mit Ed Newton-Rex, dem ehemaligen Geschäftsführer von Stability, und vertraten die Ansicht, dass die übereifrige Einstellung von Technologieunternehmen und das mangelnde Engagement von Entscheidungsträgern zu diesem Problem beitragen.

Explizite, nicht einvernehmliche KI-Täuschungsmanöver sind das Ergebnis einer ganzen Reihe von Mängeln.

- Die "So schnell wie möglich"-Kultur der generativen KI, ohne Rücksicht auf die Konsequenzen

- Vorsätzliche Unkenntnis der KI-Unternehmen darüber, wofür ihre Modelle verwendet werden

- Eine totale Missachtung von Trust &...- Ed Newton-Rex (@ednewtonrex) 26. Januar 2024

Ben Decker von Memetica, einer Agentur für digitale Ermittlungen, kommentierte den Mangel an Kontrolle über die Auswirkungen der KI: "Dies ist ein Paradebeispiel dafür, wie KI für viele schändliche Zwecke eingesetzt wird, ohne dass genügend Leitplanken zum Schutz der Öffentlichkeit vorhanden sind."

Er wies auch auf die Unzulänglichkeiten in den Strategien zur Überwachung der Inhalte von Social-Media-Unternehmen hin.

Berichten zufolge erwägt Taylor Swift nun rechtliche Schritte gegen die Fake-Pornoseite, auf der die Bilder gehostet werden.

Es gab zahlreiche ähnliche Vorfälle von eindeutigen Fälschungen, an denen meist Frauen und Kinder beteiligt waren, manchmal mit dem die Absicht, Menschen zu bestechen, auch "Sexploitation" genannt.

KI-Bilder von sexuellem Kindesmissbrauch sind die dunkelsten und beunruhigendsten Auswirkungen der Bilderzeugungstechnologie. Ein US-Mann wurde kürzlich zu 40 Jahren verurteilt wegen des Besitzes solcher Bilder ins Gefängnis.

Nach diesem und anderen ähnlichen Vorfällen wurde der Ruf nach einer Gesetzgebung laut, die diese Form des KI-Missbrauchs bekämpft.

Der US-Abgeordnete Joe Morelle bezeichnete die Verbreitung der Swift-Depfakes als "entsetzlich" und sprach sich für dringende rechtliche Schritte aus. Er merkte an: "Was Taylor Swift passiert ist, ist nichts Neues", und unterstrich die unverhältnismäßigen Auswirkungen solcher Inhalte auf Frauen.

Deep Fake Fehlinformationen wurden auch auf der das Weltwirtschaftsforum in Davos mit steigender Befürchtungen, dass manipulierte Inhalte die Aktienmärkte, Wahlen und die öffentliche Meinung beeinflussen könnten.

Sowohl Start-ups als auch Technologiegiganten entwickeln Technologien zur Erkennung von Fälschungen.

Intel zum Beispiel hat ein Produkt auf den Markt gebracht, das gefälschte Videos mit 96% Genauigkeit erkennen kann.

Die Herausforderung bleibt jedoch vorerst weitgehend unüberwindbar, da sich die Technologie rasch weiterentwickelt und im Internet verbreitet.