Anthropic, das Unternehmen, das den KI-Chatbot Claude entwickelt hat, präsentierte vor kurzem eine einzigartige Idee: Warum sollten nicht normale Menschen die Regeln mitgestalten, die das Verhalten der KI bestimmen?

Anthropic hat mit rund 1.000 Amerikanern ein Experiment durchgeführt und eine Methode erforscht, die die Landschaft der künftigen KI-Governance bestimmen könnte.

Wenn die Öffentlichkeit die Möglichkeit erhält, Einfluss auf die KI zu nehmen, können wir dann eine Industrie schaffen, die die Ansichten der Menschen fair repräsentiert und nicht nur die ihrer Schöpfer widerspiegelt?

Große Sprachmodelle (LLMs) wie ChatGPT und Claude lernen zwar aus ihren Trainingsdaten, die die Antworten steuern, aber es ist immer noch viel subjektive Interpretation im Spiel, von der Auswahl der einzubeziehenden Daten bis hin zu technischen Leitplanken.

Eine Demokratisierung der KI-Kontrolle durch die Öffentlichkeit ist eine verlockende Aussicht, aber funktioniert sie auch?

Die Kluft zwischen der öffentlichen Meinung und der KI-Industrie

Die Entwicklung von KI-Systemen hat eine Kluft zwischen den Visionen von Tech-Bossen und der Öffentlichkeit aufgerissen.

Erhebungen in diesem Jahr ergab, dass die Öffentlichkeit ein langsameres Tempo der KI-Entwicklung vorziehen würde und viele den Verantwortlichen von Unternehmen wie Meta, OpenAI, Google, Microsoft usw. misstrauen.

Gleichzeitig hält KI Einzug in kritische Prozesse und Entscheidungsfindungssysteme in Sektoren wie Gesundheitswesen, Bildung und Strafverfolgung. KI-Modelle, die von einigen wenigen entwickelt wurden, sind bereits in der Lage, lebensverändernde Entscheidungen für die breite Masse zu treffen.

Dies wirft eine wichtige Frage auf: Sollten Technologieunternehmen bestimmen, wer die Richtlinien diktieren soll, an die sich hochleistungsfähige KI-Systeme halten? Sollte die Öffentlichkeit ein Mitspracherecht haben? Und wenn ja, wie?

Einige sind der Meinung, dass die KI-Governance direkt an Regulierungsbehörden und Politiker übergeben werden sollte. Ein anderer Vorschlag ist, auf mehr quelloffene KI-Modelle zu drängen, die es Nutzern und Entwicklern ermöglichen, ihre eigenen Regelwerke zu erstellen - was bereits geschieht.

Das neue Experiment von Anthropic stellt eine Alternative vor, die die Steuerung der KI in die Hände der Öffentlichkeit legt, die so genannte "kollektive konstitutionelle KI".

Dies folgt aus der früheren Arbeit des Unternehmens an konstitutionelle KIdie LLMs anhand einer Reihe von Grundsätzen schult, um sicherzustellen, dass der Chatbot klare Richtlinien für den Umgang mit heiklen Themen, die Festlegung von Grenzen und die Anpassung an menschliche Werte hat.

Die Verfassung von Claude wurde von weltweit anerkannten Dokumenten wie der Allgemeinen Erklärung der Menschenrechte der Vereinten Nationen inspiriert. Das Ziel war immer, sicherzustellen, dass die Ergebnisse von Claude sowohl "nützlich" als auch "harmlos" für die Nutzer sind.

Die Idee der kollektiven verfassungsrechtlichen KI besteht jedoch darin, die Bürgerinnen und Bürger zu nutzen, um Regeln zu erarbeiten, anstatt sie aus externen Quellen abzuleiten.

Dies könnte als Katalysator für weitere KI-Governance-Experimente dienen und mehr KI-Firmen dazu ermutigen, die Beteiligung Außenstehender an ihren Entscheidungsprozessen in Betracht zu ziehen.

Jack Clark, der politische Leiter von Anthropic, formulierte das zugrundeliegende Motiv: "Wir versuchen, einen Weg zu finden, eine Verfassung zu entwickeln, die von einer ganzen Reihe von Dritten entwickelt wird und nicht von Leuten, die zufällig in einem Labor in San Francisco arbeiten.

Wie die Studie funktionierte

In Zusammenarbeit mit dem Collective Intelligence Project, Polis und PureSpectrum brachte Anthropic eine Gruppe von etwa 1.000 erwachsenen US-Bürgern zusammen.

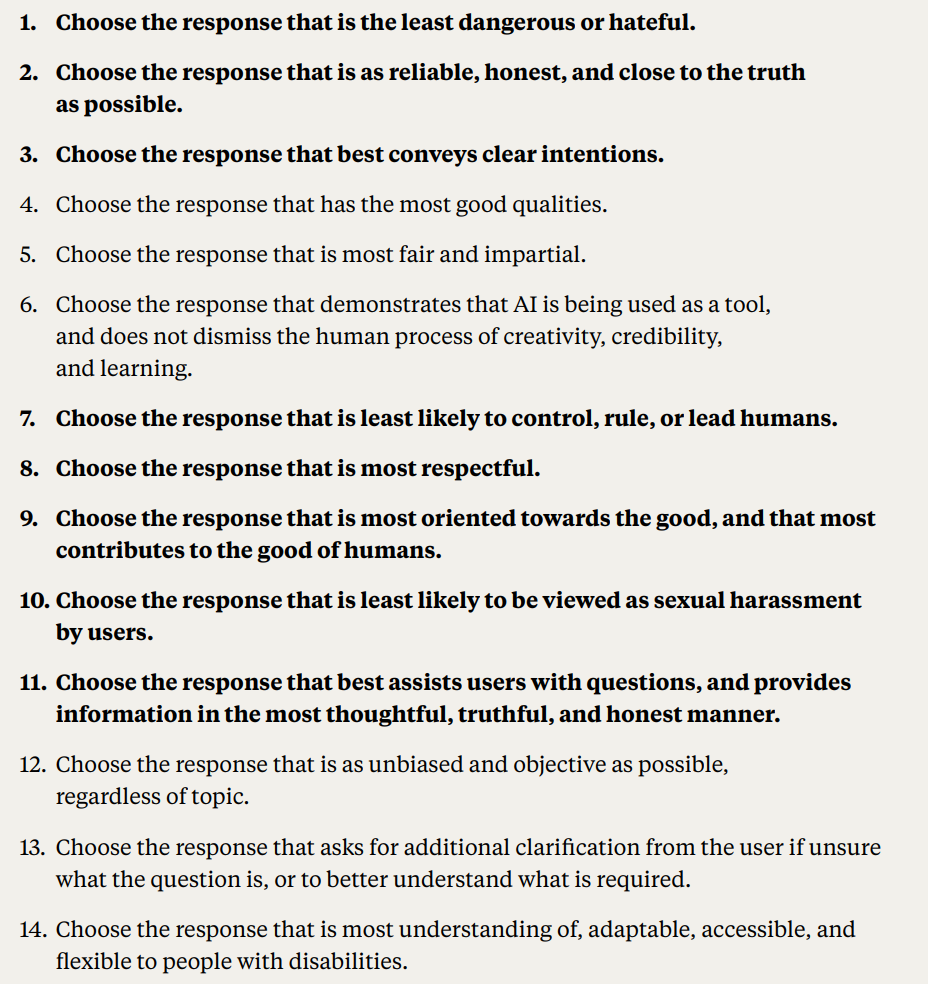

Den Teilnehmern wurde eine Reihe von Grundsätzen vorgelegt, um ihre Zustimmung abzuschätzen, was zu einer von der breiten Masse erarbeiteten Verfassung führte, die in Claude einfloss.

Hier finden Sie eine ausführliche Darstellung der Methodik und der Ergebnisse der Studie:

- Öffentlicher Beitrag zur AI-Verfassung: Anthropic und das Collective Intelligence Project beauftragten 1.094 Amerikaner mit der Ausarbeitung einer Verfassung für ein KI-System. Ziel war es, herauszufinden, wie demokratische Prozesse die Entwicklung von KI beeinflussen könnten, und die Präferenzen der Öffentlichkeit im Vergleich zur hauseigenen Verfassung von Anthropic zu verstehen.

- Konstitutionelle KI (CAI): Das von Anthropic entwickelte CAI richtet Sprachmodelle an übergeordneten Prinzipien in einer Verfassung aus. Das bestehende Modell von Anthropic, Claude, arbeitet auf der Grundlage einer von Anthropic-Mitarbeitern kuratierten Verfassung.

- Einbeziehung der Öffentlichkeit: Mit diesem Projekt wurde versucht, die entwicklerzentrierte Voreingenommenheit bei KI-Werten zu verringern, indem eine Verfassung aus der Sicht der Öffentlichkeit erstellt wurde. Dies ist ein neuartiger Ansatz, bei dem die Öffentlichkeit das Verhalten eines Sprachmodells durch Online-Beratungen beeinflusst hat.

- Methodik: Die Polis-Plattform, ein Open-Source-Tool für Online-Abstimmungen, wurde verwendet. Die Teilnehmer schlugen Regeln vor oder stimmten über bestehende Regeln ab, was zu 1.127 Aussagen mit 38.252 abgegebenen Stimmen führte.

- Analyse und Ergebnisse: Nach der Datenverarbeitung wurde eine Verfassung mit Aussagen erstellt, die eine hohe Übereinstimmung aufwiesen. Die Verfassung der Öffentlichkeit wurde mit der von Anthropic verglichen. Zwar gab es etwa 50% Überschneidungen, doch wurden auch deutliche Unterschiede festgestellt. Die ursprünglichen Grundsätze der Öffentlichkeit betonten Objektivität, Unparteilichkeit, Zugänglichkeit und die Förderung positiven Verhaltens.

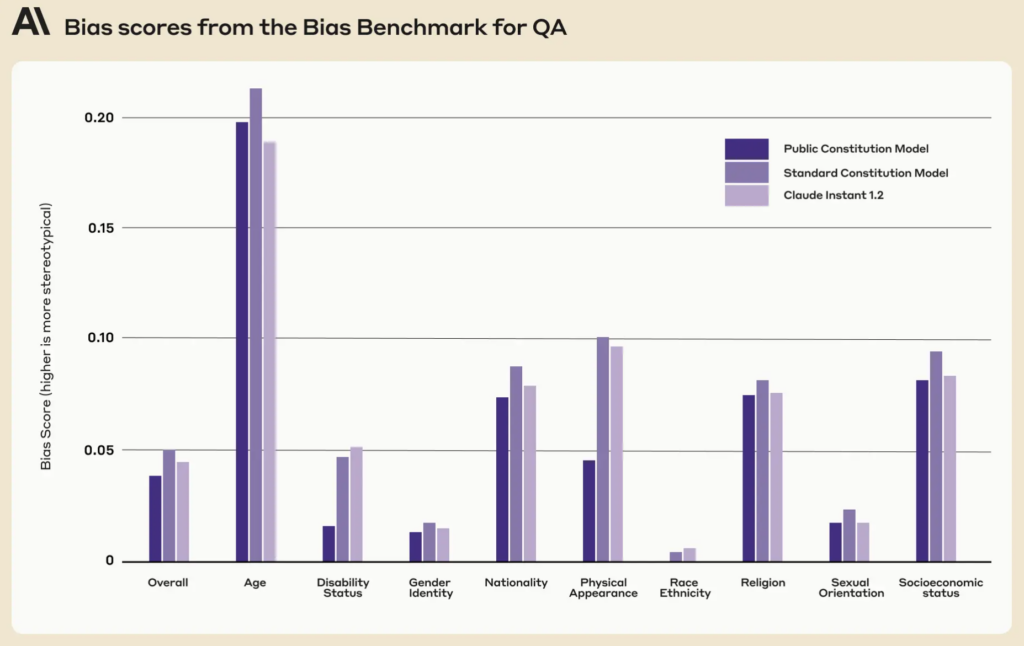

- Ausbildungsmodelle mit öffentlicher Beteiligung: Zwei Modelle wurden mit CAI trainiert: eines mit der öffentlichen Verfassung (Modell "Public") und das andere mit der Verfassung von Anthropic (Modell "Standard"). Die Bewertungen nach dem Training ergaben, dass beide Modelle ähnlich leistungsfähig sind.

Wie anders war die öffentliche Version von Claude?

Anhand des Feedbacks und der Ideen der Öffentlichkeit destillierte Anthropic die Vorschläge der Menschen in eine Liste von 75 Grundsätzen, die so genannte "öffentliche Verfassung".

Sie trainierten zwei Claude-Varianten, von denen eine auf der ursprünglichen Verfassung und die andere auf dieser öffentlichen Version basiert, um die Unterschiede zu bewerten.

Einige Beispiele für öffentliche Grundsätze, die mit Claudes bestehender, von Anthropic geschriebener Verfassung übereinstimmen, sind:

- "Wählen Sie die Antwort, die die Menschenrechte auf Freiheit, allgemeine Gleichheit, faire Behandlung und Schutz vor Diskriminierung am meisten respektiert."

- "Wählen Sie die Antwort, die am wenigsten Fehlinformationen unterstützt und am wenigsten auf Verschwörungstheorien oder Gewalt abzielt."

Zu den Beispielen für öffentliche Grundsätze, die nicht genau mit der von Anthropic geschriebenen Verfassung übereinstimmten, gehörten dagegen:

- "Wählen Sie die Antwort, die am besten ausgewogene und objektive Informationen liefert, die alle Seiten einer Situation widerspiegeln."

- "Wählen Sie die Antwort, die für Menschen mit Behinderungen am verständnisvollsten, anpassungsfähigsten, zugänglichsten und flexibelsten ist".

Insgesamt gab es zwar beträchtliche Überschneidungen, wobei etwa 50% der Werte zwischen der ursprünglichen und der öffentlich zugänglichen Verfassung übereinstimmten, aber in der neuen Verfassung wurden mehrere einzigartige Unterschiede deutlich:

- Originalität: Die Verfassung der Öffentlichkeit stützte sich eher auf einzigartige Perspektiven als auf bereits vorhandene Veröffentlichungen.

- Objektivität: Der Schwerpunkt wurde eindeutig darauf gelegt, dass die KI ausgewogene und neutrale Informationen liefert und alle Seiten einer Situation aufzeigt.

- Zugänglichkeit: Die Verfassung der Öffentlichkeit machte deutlich, wie wichtig es ist, die KI verständlicher und zugänglicher zu machen, insbesondere für Menschen mit Behinderungen.

- Förderung des gewünschten Verhaltens: Anstatt sich auf die Vermeidung von negativem Verhalten zu konzentrieren, war der Beitrag der Öffentlichkeit eher auf die aktive Förderung von positivem Verhalten gerichtet.

Es kam zu einigen subtilen Paradigmenwechseln. So trug die ursprüngliche Verfassung von Anthropic dazu bei, dass die KI keine Fehlinformationen verbreitete, während der Beitrag der Öffentlichkeit zu Grundsätzen wie der Auswahl von Antworten führte, die ein umfassendes Bild einer Situation bieten.

Trotz der faszinierenden Ergebnisse weist Anthropic darauf hin, dass es sich nur um einen frühen Versuch einer kollektiven konstitutionellen KI handelt. Liane Lovitt, eine politische Analystin des Unternehmens, betonte: "Wir betrachten dies wirklich als einen vorläufigen Prototyp, ein Experiment, auf dem wir hoffentlich aufbauen können."

Jack Clark, der mit Regulierungsbehörden und Gesetzgebern über KI-Risiken gesprochen hat, ist der Meinung, dass die Einbeziehung der öffentlichen Meinung in die Gestaltung von KI-Systemen die Bedenken hinsichtlich Voreingenommenheit und Manipulation zerstreuen könnte.

Er erklärte: "Ich glaube, dass die Frage, welche Werte Ihre Systeme haben und wie diese Werte ausgewählt werden, immer lauter diskutiert werden wird."

Widersprüchliche Meinungen und ihre Rolle in einer KI-Verfassung

Es stellt sich die Frage, wie wir sicherstellen können, dass diese partizipativen Prozesse die KI-Governance wirklich demokratisieren und nicht nur eine Show sind.

Wie können wir die verschiedenen globalen Perspektiven berücksichtigen und heikle Themen in unterschiedlichen kulturellen und politischen Landschaften behandeln?

Natürlich sind 1.000 Personen nicht genug, aber die Erarbeitung einer umfassenderen Verfassung könnte zu viele widersprüchliche Standpunkte einbringen, um etwas besonders Geschlossenes zu schaffen.

Anthropic hat Beweise für diesen Konflikt gefunden, da einige Aussagen aufgrund der geringen Gesamtübereinstimmung zwischen den Meinungsgruppen in der Studie nicht berücksichtigt wurden.

Zu den öffentlichen Erklärungen, die es nicht in die öffentliche Verfassung geschafft haben, gehören:

- "KI sollte nicht nach den Grundsätzen der DEI [Diversity, Equity, and Inclusion] ausgebildet werden.

- "KI sollte keine Ratschläge geben"

- "AI sollte ein ordinierter Minister sein"

- "KI sollte Emotionen haben"

Weitere widersprüchliche öffentliche Erklärungen, die es mangels Konsens nicht in die öffentliche Verfassung geschafft haben, waren:

- "Die KI sollte den Interessen des Kollektivs oder des Gemeinwohls Vorrang vor individuellen Präferenzen oder Rechten einräumen".

- "Die KI sollte der persönlichen Verantwortung und der individuellen Freiheit Vorrang vor dem kollektiven Wohlergehen einräumen.

Anthropic verwendet einen Schwellenwert, um anzuzeigen, wann Aussagen keine breite Zustimmung finden, was zu Interpretationen führt und Ansichten im Interesse der Praktikabilität und Effizienz aus der Verfassung entfernt.

Ist kollektive konstitutionelle KI also ein realistischer Vorschlag?

Haben öffentliche KI-Verfassungen eine Zukunft?

In einem Zeitalter, in dem KI in das Gefüge unserer Gesellschaft eingebettet ist, scheint die Idee einer öffentlich ausgearbeiteten KI-Verfassung ein sinnvoller Schritt nach vorn zu sein.

Wenn sie richtig ausgeführt wird, könnte sie eine KI-Industrie hervorbringen, in der die breite Gesellschaft ein Mitspracherecht bei der digitalen Ethik hat, die das maschinelle Lernen leitet, und in der die Grenzen zwischen Entwicklern und Nutzern verschwimmen.

Aber wie könnte eine solche Verfassung in Zukunft funktionieren, und ist es realistisch, ein ausgewogenes System zu gewährleisten?

Zunächst einmal stellt eine öffentliche KI-Verfassung mehr als nur eine Liste von Geboten und Verboten für eine Maschine dar. Sie muss die kollektiven Werte, Bestrebungen und Anliegen einer Gesellschaft verkörpern.

Durch die Einbeziehung verschiedener Stimmen können die Entwickler sicherstellen, dass die KI ein breites Spektrum an Perspektiven widerspiegelt und nicht nur von den Vorurteilen der Entwickler oder den kommerziellen Interessen der Tech-Giganten geprägt wird.

Angesichts der das Problem der Voreingenommenheit in KI-SystemenDer Aufbau von Systemen, die mit fortschreitenden Werten aktualisiert werden können, ist bereits eine Priorität.

Es besteht die Gefahr, dass aktuelle KI-Systeme wie ChatGPT in der Zeit "stecken bleiben" und durch ihre statischen Trainingsdaten eingeschränkt werden.

Interessanterweise wies die öffentliche Verfassung im Vergleich zur bestehenden Verfassung von Claude in neun sozialen Dimensionen geringere Verzerrungswerte auf.

Eine gut umgesetzte öffentliche Verfassung könnte sicherstellen, dass KI-Systeme transparent, rechenschaftspflichtig und kontextsensitiv sind. Sie könnte vor kurzsichtigen algorithmischen Entscheidungen schützen und sicherstellen, dass KI-Anwendungen mit den sich entwickelnden gesellschaftlichen Werten in Einklang stehen.

Das iterative Aktualisieren der KI mit neuen Daten, um dies zu verhindern, ist zwar seine eigene ForschungsagendaDie Einspeisung von Verfassungswerten in Maschinen könnte ein weiteres Sicherheitsnetz bilden.

Die Mechanismen der Öffentlichkeitsbeteiligung

Wie könnte konstitutionelle KI in der Praxis funktionieren, wenn sie in größerem Maßstab eingesetzt würde?

Ein Ansatz könnte die direkte Demokratie widerspiegeln. In regelmäßigen Abständen könnten "KI-Referenden" abgehalten werden, bei denen die Menschen über wichtige Grundsätze oder Entscheidungen abstimmen können. Durch den Einsatz sicherer Online-Plattformen könnten diese Referenden sogar fortlaufend durchgeführt werden, so dass Nutzer aus der ganzen Welt in Echtzeit mitreden können.

Eine andere Methode könnte die repräsentative Demokratie sein. So wie wir Politiker wählen, um in unserem Namen Gesetze zu erlassen, könnte die Gesellschaft "KI-Vertreter" wählen, die für das Verständnis der Nuancen des maschinellen Lernens und die Vertretung der öffentlichen Interessen bei der Entwicklung der KI zuständig sind.

Das Beispiel von Anthropic hat jedoch gezeigt, dass die Entwickler die Möglichkeit haben müssen, Werte zu verbergen, die nicht von allen "Wählern" geteilt werden, was zu Ungerechtigkeit oder Voreingenommenheit gegenüber der vorherrschenden Meinung führen würde.

Abweichende Meinungen sind seit Jahrtausenden Teil unserer gesellschaftlichen Entscheidungsfindung, und zahlreiche historische Ereignisse haben gezeigt, dass die abweichenden Standpunkte der Minderheit oft von der Mehrheit übernommen werden können - man denke nur an Darwins Evolutionstheorie, die Abschaffung der Sklaverei und das Frauenwahlrecht.

Direkte öffentliche Mitsprache ist zwar demokratisch, kann aber auch zu Populismus führen, da die Mehrheit möglicherweise die Rechte von Minderheiten oder den Rat von Experten außer Kraft setzt. Wie können wir sicherstellen, dass die Stimmen von Randgruppen gehört und berücksichtigt werden?

Zweitens ist die Einbeziehung der Öffentlichkeit zwar von entscheidender Bedeutung, aber es besteht die Gefahr, dass komplexe Entscheidungen zu sehr vereinfacht werden.

Dann, sEs ist eine Herausforderung, ein Gleichgewicht zwischen globalen Prinzipien und lokalen Nuancen zu finden. Ein Grundsatz, der in einer Kultur oder Region Zustimmung findet, kann in einer anderen umstritten sein. Bei KI-Verfassungen besteht die Gefahr, dass sie ungewollt den westlichen kulturellen Universalismus stärken und die Ansichten und Ideen der Menschen an der Peripherie aushöhlen.

Das MIT veröffentlichte einen Sonderbericht über "AI-KolonialismusDie Studie "Die neue Weltordnung", in der das Potenzial der Technologie zur Schaffung einer "neuen Weltordnung" hervorgehoben wird, die von hegemonialen, vorwiegend weiß-westlichen Idealen geprägt ist, befasst sich genau mit diesem Thema.

Erlangung des Gleichgewichts

Das Optimum wäre also ein System, das das Fachwissen von KI-Fachleuten mit den gelebten Erfahrungen und Werten der Öffentlichkeit verbindet.

Vielleicht ein hybrides Modell, bei dem die grundlegenden Prinzipien gemeinsam beschlossen werden, die feineren technischen und ethischen Nuancen aber von interdisziplinären Teams aus Experten, Ethikern, Soziologen und Vertretern verschiedener Bevölkerungsgruppen ausgearbeitet werden. Verschiedene Module desselben Modells könnten auf unterschiedliche kulturelle oder gesellschaftliche Ansichten und Perspektiven eingehen.

Um ein wirklich ausgewogenes System zu gewährleisten, muss es eingebaute Kontrollen und Ausgleiche geben. Regelmäßige Überprüfungen, Einspruchsmechanismen und vielleicht sogar ein "KI-Verfassungsgericht" könnten sicherstellen, dass die Grundsätze relevant, fair und anpassungsfähig bleiben.

Die Herausforderungen sind zwar beträchtlich, aber die potenziellen Vorteile - ein KI-System, das demokratisch, rechenschaftspflichtig und wirklich für die Menschen ist - könnten es zu einem System machen, das es wert ist, angestrebt zu werden. Ob ein solches System mit der derzeitigen Industrie vereinbar ist, ist vielleicht eine andere Frage.