KI durchdringt das Leben von Millionen von Menschen auf der ganzen Welt, aber trotz der weit verbreiteten Akzeptanz erweist sich die Technologie angesichts der eskalierenden Kosten als schwierig zu monetarisieren.

Generative KI-Tools wie ChatGPT sind kostspielig im Betrieb und erfordern High-End-Server, teure Grafikprozessoren und umfangreiche Zusatzhardware, die viel Energie verschlingt.

Weitgehend ungeprüft, Dylan Patel von SemiAnalysis Die Information erzählt dass OpenAI angeblich auf einige $700.000 pro Tag um seine Modelle zu betreiben, und verzeichnete im Jahr 2022 Verluste von fast $500 Millionen.

John Hennessy, Vorsitzender der Google-Muttergesellschaft Alphabet, sagte, eine einzige Eingabeaufforderung auf Bard koste bis zu 10 Mal mehr als eine Google-Sucheund Analysten gehen davon aus, dass Google in den kommenden Jahren Ausgaben in Milliardenhöhe für KI tätigen wird.

Das Jahr 2023 hat sich als Testfeld für die KI-Monetarisierung erwiesen. Tech-Giganten wie Microsoft, Google und Adobe und andere versuchen eine Vielzahl unterschiedlicher Ansätze, um ihre KI-Angebote zu entwickeln, zu vermarkten und zu bepreisen.

Die meisten kommerziellen Modelle wie ChatGPT, Bard und Claude 2 von Anthropic beschränken die Nutzer bereits auf eine bestimmte Anzahl von Eingabeaufforderungen pro Stunde oder Tag, einschließlich kostenpflichtiger Versionen wie ChatGPT Plus. Adobe legt monatliche Nutzungsobergrenzen für seine Firefly-Modelle fest.

Die immensen Kosten der KI treffen auch die Unternehmen. Adam Selipsky, der CEO von Amazon Web Services (AWS), kommentierte die unerschwinglichen Kosten für Unternehmensanwender, die KI-Workloads aufbauen wollen: "Viele Kunden, mit denen ich gesprochen habe, sind unzufrieden mit den Kosten, die sie für den Betrieb einiger dieser Modelle sehen."

Chris Young, Microsofts Leiter der Unternehmensstrategie, merkte an, dass es für Unternehmen, die aktuelle KI-Modelle nutzen wollen, noch zu früh ist: "Es wird Zeit brauchen, bis Unternehmen und Verbraucher verstehen, wie sie KI nutzen wollen und was sie bereit sind, dafür zu bezahlen."

Er fügte hinzu: "Wir sind eindeutig an einem Punkt angelangt, an dem wir die Begeisterung und das Interesse in echte Akzeptanz umsetzen müssen."

KI-Modelle vs. Software

KI bietet nicht die gleiche Wirtschaftlichkeit wie herkömmliche Software, da sie für jede Aufgabe spezifische Berechnungen erfordert.

Wenn Nutzer ein Modell wie ChatGPT auffordern, sucht es nach Mustern und Sequenzen aus seinen Trainingsdaten in der Architektur des neuronalen Netzes und berechnet eine bestimmte Antwort. Jede Interaktion verbraucht Energie, was zu laufenden Kosten führt.

Folglich steigen mit der zunehmenden Verbreitung auch die Kosten, was eine Herausforderung für Unternehmen darstellt, die KI-Dienste zu Pauschalpreisen anbieten.

So hat Microsoft kürzlich in Zusammenarbeit mit OpenAI den GitHub Copilot eingeführt, der sich an Programmierer und Entwickler richtet.

Aufgrund der hohen Betriebskosten war es bisher nicht rentabel. In den ersten Monaten des Jahres verlangte Microsoft für diesen KI-Assistenten ein Abonnement von $10 pro Monat und verursachte damit einen durchschnittlichen Verlust von mehr als $20 pro Monat für jeden Nutzer. Einige Nutzer erlitten Verluste von bis zu $80 pro Monat, wie aus einer Quelle: WSJ.

Microsofts Copilot-Suite für Microsoft 365 (die verwirrenderweise denselben Namen trägt wie das GitHub-Tool) soll monatlich $30 extra kosten. Dieses Tool bietet Funktionen wie das autonome Verfassen von E-Mails, das Erstellen von PowerPoint-Präsentationen und Excel-Tabellen.

In ähnlicher Weise wird Google eine KI-Assistentenfunktion für seine Arbeitsplatz-Tools einführen und dafür eine zusätzliche monatliche Gebühr von $30 zusätzlich zu den bestehenden Gebühren erheben.

Sowohl Microsoft als auch Google setzen auf eine monatliche Pauschale und hoffen, dass die erhöhten Gebühren die durchschnittlichen Kosten für den Betrieb dieser KI-Tools angemessen ausgleichen.

Während $30/Monat in einigen entwickelteren westlichen Ländern erschwinglich erscheinen mag, sind diese Preismodelle nicht für einen Großteil der Weltbevölkerung geeignet.

Als ChatGPT Plus auf dem indischen Markt eingeführt wurde, beschwerten sich beispielsweise viele, dass es viel zu teuer wardie einen erheblichen Teil des durchschnittlichen Monatsgehalts von $330 ausmachen. Die Ausgrenzung von Milliarden von Nutzern aus der KI kann die Entwickler teuer zu stehen kommen, wenn sie ihre Tools an die Öffentlichkeit vermarkten.

Auch für die Menschen in wohlhabenderen Ländern sind die Kosten nicht unerheblich, denn Umfragen zeigen, dass Abonnements zu den ersten Dingen gehören, die man aufgibt, wenn man seine Ausgaben reduzieren will.

Warum ist KI so schwer zu monetarisieren?

KI stellt eine Lücke dar zwischen den scheinbar unendlichen Visionen der Entwickler und den endlichen Ressourcen, die zu ihrer Verwirklichung zur Verfügung stehen.

Sam Altman, CEO von OpenAI behauptet, dass eine futuristische, in KI eingebettete Welt einfach "unvermeidlich" ist, in der intelligente Maschinen neben uns leben und unsere Befehle ausführen, in der Menschen hunderte von Jahren oder sogar unsterblich leben und in der KI, die in unsere Gehirne eingebettet ist, uns hilft, komplexe Aufgaben allein durch unser Denken zu bewältigen.

Damit ist er sicherlich nicht allein. Der CEO von Inflection, Mustafaya Suleman, hat kürzlich sein Buch "The Coming Wave" veröffentlicht, in dem er KI mit der kambrischen Explosion vor 500 Millionen Jahren vergleicht, die zum schnellsten Evolutionsschub führte, den es je auf unserem Planeten gab.

Generative KI steht kurz vor der Explosion: Bis 2032 wird ein Umsatz von über $1 Billion erwartet. Von den Anfängen bis zur Gegenwart und Zukunft ist es atemberaubend... jede Branche wird sich zum Besseren verändern. pic.twitter.com/0licQGfphn

- Mustafa Suleyman (@mustafasuleyman) Oktober 20, 2023

Ambitionen beflügeln Ideen, aber Geld treibt die Tech-Industrie an. KI-Forschung und -Entwicklung ist kostspielig, daher investieren Branchenführer wie OpenAI, Google und Facebook massiv, um im Rennen vorne zu bleiben.

KI-Unternehmen zogen im Jahr 2021 satte $94 Milliarden Investitionen an, wobei mehrere Finanzierungsrunden $500 Millionen oder mehr erreichten. Das Jahr 2023 setzte noch einen drauf, mit Investitionen in Start-ups Anthropisch und Beugung die $1-Milliarden-Grenze überschritten.

KI-Spezialisten verlangen aufgrund des harten Wettbewerbs hohe Gehälter, die oft in die Millionen gehen, und die Modelle erfordern regelmäßige Feinabstimmungen und Belastungstests, was die laufenden Kosten erhöht.

Hinzu kommen die Nebenkosten für die Rechenzentren und die Wartung, besonders kühlDa solche Geräte heiß laufen und bei nicht optimaler Temperatur störanfällig sind, sollten sie nicht in der Nähe der Heizung stehen.

GPUs haben unter Umständen eine kurze Lebensdauer von weniger als fünf Jahren und benötigen häufig eine spezielle Wartung.

AI-Monetarisierungsstrategien

Wie gehen Technologieunternehmen angesichts dieser Herausforderungen an die KI-Monetarisierung heran?

Steigerung der Produktivität

Die Unternehmen können von der KI profitieren, indem sie die gesellschaftliche Nettoproduktivität erheblich steigern. Durch die Automatisierung sich wiederholender Aufgaben können sich die Mitarbeiter auf Funktionen mit höherem Mehrwert konzentrieren.

Dies wird ihnen helfen, sowohl private als auch öffentliche Gelder zu erschließen. So arbeitet DeepMind beispielsweise mit dem Nationalen Gesundheitsdienst (NHS) im Vereinigten Königreich zusammen, und Technologieunternehmen kooperieren mit Regierungen bei der Bekämpfung des Klimawandels.

Die KI-gesteuerte Produktivität könnte sich jedoch auf die anderen Einkommensquellen von Technologieunternehmen auswirken. Zum Beispiel ist Googles Die Werbeeinnahmen sind rückläufig, da KI den Verkehr von seiner Suchmaschine abzieht. In diesem Jahr hat Google seine Einnahmen aus YouTube-Anzeigen Rückgang um 2,6%und die Einnahmen des Werbenetzes um noch nie dagewesene 8,3% zurück.

Hardware-Verkäufe

Für das Training und das Hosting von KI-Modellen ist spezielle High-End-Hardware erforderlich. Grafikprozessoren sind für die Ausführung anspruchsvoller KI-Algorithmen unverzichtbar, was sie zu einer lukrativen Komponente im KI-Ökosystem macht.

Der Branchenführer Nvidia ist hier der große Gewinner, dessen Marktkapitalisierung die Marke von $1 Billionen erreicht hat, aber auch andere Hersteller von KI-Hardware mit geringerer Bedeutung haben auch davon profitiert.

Abonnements

Das Anbieten von KI-Erweiterungen als Teil von Abonnementpaketen ist das Mittel der Wahl, um Einnahmen von öffentlichen Nutzern und Unternehmen zu generieren, die nicht den Weg über die API gehen wollen oder müssen.

ChatGPT Plus ist der weltweit am meisten abonnierte KI-Dienst, aber es fehlen Informationen darüber, wie viel Einnahmen er generiert.

OpenAI hat seine Unternehmensvariante in diesem Jahr, um die Abonnementeinnahmen zu steigern, und erklärte, dass das Unternehmen für das nächste Jahr einen Umsatz von $1 Milliarde anpeilt.

APIs

Unternehmen wie OpenAI verwenden für ihre APIs einen tokenbasierten Abrechnungsansatz für Unternehmens- und Geschäftskunden.

Dieses System stellt sicher, dass die Nutzer auf der Grundlage der tatsächlichen Rechenlast ihrer Anfragen abgerechnet werden, was für Fairness und Transparenz sorgt.

Die API-Preismodelle richten sich an ein breites Spektrum von Nutzern, von denen, die nur sporadisch leichte Anrufe tätigen, bis zu Vielnutzern mit intensiven Aufgaben.

AI als inhärentes Merkmal

Einige Unternehmen integrieren KI-Funktionen in ihre Produkte, ohne gleich einen Aufpreis zu verlangen. Diese Strategie zielt darauf ab, zunächst den Eigenwert eines Produkts zu steigern.

Mit der Zeit, wenn die Nutzer die KI-Funktionen in ihre Arbeitsabläufe integriert und ihren Wert erkannt haben, werden sie eher bereit sein, eine spätere Preiserhöhung zu akzeptieren. KI muss jedoch progressive Vorteile bieten, wenn die Kosten stetig steigen.

Open-Source-KI-Schulungskosten werden billiger

Hier gibt es eine parallele Diskussion: Warum sollte jemand für KI bezahlen, wenn er sie nie besitzt?

Einige - wie der KI-"Pate" Yann LeCun - argumentieren, dass KI Teil unserer öffentlichen Infrastruktur werden sollte, und betonen die Notwendigkeit, dass Entwickler Open-Source-Modelle erstellen, die billig und leicht zugänglich sind.

Ein NYT-Artikel über die Debatte darüber, ob LLM-Basismodelle geschlossen oder offen sein sollten.

Meta plädiert für Offenheit, beginnend mit der Veröffentlichung von LLaMA (für nicht-kommerzielle Zwecke), während OpenAI und Google die Dinge geschlossen und proprietär halten wollen.

Sie argumentieren, dass Offenheit...

- Yann LeCun (@ylecun) 18. Mai 2023

Da KI-Lösungen für Unternehmen immer wichtiger werden, verfügen viele nicht über das Budget, um eigene Modelle von Grund auf zu entwickeln. Traditionell haben sie sich an APIs von aufstrebenden KI-Startups oder an Standardsysteme gewandt.

Da jedoch die Ausbildungskosten sinken und das Bedürfnis nach Datenschutz wächst, wird die Zusammenarbeit mit Anbietern, die auf die Anpassung von privaten und Open-Source-Modellen spezialisiert sind, immer beliebter.

Naveen Rao, CEO und Mitbegründer von MosaicML, erklärte gegenüber The Register dass Open-Source-Modelle verlockend sind, da sie billiger und flexibler sind und es Unternehmen ermöglichen, Arbeitslasten privat zu halten.

MosaicML hat eine Reihe von quelloffenen großen Sprachmodellen (LLMs) auf der Grundlage seiner MPT-7B-Architektur auf den Markt gebracht. Im Gegensatz zu vielen anderen LLMs ist dieses Modell für die breite Masse kommerziell nutzbar.

Rao erläuterte die Beweggründe für dieses Modell: "Es gibt definitiv eine große Anziehungskraft für diese Art von Dingen, und wir haben es aus mehreren Gründen gemacht." Er fügte hinzu: "Einer davon war, dass wir ein Modell haben wollten, das für die kommerzielle Nutzung zugelassen ist. Wir wollen diese Art von Innovation nicht im Keim ersticken".

Zur Erschwinglichkeit bemerkte Rao: "Wenn ein Kunde zu uns kommt und sagt, wir sollen dieses Modell trainieren, können wir das für $200.000 machen und wir verdienen immer noch Geld damit."

MosaicML bietet Unternehmen auch die Tools, um ihre benutzerdefinierten Modelle effizient auf Cloud-Plattformen zu hosten. "Ihre Daten werden nicht mit dem Startup geteilt, und sie besitzen die Gewichtung des Modells und seine IP", bestätigt Rao.

Rao ging auch auf die Grenzen kommerzieller APIs ein und erklärte: "Kommerzielle APIs sind ein großartiges Werkzeug für die Prototypenentwicklung. Ich denke, dass die Leute sie bei Diensten vom Typ ChatGPT zur Unterhaltung und vielleicht auch für persönliche Zwecke nutzen werden, aber nicht für Unternehmen. Daten sind ein sehr wichtiger Graben für Unternehmen."

Rao wies außerdem auf die Kosten der firmeneigenen Architektur hin: "GPUs fallen ziemlich oft aus", "Wenn ein Knoten ausfällt und ein manueller Eingriff erforderlich ist, für den Sie fünf Stunden [zur Reparatur] gebraucht haben, haben Sie gerade $10.000 ohne Arbeit verbrannt, richtig?"

Er sprach auch das sich abzeichnende Problem der Chipknappheit in der Industrie anWir werden noch mindestens zwei, vielleicht fünf Jahre lang in dieser Welt der GPU-Knappheit leben".

Wenn Unternehmen Open-Source-KI nutzen können, um ihre kostengünstigen Modelle mit vollständiger Datenhoheit und -kontrolle zu trainieren, dann stellt dies eine Herausforderung für öffentliche KI wie ChatGPT dar.

Drohen der KI Engpässe?

Neben dem von Rao angesprochenen Mangel an Grafikprozessoren ist ein weiteres Hindernis für die Monetarisierung von KI der rasant steigende Energiebedarf der Branche.

A aktuelle Studie prognostiziert, dass der Energieverbrauch der KI-Industrie bis 2027 dem einer kleinen Nation entsprechen könnte.

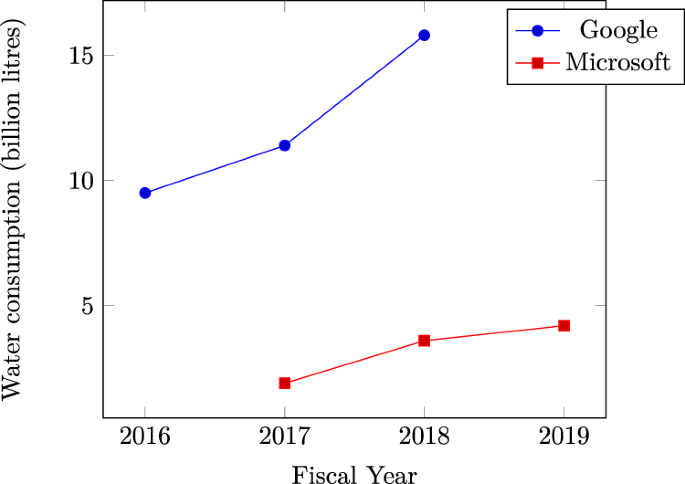

Microsofts Steigender Wasserverbrauch in Rechenzentren bestätigt den immensen Durst der KI nach natürlichen Ressourcen. Es gibt Anzeichen dafür, dass der jüngste Anstieg des Wasserverbrauchs bei Tech-Giganten wie Microsoft und Google auf intensive KI-bezogene Arbeitslasten zurückzuführen ist.

Auf breiterer Ebene übersteigt der kumulierte Energieverbrauch von Rechenzentren bereits 1% des weltweiten Stromverbrauchs, wie die Internationale Energieagentur (IEA).

Wenn der Energiebedarf weiter ansteigt, könnten die KI-Unternehmen gezwungen sein, ihre Aufmerksamkeit auf die Entwicklung effizienterer Ansätze für das Modelltraining zu richten, was die kurzfristige Entwicklung der Technologie beeinträchtigen könnte.

Konkurrierende Narrative

Die aufstrebende KI-Branche ist noch jung, und ihre künftige Entwicklung lässt sich nur schwer vorhersagen.

Zentrale Persönlichkeiten der KI geben zu, dass ihre Vorstellungen nicht immer mit der Realität übereinstimmen.

So räumte Sam Altman im Joe-Rogan-Podcast ein, dass er sich in Bezug auf die Entwicklung der KI geirrt habe und beschrieb, dass der Weg zur Verwirklichung hochintelligenter Formen der KI eher körnig als explosiv sein wird.

Einerseits erweist sich KI als schwierig zu monetarisieren, was Zweifel aufkommen lässt, ob der anfängliche Hype nachlässt, was zu einem langsameren Reifeprozess der Technologie führt.

Andererseits könnte die Industrie bereits genügend Fortschritte gemacht haben, um die KI in Richtung einer "Singularität" zu treiben, in der sie die menschliche Kognition übertrifft.

Wenn die Menschheit in den nächsten Jahren Fortschritte in wichtigen Bereichen wie der Energieerzeugung und der Entwicklung von KI-Hardware und -Architekturen mit geringem Stromverbrauch erzielt - und In diesem Jahr wurden dort Fortschritte erzielt. - dann kann die Technologie kurzfristige Engpässe ausräumen und ihre rasante Entwicklung fortsetzen.