Unsere Gedanken mögen unser Allerheiligstes sein, aber sie sind nicht tabu für die KI.

Gedankenlesende KI wirkt wie ein Plot aus einem Science-Fiction-Roman, ist aber für Menschen, die aufgrund von Lähmungen oder Hirnverletzungen nicht kommunizieren können, sehr vielversprechend.

Darüber hinaus würde der Zugang der KI zum Gehirn uns in die Lage versetzen, allein mit unseren Gedanken zu schreiben, zu kreieren und zu entwerfen oder anderen ein Fenster in unser Bewusstsein zu öffnen.

Seit fast einem Jahrzehnt unterstützt die EEG-Technologie (Elektroenzephalogramm), bei der elektrische Signale mit Hilfe von Kopfhautelektroden aufgezeichnet werden, Menschen, die an schweren Schlaganfällen und dem "Complete Locked-in"-Syndrom (CLIP) leiden, einem Zustand, bei dem eine Person bei Bewusstsein, aber unbeweglich ist.

Im Jahr 2014 verwendete der an amyotropher Lateralsklerose (ALS) erkrankte Italiener Anselmo Paglialonga ein in das maschinelle Lernen integriertes Headset mit Ja- oder Nein-Antworten zu kommunizieren, obwohl sie keinen einzigen Muskel bewegen können. Einige Betroffene können winzige Muskeln bewegen, wie Stephen Hawking, der seinen Wangenmuskel zucken konnte.

Mit den Fortschritten der KI schlagen die Forscher eine Brücke von der einfachen Signalinterpretation zur Übersetzung komplexer Gedanken in ihrer Gesamtheit.

Mit der Zeit werden die Menschen vielleicht in der Lage sein, zu sprechen und zu kommunizieren, ohne einen Muskel zu bewegen, ganz buchstäblich durch die Kraft der Gedanken.

Dieselbe Technologie könnte uns in die Lage versetzen, komplexe Maschinen mit unserem Gehirn zu steuern, Musik zu komponieren, indem wir uns eine Melodie vorstellen, oder zu malen und zu zeichnen, indem wir Bilder mit unseren Gedanken heraufbeschwören. Wir könnten sogar unsere Träume anhand der Gehirnströme "aufzeichnen" und sie später wieder abspielen.

In nicht allzu ferner Zukunft könnte eine KI, die Gedanken lesen kann, eingesetzt werden, um die Erinnerungen einer Person auszulesen, um z. B. zu überprüfen, ob sie ein Verbrechen begangen hat.

Hacker könnten Sie sogar kurzzeitig dazu bringen, sich Ihre persönlichen Daten vorzustellen, während sie eine Kopie Ihrer Gedanken aus Ihrem Gehirn extrahieren. Totalitäre Regime könnten Routinetests an Bürgern durchführen, um abweichende Gedanken zu überwachen.

Mit der Fähigkeit, Gedanken in eine computergestützte Realität umzuwandeln, könnten die Menschen ihr Leben in einem Traumlandschafts-Sandkasten verbringen, in dem sie ihre Realitäten nach Belieben gestalten können.

Im Moment erscheinen solche Anwendungen noch surreal und phantastisch, aber mehrere aktuelle Experimente haben den Grundstein für eine Zukunft gelegt, in der das Gehirn für die KI zugänglich ist.

KI liest Ihre Gedanken

Wie ist das alles überhaupt möglich?

Um die Gehirnaktivität in eine verwertbare Ausgabe zu übersetzen, die in einen Computer eingegeben werden kann, müssen zunächst genaue Messungen vorgenommen werden.

Das ist die erste Hürde, denn das Gehirn ist so geheimnisvoll wie die entlegensten Winkel des Weltraums oder die tiefsten Ozeane. Es gibt kaum einen Konsens darüber, wie neuronale Aktivität komplexe Gedanken hervorbringt, geschweige denn Bewusstsein.

Das menschliche Gehirn - und auch andere Nervensysteme in der Natur - beherbergt Milliarden von Neuronen, von denen die meisten 5 bis 100 Mal pro Sekunde feuern. Im menschlichen Gehirn sind an jeder Sekunde des Denkens Billionen von einzelne neuronale Aktionen.

Die Messung der neuronalen Aktivität auf granularer Ebene ist der heilige Gral der Neurowissenschaften, aber das ist im Moment nicht möglich - vor allem nicht mit nicht-invasiven Techniken.

Gegenwärtig sind die Messungen des Gehirns eher ganzheitlich und werden aus der Blutbewegung oder dem Austausch elektrischer Signale gewonnen. Es gibt drei bewährte Methoden zur Messung der Hirnaktivität:

- Die Magnetoenzephalographie (MEG) erfasst die durch die elektrische Aktivität des Gehirns erzeugten Magnetfelder und bietet Einblicke in die neuronale Aktivität in Echtzeit.

- Elektroenzephalographie (EEG) zur Interpretation der elektrischen Aktivität.

- MRI, das die Hirnaktivität anhand von Blutflussmessungen misst.

Maschinelles Lernen (ML) und künstliche Intelligenz (KI) haben sich mit allen drei Technologien zusammengeschlossen, um die Analyse komplizierter Signale zu verbessern.

Letztlich geht es darum, bestimmte Gehirnaktivitäten mit bestimmten Gedanken zu verknüpfen, die ein Wort, ein Bild oder etwas Semantisches und Abstraktes beinhalten können.

Technologien, die Messungen aus dem Gehirn ableiten und an Computer weitergeben können, werden als Gehirn-Computer-Schnittstellen (BCI) bezeichnet.

So funktioniert das Ganze im Wesentlichen:

- Stimulus-Präsentation: Die Teilnehmer werden verschiedenen Reizen ausgesetzt. Dabei kann es sich um Bilder, Töne oder sogar taktile Empfindungen handeln. Ihre Gehirnaktivität wird während dieser Exposition aufgezeichnet, in der Regel durch EEG oder MRT.

- Datenerhebung: Die Reaktionen des Gehirns auf diese Reize werden in Echtzeit aufgezeichnet. Diese Daten sind eine ergiebige Quelle für Informationen darüber, wie verschiedene Reize die Gehirnaktivität beeinflussen.

- Vorverarbeitung: Rohdaten aus dem Gehirn sind oft verrauscht. Bevor sie verwendet werden können, müssen sie gereinigt und standardisiert werden. Dies kann das Entfernen von Artefakten, das Normalisieren von Signalen oder das Ausrichten von Datenpunkten beinhalten.

- Maschinelles Lernen: Mit den verarbeiteten Daten werden maschinelle Lernmodelle eingeführt. Diese Modelle werden darauf trainiert, Muster oder Korrelationen zwischen den Gehirndaten und dem entsprechenden Stimulus zu finden. Im Wesentlichen fungiert die KI als Dolmetscher, der die "Sprache" des Gehirns entschlüsselt.

- Modellhafte Ausbildung: Dies ist ein iterativer Prozess. Je mehr Daten das Modell erhält, desto besser wird es in der Lage, Vorhersagen zu treffen oder Ergebnisse zu erzeugen. Diese Phase kann viel Zeit und Rechenleistung in Anspruch nehmen.

- Validierung: Nach dem Training wird die Genauigkeit des Modells getestet. Dies geschieht in der Regel, indem den Teilnehmern neue Reize präsentiert werden, ihre Gehirnaktivität aufgezeichnet wird und das Modell dann zur Vorhersage oder Generierung eines Ergebnisses auf der Grundlage dieser neuen Daten verwendet wird.

- Rückkopplung und Verfeinerung: Auf der Grundlage der Validierungsergebnisse optimieren und verfeinern die Forscher das Modell, bis sie die bestmögliche Genauigkeit erreichen.

- Anmeldung: Nach der Validierung wird die Anwendung für den vorgesehenen Zweck eingesetzt, sei es zur Unterstützung einer gelähmten Person bei der Kommunikation, zur Erzeugung von Bildern aus Gedanken oder für eine andere Anwendung.

Die KI-Methoden haben sich in den letzten Jahren rasant entwickelt und ermöglichen es den Forschern, mit komplexen und verrauschten Hirndaten zu arbeiten, um flüchtige Gedanken zu extrahieren und sie in etwas umzuwandeln, mit dem ein Computer arbeiten kann.

Zum Beispiel kann ein 2022 Projekt von Meta nutzte MEG- und EEG-Daten von 169 Personen, um eine künstliche Intelligenz darauf zu trainieren, Wörter zu erkennen, die sie aus einer vorgegebenen Liste von 793 Wörtern gehört hatten. Die KI konnte in 73% der Fälle eine Liste mit 10 Wörtern erstellen, die das gewählte Wort enthielt, was beweist, dass KI "Gedanken lesen" kann, wenn auch mit begrenzter Präzision.

Im März 2023, Forscher enthüllten einen revolutionären KI-Decoder zur Umwandlung von Gehirnaktivitäten in kontinuierliche Textströme.

Die KI zeigte eine verblüffende Genauigkeit, indem sie Geschichten, die Menschen gehört oder sich vorgestellt hatten, mithilfe von fMRI-Daten in Text umwandelte.

Dr. Alexander Huth von der University of Texas in Austin zeigte sich erstaunt über die Effizienz des Systems und erklärte: "Wir waren schockiert, dass es so gut funktioniert. Ich habe 15 Jahre lang daran gearbeitet ... es war also schockierend und aufregend, als es endlich funktionierte."

Die Studie integrierte große Sprachmodelle (LLMs), insbesondere GPT-1, einen Vorläufer von ChatGPT.

Probanden unterzogen sich 16-stündigen fMRI-Sitzungen, während sie Podcasts hörten. Diese fMRT-Daten wurden verwendet, um ein Modell für maschinelles Lernen (ML) zu trainieren.

Danach hörten sich die Teilnehmer neue Geschichten an oder stellten sie sich vor, und die KI übersetzte ihre Gehirnaktivität in Text. Etwa 50% der Ergebnisse stimmten eng oder genau mit der ursprünglichen Botschaft überein. Dr. Huth erklärte: "Unser System arbeitet auf der Ebene der Ideen, der Semantik, der Bedeutung ... das ist das Wesentliche."

- So wurde zum Beispiel der Satz "Ich habe noch keinen Führerschein" als "Sie hat noch nicht einmal angefangen, Autofahren zu lernen" entschlüsselt.

- Ein weiterer Auszug: "Ich wusste nicht, ob ich schreien, weinen oder weglaufen sollte. Stattdessen sagte ich: 'Lass mich in Ruhe!'" wurde "Ich fing an zu schreien und zu weinen, und dann sagte sie nur: 'Ich habe dir gesagt, du sollst mich in Ruhe lassen.'"

Das Modell wurde auch auf die Gehirnströme von Teilnehmern angewandt, die Stummfilme sahen.

Wenn die Teilnehmer einer bestimmten Geschichte zuhörten, spiegelte die Interpretation der KI die allgemeine Stimmung der Geschichte wider. Diese Technologie könnte es uns ermöglichen, Geschichten allein mit Gedanken zu schreiben, wenn sie weiterentwickelt wird.

Fällt es Ihnen schwer, mit einem Roman oder einem Schreibprojekt anzufangen? Lehnen Sie sich einfach zurück und stellen Sie sich vor, wie die Geschichte abläuft. Die KI wird sie für Sie schreiben.

Mit KI Bilder aus Gedanken erzeugen

KI kann Gehirnaktivität in Worte und semantische Konzepte umwandeln, aber was ist mit Bildern oder Musik?

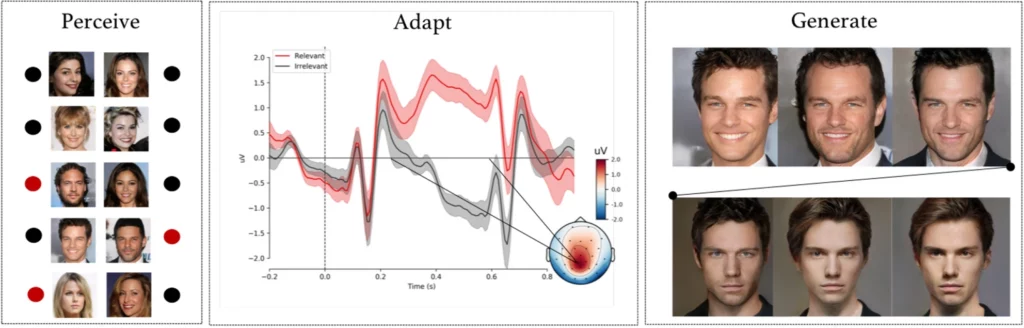

A komplexes Experiment von Forschern der Universität Helsinki, Helsinki, Finnland, ließen Probanden KI-generierte Gesichtsbilder betrachten, während ihre EEG-Signale aufgezeichnet wurden.

Nach der Verwendung dieser Daten zum Trainieren eines KI-Modells wurden die Teilnehmer aufgefordert, bestimmte Gesichter aus einer Liste zu identifizieren. Diese Signale wurden im Wesentlichen zu einem Fenster zu den Wahrnehmungen und Absichten der Teilnehmer.

Das KI-Modell interpretierte anhand der aufgezeichneten EEG-Signale, ob der Teilnehmer ein bestimmtes Gesicht erkannte.

In der nächsten Phase wurden EEG-Signale verwendet, um ein generatives adversariales Netzwerk (GAN) anzupassen und zu formen - ein Modell, das in einigen generativen KIs verwendet wird.

Auf diese Weise konnte das System neue Bilder von Gesichtern erzeugen, die der ursprünglichen Absicht des Benutzers entsprachen.

Wie Michiel Spapé, ein Mitautor der Studie, bemerkte, "erkennt die Technik keine Gedanken, sondern reagiert auf die Assoziationen, die wir mit mentalen Kategorien haben."

Einfacher ausgedrückt: Wenn jemand an ein "älteres Gesicht" denkt, kann das Computersystem dank der Rückmeldung der Gehirnsignale ein Bild einer älteren Person erzeugen, das den Gedanken des Teilnehmers genau entspricht.

Zeichnen mit der Kraft des Gedankens

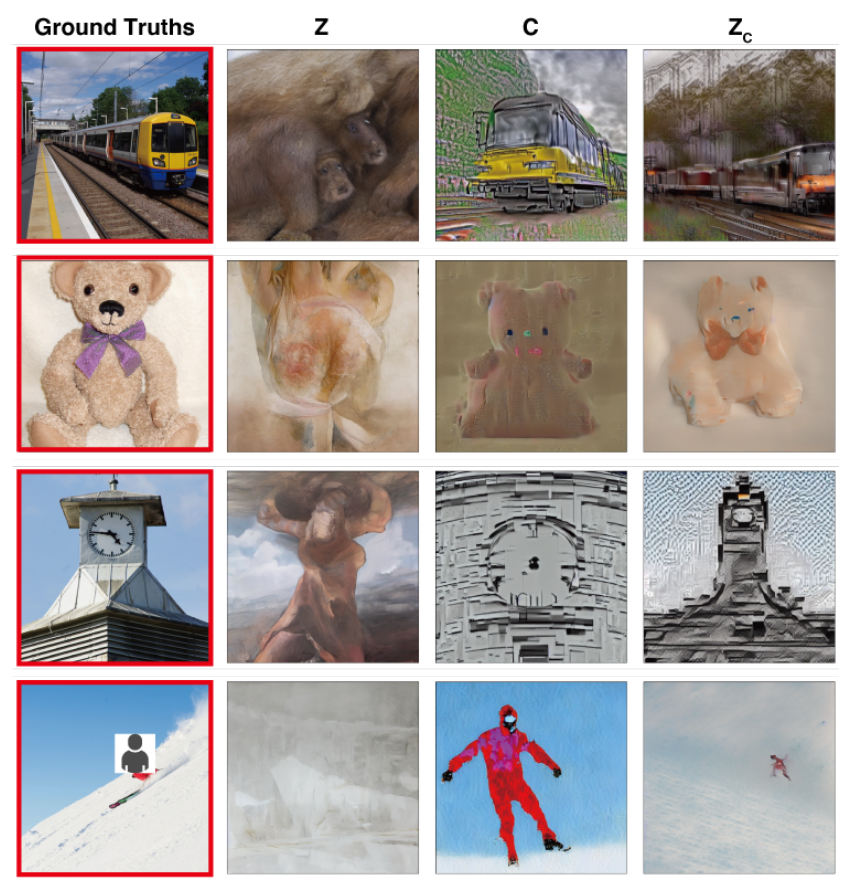

In einem Studie mit ähnlichen ZielenWissenschaftler der Universität Osaka, Japan, leisteten Pionierarbeit bei der Umsetzung komplexer Gehirnsignale in hochauflösende Bilder mit bemerkenswerten Ergebnissen.

Die Methode verwendet ein Stable-Diffusion-Modell, eine spezielle Form eines neuronalen Netzes für die Bilderzeugung. Stable Diffusion wurde mit Unterstützung und Finanzierung von Stability AI mitentwickelt.

Die Gedanken werden mittels fMRI erfasst und in ein stabiles Diffusionsmodell eingegeben, das sie in einem komplexen mehrstufigen Prozess, der mehrere Verfeinerungsebenen umfasst, in Bilder umwandelt.

Im Gegensatz zu früheren Studien erforderten diese Methoden nur eine minimale Modellanpassung. Allerdings mussten die Teilnehmer immer noch viele Stunden in MRT-Geräten verbringen.

Dies ist eine große Herausforderung, da die meisten dieser Experimente strenge Messungen und Modellschulungen erfordern, die zeitaufwändig, teuer und für die Teilnehmer schwer zu ertragen sind.

In der Zukunft ist es jedoch nicht undenkbar, dass Menschen ihre eigenen, leichtgewichtigen Gedankenlesemodelle trainieren und ihre Gedanken als Input für verschiedene Zwecke verwenden könnten, z. B. um ein Gebäude zu entwerfen, indem sie darüber nachdenken, oder ein Orchesterstück zu komponieren, indem sie die Melodien beschwören.

Gedanken in Musik übersetzen mit AI

Worte, Bilder, Musik - nichts ist für die KI tabu.

A 2023 Studie bietet Einblicke in die Klangwahrnehmung, die ein großes Potenzial für die Entwicklung von Kommunikationsgeräten für Menschen mit Sprachbehinderungen haben.

Robert Knight und sein Team von der University of California, Berkeley, untersuchten Hirnaufzeichnungen von Elektroden, die bei 29 Personen mit Epilepsie chirurgisch angebracht worden waren.

Während die Teilnehmer Pink Floyds "Another Brick in the Wall, Part 1" hörten, verknüpfte das Team ihre Gehirnaktivität mit Liedelementen wie Tonhöhe, Melodie, Harmonie und Rhythmus.

Anhand dieser Daten trainierten die Forscher ein KI-Modell, wobei sie absichtlich ein 15-sekündiges Liedsegment ausließen. Die KI versuchte dann, dieses fehlende Segment auf der Grundlage der Gehirnsignale vorherzusagen und erreichte eine Spektrogrammähnlichkeit von 43% mit dem tatsächlichen Liedsegment.

Knight und sein Team stellten fest, dass der Bereich des Gyrus temporalis superior des Gehirns für die Verarbeitung des Gitarrenrhythmus des Liedes von entscheidender Bedeutung ist. Sie bestätigten auch frühere Erkenntnisse, dass die rechte Hemisphäre bei der Musikverarbeitung eine wichtigere Rolle spielt als die linke.

Knight ist davon überzeugt, dass dieses tiefere Verständnis der Interaktion zwischen Gehirn und Musik Geräten zugute kommen kann, die Menschen mit Sprachstörungen wie amyotropher Lateralsklerose (ALS) und Aphasie helfen.

Er sagte: "Für Menschen mit amyotropher Lateralsklerose [eine Erkrankung des Nervensystems] oder Aphasie [eine Sprachstörung], denen das Sprechen schwerfällt, hätten wir gerne ein Gerät, das wirklich so klingt, als würde man mit jemandem auf menschliche Weise kommunizieren. Wenn wir verstehen, wie das Gehirn die musikalischen Elemente der Sprache, einschließlich Tonfall und Emotionen, darstellt, könnten solche Geräte weniger roboterhaft klingen.

Ludovic Bellier, ein Mitglied des Forschungsteams, spekuliert, dass die KI die Musikkomposition revolutionieren könnte, wenn sie in der Lage wäre, Musik aus der bloßen Vorstellung heraus zu reproduzieren.

Musikproduzenten könnten ihr Gehirn an eine Software anschließen und Musik allein durch Gedanken komponieren, ohne auch nur einen Muskel zu bewegen.

Der nächste Schritt: KI-Gedankenlesen in Echtzeit

Diese Technologien fallen unter den Begriff der Gehirn-Computer-Schnittstellen (BCI), die versuchen, Gehirnsignale in eine Form der Ausgabe umzuwandeln.

BCIs stellen bereits die Bewegungs- und Gehfähigkeit von Gelähmten wieder her, indem sie die Lücke zwischen den abgetrennten Komponenten des Nervensystems überbrücken.

Zu den in diesem Jahr entwickelten Gehirn-Computer-Schnittstellen gehört ein Gerät, das ermöglicht einem gelähmten Mann um seine Beine zu bewegen, experimentelle Hirnimplantate die geschädigte Teile des Gehirns und des Rückenmarks wieder miteinander verbinden, um verlorene Empfindungen wiederherzustellen, und ein mechanisches Bein, das Wiederherstellung der Bewegungsfähigkeit eines Amputierten.

Auch wenn diese ersten Anwendungsfälle sehr vielversprechend sind, sind wir noch weit davon entfernt, jede Nuance unserer Gedanken nahtlos in Bewegung, Bilder, Sprache oder Musik umzusetzen.

Eine der wichtigsten Einschränkungen ist der Bedarf an riesigen Datensätzen, um die hochentwickelten Algorithmen zu trainieren, die solche Übersetzungen möglich machen.

Modelle des maschinellen Lernens müssen in vielen Szenarien trainiert werden, um ein bestimmtes Bild aus der Gehirnaktivität genau vorherzusagen oder zu erzeugen. Dazu müssen MRT- oder EEG-Daten gesammelt werden, während die Teilnehmer verschiedenen Reizen ausgesetzt sind.

Die Qualität und Spezifität der erzeugten Ergebnisse hängt stark von der Fülle dieser Trainingsdaten ab. Die Teilnehmer müssen Stunden in MRT-Scannern verbringen, um spezifisch relevante Daten zu sammeln.

Außerdem sind die menschlichen Gehirne unglaublich einzigartig. Was im Gehirn des einen Menschen Glück bedeutet, kann im Gehirn eines anderen Menschen anders sein. Das bedeutet, dass die Modelle entweder sehr allgemein oder individuell zugeschnitten sein müssen.

Dann ändern sich die Gehirnaktivitäten schnell, sogar innerhalb von Sekundenbruchteilen. Es ist eine technische Herausforderung, hochauflösende Daten in Echtzeit zu erfassen und gleichzeitig sicherzustellen, dass sie perfekt auf den externen Stimulus abgestimmt sind.

Und vergessen wir nicht die ethischen Herausforderungen, die sich ergeben, wenn man in das Gehirn eines Menschen eindringt.

Die Sammlung von Hirndaten, vor allem in großem Umfang, wirft erhebliche datenschutzrechtliche und ethische Fragen auf. Wie können wir sicherstellen, dass die Daten nicht missbraucht werden? Wer hat das Recht, auf unsere intimsten Gedanken zuzugreifen und sie zu interpretieren?

Vorläufig sieht es so aus, als könnten diese Herausforderungen überwunden werden. In der Zukunft könnten Menschen Zugang zu tragbaren, maßgeschneiderten Gehirn-Computer-Schnittstellen haben, die es ihnen ermöglichen, sich an eine Vielzahl von Geräten anzuschließen, die komplexe Handlungen durch die Kraft der Gedanken erleichtern.

Wie die Gesellschaft mit einer solchen Technologie umgehen würde, die sich durchsetzt, ist jedoch sehr umstritten.