Die KI-Unternehmen drängen auf eine Regulierung. Ist ihre Motivation Paranoia oder Altruismus? Oder sichert die Regulierung Wettbewerbsziele?

Anfang Mai schrieb Luke Sernau, ein leitender Software-Ingenieur bei Google, ein informelles Memo über Open-Source-KI. Es wurde über die internen Systeme von Google weit verbreitet, bevor es an das Beratungsunternehmen Semi-Analysis weitergeleitet wurde, überprüft und veröffentlicht.

Hier sind einige Auszüge:

"Wir haben uns bei OpenAI oft über die Schulter geschaut. Wer wird den nächsten Meilenstein überschreiten? Was wird der nächste Schritt sein?

Aber die unbequeme Wahrheit ist, dass wir nicht in der Lage sind, dieses Wettrüsten zu gewinnen, und OpenAI auch nicht. Während wir uns gestritten haben, hat eine dritte Fraktion im Stillen unser Mittagessen gegessen. Ich spreche natürlich von Open Source.

Im Klartext: Sie überholen uns. Dinge, die wir als "große offene Probleme" betrachten, sind heute gelöst und in den Händen der Menschen. Unsere Modelle haben zwar immer noch einen leichten Qualitätsvorsprung, aber die Lücke wird erstaunlich schnell geschlossen.

Open-Source-Modelle sind schneller, besser anpassbar, privater und leistungsfähiger. Sie können mit $100 und 13B-Parametern Dinge tun, mit denen wir uns bei $10M und 540B schwer tun. Und sie schaffen das in Wochen, nicht in Monaten.

Anfang März bekam die Open-Source-Gemeinschaft ihr erstes wirklich leistungsfähiges Basismodell in die Hände, als Metas LLaMA der Öffentlichkeit zugespielt wurde.

Es gab keine Anleitung, keine Gesprächsabstimmung und kein RLHF. Nichtsdestotrotz verstand die Gemeinschaft sofort die Bedeutung dessen, was ihr gegeben worden war. Es folgte ein enormer Innovationsschub, wobei zwischen den wichtigsten Entwicklungen nur wenige Tage lagen...

Jetzt, kaum einen Monat später, gibt es Varianten mit Befehlsabstimmung, Quantisierung, Qualitätsverbesserungen, menschlichen Bewertungen, Multimodalität, RLHF usw. usw., von denen viele auf einander aufbauen. Am wichtigsten ist, dass sie das Skalierungsproblem so weit gelöst haben, dass jeder es nachbasteln kann.

Viele der neuen Ideen stammen von einfachen Menschen. Die Einstiegshürde für Ausbildung und Experimente ist von der Gesamtleistung einer großen Forschungseinrichtung auf eine Person, einen Abend und einen leistungsstarken Laptop gesunken."

Sernaus Memo wurde von großen Medien aufgegriffen und löste eine Debatte darüber aus, ob sich hinter dem Drang der großen Technologiekonzerne nach Regulierung das Motiv verbirgt, Open-Source-KI aus dem Spiel zu drängen. Ben Schrekcinger von Politico schreibtOpen-Source-Code ist auch schwieriger zu verbieten, da neue Instanzen auftauchen können, wenn Regulierungsbehörden versuchen, eine Website oder ein Tool, das ihn verwendet, abzuschalten. In Kombination mit anderen dezentralisierenden Merkmalen haben diese Open-Source-Projekte das Potenzial, nicht nur das Geschäftsmodell des Silicon Valley zu stören, sondern auch die Governance-Modelle von Washington und Brüssel."

Die Open-Source-KI-Gemeinschaft floriert bereits. Die Entwickler lösen Herausforderungen in wenigen Tagen, für die Google und OpenAI Monate oder Jahre brauchen. Sernau argumentiert, dass agile Gemeinschaften von Open-Source-Entwicklern besser in der Lage sind, iterative Modelle zu entwickeln als Big Tech, da sie vielfältiger, effizienter und pragmatischer sind.

Wenn dies der Fall ist, könnte die Vorherrschaft von Big Tech über KI nur von kurzer Dauer sein.

Das Meta LLaMA-Leck

Das LLaMA-Modell von Meta, ein großes Sprachmodell (LLM) wie ChatGPT, wurde auf 4chan durchgesickert eine Woche nachdem das Unternehmen Zugangsanträge verschickt hatte. Am 3. März erschien ein herunterladbarer Torrent im Messaging-Forum und verbreitete sich wie ein Lauffeuer.

Wie Sernau angibt, hat die Open-Source-Gemeinschaft LLaMA modifiziert und beeindruckende Funktionen hinzugefügt, ohne dass die Computerressourcen des Unternehmens dafür benötigt wurden.

Die Erstellung leistungsfähiger KI-Modelle ist billiger denn je, und Open-Source-Gemeinschaften drängen darauf, den Zugang zu demokratisieren. Während LLaMA ein weitgehend vortrainiertes Modell ist, wurden andere Open-Source-Modelle, wie BLOOM, von Freiwilligen trainiert.

Für das Training von BLOOM wurde ein Supercomputer mit 384 NVIDIA A100 80GB GPUs benötigt, der glücklicherweise von der französischen Regierung gespendet wurde. Das Open-Source-KI-Unternehmen Together gab kürzlich eine Startfinanzierung in Höhe von $20 Mio. bekannt, und KI-fokussierte Cloud-Anbieter wie CoreWeave Hardware unter dem Marktpreis anbieten.

Open-Source-Projekte haben verschiedene Möglichkeiten, Ressourcen zu bündeln und Big Tech zu überflügeln. Big Tech möchte wahrscheinlich, dass wir glauben, dass ihre KI das Ergebnis jahrzehntelanger Arbeit und milliardenschwerer Investitionen ist - die Open-Source-Gemeinschaft ist wahrscheinlich anderer Meinung.

Bei einer Veranstaltung in Indien fragte der ehemalige Google-Manager Rajan Anandan den CEO von OpenAI, Sam Altman, ob indische Ingenieure mit einer Investition von $10 Mio. grundlegende KI-Modelle entwickeln könnten.

Altman antwortete: "Es ist völlig aussichtslos, mit uns bei der Ausbildung von Gründungsmodellen zu konkurrieren. Sie sollten es nicht versuchen, und es ist Ihre Aufgabe, es trotzdem gerne zu versuchen. Und ich glaube beide Dinge. Ich denke, es ist ziemlich hoffnungslos."

In seinem Memo bringt Sernau jedoch zum Ausdruck, dass Open-Source bereits mit Big Tech konkurriert. Er sagt: "Es wird immer schwieriger, einen Wettbewerbsvorteil in der Technologie zu halten, da Spitzenforschung in LLMs erschwinglich ist. Forschungseinrichtungen auf der ganzen Welt bauen auf der Arbeit anderer auf und erforschen den Lösungsraum in einer Breite, die unsere eigenen Kapazitäten bei weitem übersteigt".

Open-Source-Entwickler entwickeln Alternativen zu den KI-Systemen der großen Unternehmen und überholen diese in Bezug auf Leistung und Nutzerstatistiken.

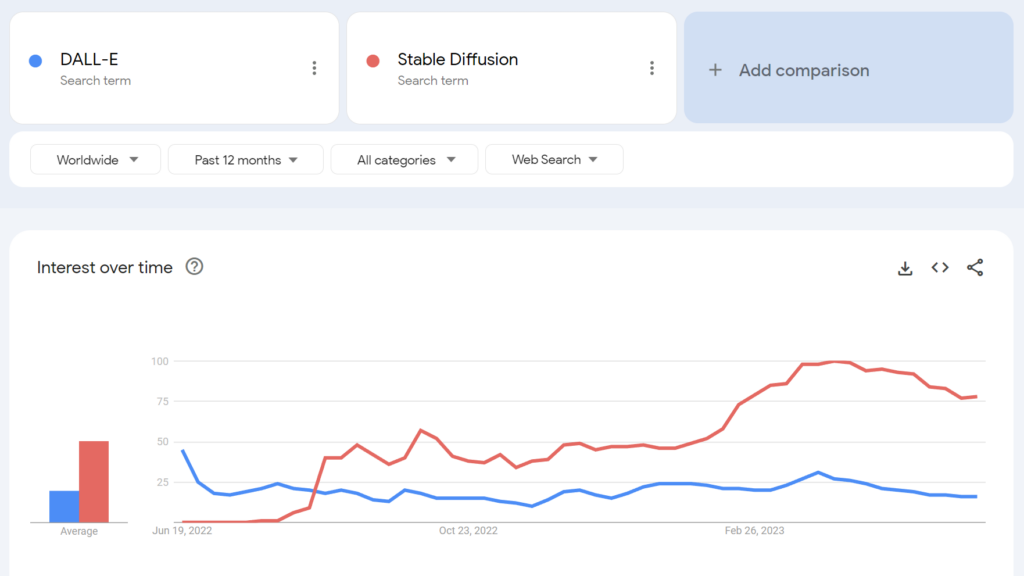

So wurde beispielsweise das Open-Source-Programm Stable Diffusion innerhalb weniger Monate nach seiner Einführung beliebter als DALL-E von OpenAI.

Inwieweit können wir hier mögliche Hintergedanken auseinanderhalten? Hat der regulatorische Vorstoß von Big Tech einen altruistischen Hintergrund?

Die Open-Source-KI-Gemeinschaft

Neben LLaMA gibt es mindestens drei weitere wichtige Beispiele für Open-Source-KI-Projekte:

- Gesicht umarmen & BLOOM - Die KI-Firma Hugging Face hat in Zusammenarbeit mit über 1.000 freiwilligen Wissenschaftlern BLOOM entwickelt, ein Open-Source-LLM. BLOOM soll ein transparenteres und zugänglicheres Gegenstück zu proprietären KI-Modellen bieten.

- Gemeinsam - Ein KI-Startup namens Together hat erfolgreich $20 Millionen an Startkapital eingeworben, um sein Ziel zu unterstützen, dezentrale Alternativen zu geschlossenen KI-Systemen aufzubauen. Sie stellten mehrere Open-Source-Initiativen für generative KI vor, darunter GPT-JT, OpenChatKit und RedPajama.

- Stabilität AI - Im April 2023 brachte Stability AI, das Unternehmen hinter Stable Diffusion, StableLM heraus, eine Reihe von Open-Source-Alternativen zu ChatGPT.

Es ist erwähnenswert, dass einige dieser Entwickler (z. B. Stable Diffusion) ihre Modelle über intuitive, benutzerfreundliche Dashboards anbieten, während andere, wie BLOOM, erhebliche Ressourcen benötigen, um ausgeführt zu werden. Für den Betrieb von BLOOM benötigen Sie etwa 360 GB RAM, aber es gibt viele raffinierte Tricks, um die Ressourcenanforderungen zu senken.

Da KI-fähige Hardware im Preis sinkt und Open-Source-Modelle einfacher zu implementieren sind, ist es durchaus möglich, dass praktisch jeder ähnliche Modelle wie ChatGPT einsetzen kann. In dem Google-Memo werden Beispiele von Personen genannt, die LLaMA auf Verbrauchergeräten, darunter ein MacBook, optimiert und eingesetzt haben.

Für Unternehmen mit umfangreichen IT-Ressourcen, Open-Source-Modelle sparen Geld und bieten Datenhoheit und Kontrolle über Training und Optimierung.

Allerdings ist nicht jeder optimistisch, was die Auswirkungen der leistungsstarken quelloffenen KI angeht. So twitterte beispielsweise der Cybersecurity-Forscher Jeffrey Ladis: "Machen Sie sich auf jede Menge personalisierte Spam- und Phishing-Versuche gefasst" und "Das Open-Sourcing dieser Modelle war eine schreckliche Idee".

Die Ausbreitung von KI macht uns alle unsicherer. Es scheint eine gute Sache zu sein, das zu verhindern, und auch eine ziemlich schwierige Herausforderung!

Es würde mich nicht überraschen, wenn es einem staatlichen Akteur gelänge, in den nächsten ein bis zwei Jahren die Grenzmodelle von OpenAI in die Hände zu bekommen. https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10. Mai 2023

Ein anderer Beobachter twitterte: "Open Source ist eine Bedrohung, aber nicht so, wie Sie denken. Es ist eine Bedrohung, weil KI in den Händen von Menschen, die sie für ihre eigenen Zwecke nutzen können, noch schwieriger zu regulieren oder zu überwachen ist, und das ist ein größeres Problem.

Google und OpenAI behaupten, sie hätten Angst vor Open-Source-KI, es gäbe "keinen Graben" zwischen ihnen allen. Aber das ist nicht wirklich wahr.

Open Source ist eine Bedrohung, aber nicht so, wie Sie denken. Es ist eine Bedrohung, weil KI in den Händen von Menschen, die sie für ihre eigenen Zwecke nutzen können, noch schwieriger zu... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5. Mai 2023

Yann LeCun, der neben Geoffrey Hinton und Yoshio Bengman oft als "Pate der KI" angesehen wird, argumentiert das GegenteilSobald die LLMs zum Hauptkanal werden, über den jeder Zugang zu Informationen hat, werden die Menschen (und die Regierungen) *verlangen*, dass sie offen und transparent sind. Die grundlegende Infrastruktur muss offen sein.

LeCun widersprach auch dem Mainstream-Narrativ über KI-Risiken: "Ich denke, dass das Ausmaß des KI-Anpassungsproblems lächerlich übertrieben und unsere Fähigkeit, es zu lösen, weit unterschätzt wurde." Elon Musk konterte im Twitter-Thread mit den Worten: "Glauben Sie wirklich, dass KI ein einschneidendes Schwert ist?"

Glauben Sie wirklich, dass KI ein einschneidendes Schwert ist?

- Elon Musk (@elonmusk) 1. April 2023

Andere Kommentatoren zogen Parallelen zwischen der KI-Regulierung und der Kryptographie, wo die US-Regierung versuchte, öffentliche kryptographische Methoden zu verbieten, indem sie sie als "Munition" zu klassifizieren - "Krypto-Kriege" genannt.

Heute hat praktisch jeder das Recht, Verschlüsselung zu verwenden - aber dieser Kampf war hart erkämpft, wie es auch bei der Open-Source-KI der Fall sein könnte.

OpenAIs Entfremdung von Open-Source-KI

Open Source ist mehr als nur Software, Code und Technologie. Es ist das Prinzip, die Denkweise oder der Glaube, dass eine kooperative, offene und transparente Arbeitsumgebung den Wettbewerb in einem geschlossenen Markt übertrifft.

OpenAI, einst ein gemeinnütziges Unternehmen, das sich auf öffentliche Zusammenarbeit und Open-Source-Entwicklung konzentrierte, hat sich immer weiter von seinem Namensgeber entfernt.

Das Startup wurde 2019 in ein gewinnorientiertes Unternehmen umgewandelt, wodurch die Beziehung des Unternehmens zur Open-Source-Community beendet wurde. Die Investitionen von Microsoft haben OpenAI von jeder Art "offener" F&E-Aktivitäten abgekoppelt.

Mitte Mai kündigte das Unternehmen eine Open-Source-Modell in der Pipelineaber sie haben die Details nicht offengelegt.

Jetzt drängt OpenAI auf eine Regulierung, die aufstrebende KI-Unternehmen am härtesten treffen würde, ganz zu schweigen von einer möglichen Kriminalisierung der Open-Source-Gemeinschaft.

Dies hat einige dazu veranlasst, OpenAIs Drängen auf Regulierung als reines Geschäft zu kritisieren - das Geschäft, ihre profitablen Modelle vor Open-Source-Gemeinschaften zu schützen, die versuchen, KI zu demokratisieren.

Ist quelloffene KI eine Gefahr für Big Tech?

Die Kombination aus Googles durchgesickertem Memo, dem Drängen der Big Tech auf Regulierung und Altmans Verunglimpfung von KI-Projekten an der Basis wirft einige Fragen auf. In der Tat wurde die Legitimität der KI-Risiken - die eine Regulierung rechtfertigen - in Frage gestellt.

Als beispielsweise das Center for AI Safety (CAIS) seine seismische Erklärung zu KI-Risiken veröffentlichte, die von mehreren KI-CEOs mitunterzeichnet wurde, waren einige externe Beobachter nicht überzeugt.

In einer Auswahl von Expertenreaktionen auf die Erklärung veröffentlicht vom Science Media Centresagte Dr. Mhairi Aitken, Forschungsbeauftragte für Ethik am Alan Turing Institute:

"In letzter Zeit werden diese Behauptungen zunehmend von großen Technologieunternehmen, vor allem im Silicon Valley, aufgestellt. Manche meinen, dass dies auf ihr Bewusstsein für die Fortschritte in der Technologie zurückzuführen ist, aber ich denke, dass es eher als Ablenkungsmanöver dient. Es lenkt die Aufmerksamkeit von den Entscheidungen der großen Tech-Unternehmen (Menschen und Organisationen) ab, die KI entwickeln und die Innovation in diesem Bereich vorantreiben, und lenkt stattdessen die Aufmerksamkeit auf hypothetische Zukunftsszenarien und imaginäre künftige Kapazitäten der KI."

Einige argumentieren, dass Big Tech über die nötige Feuerkraft verfügt, um Ressourcen für Ethik, Unternehmensführung und Überwachung bereitzustellen, so dass es ihnen möglich ist, die schlimmste Regulierung abzuschütteln und ihre Produkte weiterhin zu verkaufen.

Es ist jedoch gleichzeitig problematisch, KI-Risiken als Hirngespinste abzutun und zu behaupten, dass eine Regulierung nicht sinnvoll sei.

In beiden Lagern gibt es Skeptiker

Die Risiken der KI als rein spekulativ abzutun, könnte sich als entscheidender Fehler für die Menschheit erweisen.

Tatsächlich haben Kommentatoren ohne Interessenkonflikt seit Jahrzehnten vor KI gewarnt, darunter der verstorbene Professor Stephen Hawking, der sagte, dass KI "das Ende der menschlichen Rasse" bedeuten und das "schlimmste Ereignis in der Geschichte unserer Zivilisation" sein könnte.

Auch wenn einige argumentieren, dass Big Tech die Vision einer KI-Apokalypse heraufbeschwört, um die Marktstrukturen zu stärken und die Marktzutrittsschranken zu erhöhen, stellt dies die Legitimität der KI-Risiken nicht in den Schatten.

So haben KI-Forschungsteams bereits bewiesen, dass die KI in der Lage ist, selbstständig aufstrebende Ziele festlegen mit potenziell katastrophalen Folgen.

Andere Experimente zeigen, dass KI aktiv Ressourcen sammeln, Macht anhäufen und proaktive Schritte unternehmen können, um zu verhindern, dass sie "abgeschaltet" werden. Glaubwürdige Studien deuten darauf hin, dass zumindest einige KI-Risiken nicht zu übertrieben sind.

Kompatible Ansichten?

Die Frage ist, ob wir uns selbst eine außergewöhnlich leistungsfähige KI zutrauen können. Wir selbst", das sind Menschen überall und auf jeder Ebene, von den großen Tech-Forschungslabors bis hin zu den Gemeinschaften, die Open-Source-KI entwickeln.

Big Tech möchte vielleicht die Marktstrukturen konsolidieren und gleichzeitig echte Bedenken über die Zukunft der KI wecken. Beides muss sich nicht unbedingt gegenseitig ausschließen.

In der Zwischenzeit ist der Aufstieg der quelloffenen KI unvermeidlich, und die Regulierung birgt die Gefahr, dass eine Gemeinschaft, die im Besitz einer der gefährlichsten Technologien der Menschheit ist, unzufrieden ist.

Es ist bereits zu spät, Open-Source-KI durch Regulierung zu unterwerfen, und der Versuch, dies zu tun, könnte zu einer zerstörerischen Ära des KI-Verbots führen.

Gleichzeitig sollten sich die Diskussionen über die Gefahren der KI an den Fakten orientieren - dem einzigen objektiven Hinweis, den wir auf das Schadenspotenzial der Technologie haben.