Tilbage i 1956 skrev Philip K. Dick en novelle med titlen "The Minority Report", der spandt et net af en fremtid, hvor "precogs" kunne forudse forbrydelser, før de fandt sted i virkeligheden.

Et par årtier senere bragte Tom Cruise denne uhyggelige vision til det store lærred, hvor han jagtede potentielle forbrydere baseret på disse forudsigelser.

Begge versioner tvang os til at overveje de etiske konsekvenser af at blive anholdt for noget, man måske vil gøre i fremtiden.

I dag, hvor predictive policing-metoder sniger sig ind i moderne retshåndhævelse, må man spørge sig selv: Er vi på vej til at realisere Dicks forudseende fortælling?

Hvad er predictive policing, og hvordan fungerer det?

Forudsigende politiarbejde smelter sammen med retshåndhævelse og avanceret analyse og udnytter maskinlæring til at forudse kriminelle aktiviteter, før de finder sted.

Præmissen er på papiret ligetil: Hvis vi kan afkode de mønstre, der er skjult i historiske kriminalitetsdata, kan vi lave algoritmer til at forudsige fremtidige hændelser.

Processen starter med at samle historiske kriminalitetsregistre, overvågningsfeeds, snak på sociale medier og endda nuancer som vejrudsving. Denne store mængde information føres derefter ind i sofistikerede maskinlæringsmodeller, der er designet til at skelne mellem underliggende mønstre.

For eksempel kan modellen se, at der i et bestemt kvarter er en stigning i antallet af indbrud på regnfulde weekendaftener.

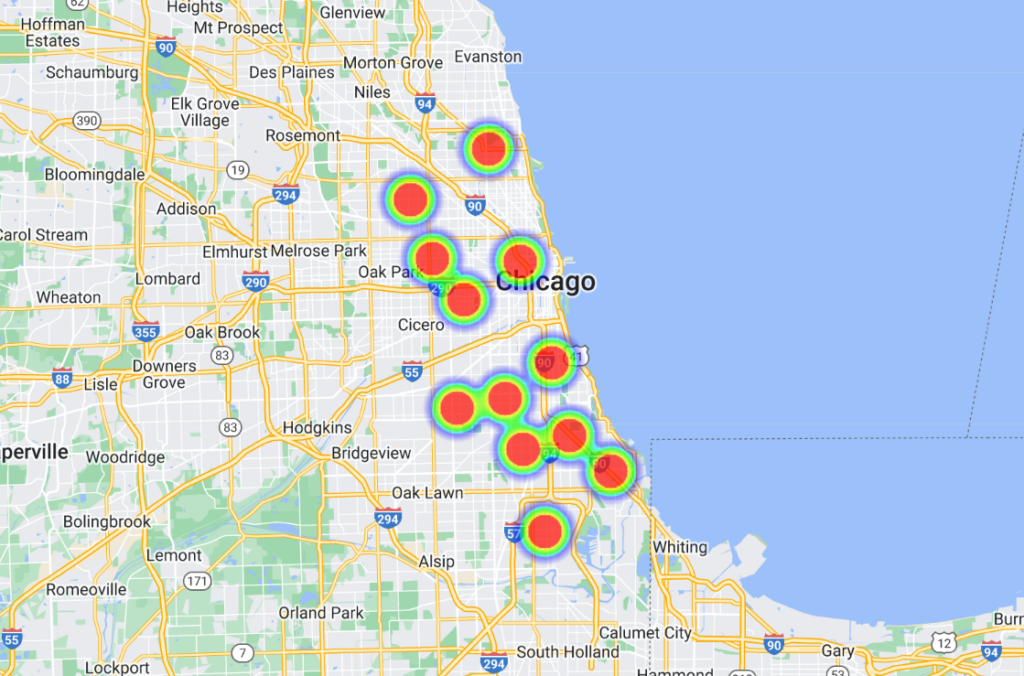

Når disse sammenhænge er fundet, omdanner avancerede softwareplatforme dem til visuelle repræsentationer, der ofte ligner "varmekort", som fremhæver sandsynlige hotspots for kriminalitet. Det giver igen politiet mulighed for at fordele deres ressourcer proaktivt og optimere deres patruljering og indsats.

Nogle modeller er gået skridtet videre og oplister folk med navn og adresse, hvilket giver betjentene meget specifikke og lokaliserede forudsigelser.

Historien om forudsigende politiarbejde

Forudsigende polititeknologi er stadig i sin vorden, og selv om der har været nogle indflydelsesrige aktører i branchen, som Palantir, er branchen lille.

I juni 2022 blev University of Chicago udviklet en AI-model i stand til at forudsige kriminalitetens placering og omfang i byen med en påstået præcision på 90%.

Med udgangspunkt i åbne kriminalitetsdata fra 2014 til 2016 inddelte teamet Chicago i kvadrater på ca. 300 m (1000 fod). Modellen kunne en uge i forvejen forudsige, hvilken firkant der havde størst sandsynlighed for at blive udsat for en forbrydelse.

Undersøgelsen havde ærlige hensigter og afslørede rumlige og socioøkonomiske skævheder i politiets indsats og ressourceallokering. Den viste, at velhavende kvarterer fik flere ressourcer end områder med lavere indkomst.

Med undersøgelsens ord: "Her viser vi, at selvom prædiktive modeller kan øge statens magt gennem kriminel overvågning, muliggør de også overvågning af staten ved at spore systemiske skævheder i håndhævelsen af kriminalitet."

Derudover blev modellen trænet ved hjælp af data fra syv andre amerikanske byer, som viste lignende resultater. Alle datasæt og algoritmer er gjort tilgængelige på GitHub.

Chicago er et vigtigt eksempel på datadrevet og AI-støttet politiarbejde. Et andet eksempel er byens Heatmap over våbenkriminalitetsom identificerer "hotspots" for kriminalitet, der kan indgå i politiets indsats.

En bemærkelsesværdig hændelse tilbage i 2013 - i den prædiktive politiindsats' barndom - var involveret Robert McDanielsHan bor i Chicagos Austin-distrikt, som står for 90% af byens våbenforbrydelser.

På trods af sin ikke-voldelige fortid blev McDaniel, da han blev opført på en liste over potentielt voldelige kriminelle, to gange mål for skydevåben i kraft af, at politiet kom til hans dør og gjorde ham til et mål.

En undersøgelse foretaget af The Verge siger, at en journalist fra Chicago Tribune kontaktede McDaniel angående "varmelisten" - et uofficielt navn, som politiet har givet de algoritmer, der mærker potentielle skytter og mål.

Ishanu Chattopadhyay, den ledende forsker i Chicago 2022 Projekt til forudsigelse af kriminalitetHan understregede, at deres model forudsiger steder, ikke individer. "Det er ikke Minority Report," sagde han - men McDaniels-begivenheden trækker bestemt nogle paralleller.

Chattopadhyay bemærkede, at de med vilje udelod borgerrapporterede mindre narkotika- og trafikforseelser og fokuserede på hyppigere rapporterede volds- og ejendomsforbrydelser.

Men sndersøgelser viser, at sorte personer oftere anmeldes for forbrydelser end deres hvide modparter. Derfor bliver sorte kvarterer uretfærdigt stemplet som "højrisikoområder".

Desuden betyder intensiveret politiarbejde i et område mere anmeldt kriminalitet, hvilket skaber en feedback-loop, der forvrænger opfattelsen af kriminalitet.

Hvis man så baserer sig på tidligere data, kan man fastholde stereotyper og overse potentialet for forandring og rehabilitering.

Hvordan er det gået med predictive policing?

Predictive policing er ikke overraskende meget omstridt, men virker det overhovedet eller opfylder det sit grundlæggende formål?

En undersøgelse fra oktober 2023 af Markup og Wired afslørede åbenlyse fejl og føjede sig til en voksende mængde af beviser, der fremhæver farerne og manglerne ved at overføre beslutningstagning om retshåndhævelse til maskiner.

Programmet i fokus er Geolitica, en software til forudsigende politiarbejde, der bruges af politiet i Plainfield, New Jersey. Det er værd at bemærke, at Plainfields politiafdeling var den eneste ud af 38 afdelinger, der var villig til at dele data med medierne.

Tidligere kendt som PredPolblev denne maskinlæringssoftware købt af forskellige politiafdelinger.

The Markup og Wired analyserede 23.631 af Geoliticas forudsigelser fra februar til december 2018. Ud af disse matchede mindre end 100 forudsigelser virkelige kriminalitetstilfælde, hvilket resulterede i en succesrate på mindre end en halv procent.

Disse forudsigelsesmodeller har altid været omstridte og rejst mange etiske spørgsmål om deres potentiale til at forstærke diskriminerende og racistiske fordomme, der er fremherskende inden for AI og retshåndhævelse.

Den seneste undersøgelse understreger etiske dilemmaer og sætter spørgsmålstegn ved softwarens evne til at forudsige forbrydelser.

Selv om softwaren viste små variationer i forudsigelsesnøjagtighed på tværs af kriminalitetstyper (f.eks. forudsagde den korrekt 0,6 procent af røverier eller grove overfald sammenlignet med 0,1 procent af indbrud), er den overordnede fortælling stadig en om grov underpræstation.

Plainfields politikommissær David Guarinos ærlige svar kaster lys over virkeligheden. "Hvorfor fik vi PredPol? Vi ønskede at forbedre vores effektivitet i forhold til at reducere kriminalitet," sagde han.

"Jeg er ikke sikker på, at den opnåede det. Vi brugte den sjældent, hvis nogensinde." Han nævnte også, at politiet var holdt op med at bruge det.

Kaptajn Guarino foreslog, at de midler, der var afsat til Geolitica - som udgjorde et årligt abonnementsgebyr på $20.500 plus yderligere $15.500 for et andet år - kunne have været investeret mere effektivt i samfundscentrerede programmer.

Geolitica er indstillet på at lukke ned for aktiviteterne ved årets udgang.

Beviser, der dokumenterer bias i forudseende politiarbejde

Løftet om forudsigende politiarbejde er stadig fristende, især da politistyrkerne bliver mere og mere udspændte, og kvaliteten af politiets menneskelige beslutningstagning bringes i miskredit.

Politistyrker i USA, Storbritannien og flere europæiske lande, herunder Frankrig, er i søgelyset på grund af fordomme over for minoritetsgrupper.

Medlemmer af både det britiske overhus og underhus opfordrer til en midlertidigt stop om politiets anvendelse af live ansigtsgenkendelsesteknologi.

Det kom frem, efter at politiminister Chris Philip diskuterede at give politistyrkerne adgang til 45 millioner billeder fra pasdatabasen til politiets ansigtsgenkendelse. Indtil videre er 65 parlamentarikere og 31 rettigheds- og racelighedsorganisationer imod at bruge ansigtsgenkendelsesteknologier i politiarbejdet.

Interesseorganisationen Big Brother Watch erklærede, at 89% af det britiske politis ansigtsgenkendelsesalarmer ikke opfylder deres formål, med uforholdsmæssigt dårligere resultater for etniske minoritetsgrupper og kvinder. Et forsøg med ansigtsgenkendelse udført af London Metropolitan Police i 2018 havde et dystert succesrate på kun omkring 2%.

Som Michael Birtwistle fra Ada Lovelace Institute, beskrevet"Nøjagtigheden og det videnskabelige grundlag for ansigtsgenkendelsesteknologier er meget omstridt, og deres lovlighed er usikker."

I USA har et samarbejdsprojekt mellem Columbia University, AI Now Institute og andre for nylig analyseret amerikanske retssager, der involverer algoritmer.

Undersøgelsen viste, at AI-systemer ofte blev implementeret hurtigt og uden passende tilsyn, primært for at reducere omkostningerne. Desværre resulterede disse systemer ofte i forfatningsmæssige problemer på grund af iboende bias.

Mindst fire sorte mænd er blevet fejlagtigt anholdt og/eller fængslet på grund af forkerte ansigtsmatch i USA, herunder Nijeer Parks, fejlagtigt anklaget for butikstyveri og færdselsforseelser på trods af, at han var 50 km væk fra de påståede hændelser. Han tilbragte efterfølgende ti dage i fængsel og måtte betale tusindvis af kroner i sagsomkostninger.

Den Studiets forfattere konkluderede"Disse AI-systemer blev implementeret uden meningsfuld træning, støtte eller tilsyn og uden nogen specifik beskyttelse af modtagerne. Det skyldtes til dels, at de blev indført for at opnå omkostningsbesparelser og standardisering under en monolitisk teknologi-indkøbsmodel, som sjældent tager hensyn til forfatningsmæssigt ansvar."

Forudseende politiarbejde kan fremme unaturlig beslutningstagning

Selv når predictive policing er præcist, skal mennesker handle på forudsigelserne, og det er her, det bliver noget rod.

Når en algoritme fortæller politiet, at de er nødt til at være et sted, fordi en forbrydelse er ved at blive begået eller sandsynligvis vil blive begået, er det langt fra umuligt at tro, at det forvrider beslutningstagningen.

Der er et par grundlæggende psykologiske teorier, som det ville være klogt at forholde sig til, når man overvejer AI's rolle i politiarbejdet.

For det første, når en algoritme informerer politiet om et sandsynligt gerningssted, kan det potentielt få dem til at se situationen i et forventningsperspektiv. Det kan have spillet en rolle i McDaniels-hændelsen - politiet ankom til stedet i forventning om, at der ville ske en hændelse, hvilket fik begivenhederne til at eskalere i et ustabilt miljø.

Dette har rod i bekræftelsesbias, som antyder, at når vi først har en oplysning, har vi en tendens til at opsøge og fortolke efterfølgende oplysninger på en måde, der stemmer overens med den oprindelige overbevisning.

Når nogen får at vide af en algoritme, at der sandsynligvis vil ske en forbrydelse, kan de ubevidst lægge mere vægt på signaler, der bekræfter denne forudsigelse, og overse dem, der modsiger den.

Desuden kan algoritmer, især dem, der bruges i officielle sammenhænge, opfattes som autoritative på grund af deres beregningsmæssige karakter, og betjente kan have uberettiget tillid til dem.

Og så er der risikoen for moralsk frigørelse. Betjente kan skubbe ansvaret for deres handlinger over på algoritmen og tænke, at det er softwaren, der har foretaget opkaldet, ikke dem - hvilket også er yderst relevant inden for krigsførelse.

Debatterne her er parallelle med dem omkring AI's brug på slagmarken, som stiller nogle lignende dilemmaer.

AI's påtvungne autoritet kan resultere i en "ansvarskløft", hvor ingen tager ansvar for fejl begået af AI'en, som fremhævet af Kate Crawford og Jason Schultz i en ny artikel. JSTOR-artikel.

Alt i alt viser de nuværende beviser, at prædiktivt politiarbejde ofte fastholder snarere end mindsker fordomme.

Når forudsigelser kombineres med menneskelig beslutningstagning, er konsekvenserne potentielt katastrofale.