En gruppe førende forskere har lanceret et frivilligt initiativ, der skitserer et sæt værdier, principper og forpligtelser for AI-proteindesign.

Den brev diskuterer det potentielle misbrug af AI-værktøjer, der er i stand til at designe nye proteiner med hidtil uset hastighed og effektivitet.

Selvom kunstig intelligens er meget lovende i forhold til at løse presserende globale udfordringer, lige fra pandemireaktioner til bæredygtige energiløsninger, rejser det også spørgsmål om muligheden for ondsindet brug, som f.eks. at skabe nye biovåben.

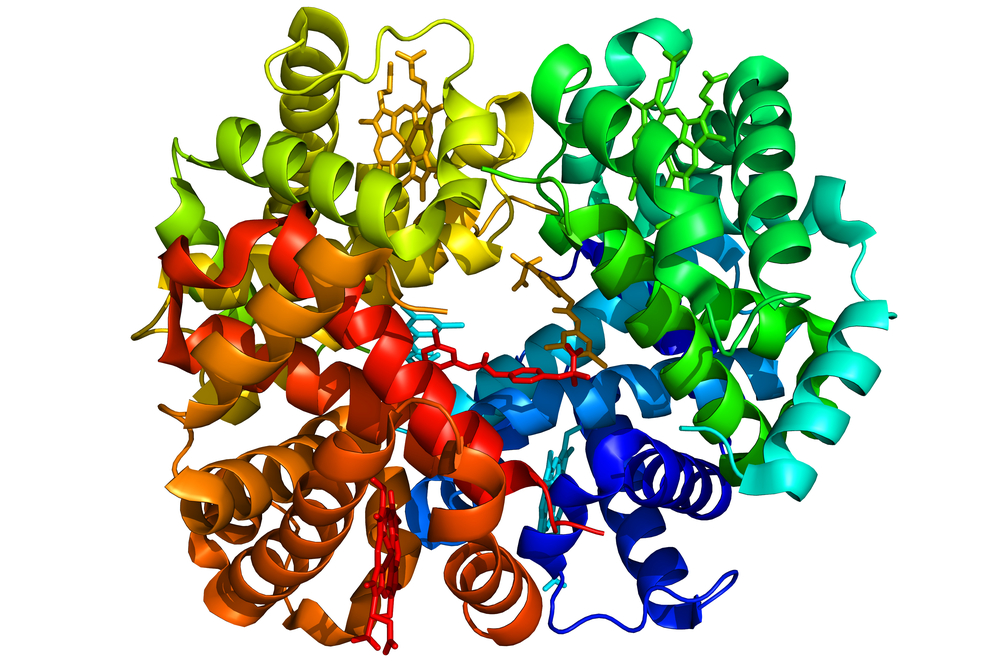

Mens proteinerne designet af DeepMinds AlphaFold-system og senere af forskere på University of Washington School of Medicine viste høj affinitet og specificitet over for deres tilsigtede mål, er der altid mulighed for, at disse proteiner kan interagere med andre molekyler i kroppen på uventede måder.

Det kan føre til uønskede bivirkninger eller endda udvikling af nye sygdomme.

En anden risiko er potentialet for misbrug eller ondsindet brug af denne teknologi. Ligesom AI-designede proteiner kan bruges til at skabe meget målrettede terapier, kan de også konstrueres til at forårsage skade.

For eksempel kan en ondsindet aktør potentielt designe et protein, der er rettet mod en bestemt etnisk gruppe eller udnytter en bestemt genetisk sårbarhed.

Som David Baker, en computerbaseret biofysiker ved University of Washington og en nøgleperson bag initiativet, bemærker: "Spørgsmålet var: Hvordan, hvis overhovedet, skal proteindesign reguleres, og hvad er i givet fald farerne?"

De mere end 100 underskrivere mener, at "fordelene ved de nuværende AI-teknologier for Proteindesign opvejer langt den potentielle skade", men anerkender behovet for en proaktiv tilgang til risikostyring, efterhånden som teknologien udvikler sig.

AI til biologi har potentiale til at hjælpe med at løse nogle af de vigtigste problemer, som vores samfund står over for. Videnskabelig åbenhed vil være afgørende for, at vores felt kan udvikle sig. Som forskere, der er engageret i dette arbejde, med mere end 90 underskrivere over hele verden, fremmer vi en ramme ... pic.twitter.com/4m81j87Vo9

- Alex Rives (@alexrives) 8. marts 2024

I brevet står der, at "i betragtning af de forventede fremskridt på dette område kan det være nødvendigt med en ny proaktiv risikostyringstilgang for at afbøde potentialet ved at udvikle AI-teknologier, der kan misbruges, bevidst eller på anden måde, til at forårsage skade."

Underskrevet.

En god idé til sikkerhed i proteindesign (AI-drevet eller ej): reguler og kontroller proteinsyntesemaskinerne og firmwaren, ikke selve AI-forskningen.

Det er en idé, jeg promoverede på UK AI Safety Summit. https://t.co/skcUUcgG5a- Yann LeCun (@ylecun) 8. marts 2024

Som en del af initiativformulerede forskerne et sæt værdier og principper, der skal guide den ansvarlige udvikling af AI-teknologier inden for proteindesign.

De omfatter "sikkerhed, tryghed, retfærdighed, internationalt samarbejde, åbenhed, ansvar og forskning til gavn for samfundet". Underskriverne er også frivilligt gået med til en række specifikke, handlingsorienterede forpligtelser, der bygger på disse værdier og principper.

Et vigtigt aspekt af initiativet fokuserer på at forbedre screeningen af DNA-syntese, et afgørende skridt i omsætningen af AI-designede proteiner til fysiske molekyler.

Forskerne forpligter sig til "kun at få DNA-synteseydelser fra udbydere, der viser, at de overholder industristandarder for biosikkerhedsscreening, som har til formål at opdage farlige biomolekyler, før de kan fremstilles."

AI's fremskridt inden for medicin og bioteknologi har været helt utrolige og har ført til nye antibiotika og anti-aging medicin.

For at fremme disse resultater forpligter underskriverne sig til at "samarbejde med interessenter fra hele verden" og "afstå fra forskning, der sandsynligvis vil føre til generel skade eller muliggøre misbrug af vores teknologier."