NVIDIA har udgivet Chat with RTX som en teknisk demonstration af, hvordan AI-chatbots kan køre lokalt på Windows-pc'er ved hjælp af RTX GPU'er.

Standardtilgangen til at bruge en AI-chatbot er at bruge en webplatform som ChatGPT eller at køre forespørgsler via en API, hvor inferens finder sted på cloud computing-servere. Ulemperne ved dette er omkostninger, ventetid og bekymringer om privatlivets fred, når personlige data eller virksomhedsdata overføres frem og tilbage.

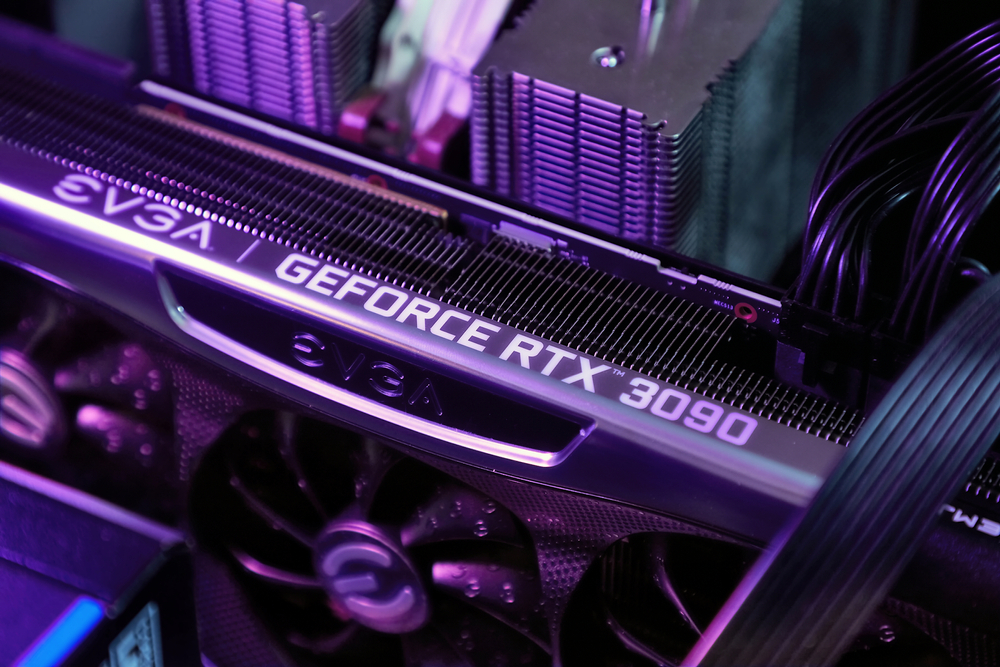

NVIDIA's RTX serie af GPU'er gør det nu muligt at køre en LLM lokalt på din Windows-pc, selv om du ikke har forbindelse til internettet.

Chat med RTX giver brugerne mulighed for at skabe en personlig chatbot ved hjælp af enten Mistral eller Lama 2. Den bruger RAG (retrieval-augmented generation) og NVIDIA's inferensoptimerende TensorRT-LLM-software.

Du kan sende Chat with RTX direkte til en mappe på din pc og derefter stille den spørgsmål om filerne i mappen. Den understøtter forskellige filformater, herunder .txt, .pdf, .doc/.docx og .xml.

Fordi LLM analyserer lokalt lagrede filer med udledning, der sker på din maskine, er det virkelig hurtigt, og ingen af dine data deles på potentielt usikre netværk.

Du kan også give den en URL til en YouTube-video og stille den spørgsmål om videoen. Det kræver internetadgang, men det er en god måde at få svar på uden at skulle se en lang video.

Du kan download Chat med RTX gratis, men du skal køre Windows 10 eller 11 på din pc med en GeForce RTX 30 Series GPU eller højere med mindst 8 GB VRAM.

Chat med RTX er en demo og ikke et færdigt produkt. Den er lidt buggy og husker ikke konteksten, så du kan ikke stille den opfølgende spørgsmål. Men det er et godt eksempel på den måde, vi vil bruge LLM'er på i fremtiden.

At bruge en AI-chatbot lokalt uden omkostninger til API-opkald og med meget lidt ventetid er sandsynligvis den måde, de fleste brugere i sidste ende vil interagere med LLM'er på. Den open source-tilgang, som virksomheder som Meta har taget, vil se AI på enheden drive vedtagelsen af deres gratis modeller i stedet for proprietære modeller som GPT.

Når det er sagt, må mobil- og laptopbrugere vente et stykke tid endnu, før computerkraften i en RTX GPU kan passe ind i mindre enheder.