I en ikke så fjern fortid var samtaler om kunstig intelligens primært begrænset til science fiction og akademiske artikler.

Spol frem til i dag, og AI er dybt integreret i dagligdagen, lige fra at drive intelligente hjem til at diagnosticere sygdomme.

Men mens AI-teknologien stormer frem, halter de lovgivningsmæssige rammer ofte bagefter innovationskurven.

Det stiller menneskeheden over for et mangefacetteret puslespil - hvordan laver vi love og regler, der er smidige nok til at tilpasse sig hurtige teknologiske forandringer og samtidig robuste nok til at beskytte samfundets interesser?

Overalt i verden er den lovgivningsmæssige indsats langt fra ensartet. Den Europæiske Union (EU) sætter scenen med sin omfattende AI-lov, som har til formål at kategorisere og kontrollere AI-applikationer baseret på deres risikoniveau.

I mellemtiden har USA foretrukket frivillige forpligtelser frem for øjeblikkelig lovgivning.

Kina har på den anden side et fast greb om AI og tilpasser reguleringen til bredere politiske og sociale styringsmål.

Og lad os ikke glemme andre jurisdiktioner - AI er et globalt fænomen, der vil kræve næsten universel lovgivning. dækning.

Så hvor er reguleringen nu, og hvordan forventes den at udvikle sig?

EU's tilgang

EU har vedtaget en streng ramme med sin banebrydende AI Act, som forventes at blive fuldt ud godkendt inden årets udgang.

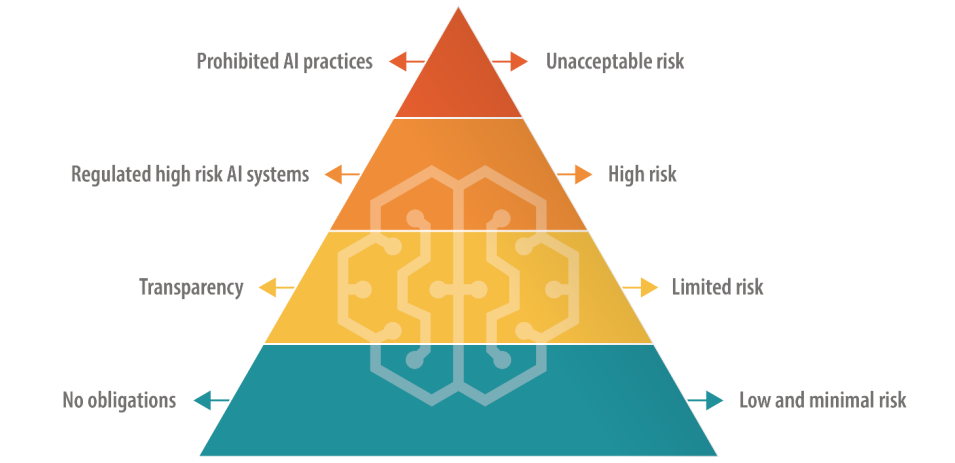

AI-loven specificerer fire niveauer, herunder "uacceptabel risiko-AI", "højrisiko-AI", "begrænset risiko-AI" og "lavrisiko-AI", hver med et specifikt sæt retningslinjer og forbud.

AI'er med uacceptabel risiko udgør en umiddelbar eller betydelig fare, som f.eks. at forårsage fysisk eller psykisk skade eller krænke menneskerettighederne - og de vil blive direkte forbudt.

AI med høj risiko er tilladt, men underlagt strenge regler fra risikostyring til teknisk dokumentation og cybersikkerhed.

AI'er med begrænset og lav risiko er på den anden side stadig overvejende uregulerede, men skal opretholde gennemsigtighed over for brugerne.

Der er en udvej på kort sigt, da lovgivningen indeholder en frist på ca. to år for virksomheder til at tilpasse sig de nye regler.

EU foreslår, at de oprindelige skabere af AI-modeller skal være ansvarlige for, hvordan deres teknologi bruges, selv når den er indlejret i et andet system af en anden virksomhed eller udvikler. Der er også tilføjet nye regler for "grundmodeller", som omfatter generative AI-modeller.

Modtagelsen af AI-loven varierer - nogle kritiserer dens klodsede definitioner og potentiale til at hæmme innovation. For eksempel er der stor usikkerhed om, hvordan forskellige AI-modeller sorteres i risikokategorier.

Derudover er mindre AI-virksomheder bekymrede for, at de mangler ressourcer til at overholde reglerne.

OpenAI's administrerende direktør Sam Altman kortvarigt truet at trække sin virksomheds produkter ud af EU-markedet, hvis AI-loven indeholder krav, som det ikke er realistisk at overholde.

I juni blev 150 store virksomheder fremhævede lovens hårdhændede tilgangog sagde, at de nuværende regler risikerer at ødelægge den europæiske konkurrenceevne.

Afvigelse fra USA

A Stanford-analyse af AI-loven diskuterede grundlæggende forskelle mellem EU's og USA's tilgang til AI-regulering.

Alex Engler, der er fellow i Governance Studies ved The Brookings Institution, sagde: "Der er en voksende forskel mellem USA's og EU's tilgang [til regulering af AI]."

Han fremhæver, at EU har presset på for at få love om databeskyttelse og gennemsigtighed, som stort set ikke findes i USA. Forskellene gør det svært for AI-virksomheder at overholde reglerne, og omkostningerne i forbindelse med overholdelse af reglerne på tværs af jurisdiktioner kan være altoverskyggende.

"Virksomhedsinteresser vil kæmpe med næb og kløer, hvis man har to dramatisk forskellige standarder for onlineplatforme," sagde Engler.

Når det kommer til stykket, er det svært at forestille sig, at teknologivirksomheder ikke finder en måde at navigere i AI-loven på, ligesom de har gjort med GDPR og bliver nødt til med den seneste lov om digitale tjenester.

At tale til Tidsskriftet NatureDaniel Leufer, Senior Policy Analyst hos Access Now, afviser AI-industriens indvendinger mod loven som "det sædvanlige praleri".

Den britiske tilgang

Efter Brexit vil Storbritannien udnytte sin uafhængighed af EU til at formulere et mere fleksibelt og sektorspecifikt regelsæt.

I modsætning til AI-loven har den britiske regering til hensigt at regulere anvendelsen af AI snarere end selve den underliggende software.

En "pro-innovation"-holdning

Den britiske regering udgav en hvidbog i marts der skitserer en "pro-innovations"-ramme og inviterer interessenter til at dele deres synspunkter. Men regeringen har endnu ikke udstedt retningslinjer for implementeringen af disse rammer.

I en erklæring hedder det, at "regeringen vil hjælpe Storbritannien med at udnytte de muligheder og fordele, som AI-teknologier giver" - en tilgang, der er blevet kritiseret for ikke at være tilstrækkelig opmærksom på AI-relaterede skader.

Regeringen havde endda planlagt at tilbyde AI-firmaer en ekstremt kontroversiel 'copyright-fritagelse', men Vendte om på den plan i august.

Storbritannien har haft svært ved at tiltrække teknologisk innovation på det seneste og har især mistet Cambridge-chipproducenten Arm, som valgte at børsnotere sine aktier i USA i stedet for i landet. Det giver måske næring til Storbritanniens angst for at genoplive sin svindende teknologisektor.

For at hjælpe med at positionere Storbritannien som fremsynet inden for kunstig intelligens annoncerede premierminister Rishi Sunak en to-dages Topmøde om AI-sikkerhed der finder sted i november.

Især Kina er blevet inviteret til begivenheden - selvom der er spekulationer om, at de vil blive udelukket på grund af Frygt for spionage.

Den amerikanske tilgang

I USA er der fokus på at lade industrien regulere sig selv, i hvert fald indtil videre.

Den amerikanske kongres signalerer en 'vent og se'-tilgang og påbegynder en gennemgang af AI-møder bag lukkede døre og Chuck Schumers AI Insight-fora for at afgøre, hvor netop AI kræver ny regulering.

Tværpolitiske aftaler kan dreje sig om snævert skræddersyet lovgivning, der omhandler privatlivets fred, platformstransparens eller Beskyttelse af børn online.

Derudover har nogle fremhævet, at eksisterende love og regler stadig er relevante for AI.

I juni, Khan sagde"Der er ingen AI-undtagelse fra love, der forbyder diskrimination ... Efterhånden som disse ting bliver mere indlejret i, hvordan daglige beslutninger træffes, tror jeg, at de indbyder til og fortjener en masse kontrol ... Jeg tror, at håndhævere, hvad enten det er på statsligt eller nationalt niveau, vil handle."

Frivillige rammer og stopklodser

Fremtrædende teknologivirksomheder som Microsoft, OpenAI, Google, Amazon og Meta for nylig underskrevet frivillige forpligtelser for sikker AI-udvikling, herunder gennemførelse af interne og eksterne AI-modeltest før offentlig udgivelse.

Mange ledere i tech-branchen er kommet med deres egne løfter, men i I mangel af et solidt lovgivningsmæssigt tilsyn er oprigtigheden af disse løfter endnu ikke blevet testet.

Alt i alt hævder kritikerne, at USA's tilgang hovedsageligt er symbolsk og ikke har samme dybde og engagement som EU's AI Act. Den første AI-indsigtsforum var et stort set lukket arrangement, som nogle kritiserede for at begrænse den åbne debat.

Senator Josh Hawley sagde, at begivenheden var et "gigantisk cocktailparty".

Som Ryan Calo, professor ved University of Washington School of Law, rammende opsummerede: "Det ser ud til, at der er aktivitet, men der er ikke noget substantielt og bindende."

Den kinesiske tilgang

I forhold til sin appetit på statskontrol indfører Kina nogle af de strengeste regler for AI.

Der lægges vægt på at kontrollere AI's formidling af information, hvilket afspejler Kinas bredere politiske og sociale styringsrammer.

For eksempel er udbydere af generativ AI, hvis produkter kan "påvirke den offentlige mening", forpligtet til at underkaste sig sikkerhedsvurderinger.

Den første bølge af godkendte chatbots, herunder Baidus ERNIE Bot, blev for nylig godkendt. frigivet til offentligheden og fundet at censurere spørgsmål med politisk tema.

Stigningen i 'deep fakes' og AI-genereret indhold giver udfordringer i hele verden, og Kina er ingen undtagelse. Cyberspace Administration of China (CAC) erkendte de potentielle faldgruber ved AI relativt tidligt på året og kræver, at AI-drevne indholdsgeneratorer skal gennemgå identitetsbekræftelsesprocesser for brugere.

Desuden er der indført bestemmelser om vandmærkning for at skelne mellem AI-genereret indhold og menneskeskabt indhold, regler, som vestlige magter også forsøger at implementere.

Forskelle mellem USA og Kina

AI har fremskyndet gnidningerne mellem USA og Kina og udløst det, som mange har kaldt en "digital kold krig" - eller måske mere passende en "AI-kold krig".

USA's restriktioner på samarbejde og handel med Kina er ikke noget nyt, men afkoblingen mellem de to lande tog et skridt fremad, da Xi Jinping annoncerede sin nye, reformerede Made in China 2025-plan.

Målet er at gøre Kina 70% selvforsynende inden for vigtige teknologisektorer i 2025, herunder avanceret AI-teknologi.

I øjeblikket er USA Afbrydelse af finansiering og forskning bånd til Kina, mens de underkaster sig deres indkøb af AI-chips fra virksomheder som Nvidia.

Mens USA har et klart forspring i kapløbet om AI-dominans, har Kina et par tricks i ærmet, herunder en centraliseret tilgang til regulering og næsten ubegrænsede persondata.

I maj blev Edith Yeung, en partner i investeringsfirmaet Race Capital, fortalte BBC"Kina har meget færre regler omkring privatlivets fred og meget mere data [sammenlignet med USA]. Der er for eksempel CCTV-ansigtsgenkendelse overalt."

Kinas tæt forbundne regering og tech-industri giver også fordele, da datadeling mellem regeringen og indenlandske tech-firmaer er næsten problemfri.

USA og andre vestlige jurisdiktioner har ikke samme adgang til forretnings- og persondata, som er livsnerven i maskinlæringsmodeller. Faktisk er der allerede bekymring for, at data af høj kvalitet Datakilderne er ved at løbe tør.'

Desuden har vestlige AI-virksomheders liberale brug af potentielt ophavsretligt beskyttede træningsdata skabt udbredt opstandelse og retssager.

Kinas AI-virksomheder vil sandsynligvis ikke lide under det problem.

Balance mellem tilgængelighed og risiko

AI var engang forbeholdt den akademiske verden og store virksomheder. Inden for et år eller deromkring har mellem en fjerdedel og halvdelen af de voksne i Storbritannien, USA og EU brugt generativ AI.

Tilgængelighed har mange fordele, herunder at anspore til innovation og reducere adgangsbarrierer for nystartede virksomheder og individuelle udviklere. Men det giver også anledning til bekymring over det potentielle misbrug, der følger med ureguleret adgang.

Den seneste hændelse, hvor Metas Llama-1-sprogmodel blev lækket på internettet eksemplificerer udfordringerne ved at inddæmme AI-teknologi. Open source AI-modeller er allerede blevet brugt til svigagtige formål og til at generere billeder af børnemishandling.

AI-virksomheder ved detteog open source-modeller truer deres konkurrencefordel. Meta har udviklet sig til lidt af en antagonist i branchen og frigiver en række modeller gratis, mens andre, som Microsoft, OpenAI og Google, kæmper for at tjene penge på deres AI-produkter.

Andre open source-modeller, som f.eks. Falcon 180B LLMer usædvanligt kraftfulde, men mangler gelændere.

Nogle spekulerer i, at store AI-virksomheder presser på for regulering, fordi det tvinger mindre spillere og open source-samfundet ud af ringen, så de kan bevare deres dominans over branchen.

AI's dobbelte anvendelsesmuligheder

En anden kompleks faktor er AI's dobbelte eller multiple anvendelser.

De samme algoritmer, som kan forbedre vores livskvalitet, kan også bruges som våben eller i militære sammenhænge. Dette kan være akilleshælen i EU AI Act's heuristiske ramme - hvordan fortolker man nyttige AI'er, der kan ændres for at gøre skade?

Regulering af teknologi med dobbelt anvendelse er notorisk kompleks. Implementering af streng kontrol kan kvæle innovation og økonomisk vækst, når kun et lille mindretal misbruger en AI-teknologi.

AI-virksomheder kan omgå skylden ved at skabe politikker mod misbrug, men det forhindrer ikke folk i at bruge 'jailbreaks'' for at narre modeller til at udsende ulovligt materiale.

Afbalancering af AI's økonomiske fordele og etiske bekymringer

Fordelene ved AI er økonomisk overbevisende, især inden for sektorer som sundhed, energi og produktion.

Rapporter af McKinsey og PwC forudser, at AI vil bidrage med billioner til den globale økonomi hvert år, uanset virkningen af jobudskiftninger og afskedigelser.

AI kan ses som en vej til jobskabelse og vækst for lande, der kæmper med økonomiske problemer.

På et bredere filosofisk plan fremstilles AI nogle gange som menneskehedens redningsmand midt i makroproblemer som fattigdom, klimaforandringer og aldrende befolkninger.

Vestlige regeringer - især USA og Storbritannien - synes at være tilbøjelige til at fremme væksten gennem skatteincitamenter, finansiering af AI-forskning og en laissez-faire-tilgang til lovgivningen.

Det er et sats, som USA tidligere har gjort ved at lade tech-industrien regulere sig selv, men kan det blive ved med at betale sig?

WEr det ikke dommedagsprofetier, der sammenligner kunstig intelligens med "atomkrig" og "globale pandemier", der sætter en stopper for romantiske forestillinger om teknologiens potentiale til at løfte menneskeheden ud af stadig større globale problemer?

AI har en vis dobbelthed, som fremkalder både eutopiske og dystopiske fremtidsvisioner, alt efter hvem man lytter til.

Reguleringen af en sådan enhed er en hidtil uset udfordring.

Under alle omstændigheder vil vi ved udgangen af 2024 sandsynligvis leve i en verden, hvor AI er næsten universelt reguleret, men hvad ingen kan svare på er, hvor meget branchen... - og selve teknologien - vil have udviklet sig til den tid.