AI-virksomheder presser på for regulering. Er deres motivation paranoia eller altruisme? Eller sikrer regulering konkurrencemæssige mål?

I begyndelsen af maj skrev Luke Sernau, en ledende softwareingeniør hos Google, et uformelt memo om open source AI. Det blev udbredt på Googles interne systemer, før et konsulentfirma, Semi-Analysis, verificeret og offentliggjort det.

Her er nogle uddrag:

"Vi har kigget os meget over skulderen hos OpenAI. Hvem passerer den næste milepæl? Hvad bliver det næste træk?

Men den ubehagelige sandhed er, at vi ikke er i stand til at vinde dette våbenkapløb, og det er OpenAI heller ikke. Mens vi har skændtes, har en tredje fraktion stille og roligt spist vores frokost. Jeg taler selvfølgelig om open source.

Kort sagt, de overhaler os. Ting, vi betragter som "store åbne problemer", er løst og i folks hænder i dag. Selv om vores modeller stadig har en lille fordel, når det gælder kvalitet, lukkes hullet forbavsende hurtigt.

Open source-modeller er hurtigere, kan tilpasses mere, er mere private og er mere effektive. De gør ting med $100 og 13B params, som vi kæmper med på $10M og 540B. Og de gør det på uger, ikke måneder.

I begyndelsen af marts fik open source-samfundet fingrene i deres første virkelig dygtige foundation-model, da Metas LLaMA blev lækket til offentligheden.

Den havde ingen instruktion eller samtaleindstilling og ingen RLHF. Ikke desto mindre forstod samfundet straks betydningen af det, de havde fået. En enorm strøm af innovation fulgte, med kun få dages mellemrum mellem større udviklinger...

Her er vi, knap en måned senere, og der er varianter med instruktionstuning, kvantisering, kvalitetsforbedringer, menneskelige evalueringer, multimodalitet, RLHF osv. osv. Vigtigst af alt har de løst skaleringsproblemet i en sådan grad, at alle kan være med.

Mange af de nye ideer kommer fra almindelige mennesker. Adgangsbarrieren for uddannelse og eksperimenter er faldet fra den samlede produktion fra en stor forskningsorganisation til en person, en aften og en stor bærbar computer."

Sernaus memo blev taget op af store nyhedsbureauer og udløste en debat om, hvorvidt big tech's pres for regulering dækker over et motiv om at tvinge open source AI ud af spillet. Ben Schrekcinger fra Politico skriver"Open source-kode er også sværere at forbyde, da nye instanser kan dukke op, hvis myndighederne forsøger at lukke en hjemmeside eller et værktøj, der bruger den. Kombineret med andre decentraliserende funktioner har disse open source-projekter potentiale til at forstyrre ikke bare Silicon Valleys forretningsmodel, men også styringsmodellerne i Washington og Bruxelles."

Open source AI-fællesskabet trives allerede i bedste velgående. Udviklere løser udfordringer på få dage, som tager Google og OpenAI måneder eller år. Sernau hævder, at smidige fællesskaber af open source-udviklere er bedre rustet til at bygge iterative modeller end big tech, da de er mere forskelligartede, effektive og pragmatiske.

Hvis det er tilfældet, kan big tech's dominans over AI være kortvarig.

Meta LLaMA-lækagen

Metas LLaMA-model, en stor sprogmodel (LLM) ligesom ChatGPT, var lækket på 4chan en uge efter, at virksomheden sendte anmodninger om adgang. Den 3. marts dukkede en torrent, der kunne downloades, op på messaging-forummet og spredte sig som en steppebrand.

Som Sernau siger, fortsatte open source-fællesskabet med at modificere LLaMA og tilføjede imponerende funktionalitet uden virksomhedens computerressourcer.

Det er billigere end nogensinde at bygge kraftfulde AI-modeller, og open source-fællesskaber presser på for at demokratisere adgangen. Mens LLaMA stort set er en forudtrænet model, er andre open source-modeller som BLOOM blevet trænet af frivillige.

Træning af BLOOM krævede en supercomputer udstyret med 384 NVIDIA A100 80GB GPU'er, som heldigvis blev doneret af den franske regering. Open source AI-virksomheden Together annoncerede for nylig $20m seed funding, og AI-fokuserede cloud-udbydere som CoreWeave tilbyde hardware til priser under markedet.

Open source-projekter har forskellige muligheder for at fokusere ressourcer og udkonkurrere big tech. Big tech vil sikkert gerne have os til at tro, at deres AI'er er produktet af årtiers arbejde og milliarder af dollars i investeringer - Open source-samfundet er nok ikke enig.

Ved en begivenhed i Indien spurgte den tidligere Google-direktør Rajan Anandan OpenAI's CEO Sam Altman, om indiske ingeniører kunne bygge grundlæggende AI-modeller med en investering på $10 millioner.

Altman svarede: "Det er helt håbløst at konkurrere med os om at træne grundmodeller. Du skal ikke prøve, og det er dit job at kunne lide at prøve alligevel. Og jeg tror på begge dele. Jeg synes, det er ret håbløst."

Men i sit memo udtrykker Sernau, at open source allerede konkurrerer med big tech. Han siger: "Det bliver endnu sværere at fastholde en konkurrencemæssig fordel inden for teknologi, nu hvor banebrydende forskning i LLM'er er overkommelig. Forskningsinstitutioner over hele verden bygger videre på hinandens arbejde og udforsker løsningsrummet på en måde, der langt overgår vores egen kapacitet."

Open source-udviklere bygger alternativer til big tech's AI'er og overhaler dem i performance og brugerstatistik.

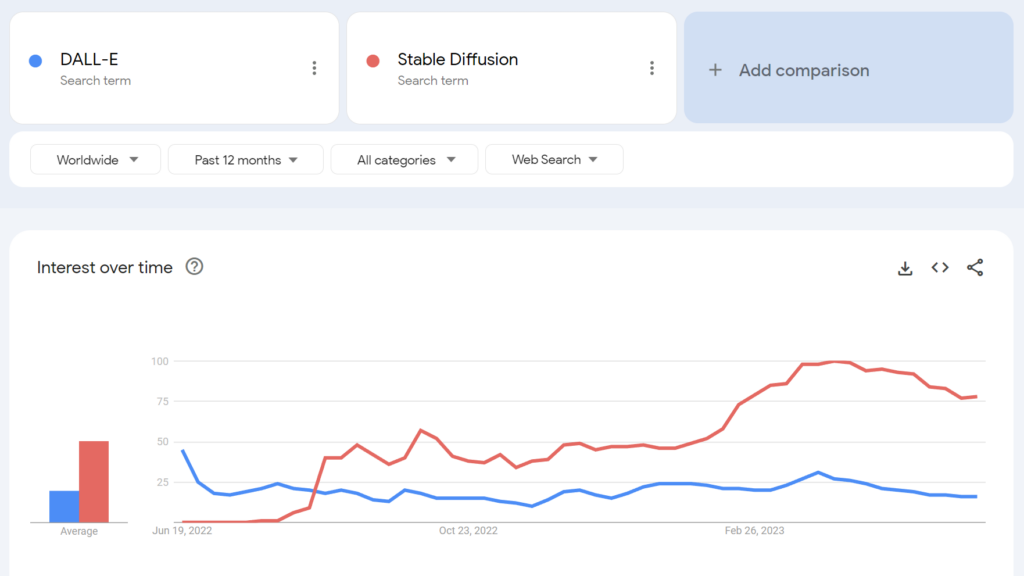

For eksempel blev open-source Stable Diffusion mere populær end OpenAI's DALL-E i løbet af få måneder efter lanceringen.

I hvor høj grad kan vi udrede potentielle bagtanker her? Har big tech's regulatoriske fremstød nogen altruistisk værdi?

Open source AI-fællesskabet

Ud over LLaMA er der mindst tre større eksempler på open source AI-projekter:

- Kramende ansigt & BLOOM - AI-firmaet Hugging Face samarbejdede med over 1.000 frivillige forskere om at udvikle BLOOM, en open source LLM. BLOOM har til formål at tilbyde et mere gennemsigtigt og tilgængeligt modstykke til proprietære AI-modeller.

- Sammen - En AI-startup ved navn Together har med succes rejst $20 millioner i seed funding for at støtte sit mål om at opbygge decentrale alternativer til lukkede AI-systemer. De afslørede flere open source-generative AI-initiativer, herunder GPT-JT, OpenChatKit og RedPajama.

- Stabilitet AI - I april 2023 lancerede Stability AI, virksomheden bag Stable Diffusion, StableLM, en række open source-alternativer til ChatGPT.

Det er værd at bemærke, at mens nogle af disse udviklere (f.eks. Stable Diffusion) tilbyder deres modeller via intuitive, brugervenlige dashboards, kræver andre, såsom BLOOM, betydelige ressourcer for at køre. Til at begynde med skal du bruge omkring 360 GB RAM for at køre BLOOM, men der er mange smarte tricks til at få ressourcekravene ned.

Efterhånden som AI-kompatibel hardware falder i pris, og open source-modeller bliver enklere at implementere, er det meget muligt, at stort set alle kan implementere modeller, der ligner ChatGPT. Googles memo-lækage nævner eksempler på folk, der har tunet og implementeret LLaMA på forbrugerenheder, herunder en MacBook.

For virksomheder med betydelige IT-ressourcer, Open source-modeller sparer penge og giver datasuverænitet og kontrol over træning og optimering.

Det er dog ikke alle, der er optimistiske med hensyn til virkningen af kraftfuld open source AI. For eksempel tweetede cybersikkerhedsforskeren Jeffrey Ladis: "Gør dig klar til masser af personlig spam og phishing-forsøg," og "Open sourcing af disse modeller var en forfærdelig idé."

Spredning af AI gør os alle mindre sikre. Det virker som en god ting at forhindre, og også som en ret vanskelig udfordring!

Jeg ville ikke blive så overrasket, hvis det lykkedes en statslig aktør at få fat i OpenAI's frontier-modeller i løbet af det næste år eller to. https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10. maj 2023

En anden observatør tweetede: "Open source er en trussel, men ikke på den måde, du tror. Det er en trussel, fordi AI i hænderne på folk, der kan bruge det til deres egne formål, bliver endnu sværere at regulere eller holde styr på, og det er et større problem."

Google og OpenAI hævder, at de er bange for open source AI, der er "ingen voldgrav" mellem dem alle. Men det er ikke helt sandt.

Open source er en trussel, men ikke på den måde, du tror. Det er en trussel, fordi AI i hænderne på folk, der kan bruge det til deres egne formål, bliver endnu sværere at... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5. maj 2023

Yann LeCun, der ofte betragtes som en "AI-gudfader" sammen med Geoffrey Hinton og Yoshio Bengman, hævder det modsatte"Når LLM'er bliver den vigtigste kanal, hvorigennem alle får adgang til information, vil folk (og regeringer) *kræve*, at den er åben og gennemsigtig. Grundlæggende infrastruktur skal være åben."

LeCun var også uenig i de almindelige fortællinger om AI-risici: "Jeg synes, at omfanget af AI-tilpasningsproblemet er blevet latterligt overdrevet, og vores evne til at løse det er blevet stærkt undervurderet." Elon Musk slog tilbage i Twitter-tråden og sagde: "Tror du virkelig, at AI er et enægget sværd?"

Tror du virkelig, at AI er et enægget sværd?

- Elon Musk (@elonmusk) 1. april 2023

Andre kommentatorer trak paralleller mellem AI-regulering og kryptografi, hvor den amerikanske regering forsøgte at forbyde offentlige kryptografiske metoder ved at at klassificere dem som "ammunition" - kaldet "Kryptokrigen".

Nu har stort set alle ret til at bruge kryptering - men den kamp var svær at vinde - ligesom det kan være tilfældet med open source AI.

OpenAI's fremmedgørelse af open source AI

Open source er mere end bare software, kode og teknologi. Det er princippet, tankegangen eller troen på, at et kooperativt, åbent og gennemsigtigt arbejdsmiljø overgår konkurrencen på et lukket marked.

OpenAI, der engang var en non-profit virksomhed med fokus på offentligt samarbejde og open source-udvikling, har støt og roligt fjernet sig fra sit navn.

Startup-virksomheden overgik til en "for-profit"-virksomhed i 2019, hvilket effektivt afsluttede virksomhedens forhold til open source-fællesskabet. Investeringen fra Microsoft afkoblede OpenAI fra enhver form for "åben" F&U-aktivitet.

I midten af maj annoncerede virksomheden en open source-model i støbeskeenmen de har ikke været ærlige med detaljerne.

Nu presser OpenAI på for en regulering, der vil ramme nye AI-virksomheder hårdest, for ikke at nævne en potentiel kriminalisering af open source-fællesskabet.

Det har fået nogle til at kritisere OpenAI's pres for regulering som ren forretning - en forretning, der handler om at beskytte deres profitable modeller mod open source-fællesskaber, der ønsker at demokratisere AI.

Er open source AI en risiko for big tech?

Kombinationen af Googles lækkede memo, big tech's pres for regulering og Altmans nedgørelse af AI-projekter på græsrodsniveau får nogle til at løfte øjenbrynene. Der er faktisk blevet sat spørgsmålstegn ved legitimiteten af AI's risici - som retfærdiggør regulering.

Da Center for AI Safety (CAIS) for eksempel offentliggjorde sin seismiske erklæring om AI-risiko, der var underskrevet af flere AI-chefer, var der nogle eksterne observatører, der ikke var overbeviste.

I et udvalg af ekspertreaktioner på erklæringen udgivet af Science Media CentreDr. Mhairi Aitken, Ethics Research Fellow ved Alan Turing Institute, sagde:

"På det seneste er disse påstande i stigende grad kommet fra store tech-aktører, primært i Silicon Valley. Nogle mener, at det skyldes, at de er opmærksomme på de teknologiske fremskridt, men jeg tror faktisk, at det fungerer som en afledningsmanøvre. Det afleder opmærksomheden fra de beslutninger, der træffes af big tech (mennesker og organisationer), som udvikler AI og driver innovation på dette område, og fokuserer i stedet på hypotetiske fremtidsscenarier og forestillede fremtidige kapaciteter for AI."

Nogle hævder, at big tech har den fornødne ildkraft til at afsætte ressourcer til etik, ledelse og overvågning, så de kan ryste den værste regulering af sig og fortsætte med at sælge deres produkter.

Men det er samtidig problematisk at fordømme AI-risici som fantasi og hævde, at der ikke er nogen værdi i regulering.

Der er skeptikere i begge lejre

At afvise AI-risici som rent spekulative kan vise sig at være en kritisk fejl for menneskeheden.

Faktisk har kommentatorer uden interessekonflikt advaret om AI i årtier, herunder den afdøde professor Stephen Hawking, som sagde, at AI "kunne betyde enden på den menneskelige race" og være den "værste begivenhed i vores civilisations historie".

Nogle vil måske hævde, at big tech bruger visioner om en AI-apokalypse til at styrke markedsstrukturer og hæve adgangsbarrierer, men det overskygger ikke legitimiteten af AI-risici.

For eksempel har AI-forskningshold allerede bevist AI's evne til selvstændigt at opstille nye mål med potentielt katastrofale konsekvenser.

Andre eksperimenter viser, at AI'er aktivt kan indsamle ressourcer, akkumulere kraft og tage proaktive skridt for at forhindre sig selv i at blive "slukket". Troværdige undersøgelser tyder på, at i det mindste nogle AI-risici ikke er alt for overdrevne.

Kompatible synspunkter?

Spørgsmålet er, om vi kan stole på os selv med usædvanlig kraftfuld AI? "Os selv" er mennesker overalt, på alle niveauer, fra store teknologiske forskningslaboratorier til de fællesskaber, der bygger open source AI.

Big tech ønsker måske at konsolidere markedsstrukturerne og samtidig skabe ægte bekymring for AI's fremtid. De to ting udelukker ikke nødvendigvis hinanden.

I mellemtiden er stigningen i open source AI uundgåelig, og regulering risikerer at skabe utilfredshed blandt et samfund, der ejer en af menneskehedens farligste teknologier.

Det er allerede for sent at underlægge sig open source AI gennem regulering, og hvis man forsøger at gøre det, kan det føre til en destruktiv æra med AI-forbud.

Samtidig bør diskussioner om AI's farer være drevet af evidens - det eneste objektive signal, vi har om teknologiens potentiale for skade.