För inte så länge sedan var samtal om AI främst förpassade till science fiction och akademiska artiklar.

I dag är AI djupt integrerat i det dagliga livet, från att driva smarta hem till att diagnostisera sjukdomar.

Men i takt med att AI-tekniken går framåt måste regelverken komma ikapp och släpar ofta efter innovationskurvan.

Detta ställer mänskligheten inför ett mångfacetterat pussel - hur skapar vi lagar och regler som är tillräckligt smidiga för att anpassa sig till snabba tekniska förändringar och samtidigt tillräckligt robusta för att skydda samhällets intressen?

Över hela världen är regleringsinsatserna långt ifrån enhetliga. Europeiska unionen (EU) visar vägen med sin omfattande AI Act, som syftar till att kategorisera och kontrollera AI-applikationer baserat på deras risknivå.

Samtidigt har USA föredragit frivilliga åtaganden framför omedelbar lagstiftning.

Kina, å andra sidan, har ett fast grepp om AI och anpassar regleringen till bredare politiska och sociala mål.

Och låt oss inte glömma andra jurisdiktioner - AI är ett globalt fenomen som kommer att kräva nästan universell lagstiftning täckning.

Så var befinner sig regleringen nu, och hur förväntas den utvecklas?

EU:s strategi

EU har antagit ett strikt ramverk med sin banbrytande AI Act, som förväntas bli helt godkänd i slutet av året.

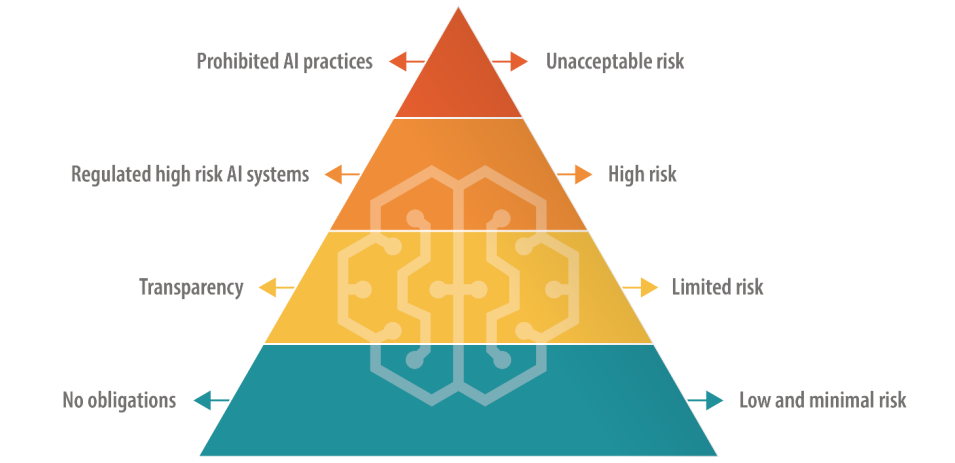

AI-lagen anger fyra nivåer, inklusive "AI med oacceptabel risk", "AI med hög risk", "AI med begränsad risk" och "AI med låg risk", var och en med en specifik uppsättning riktlinjer och förbud.

Oacceptabel risk AI:er utgör omedelbara eller betydande faror, som att orsaka fysisk eller psykisk skada eller kränka mänskliga rättigheter - och dessa kommer att förbjudas helt och hållet.

AI med hög risk tillåts, men omfattas av strikta regler från riskhantering till teknisk dokumentation och cybersäkerhet.

AI med begränsad omfattning och låg risk är däremot fortfarande i huvudsak oreglerade, men de är skyldiga att vara transparenta gentemot användarna.

Det finns ett undantag på kort sikt, eftersom lagstiftningen innehåller en frist på cirka två år för företag att anpassa sig till de nya bestämmelserna.

EU föreslår att de ursprungliga skaparna av AI-modellerna ska vara ansvariga för hur deras teknik används, även om den byggs in i ett annat system av ett annat företag eller en annan utvecklare. Det finns också nytillkomna regler för "foundation models", vilket inkluderar generativa AI-modeller.

Mottagandet av AI-lagen varierar - vissa kritiserar dess klumpiga definitioner och potential att hämma innovation. Det råder till exempel stor osäkerhet om hur olika AI-modeller ska sorteras in i riskkategorier.

Dessutom är mindre AI-företag oroliga för att de saknar resurser att ägna åt efterlevnad.

OpenAI:s VD Sam Altman kortvarigt hotad att dra tillbaka sitt företags produkter från EU-marknaden om AI-lagen innehåller krav som inte kan uppfyllas på ett realistiskt sätt.

I juni fick 150 stora företag framhävde lagens hårdhänta tillvägagångssätt, där det konstaterades att de nuvarande reglerna riskerar att förstöra den europeiska konkurrenskraften.

Avvikelse från USA

A Stanford-analys av AI-lagen diskuterades grundläggande skillnader mellan EU:s och USA:s syn på reglering av AI.

Alex Engler, forskare i Governance Studies vid Brookings Institution, sade: "Det finns en växande skillnad mellan USA:s och EU:s inställning [till reglering av AI]."

Han framhåller att EU har drivit på för att få till stånd lagar om dataskydd och transparens, något som i stort sett saknas i USA. Skillnaderna försvårar efterlevnaden för AI-företag, och de kostnader som är förknippade med efterlevnad i olika jurisdiktioner kan bli övermäktiga.

"Företagsintressen kommer att kämpa med näbbar och klor om du har två dramatiskt olika standarder för onlineplattformar", säger Engler.

När allt kommer omkring är det svårt att tänka sig att teknikföretagen inte hittar ett sätt att navigera i AI-lagen på samma sätt som de har gjort med GDPR och kommer att behöva göra med den nya lagen om digitala tjänster.

Talar till tidskriften NatureDaniel Leufer, Senior Policy Analyst på Access Now, avfärdar AI-industrins invändningar mot lagen som "det vanliga skrytbygget".

Den brittiska strategin

Efter Brexit vill Storbritannien dra nytta av sitt oberoende från EU för att utforma ett mer flexibelt och sektorspecifikt regelverk.

Till skillnad från AI Act avser den brittiska regeringen att reglera tillämpningarna av AI snarare än den underliggande mjukvaran i sig.

En "pro-innovation" hållning

Den brittiska regeringen publicerade en vitbok i mars där man skisserar ett ramverk för "pro-innovation" och bjuder in intressenter att dela med sig av sina synpunkter. Regeringen har dock ännu inte utfärdat några riktlinjer för hur detta ramverk ska implementeras.

I ett uttalande sägs att "regeringen kommer att hjälpa Storbritannien att utnyttja de möjligheter och fördelar som AI-teknik innebär" - ett tillvägagångssätt som kritiserats för att inte ägna rättvis uppmärksamhet åt AI-relaterade skador.

Regeringen hade till och med planerat att erbjuda AI-företag ett extremt kontroversiellt "upphovsrättsundantag", men U-sväng på den planen i augusti.

Storbritannien har haft svårt att locka till sig tekniska innovationer på senare tid och har bland annat förlorat chiptillverkaren Arm i Cambridge, som valde att börsnotera sina aktier i USA istället för i Storbritannien. Detta kanske spär på Storbritanniens oro för att åter få fart på sin krympande tekniksektor.

För att hjälpa till att positionera Storbritannien som framåtblickande inom AI tillkännagav premiärminister Rishi Sunak ett tvådagars Toppmöte om AI-säkerhet som äger rum i november.

Framför allt har Kina bjudits in till evenemanget - även om det spekuleras i att de kommer att uteslutas över Spionage rädsla.

Den amerikanska strategin

I USA ligger fokus på att låta branschen självreglera sig, åtminstone för tillfället.

Den amerikanska kongressen signalerar en "vänta och se"-strategi och påbörjar en granskning av AI-möten bakom stängda dörrar och Chuck Schumers AI Insight Forum för att avgöra var just AI kräver ny reglering.

Överenskommelser över partigränserna kan kretsa kring snävt skräddarsydd lagstiftning som behandlar integritet, plattformstransparens eller skydda barn på nätet.

Dessutom har vissa framhållit att befintliga lagar och förordningar fortfarande är relevanta för AI.

I juni, Khan sade"Det finns inget AI-undantag från lagar som förbjuder diskriminering ... När dessa saker blir mer inbäddade i hur dagliga beslut fattas, tror jag att de inbjuder och förtjänar mycket granskning ... Jag tror att verkställare, vare sig det är på statlig nivå eller nationell nivå, kommer att agera."

Frivilliga ramverk och stoppklossar

Framstående teknikföretag som Microsoft, OpenAI, Google, Amazon och Meta har nyligen undertecknat frivilliga åtaganden för säker AI-utveckling, bland annat genom att genomföra interna och externa tester av AI-modeller innan de släpps för allmänheten.

Många ledare inom teknikindustrin har kommit fram med sina egna löften, men i I avsaknad av en robust lagstiftande tillsyn återstår det att pröva om dessa löften är uppriktiga.

Sammantaget hävdar kritikerna att USA:s strategi i huvudsak är symbolisk och saknar det djup och engagemang som EU:s AI Act har. Den första AI Insight Forum var ett evenemang som till stor del hölls bakom stängda dörrar och som vissa kritiserade för att begränsa den öppna debatten.

Senator Josh Hawley sa att evenemanget var ett "gigantiskt cocktailparty".

Som Ryan Calo, professor vid University of Washington School of Law, träffande sammanfattade det: "Det ser ut att finnas aktivitet, men inget substantiellt och bindande."

Det kinesiska synsättet

Kina har, i proportion till sin aptit på statlig kontroll, infört några av de strängaste reglerna för AI.

Tyngdpunkten ligger på att kontrollera AI:s informationsspridning, vilket återspeglar Kinas bredare politiska och sociala styrningsramar.

Till exempel måste leverantörer av generativ AI vars produkter kan "påverka den allmänna opinionen" genomgå en säkerhetsgranskning.

Den första vågen av godkända chatbottar, inklusive Baidus ERNIE Bot, presenterades nyligen släppt till allmänheten och censurerade frågor med politiska teman.

Ökningen av "deep fakes" och AI-genererat innehåll innebär utmaningar över hela världen, och Kina är inget undantag. Cyberspace Administration of China (CAC) insåg de potentiella fallgroparna med AI relativt tidigt under året och kräver att AI-drivna innehållsgeneratorer ska genomgå identitetsverifieringsprocesser för användare.

Dessutom har bestämmelser om vattenstämpling införts för att skilja AI-genererat innehåll från innehåll som skapats av människor, regler som även västmakterna försöker införa.

Skillnader mellan USA och Kina

AI har påskyndat motsättningarna mellan USA och Kina och lett till vad många har kallat ett "digitalt kallt krig" - eller kanske snarare ett "AI-kallt krig".

USA:s restriktioner för samarbete och handel med Kina är inget nytt, men frikopplingen mellan de två länderna tog ett steg framåt när Xi Jinping tillkännagav sin nya, reformerade Planen Made in China 2025.

Detta syftar till att göra Kina 70% självförsörjande inom viktiga tekniksektorer fram till 2025, inklusive avancerad AI-teknik.

För närvarande är USA minska finansiering och forskning med Kina samtidigt som de underordnar sig deras upphandling av AI-chip från företag som Nvidia.

USA har ett klart försprång i kampen om AI-dominans, men Kina har några tricks i rockärmen, bland annat en centraliserad regleringsstrategi och nästan obegränsad tillgång till personuppgifter.

I maj meddelade Edith Yeung, partner i investmentbolaget Race Capital, berättade för BBC, "Kina har mycket färre regler kring integritet och mycket mer data [jämfört med USA]. Det finns till exempel ansiktsigenkänning från CCTV överallt."

Kinas nära samarbete mellan regeringen och teknikindustrin ger också fördelar, eftersom datadelningen mellan regeringen och inhemska teknikföretag är praktiskt taget sömlös.

USA och andra västerländska jurisdiktioner har inte samma tillgång till affärs- och personuppgifter, som är livsnerven i modeller för maskininlärning. Faktum är att det redan finns farhågor om att högkvalitativa datakällorna håller på att "ta slut".'

Dessutom har västerländska AI-företags frikostiga användning av potentiellt upphovsrättsligt skyddade träningsdata orsakat omfattande upprördhet och stämningar.

Kinas AI-företag kommer sannolikt inte att drabbas av det problemet.

Balans mellan tillgänglighet och risk

AI var en gång i tiden förbehållet den akademiska världen och stora företag. Inom loppet av något år har mellan en fjärdedel och hälften av alla vuxna i Storbritannien, USA och EU använt generativ AI.

Tillgänglighet har många fördelar, bland annat att det stimulerar innovation och minskar inträdesbarriärerna för nystartade företag och enskilda utvecklare. Detta väcker dock också farhågor om det potentiella missbruk som följer med oreglerad åtkomst.

Den senaste händelsen där Metas språkmodell Llama-1 läckte ut på internet exemplifierar utmaningarna med att begränsa AI-tekniken. AI-modeller med öppen källkod har redan använts i bedrägliga syften och för att generera bilder av barnmisshandel.

AI-företagen vet dettaoch modeller med öppen källkod hotar deras konkurrensfördelar. Meta har framstått som något av en antagonist i branschen och släppt en serie modeller gratis när andra, som Microsoft, OpenAI och Google, kämpar för att tjäna pengar på sina AI-produkter.

Andra modeller med öppen källkod, som Falcon 180B LLMär exceptionellt kraftfulla samtidigt som de saknar skyddsräcken.

Vissa spekulerar i att de stora AI-företagen driver på för reglering eftersom det tvingar bort mindre aktörer och open source-communityn från arenan, vilket gör det möjligt för dem att behålla sin dominans över branschen.

AI:s gåta med dubbla användningsområden

En annan komplex faktor är AI:s dubbla eller multipla tillämpningar.

Samma algoritmer som kan förbättra vår livskvalitet kan också bli vapen eller användas i militära sammanhang. Detta kan vara akilleshälen i EU:s AI-rättsakts heuristiska ramverk - hur tolkar man användbara AI:er som kan modifieras för att skada?

Att reglera teknik med dubbla användningsområden är notoriskt komplext. Att införa stränga kontroller kan hämma innovation och ekonomisk tillväxt när endast en liten minoritet missbrukar en AI-teknik.

AI-företag kan kringgå skuldfrågan genom att skapa policyer mot missbruk, men det hindrar inte människor från att använda "jailbreaks' för att lura modeller att producera olagligt material.

Balans mellan AI:s ekonomiska fördelar och etiska problem

Fördelarna med AI är ekonomiskt övertygande, särskilt inom sektorer som hälso- och sjukvård, energi och tillverkning.

Rapporter av McKinsey och PwC förutspår att AI kommer att bidra med biljoner till den globala ekonomin varje år, oavsett effekterna av ersättningsjobb och uppsägningar.

AI kan ses som en väg till jobbskapande och tillväxt för länder som kämpar med ekonomiska problem.

På ett bredare filosofiskt plan framställs AI ibland som mänsklighetens räddare i nöden när det gäller frågor på makronivå som fattigdom, klimatförändringar och åldrande befolkningar.

Regeringar i västvärlden - i synnerhet USA och Storbritannien - verkar vara benägna att främja tillväxt genom skatteincitament, finansiering av AI-forskning och en "laissez-faire"-strategi.

Det här är en chansning som USA har gjort tidigare genom att låta teknikindustrin självreglera sig, men kan det fortsätta att löna sig?

WÄr det inte så att domedagsprofetior som jämför AI med "kärnvapenkrig" och "globala pandemier" sätter stopp för den romantiserade synen på teknikens potential att lyfta mänskligheten ur allt svårare globala problem?

AI har en viss dubbelhet som framkallar både eutopiska och dystopiska framtidsvisioner, beroende på vem man lyssnar på.

RAtt reglera en sådan enhet är en utmaning utan motstycke.

I vilket fall som helst kommer vi i slutet av 2024 sannolikt att leva i en värld där AI är nästan universellt reglerad, men vad ingen kan svara på är hur mycket branschen - och tekniken i sig - kommer att ha utvecklats vid det laget.