AI-företagen driver på för reglering. Är deras motivation paranoia eller altruism? Eller säkerställer regleringen konkurrensmål?

I början av maj skrev Luke Sernau, en senior mjukvaruingenjör på Google, ett informellt memo om AI med öppen källkod. Det cirkulerade brett i Googles interna system innan konsultföretaget Semi-Analysis, kontrollerat och publicerat det.

Här är några utdrag:

"Vi har tittat oss mycket över axeln på OpenAI. Vem kommer att passera nästa milstolpe? Vad kommer nästa steg att vara?

Men den obekväma sanningen är att vi inte är positionerade för att vinna den här kapprustningen och inte heller OpenAI. Medan vi har käbblat har en tredje fraktion i tysthet ätit vår lunch. Jag talar naturligtvis om öppen källkod.

Enkelt uttryckt, de springer om oss. Saker som vi betraktar som "stora öppna problem" är lösta och finns i folks händer idag. Även om våra modeller fortfarande har ett litet försprång när det gäller kvalitet, minskar gapet förvånansvärt snabbt.

Modeller med öppen källkod är snabbare, mer anpassningsbara, mer privata och mer kapabla. De gör saker med $100 och 13B params som vi kämpar med på $10M och 540B. Och de gör det på veckor, inte månader.

I början av mars fick open source-gemenskapen tag på sin första riktigt kapabla grundmodell, när Metas LLaMA läckte ut till allmänheten.

Den innehöll inga instruktioner eller konversationstoner och ingen RLHF. Ändå förstod samhället omedelbart betydelsen av vad de hade fått. En enorm ström av innovationer följde, med bara några dagar mellan de stora utvecklingarna...

Här är vi, knappt en månad senare, och det finns varianter med instruktionstuning, kvantifiering, kvalitetsförbättringar, mänskliga utvärderingar, multimodalitet, RLHF, etc., etc., varav många bygger på varandra. Viktigast av allt är att de har löst skalningsproblemet i den utsträckning som alla kan tinker.

Många av de nya idéerna kommer från vanliga människor. Inträdesbarriären för utbildning och experiment har sjunkit från den totala produktionen från en stor forskningsorganisation till en person, en kväll och en stor bärbar dator."

Sernaus memo plockades upp av stora nyhetsbyråer och utlöste debatt om huruvida big tech's press för reglering maskerar ett motiv för att tvinga AI med öppen källkod ur spelet. Ben Schrekcinger från Politico skriver, "öppen källkod är också svårare att förbjuda eftersom nya instanser kan dyka upp om tillsynsmyndigheter försöker stänga ner en webbplats eller ett verktyg som använder den. I kombination med andra decentraliserande funktioner har dessa projekt med öppen källkod potential att störa inte bara Silicon Valleys affärsmodell, utan även styrmodellerna i Washington och Bryssel."

AI-communityn med öppen källkod är redan blomstrande. Utvecklare löser utmaningar på några dagar som tar Google och OpenAI månader eller år. Sernau menar att agila grupper av open source-utvecklare är bättre rustade för att bygga iterativa modeller än big tech, eftersom de är mer mångsidiga, effektiva och pragmatiska.

Om så är fallet kan Big Techs dominans över AI bli kortvarig.

Meta LLaMA-läckan

Metas LLaMA-modell, en stor språkmodell (LLM) som ChatGPT, var läckt ut på 4chan en vecka efter att företaget skickat ut begäran om tillgång. Den 3 mars dök en nedladdningsbar torrent upp på meddelandeforumet och spreds som en löpeld.

Som Sernau påpekar fortsatte open source-gruppen att modifiera LLaMA och lägga till imponerande funktionalitet utan att använda företagets datorresurser.

Att bygga kraftfulla AI-modeller är billigare än någonsin, och öppen källkodssamhällen driver på för att demokratisera tillgången. LLaMA är till stor del en förtränad modell, medan andra modeller med öppen källkod, som BLOOM, tränades av frivilliga.

Training BLOOM krävde en superdator utrustad med 384 NVIDIA A100 80GB GPU:er som lyckligtvis skänktes av den franska regeringen. AI-företaget Together med öppen källkod Together tillkännagav nyligen $20m seedfinansiering, och AI-fokuserade molnleverantörer som CoreWeave erbjuda hårdvara under marknadspris.

Open source-projekt har olika sätt att fokusera resurser och utmanövrera stora teknikföretag. Big tech vill nog gärna att vi ska tro att deras AI är resultatet av decennier av arbete och investeringar på miljarder dollar - Open Source-gemenskapen håller förmodligen inte med.

På temat att stora teknikföretag separerar sig själva från mindre AI-projekt frågade Rajan Anandan, tidigare Google-chef, OpenAI:s VD Sam Altman vid ett evenemang i Indien om indiska ingenjörer kunde bygga grundläggande AI-modeller med en investering på $10 miljoner.

Altman svarade: "Det är helt hopplöst att konkurrera med oss när det gäller att utbilda foundationmodeller. Du borde inte försöka, och det är ditt jobb att tycka om att försöka ändå. Och jag tror på båda de sakerna. Jag tycker att det är ganska hopplöst."

Men i sitt memo uttrycker Sernau att open source redan konkurrerar med big tech. Han säger: "Att hålla fast vid en konkurrensfördel inom teknik blir ännu svårare nu när banbrytande forskning i LLM är överkomlig. Forskningsinstitutioner över hela världen bygger vidare på varandras arbete och utforskar lösningsutrymmet på ett sätt som vida överstiger vår egen kapacitet."

Open source-utvecklare bygger alternativ till big tech-bolagens AI:er och går om dem i prestanda och användarstatistik.

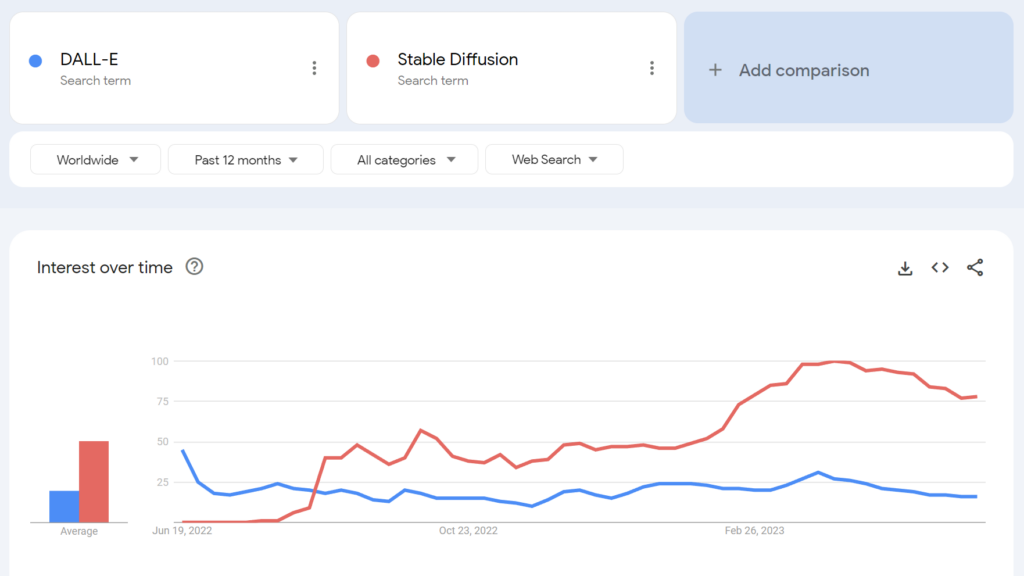

Den öppna källkodsmodellen Stable Diffusion blev till exempel mer populär än OpenAI:s DALL-E inom några månader efter lanseringen.

I vilken utsträckning kan vi skilja på potentiella baktankar här? Har big tech's regleringsdrivkraft någon altruistisk förtjänst?

AI-communityt med öppen källkod

Förutom LLaMA finns det åtminstone tre större exempel på AI-projekt med öppen källkod:

- Kramande ansikte & BLOOM - AI-företaget Hugging Face samarbetade med över 1.000 frivilliga forskare för att utveckla BLOOM, en LLM med öppen källkod. BLOOM syftar till att erbjuda en mer transparent och tillgänglig motsvarighet till proprietära AI-modeller.

- Tillsammans - En AI-startup vid namn Together har framgångsrikt samlat in $20 miljoner i såddfinansiering för att stödja sitt mål att bygga decentraliserade alternativ till slutna AI-system. De presenterade flera generativa AI-initiativ med öppen källkod, inklusive GPT-JT, OpenChatKit och RedPajama.

- Stabilitet AI - I april 2023 lanserade Stability AI, företaget bakom Stable Diffusion, StableLM, en serie alternativ till ChatGPT med öppen källkod.

Det är värt att notera att medan vissa av dessa utvecklare (t.ex. Stable Diffusion) erbjuder sina modeller via intuitiva, lättanvända instrumentpaneler, kräver andra, som BLOOM, betydande resurser för att köra. Till att börja med behöver du cirka 360 GB RAM för att köra BLOOM, men det finns många smarta knep för att minska resurskraven.

Eftersom AI-kapabel hårdvara kommer ner i pris och modeller med öppen källkod blir enklare att distribuera, är det mycket möjligt att praktiskt taget vem som helst kan distribuera modeller som liknar ChatGPT. Google memo-läckan citerar exempel på människor som ställer in och distribuerar LLaMA på konsumentenheter, inklusive en MacBook.

För företag med betydande IT-resurser, modeller med öppen källkod sparar pengar och ger datasuveränitet och kontroll över utbildning och optimering.

Det är dock inte alla som är optimistiska när det gäller effekterna av kraftfull AI med öppen källkod. Till exempel twittrade cybersäkerhetsforskaren Jeffrey Ladis: "Gör dig redo för massor av personlig skräppost och nätfiskeförsök" och "Att öppna dessa modeller var en fruktansvärd idé."

AI-spridningen gör oss alla mindre säkra. Det verkar vara en bra sak att förhindra, men också en ganska svår utmaning!

Jag skulle inte bli så förvånad om en statlig aktör lyckades få tag på OpenAI:s gränsmodeller under det närmaste året eller två https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10 maj 2023

En annan observatör twittrade: "Open source är ett hot, men inte på det sätt du tror. Det är ett hot eftersom AI i händerna på människor som kan använda det för sina egna syften blir ännu svårare att reglera eller hålla reda på, och det är ett större problem."

Google och OpenAI hävdar att de är rädda för AI med öppen källkod, att det "inte finns någon vallgrav" mellan dem alla. Men det är inte riktigt sant.

Öppen källkod är ett hot, men inte på det sätt du tror. Det är ett hot eftersom AI i händerna på människor som kan använda det för sina egna syften blir ännu svårare att... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5 maj 2023

Yann LeCun, ofta betraktad som en "AI-gudfader" tillsammans med Geoffrey Hinton och Yoshio Bengman, hävdar motsatsen"När LLM blir den huvudsakliga kanalen genom vilken alla får tillgång till information kommer människor (och regeringar) att * kräva * att den är öppen och transparent. Grundläggande infrastruktur måste vara öppen."

LeCun var också oenig med de vanliga berättelserna om AI-risker: "Jag tror att omfattningen av AI-anpassningsproblemet har varit löjligt överdrivet och vår förmåga att lösa det underskattas i stor utsträckning." Elon Musk slog tillbaka i Twitter-tråden och sa: "Tror du verkligen att AI är ett eneggat svärd?"

Tror du verkligen att AI är ett eneggat svärd?

- Elon Musk (@elonmusk) 1 april 2023

Andra kommentatorer drog paralleller mellan AI-reglering och kryptografi, där den amerikanska regeringen försökte förbjuda offentliga kryptografiska metoder genom att klassa dem som "ammunition" - som kallas "kryptokrigen".

Nu har i stort sett alla rätt att använda kryptering - men den kampen var svår att vinna - vilket kan vara fallet med AI med öppen källkod.

OpenAI:s alienering av AI med öppen källkod

Öppen källkod är mer än bara programvara, kod och teknik. Det är principen, tankesättet eller övertygelsen om att en samarbetsinriktad, öppen och transparent arbetsmiljö överträffar konkurrensen på en sluten marknad.

OpenAI, som en gång var ett icke-vinstdrivande företag med fokus på offentligt samarbete och utveckling av öppen källkod, har stadigt avvikit från sin namne.

Startup-företaget övergick till att bli ett vinstdrivande företag 2019, vilket i praktiken avslutade företagets relation med open source-gemenskapen. Investeringar från Microsoft gjorde att OpenAI inte längre kunde bedriva någon form av "öppen" FoU-verksamhet.

I mitten av maj meddelade bolaget att man öppen källkodsmodell i pipelinemen de har inte varit uppriktiga med detaljerna.

Nu driver OpenAI på för en reglering som skulle slå hårdast mot framväxande AI-företag, för att inte tala om en potentiell kriminalisering av open source-communityn.

Detta har fått vissa att kritisera OpenAI:s strävan efter reglering som inget annat än affärer - affärer som handlar om att skydda sina vinstmodeller från open source-grupper som vill demokratisera AI.

Är AI med öppen källkod en risk för big tech?

Kombinationen av Googles läckta memo, big tech:s krav på reglering och Altmans nedvärdering av AI-projekt på gräsrotsnivå får en att höja på ögonbrynen. Faktum är att legitimiteten för AI:s risker - som motiverar reglering - har ifrågasatts.

När till exempel Center for AI Safety (CAIS) publicerade sitt uttalande om AI-risker, som undertecknats av flera AI-vd:ar, var vissa externa observatörer inte övertygade.

I ett urval av expertreaktioner på uttalandet publicerad av Science Media CentreDr Mhairi Aitken, Ethics Research Fellow vid Alan Turing Institute, sade:

"På senare tid har dessa påståenden i allt högre grad kommit från stora teknikaktörer, främst i Silicon Valley. Vissa menar att det beror på att de är medvetna om de tekniska framstegen, men jag tror att det i själva verket fungerar som en distraktionsteknik. Man avleder uppmärksamheten från de beslut som fattas av big tech-aktörer (personer och organisationer) som utvecklar AI och driver på innovationen inom detta område, och riktar i stället uppmärksamheten mot hypotetiska framtidsscenarier och föreställningar om AI:s framtida kapacitet."

Vissa hävdar att big tech har den kraft som krävs för att avsätta resurser för etik, styrning och övervakning, vilket gör att de kan skaka av sig de värsta regleringarna och fortsätta att sälja sina produkter.

Men det är samtidigt problematiskt att fördöma AI-risker som fantasier och hävda att det inte finns något värde i reglering.

Det finns skeptiker i båda lägren

Att avfärda AI-risker som rent spekulativa kan visa sig vara ett kritiskt misstag för mänskligheten.

Kommentatorer utan intressekonflikt har faktiskt varnat för AI i årtionden, inklusive den avlidne professor Stephen Hawking, som sa att AI "kan stava slutet på mänskligheten" och vara den "värsta händelsen i vår civilisations historia".

Även om vissa kanske hävdar att big tech använder visioner om en AI-apokalyps för att förstärka marknadsstrukturer och höja inträdesbarriärerna, förmörkar det inte legitimiteten i AI-riskerna.

Till exempel har AI-forskargrupper redan bevisat AI:s förmåga att självständigt fastställa framväxande mål med potentiellt katastrofala följder.

Andra experiment visar att AI aktivt kan samla in resurser, ackumulera kraft och vidta proaktiva åtgärder för att förhindra att de blir "avstängda". Trovärdiga studier tyder på att åtminstone vissa AI-risker inte är alltför överdrivna.

Kompatibla åsikter?

Frågan är om vi kan lita på oss själva med exceptionellt kraftfull AI? Med "oss själva" avses människor överallt, på alla nivåer, från stora tekniska forskningslaboratorier till de grupper som bygger AI med öppen källkod.

Big tech kanske vill konsolidera marknadsstrukturerna och samtidigt skapa en genuin oro för AI:s framtid. De två är inte nödvändigtvis ömsesidigt uteslutande.

Samtidigt är ökningen av AI med öppen källkod oundviklig, och reglering riskerar att leda till missnöje bland en grupp som äger en av mänsklighetens farligaste tekniker.

Det är redan för sent att underkuva AI med öppen källkod genom reglering, och att försöka göra det kan leda till en destruktiv era av AI-förbud.

Samtidigt bör diskussionerna om AI:s faror drivas av bevisen - den enda objektiva signal vi har om teknikens skadepotential.