Когда ChatGPT дает вам правильный ответ на ваш запрос, рассуждает ли он сам или просто запоминает ответ из своих обучающих данных?

Исследователи Лаборатории компьютерных наук и искусственного интеллекта Массачусетского технологического института (CSAIL) провели серию тестов, чтобы выяснить, "думают" ли модели ИИ или просто обладают хорошей памятью.

Когда вы предлагаете модели искусственного интеллекта решить математическую задачу типа "Сколько будет 27+62?", она быстро выдает правильный ответ: 89. Как определить, понимает ли она суть арифметики или просто увидела проблему в обучающих данных?

На сайте их газетаИсследователи протестировали GPT-4, GPT-3.5 Turbo, Claude 1.3 и PaLM2, чтобы проверить, могут ли они "обобщать не только невидимые экземпляры известных задач, но и новые задачи".

Они разработали серию из 11 заданий, которые немного отличались от стандартных задач, с которыми LLM обычно справляются хорошо.

LLM должны одинаково хорошо справляться с "контрфактическими заданиями", если они используют общие и переносимые процедуры решения задач.

Если LLM "понимает" математику, то он должен дать правильный ответ на математическую задачу в base-10 и редко используемом base-9, например.

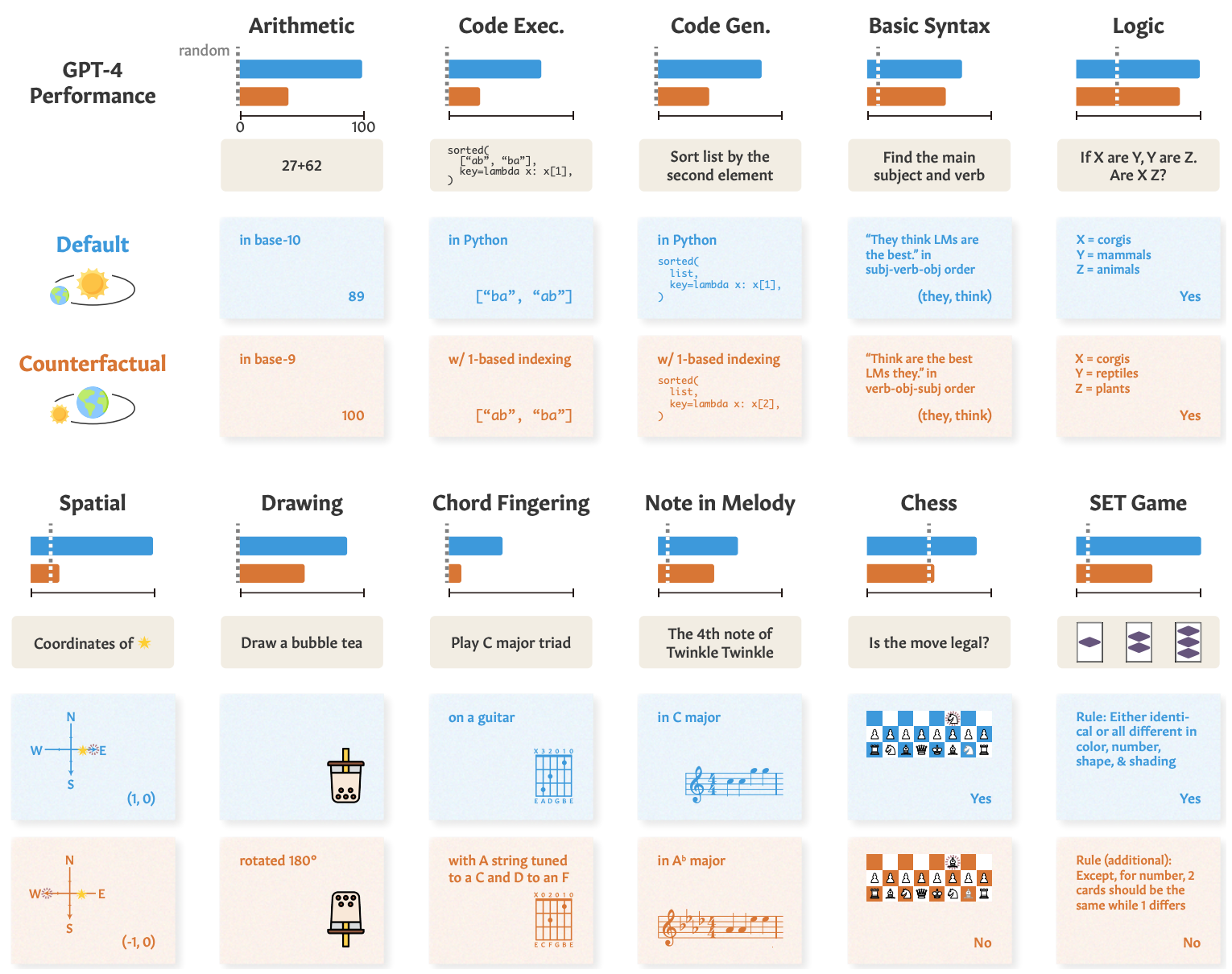

Вот примеры заданий и производительность GPT-4.

Показатели GPT-4 в стандартных тестах (синяя линия) хорошие, но его способности к математике, логическому мышлению, пространственному мышлению и другие способности (оранжевая линия) значительно ухудшаются при незначительном изменении задания.

Остальные модели продемонстрировали схожую деградацию, а GPT-4 оказался на первом месте.

Несмотря на ухудшение, производительность в контрфактических задачах все равно была лучше, чем случайность. Модели искусственного интеллекта пытаются решить эти задачи, но у них это не очень хорошо получается.

Результаты показывают, что впечатляющая производительность моделей ИИ в таких задачах, как экзамены в колледже, зависит от отличного запоминания учебных данных, а не от рассуждений. Это еще раз подчеркивает, что модели искусственного интеллекта не могут обобщенно подходить к невиданным задачам,

Чжаофэн Ву, аспирант MIT по электротехнике и информатике, сотрудник CSAIL и ведущий автор статьи, сказал: "Мы обнаружили интересный аспект больших языковых моделей: они отлично работают в знакомых сценариях, почти как хорошо натоптанная тропа, но испытывают трудности, когда местность становится незнакомой. Это очень важно, поскольку мы стремимся повысить адаптивность этих моделей и расширить горизонты их применения".

Подобную демонстрацию неспособности к обобщению мы наблюдали, когда исследовали, насколько плохо модели ИИ справляются со своей задачей. решение упрощенной головоломки с переправой через реку.

Исследователи пришли к выводу, что при анализе своих моделей разработчики должны "рассматривать абстрактные способности к выполнению задач в отрыве от наблюдаемого выполнения задач".

Подход "от тренировки к тестированию" может продвинуть модель вверх по эталонам, но не дает истинного представления о том, как модель поведет себя, когда ей будет предложена новая задача, в которой нужно разобраться.

Исследователи предполагают, что отчасти проблема заключается в том, что эти модели обучаются только на текстах поверхностной формы.

Если ЛЛМ будут подвергаться воздействию более реальных контекстуальных данных и семантических представлений, они смогут обобщать, когда им будут предлагаться вариации задач.