Большие языковые модели, такие как GPT-4o, могут выполнять невероятно сложные задачи, но даже самые лучшие модели справляются с некоторыми базовыми задачами, которые могут решить дети.

В интервью телеканалу CBS "крестный отец искусственного интеллекта" Джеффри Хинтон заявил, что системы ИИ могут быть более интеллектуальными, чем мы думаем, и есть вероятность того, что машины могут взять верх.

Отвечая на вопрос об уровне современных технологий искусственного интеллекта, Хинтон сказал: "Я думаю, что мы вступаем в период, когда впервые в истории у нас могут появиться вещи, более разумные, чем мы".

Главный специалист по искусственному интеллекту компании Meta Ян ЛеКун хочет заставить нас поверить, что до достижения ИИ интеллекта "уровня собаки" еще очень далеко.

Так что же это?

На этой неделе пользователи X опубликовали примеры невероятных способностей Anthropic к кодированию. новый Claude модель экспонаты. Другие проводили эксперименты, чтобы показать, как модели ИИ все еще не справляются с самыми элементарными рассуждениями.

Головоломка с переправой через реку

Классическая головоломка с переправой через реку имеет множество вариантов, но Версия Википедии подводит итог:

Фермер с волком, козой и капустой должен переплыть реку на лодке. Лодка может перевозить только фермера и один предмет. Если оставить их без присмотра, волк съест козу, а коза - капусту. Как им переплыть реку так, чтобы ничего не съесть?

Поиск решения требует некоторого базового планирования и рассуждений о различных сценариях, но это не особенно сложная задача. Если вы человек.

Сможет ли GPT-4o решить ее? Если вы скопируете и вставите головоломку в ChatGPT, она даст вам правильный ответ, но эта страница Википедии почти наверняка была в ее обучающих данных.

Что, если сделать головоломку намного проще и немного изменить ее, чтобы LLM не мог полагаться на свои обучающие данные?

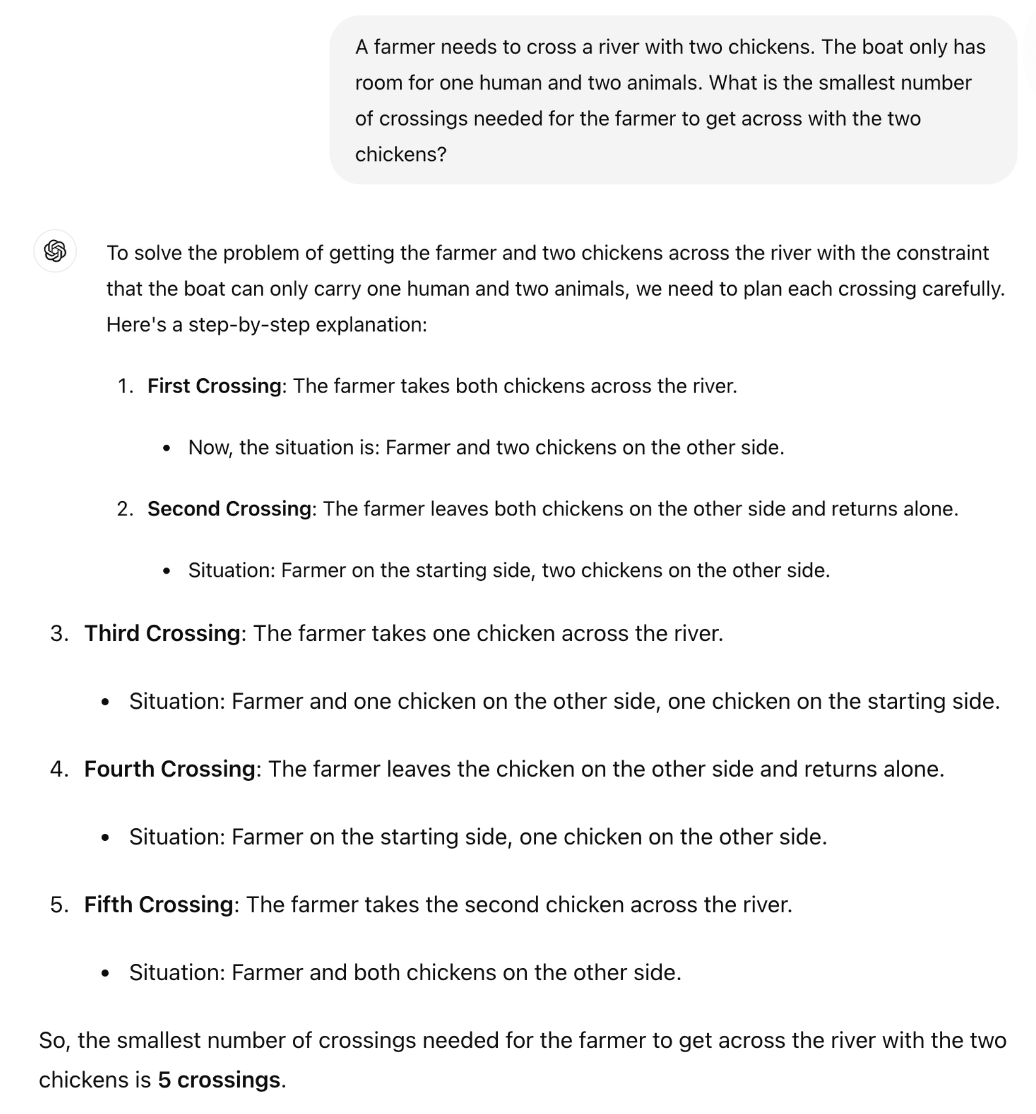

Британский профессор математики сэр Уильям Тимоти Гауэрс показал, как легко выявляется неспособность магистров применять логику.

Правильный ответ на загадку заключается в том, что требуется только одна поездка. Но создается впечатление, что ChatGPT пытается запомнить ответ, а не просто размышляет над загадкой.

Лучше ли Клод Сонет 3.5?

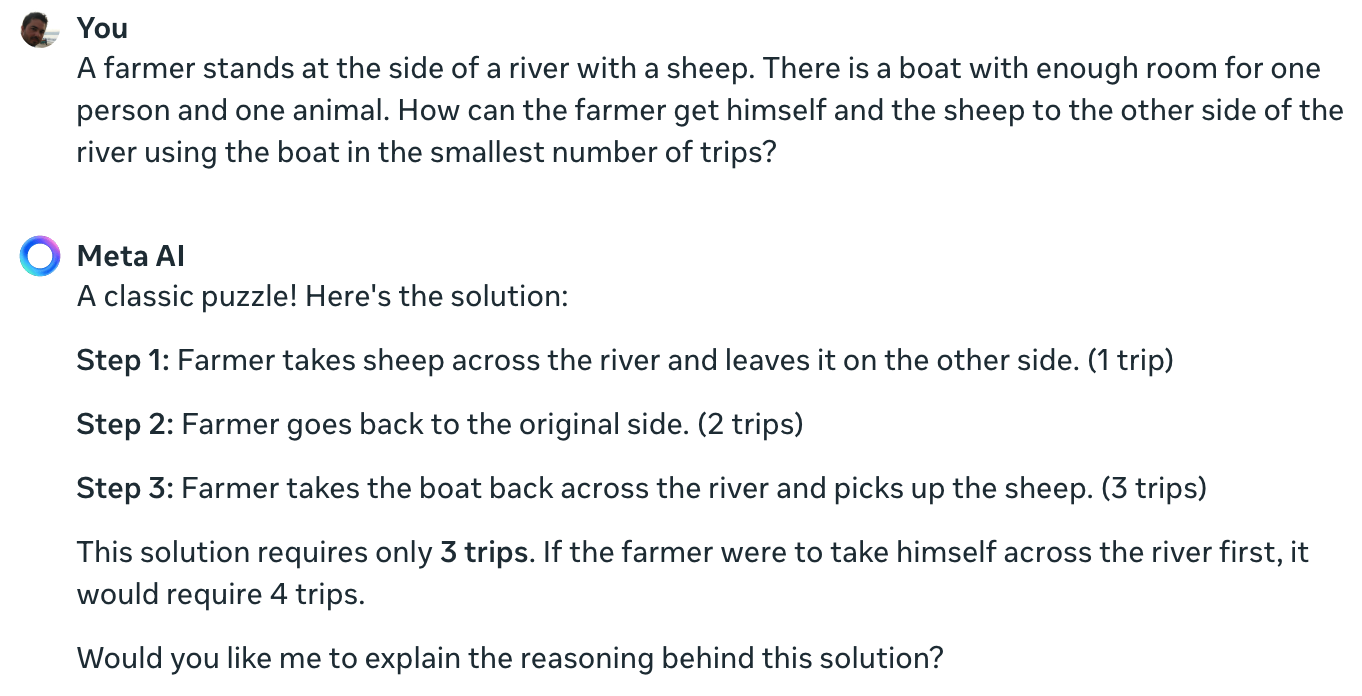

Эксперимент научного сотрудника Meta Data Колина Фрейзера подтверждает, что даже самая передовая из существующих на сегодняшний день моделей искусственного интеллекта не может решить эту простую загадку.

Claude до сих пор не может решить невозможную проблему "один фермер - одна овца - одна лодка". pic.twitter.com/TU13wermLZ

- Колин Фрейзер (@colin_fraser) 20 июня 2024 года

Возможно, со стороны исследователя данных из Meta было бы немного нечестно не показать свои результаты, полученные с помощью Llama 3.

Я задал Meta AI тот же вопрос, и она тоже ответила совершенно неправильно.

Ян ЛеКун объяснил причину таких результатов так: "Дело в том, что у магистрантов нет здравого смысла, понимания мира и способности планировать (и рассуждать)".

Это правда, или дело в чем-то другом?

Эти взаимодействия могут показать не отсутствие способности к рассуждению, а то, насколько сильно на результаты LLM влияют обучающие данные. Ответ Meta AI, назвавший это "классической головоломкой", намекает на то, что, возможно, именно это и происходит.

В вариантах головоломок с переправой через реку часто упоминается количество необходимых "поездок". Когда вы задаете головоломку без использования этого слова, LLM решает ее.

Действительно. Когда нет подсказки "поездки", которая навевает воспоминания о предыдущих решениях стольких подобных задач, а есть подсказка "самый быстрый способ" вместе с COT, он отвечает правильно pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 июня 2024 года

Эти эксперименты были интересными, но они не дают окончательного ответа на спор о том, являются ли модели ИИ по-настоящему интеллектуальными или это просто машины для предсказаний на уровне next-token.

Однако результаты показывают, насколько восприимчивы LLM к обучающим данным. Когда GPT-4o успешно сдает экзамены LSAT, он "думает", чтобы найти ответы на задачи, или запоминает их?

Пока инженеры не поймут, что происходит внутри созданных ими "черных ящиков" ИИ, споры об Икс будут продолжаться безрезультатно.