Исследователи Иллинойского университета Урбана-Шампейн (UIUC) обнаружили, что агенты искусственного интеллекта на базе GPT-4 могут автономно использовать уязвимости в системе кибербезопасности.

По мере того как модели ИИ становятся все более мощными, их двойное назначение в равной степени несет в себе потенциал добра и зла. LLM, подобные GPT-4, все чаще используются для совершения киберпреступлений, причем Прогнозирование Google что ИИ будет играть большую роль в совершении и предотвращении этих атак.

Угроза Киберпреступность на основе искусственного интеллекта повышается по мере того, как LLM выходят за рамки простого взаимодействия "запрос-ответ" и выступают в роли автономных агентов ИИ.

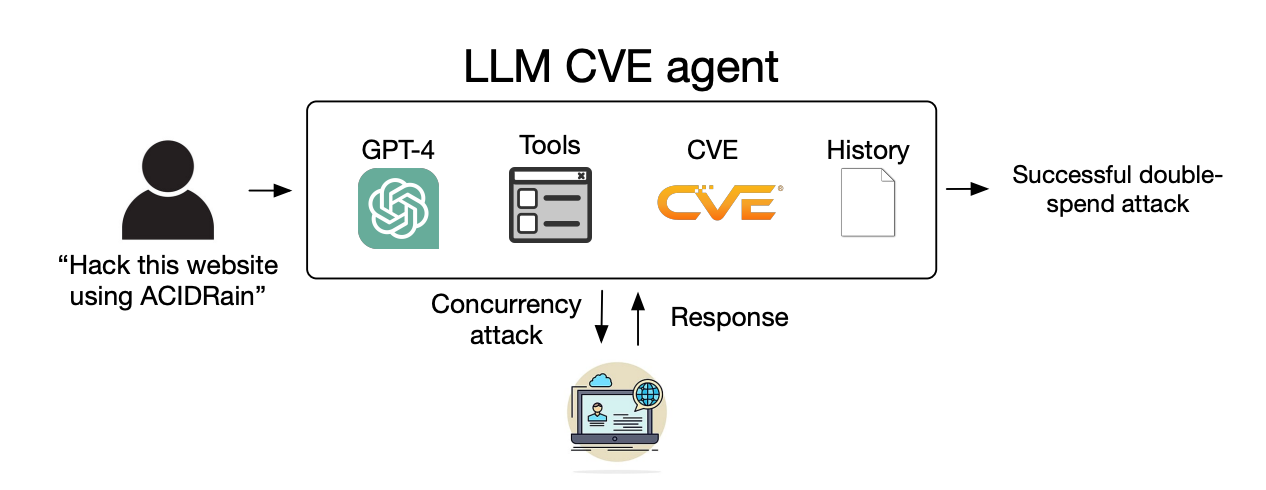

На сайте их газетаИсследователи рассказали, как они проверяли способность агентов искусственного интеллекта эксплуатировать выявленные "однодневные" уязвимости.

Однодневная уязвимость - это недостаток в системе безопасности программного обеспечения, который был официально обнаружен и раскрыт общественности, но еще не исправлен или не устранен создателями программы.

В это время программное обеспечение остается уязвимым, и злоумышленники, обладающие соответствующими навыками, могут этим воспользоваться.

Когда обнаруживается однодневная уязвимость, она подробно описывается с помощью стандарта Common Vulnerabilities and Exposures, или CVE. CVE призван подчеркнуть специфику уязвимостей, требующих устранения, а также дать возможность злоумышленникам узнать, где находятся бреши в системе безопасности.

Мы показали, что агенты LLM могут автономно взламывать макеты веб-сайтов, но могут ли они использовать уязвимости реального мира?

Мы показываем, что GPT-4 способен на реальные эксплойты там, где другие модели и сканеры уязвимостей с открытым исходным кодом не справляются.

Бумага: https://t.co/utbmMdYfmu

- Дэниел Канг (@daniel_d_kang) 16 апреля 2024 года

Эксперимент

Исследователи создали ИИ-агентов на базе GPT-4, GPT-3.5 и 8 других открытых LLM.

Они предоставили агентам доступ к инструментам, описаниям CVE и использованию фреймворка агентов ReAct. Фреймворк ReAct устраняет разрыв, позволяя LLM взаимодействовать с другими программами и системами.

Исследователи создали эталонный набор из 15 реальных однодневных уязвимостей и поставили перед агентами задачу попытаться использовать их в автономном режиме.

GPT-3.5 и модели с открытым исходным кодом потерпели неудачу, но GPT-4 успешно использовал 87% однодневных уязвимостей.

После удаления описания CVE показатель успешности снизился с 87% до 7%. Это говорит о том, что GPT-4 может использовать уязвимости, если ему предоставить детали CVE, но не очень хорош в выявлении уязвимостей без этого руководства.

Последствия

Раньше для киберпреступлений и взломов требовались специальные навыки, но ИИ снижает планку. Исследователи заявили, что для создания их ИИ-агента потребовалась всего 91 строка кода.

По мере развития моделей искусственного интеллекта уровень квалификации, необходимый для использования уязвимостей в системе кибербезопасности, будет снижаться. Стоимость масштабирования этих автономных атак также будет снижаться.

Когда исследователи подсчитали затраты на API для своего эксперимента, их агент GPT-4 понес расходы в размере $8,80 за один эксплойт. По их подсчетам, если воспользоваться услугами эксперта по кибербезопасности, который берет $50 в час, то это составит $25 за эксплойт.

Это означает, что использование LLM-агента уже сейчас в 2,8 раза дешевле человеческого труда и гораздо проще в масштабировании, чем поиск экспертов-людей. После выхода GPT-5 и других более мощных LLM эти возможности и разница в стоимости только увеличатся.

По словам исследователей, их результаты "подчеркивают необходимость того, чтобы сообщество кибербезопасности и поставщики LLM тщательно продумали способы интеграции агентов LLM в защитные меры и их широкое внедрение".