Гонка за более мощным и эффективным оборудованием для искусственного интеллекта разгорелась на этой неделе: Intel и Google анонсировали новые чипы, которые помогут им стать менее зависимыми от технологий NVIDIA.

Кажется, что каждую неделю появляются новые модели ИИ. За каждым релизом стоят недели тренировок на облачных вычислительных центрах, большинство из которых работают на базе NVIDIA GPU.

Компании Intel и Google анонсировали новые собственные чипы ИИ, которые позволяют быстрее обучать и развертывать большие модели ИИ, потребляя при этом меньше энергии.

Чип ускорителя искусственного интеллекта Gaudi 3 от Intel

Компания Intel, вероятно, больше известна благодаря чипам, на которых работают ваши компьютеры, но во вторник компания объявил свой новый чип искусственного интеллекта под названием Gaudi 3.

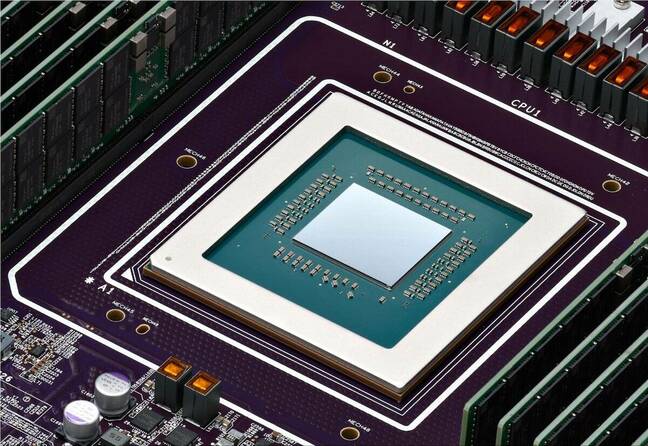

NVIDIA H100 Графические процессоры составляют основную часть центров обработки данных ИИ, но Intel утверждает, что Gaudi 3 обеспечивает "в среднем на 50% лучший вывод и в среднем на 40% лучшую энергоэффективность, чем Nvidia H100 - за меньшую стоимость".

Большой вклад в энергоэффективность Gaudi 3 внесло то, что Intel использовала для производства чипов 5-нм техпроцесс Taiwan Semiconductor Manufacturing Co.

Intel не предоставила никакой информации о ценах, но когда ее спросили, как она сравнится с продуктами NVIDIA, Дас Камхаут, вице-президент по программному обеспечению Xeon в Intel, сказал: "Мы ожидаем, что она будет очень конкурентоспособной".

Dell Technologies, Hewlett Packard Enterprise, Lenovo и Supermicro станут первыми, кто развернет Gaudi 3 в своих центрах обработки данных с искусственным интеллектом.

Генеральный директор Intel Пэт Гелсингер подвел итог амбициям компании в области ИИ, заявив: "Intel внедряет ИИ повсеместно на предприятиях - от ПК до центров обработки данных и периферии".

Сайт #IntelGaudi 3 #AI Ускоритель предлагает конкурентоспособную альтернативу NVIDIA H100 с более высокой производительностью, увеличенной масштабируемостью и интеграцией PyTorch. Узнайте больше о ключевых преимуществах продукта. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9 апреля 2024 года

Обновления Google Arm и TPU

Во вторник Google анонсировала свой первый пользовательский Процессоры на базе Arm который компания планирует использовать для питания своих центров обработки данных. Новый чип, получивший название Axion, является прямым конкурентом процессоров Intel и AMD.

Google утверждает, что Axion обеспечивает "производительность на 30% выше, чем у самых быстрых облачных инстансов общего назначения на базе Arm, до 50% выше производительность и до 60% выше энергоэффективность, чем у сопоставимых инстансов текущего поколения на базе x86".

Google переводит несколько своих сервисов, таких как YouTube и Google Earth, на серверы текущего поколения на базе Arm, которые вскоре будут модернизированы чипами Axion.

Наличие мощного варианта на базе Arm облегчает заказчикам перенос своих процессорных приложений для обучения ИИ, составления выводов и других приложений на облачную платформу Google без необходимости их переделки.

Для обучения крупномасштабных моделей Google в основном полагается на свои чипы TPU в качестве альтернативы оборудованию NVIDIA. Они также будут модернизированы с помощью одного нового TPU v5p, который теперь содержит более чем вдвое больше чипов, чем текущий TPU v4.

TPU v5p, наш самый мощный и масштабируемый TPU, теперь доступен для всех! #GoogleCloudNext pic.twitter.com/mmfWlzHeqs

- Google Cloud Tech (@GoogleCloudTech) 9 апреля 2024 года

Google не стремится продавать ни свои новые чипы Arm, ни TPU. Компания стремится развивать свои облачные вычислительные сервисы, а не становиться прямым аппаратным конкурентом NVIDIA.

Модернизированные TPU дадут толчок развитию Google. Гиперкомпьютер с искусственным интеллектом что позволяет проводить масштабное обучение моделей ИИ. Гиперкомпьютер ИИ также использует графические процессоры NVIDIA H100, которые, по словам Google, вскоре будут заменены на новые NVIDIA Графические процессоры Blackwell.

Спрос на чипы искусственного интеллекта вряд ли замедлится в ближайшее время, и это уже не похоже на гонку с одной лошадью - NVIDIA.